上两节,我们解读了 task_struct 的大部分的成员变量。这样一个任务执行的方方面面,都可以很好地管理起来,但是其中有一个问题我们没有谈。在程序执行过程中,一旦调用到系统调用,就需要进入内核继续执行。那如何将用户态的执行和内核态的执行串起来呢?这就需要以下两个重要的成员变量:

struct thread_info thread_info;void *stack;

用户函数栈

在进程的内存空间里面,栈是一个从高地址到低地址,往下增长的结构,也就是上面是栈底,下面是栈顶,入栈和出栈的操作都是从下面的栈顶开始的。

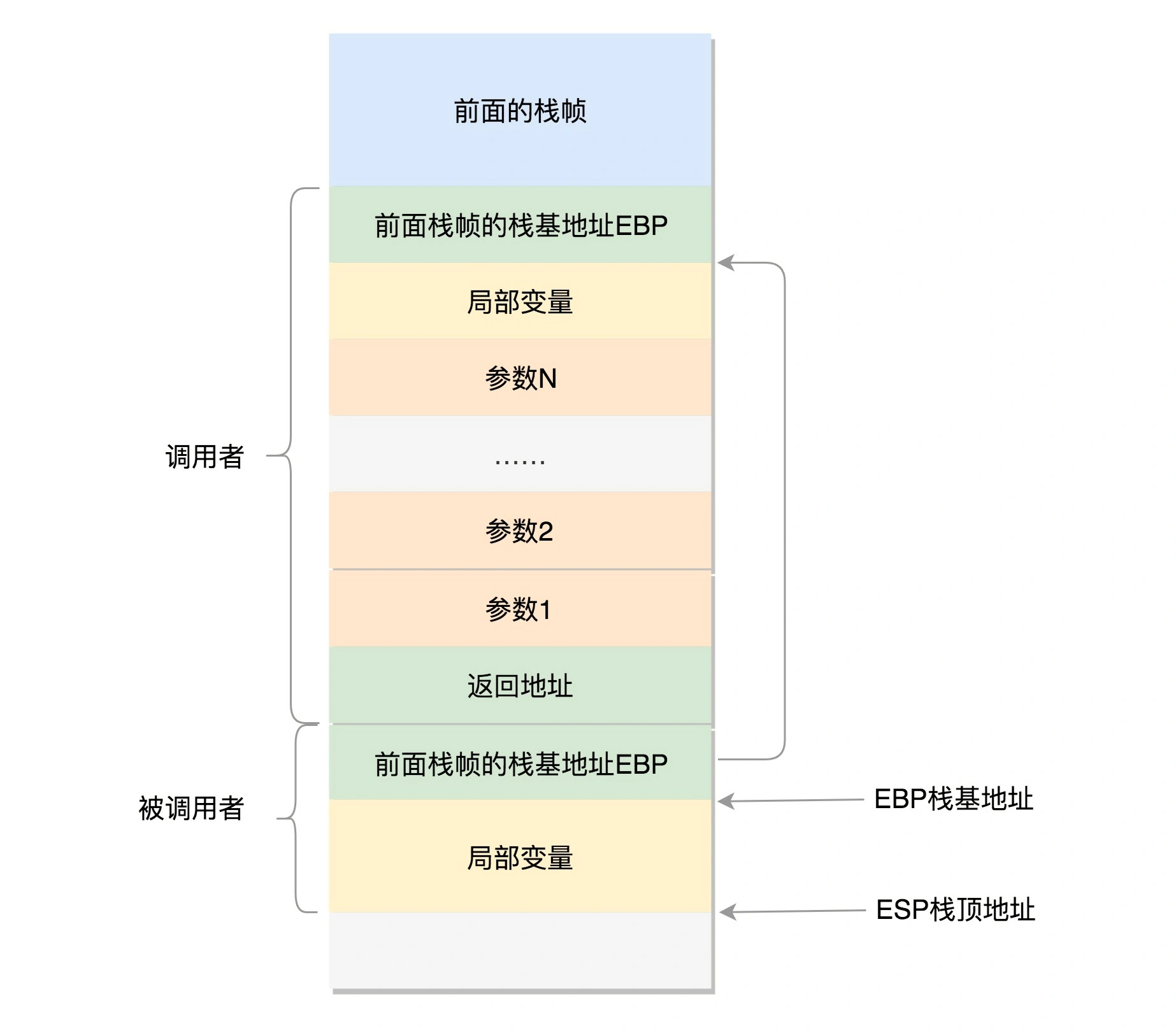

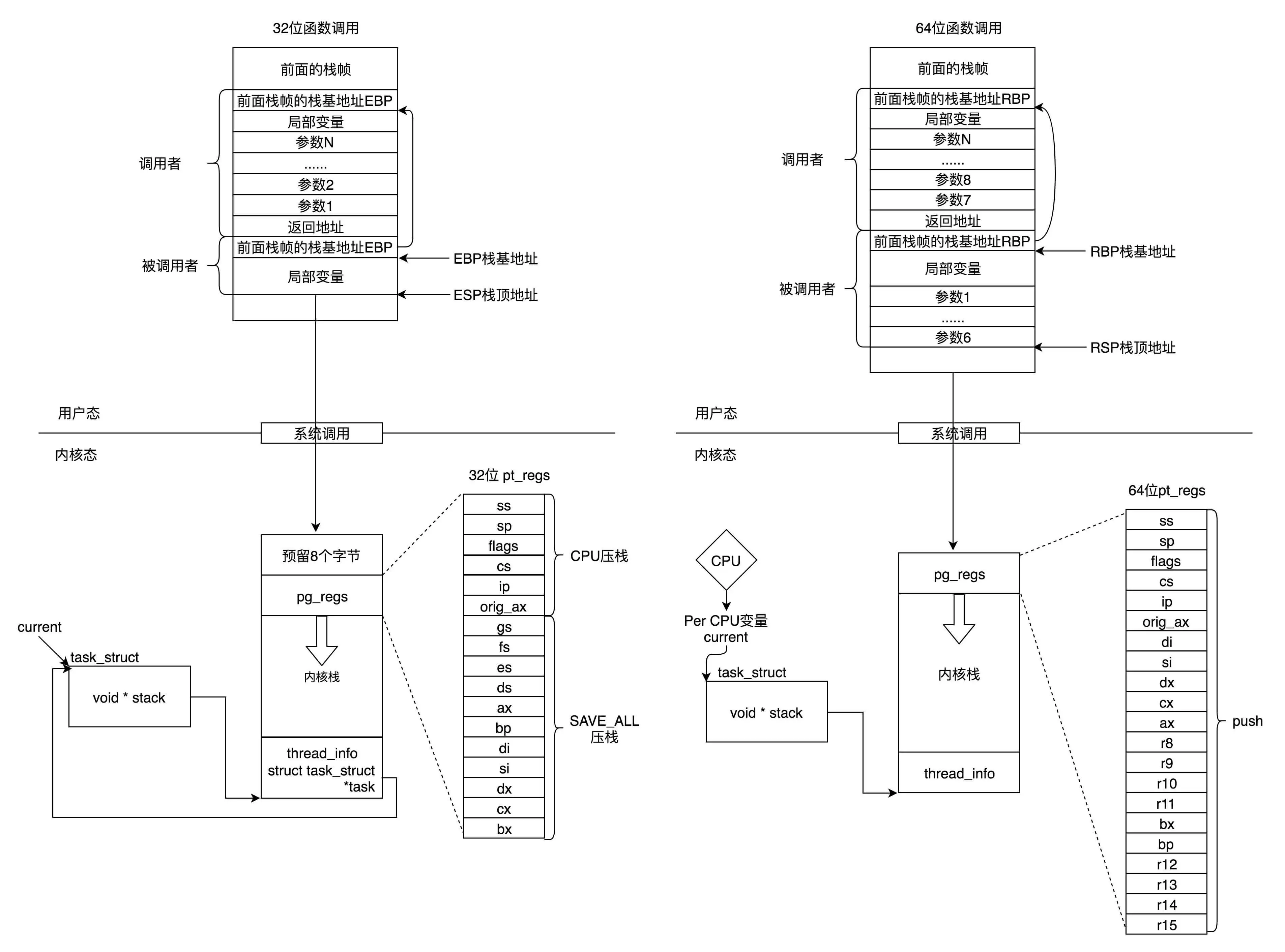

我们先来看 32 位操作系统的情况。在 CPU 里,ESP(Extended Stack Pointer)是栈顶指针寄存器,入栈操作 Push 和出栈操作 Pop 指令,会自动调整 ESP 的值。另外有一个寄存器 EBP(Extended Base Pointer),是栈基地址指针寄存器,指向当前栈帧的最底部。

A 调用 B,A 的栈里面包含 A 函数的局部变量,然后是调用 B 的时候要传给它的参数,然后返回 A 的地址,这个地址也应该入栈,这就形成了 A 的栈帧。接下来就是 B 的栈帧部分了,先保存的是 A 栈帧的栈底位置,也就是 EBP。在 B 函数里面获取 A 传进来的参数,需要靠栈底寄存器中的地址,接下来保存的是 B 的局部变量等等。

当 B 返回的时候,返回值会保存在 EAX 寄存器中,从栈中弹出返回地址,将指令跳转回去,参数也从栈中弹出,然后继续执行 A。

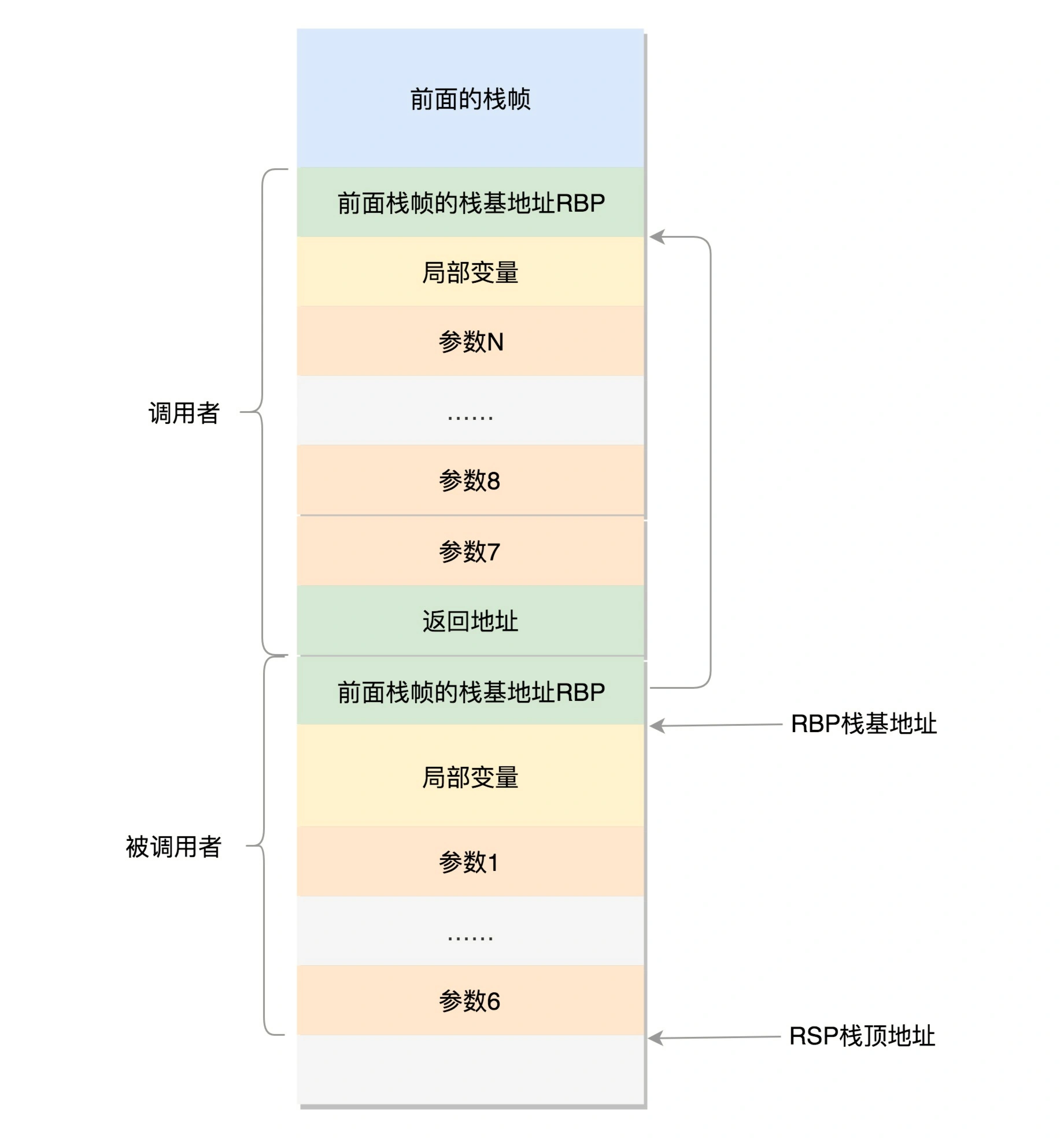

对于 64 位操作系统,模式多少有些不一样。因为 64 位操作系统的寄存器数目比较多。rax 用于保存函数调用的返回结果。栈顶指针寄存器变成了 rsp,指向栈顶位置。堆栈的 Pop 和 Push 操作会自动调整 rsp,栈基指针寄存器变成了 rbp,指向当前栈帧的起始位置。

改变比较多的是参数传递。rdi、rsi、rdx、rcx、r8、r9 这 6 个寄存器,用于传递存储函数调用时的 6 个参数。如果超过 6 的时候,还是需要放到栈里面。然而,前 6 个参数有时候需要进行寻址,但是如果在寄存器里面,是没有地址的,因而还是会放到栈里面,只不过放到栈里面的操作是被调用函数做的。

比如一个函数的参数是整数类型,如 int a,在被调用的函数中要使用 a 的地址:&a,在传参数时a的值在寄存器 rdi 中,但是 rdi 是没有地址的,被调用函数要取这个参数的地址的话,只能先把 rdi 的值存入一个局部变量中,然后取这个局部变量的地址。

以上的栈操作,都是在进程的内存空间里面进行的。

内核态函数栈

接下来,我们通过系统调用,从进程的内存空间到内核中了。内核中也有各种各样的函数调用来调用去的,也需要这样一个机制,这该怎么办呢?

这时候,上面的成员变量 stack,也就是内核栈,就派上了用场。

Linux 给每个 task 都分配了内核栈。在 32 位系统上 arch/x86/include/asm/page_32_types.h,是这样定义的:一个 PAGE_SIZE 是 4K,左移一位就是乘以 2,也就是 8K。

#define THREAD_SIZE_ORDER 1

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)

内核栈在 64 位系统上 arch/x86/include/asm/page_64_types.h,是这样定义的:在 PAGE_SIZE 的基础上左移两位,也即 16K,并且要求起始地址必须是 8192 的整数倍。

#ifdef CONFIG_KASAN

#define KASAN_STACK_ORDER 1

#else

#define KASAN_STACK_ORDER 0

#endif

#define THREAD_SIZE_ORDER (2 + KASAN_STACK_ORDER)

#define THREAD_SIZE (PAGE_SIZE << THREAD_SIZE_ORDER)

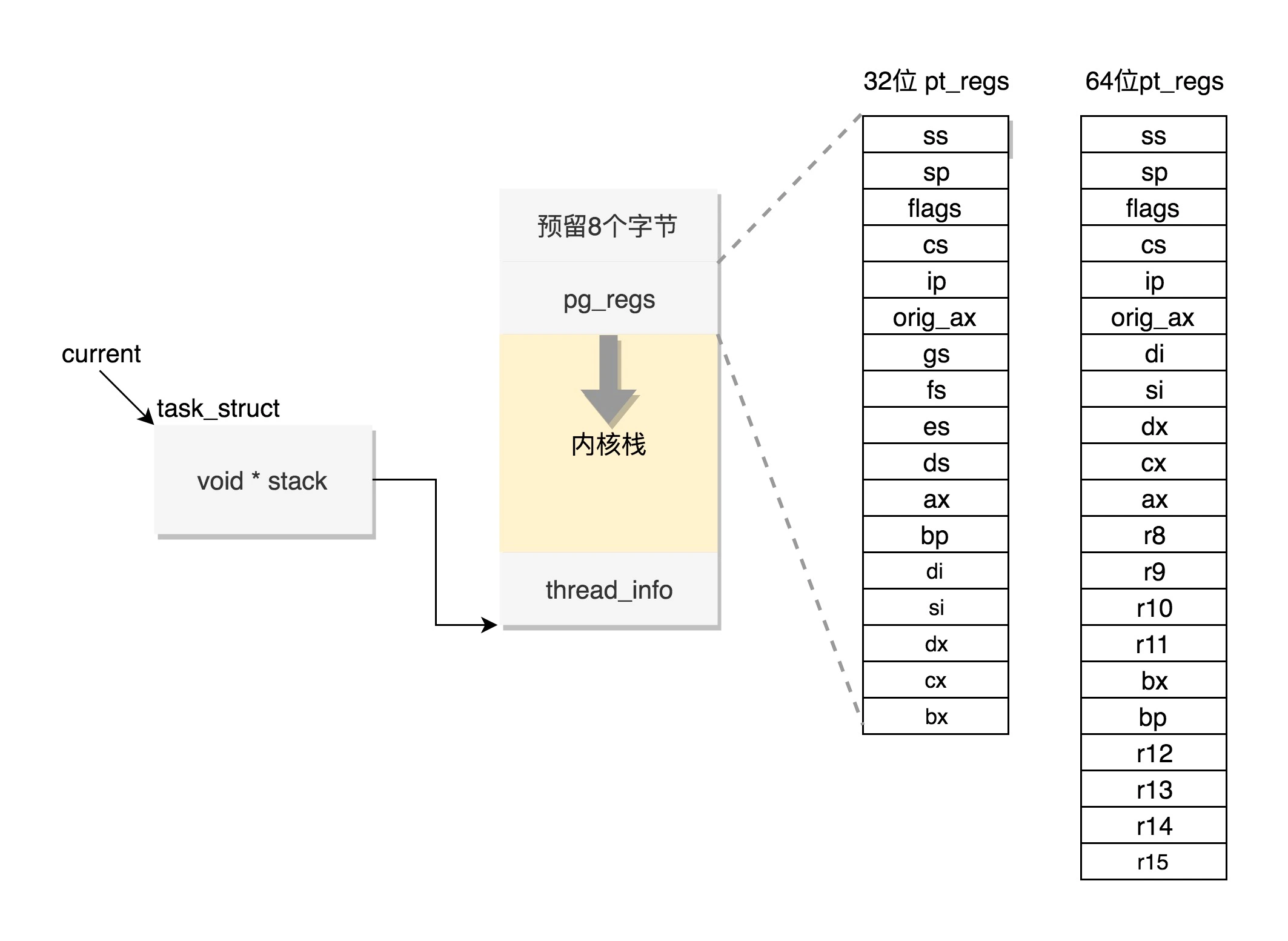

内核栈是一个非常特殊的结构,如下图所示:

这段空间的最低位置,是一个 thread_info 结构。这个结构是对 task_struct 结构的补充。因为 task_struct 结构庞大但是通用,不同的体系结构就需要保存不同的东西,所以往往与体系结构有关的,都放在 thread_info 里面。

在内核代码里面有这样一个 union,将 thread_info 和 stack 放在一起,在 include/linux/sched.h 文件中就有,开头是 thread_info,后面是 stack。

union thread_union {

#ifndef CONFIG_THREAD_INFO_IN_TASK

struct thread_info thread_info;

#endif

unsigned long stack[THREAD_SIZE/sizeof(long)];

};

在内核栈的最高地址端,存放的是另一个结构 pt_regs,定义如下。其中,32 位和 64 位的定义不一样。

#ifdef __i386__

struct pt_regs {

unsigned long bx;

unsigned long cx;

unsigned long dx;

unsigned long si;

unsigned long di;

unsigned long bp;

unsigned long ax;

unsigned long ds;

unsigned long es;

unsigned long fs;

unsigned long gs;

unsigned long orig_ax;

unsigned long ip;

unsigned long cs;

unsigned long flags;

unsigned long sp;

unsigned long ss;

};

#else

struct pt_regs {

unsigned long r15;

unsigned long r14;

unsigned long r13;

unsigned long r12;

unsigned long bp;

unsigned long bx;

unsigned long r11;

unsigned long r10;

unsigned long r9;

unsigned long r8;

unsigned long ax;

unsigned long cx;

unsigned long dx;

unsigned long si;

unsigned long di;

unsigned long orig_ax;

unsigned long ip;

unsigned long cs;

unsigned long flags;

unsigned long sp;

unsigned long ss;

/* top of stack page */

};

#endif

在讲系统调用的时候,已经多次见过这个结构。当系统调用从用户态到内核态的时候,首先要做的第一件事情,就是将用户态运行过程中的 CPU 上下文保存起来,其实主要就是保存在这个结构的寄存器变量里。这样当从内核系统调用返回的时候,才能让进程在刚才的地方接着运行下去。压栈的值的顺序和 struct pt_regs 中寄存器定义的顺序是一样的。

在内核中,CPU 的寄存器 ESP 或者 RSP,已经指向内核栈的栈顶,在内核态里的调用都有和用户态相似的过程。

通过 task_struct 找内核栈

通过 task_struct 的 stack 指针找到线程的内核栈:

static inline void *task_stack_page(const struct task_struct *task)

{

return task->stack;

}

从 task_struct 如何得到相应的 pt_regs:

/*

* TOP_OF_KERNEL_STACK_PADDING reserves 8 bytes on top of the ring0 stack.

* This is necessary to guarantee that the entire "struct pt_regs"

* is accessible even if the CPU haven't stored the SS/ESP registers

* on the stack (interrupt gate does not save these registers

* when switching to the same priv ring).

* Therefore beware: accessing the ss/esp fields of the

* "struct pt_regs" is possible, but they may contain the

* completely wrong values.

*/

#define task_pt_regs(task) \

({ \

unsigned long __ptr = (unsigned long)task_stack_page(task); \

__ptr += THREAD_SIZE - TOP_OF_KERNEL_STACK_PADDING; \

((struct pt_regs *)__ptr) - 1; \

})

结合前面的图来看,stack 指针指向栈顶,也就是图中最下面的地方。加上 thread_size 就找到了栈底,也就是最上面的地方,地址最大处。为什么可以这样加常数进行偏移呢?因为分配给每个内核栈的大小是固定的。找到栈底之后强制类型转换,再减一其实就是减去一个 pt_reg 的大小,就到了 pt_reg 地址起始的地方。

这里面有一个 TOP_OF_KERNEL_STACK_PADDING,这个的定义如下:

#ifdef CONFIG_X86_32

# ifdef CONFIG_VM86

# define TOP_OF_KERNEL_STACK_PADDING 16

# else

# define TOP_OF_KERNEL_STACK_PADDING 8

# endif

#else

# define TOP_OF_KERNEL_STACK_PADDING 0

#endif

也就是说,32 位机器上是 8,其他是 0。这是因为压栈 pt_regs 有两种情况。我们知道,CPU 用 ring 来区分权限,从而 Linux 可以区分内核态和用户态。

因此,第一种情况,我们拿涉及从用户态到内核态的变化的系统调用来说。因为涉及权限的改变,会压栈保存 SS、ESP 寄存器的,这两个寄存器共占用 8 个 byte。

另一种情况是,不涉及权限的变化,就不会压栈这 8 个 byte。这样就会使得两种情况不兼容。如果没有压栈还访问,就会报错,所以还不如预留在这里,保证安全。在 64 位上,修改了这个问题,变成了定长的。

通过内核找 task_struct

如果一个当前在某个 CPU 上执行的进程,想知道自己的 task_struct 在哪里,那就要靠 thread_info 这个结构。

struct thread_info {

struct task_struct *task; /* main task structure */

__u32 flags; /* low level flags */

__u32 status; /* thread synchronous flags */

__u32 cpu; /* current CPU */

mm_segment_t addr_limit;

unsigned int sig_on_uaccess_error:1;

unsigned int uaccess_err:1; /* uaccess failed */

};

这里面有个成员变量 task 指向 task_struct,所以我们常用 current_thread_info()->task 来获取 task_struct。

static inline struct thread_info *current_thread_info(void)

{

return (struct thread_info *)(current_top_of_stack() - THREAD_SIZE);

}

而 thread_info 的位置就是内核栈的最高位置,减去 THREAD_SIZE,就到了 thread_info 的起始地址。

但是后来 thread_info 中就只剩下一个 flag 了:

struct thread_info {

unsigned long flags; /* low level flags */

};

总结延伸

- 用户态/内核态切换执行如何串起来

- 用户态函数栈; 通过 JMP + 参数 + 返回地址 调用函数

- 栈内存空间从高到低增长

- 32位栈结构: 栈帧包含 前一个帧的 EBP + 局部变量 + N个参数 + 返回地址

- ESP: 栈顶指针; EBP: 栈基址(栈帧最底部, 局部变量起始)

- 返回值保存在 EAX 中

- 64位栈结构: 结构类似

- rax 保存返回结果; rsp 栈顶指针; rbp 栈基指针

- 参数传递时, 前 6个放寄存器中(再由被调用函数 push 进自己的栈, 用以寻址), 参数超过 6个压入栈中

- 内核栈结构:

- Linux 为每个 task 分配了内核栈, 32位(8K), 64位(16K)

- 栈结构: [预留8字节 +] pt_regs + 内核栈 + 头部 thread_info

- thread_info 是 task_struct 的补充, 存储于体系结构有关的内容

- pt_regs 用以保存用户运行上下文, 通过 push 寄存器到栈中保存

- 通过 task_struct 找到内核栈

- 直接由 task_struct 内的 stack 直接得到指向 thread_info 的指针

- 通过内核栈找到 task_struct

- 32位 直接由 thread_info 中的指针得到

- 64位 每个 CPU 当前运行进程的 task_struct 的指针存放到 Per CPU 变量 current_task 中; 可调用 this_cpu_read_stable 进行读取