搭建(2)spark HA集群(standalone模式)搭建

简单standalone搭建

1、环境

| | | |

| —- | —- | —- |

| | https://download.oracle.com/otn/java/jdk/8u231-b11/5b13a193868b4bf28bcb45c792fce896/jdk-8u231-linux-i586.tar.gz | https://app.yinxiang.com/fx/a525d593-00bf-4150-b0a6-aaa8d1867b91 |

| | http://mirror.bit.edu.cn/apache/incubator/livy/0.6.0-incubating/apache-livy-0.6.0-incubating-bin.zip | https://app.yinxiang.com/fx/2df42a8c-d1de-4ca9-af56-bd7d63ef8280 |

| | http://mirror.bit.edu.cn/apache/incubator/livy/0.6.0-incubating/apache-livy-0.6.0-incubating-bin.zip | https://app.yinxiang.com/fx/5faac747-e5e3-4e20-b9a5-a8bb0b146412 |

| | |

|

| | |

|

| | |

|

2、webui 界面

| | |

| —- | —- |

| | http://47.98.253.2:8080/ |

| | http://47.98.253.2:8998/ |

3、引入HA集群

基于前面的笔记 — 《spark 单机、standalone》 进行操作

spark HA配置

Spark集群安装完毕,但是有一个很大的问题,那就是Master节点存在单点故障,要解决此问题,就要借助zookeeper,并且启动至少两个Master节点来实现高可靠,配置方式比较简单:

SparkHA集群规划:Master: ,Worke: ,安装配置zk集群,并启动zk集群(之前博客文档有详解,自行查看并配置 ,不解释)我们将zk集群安装在了tian,tian2 上面

1、修改配置文件spark-env.sh

停止spark所有服务()

注释或删除 standalone 配置的

参数说明:

2.同步配置文件

3、启动/停止 集群

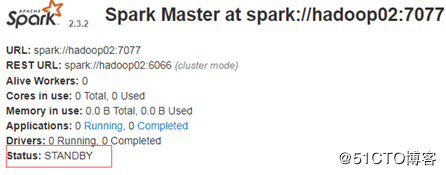

4、验证集群

5、配置日志输出级别