Spark rest api 决策方案

场景

参考: http://spark.apache.org/docs/latest/monitoring.html

[https://blog.csdn.net/Camu7s/article/details/71104968](https://blog.csdn.net/Camu7s/article/details/71104968)<br />[https://blog.csdn.net/cuixin20120511/article/details/80810190](https://blog.csdn.net/cuixin20120511/article/details/80810190)# 问题

spark1.4 版本之后支持 rest-api 到2.3.1 版本之间

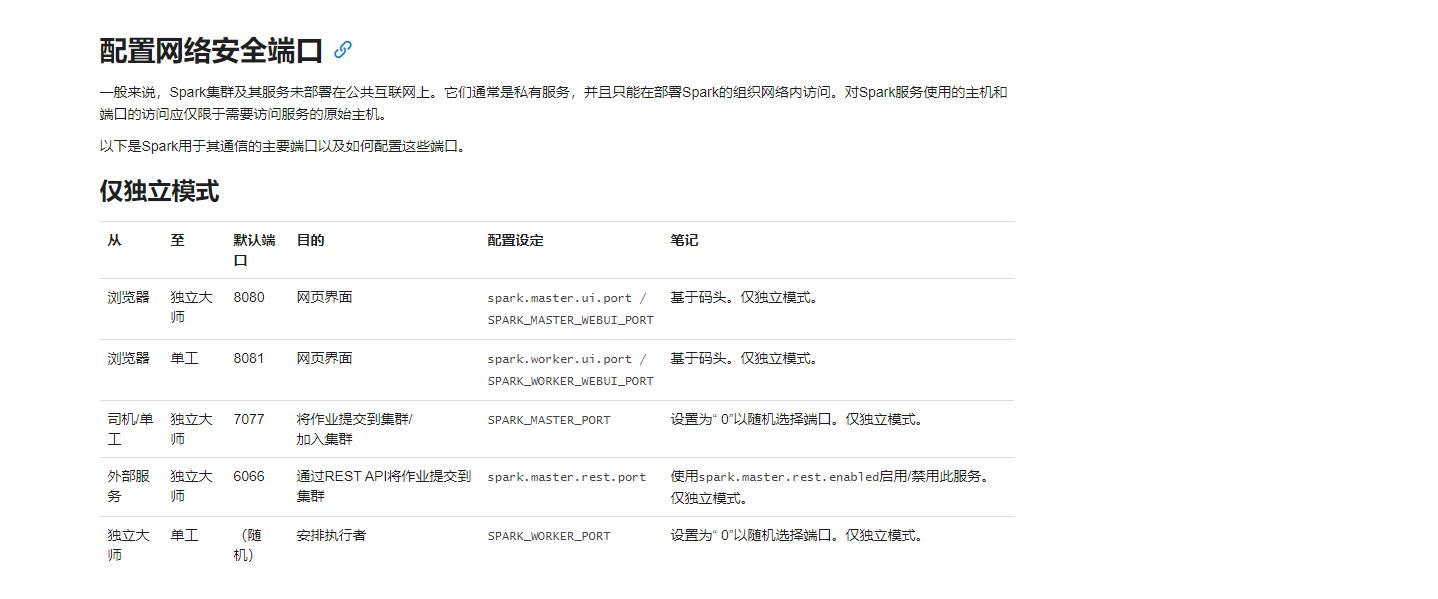

之后默认自动关闭了 6066端口我这里使用的 2.4.4 版本去没有 自动开放 6066端口官网描述:http://spark.apache.org/docs/latest/security.html 原因可能是会受到攻击 https://anquan.baidu.com/article/420https://www.freebuf.com/vuls/179092.htmlhttps://blog.csdn.net/weixin_41435098/article/details/92988350

原因可能是会受到攻击 https://anquan.baidu.com/article/420https://www.freebuf.com/vuls/179092.htmlhttps://blog.csdn.net/weixin_41435098/article/details/92988350

采用方案决策:# 1、spark自带的rest api 版本在高版本已经默认不支持 2、也考虑过使用java代码调用执行 Linux脚本但是考虑到性能问题# 决定采用下面的方案: