一、网络模型

1、NN(神经网络)

2、CNN(卷积神经网络)

Convolutional Neural Network

一个为分类而构建的CNN的构成示意如下:

输入 => 卷积 + relu + 池化 + …… + 卷积 + relu + 池化 + …… => 拉直 + 完全连接 +SoftMax

特征学习(特征提取) 分类

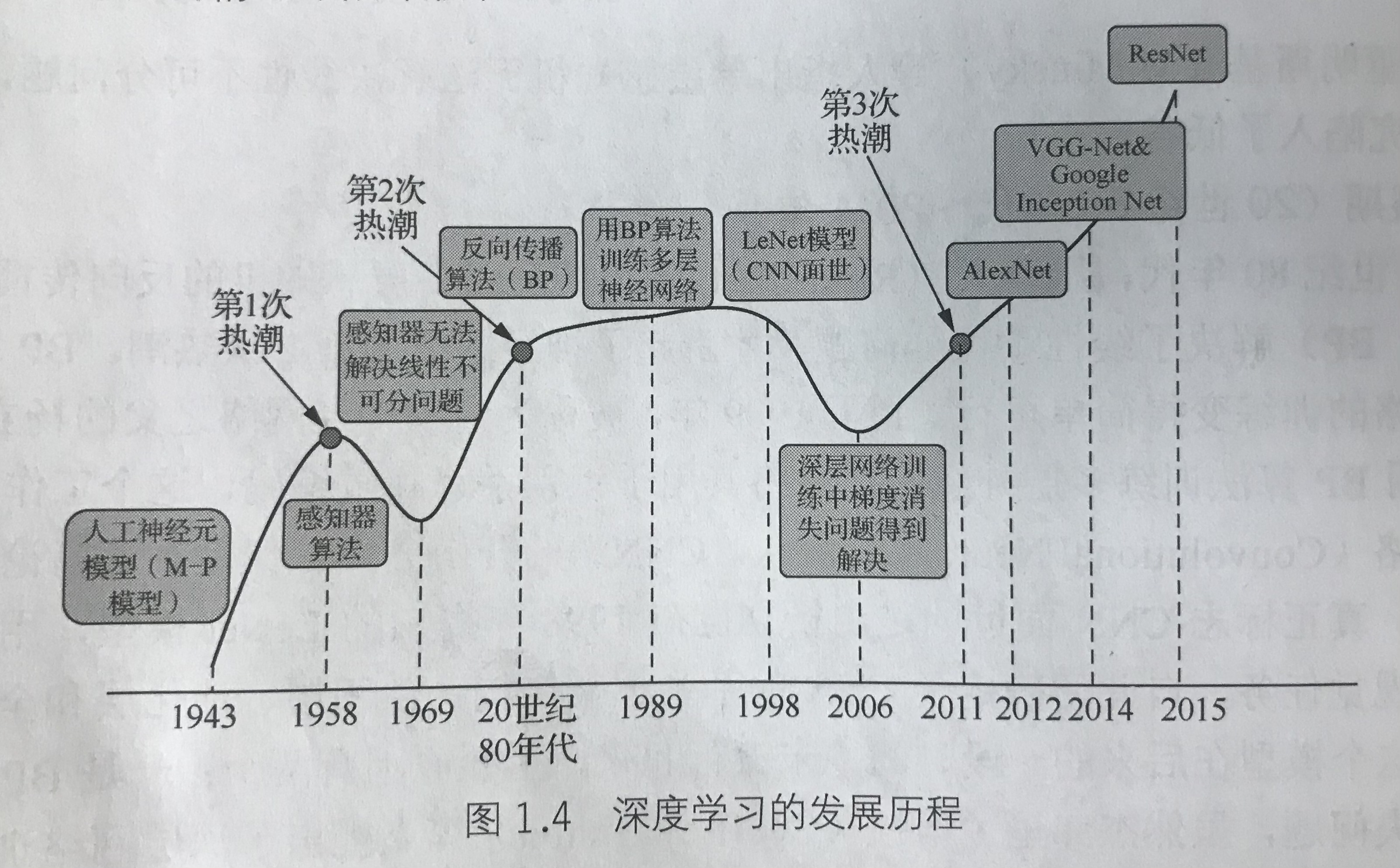

经典卷积神经网络总结:LeNet-5(Yann LeCun 翻译为杨立昆) -> AlexNet -> VGG(牛津大学和Goolge DeepMind公司提出的) -> Inception-v2(Google提出的,又称GoogleNet) -> ResNet -> DenseNet (CVPR2017) -> MobileNet(Google提出的)

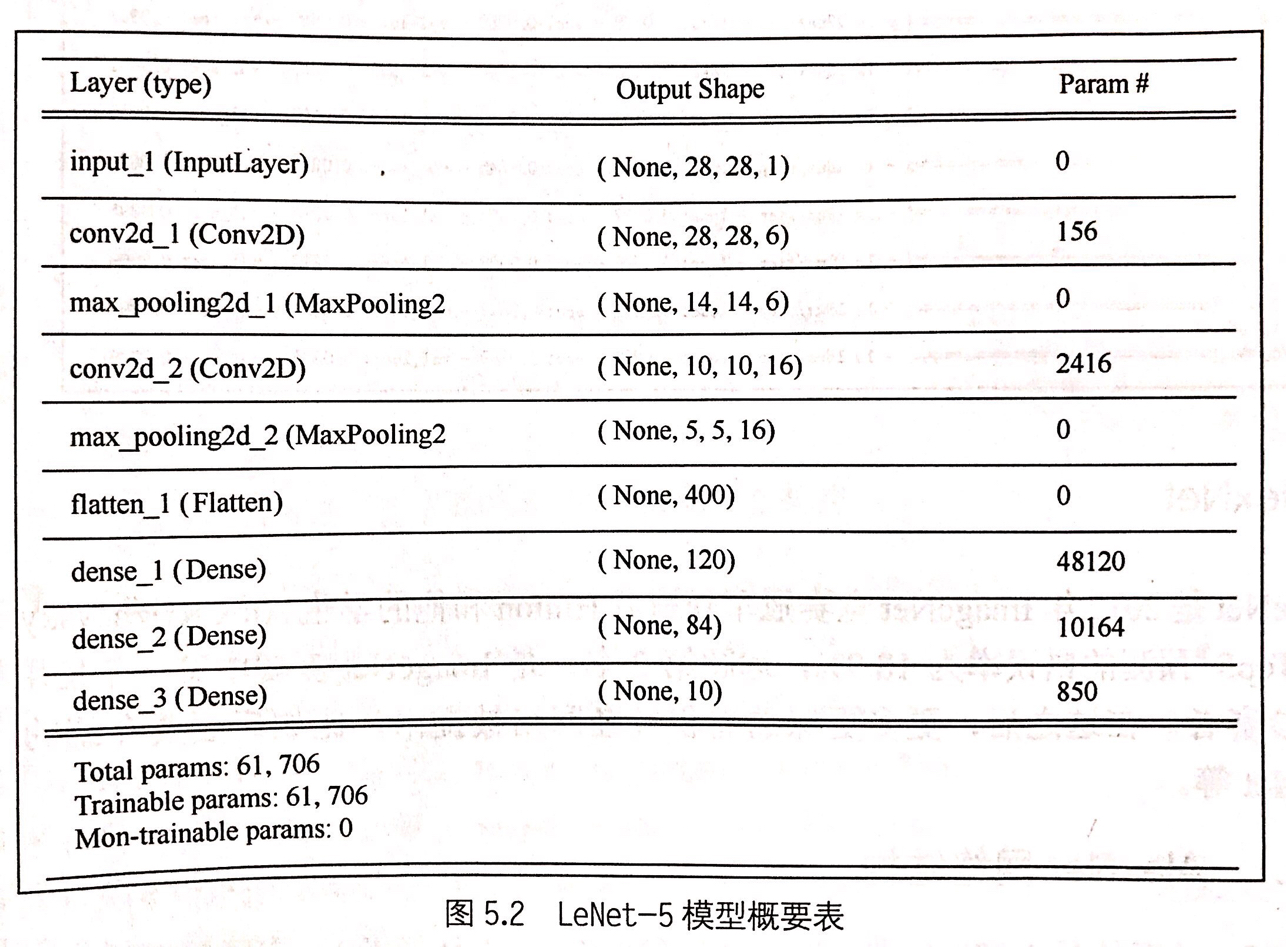

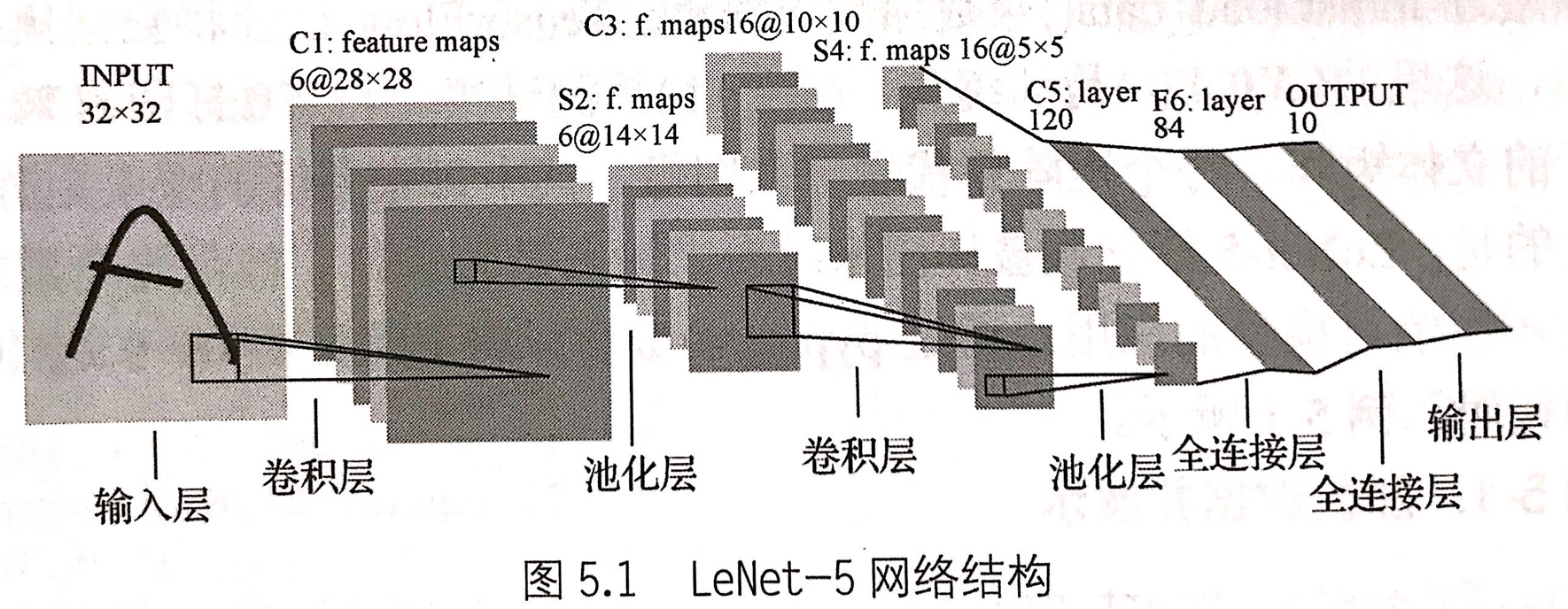

2.1 LeNet-5

LeNet-5网络结构,如果输入层不计入层数,则LeNet-5总共有7层网络,网络结构如下:

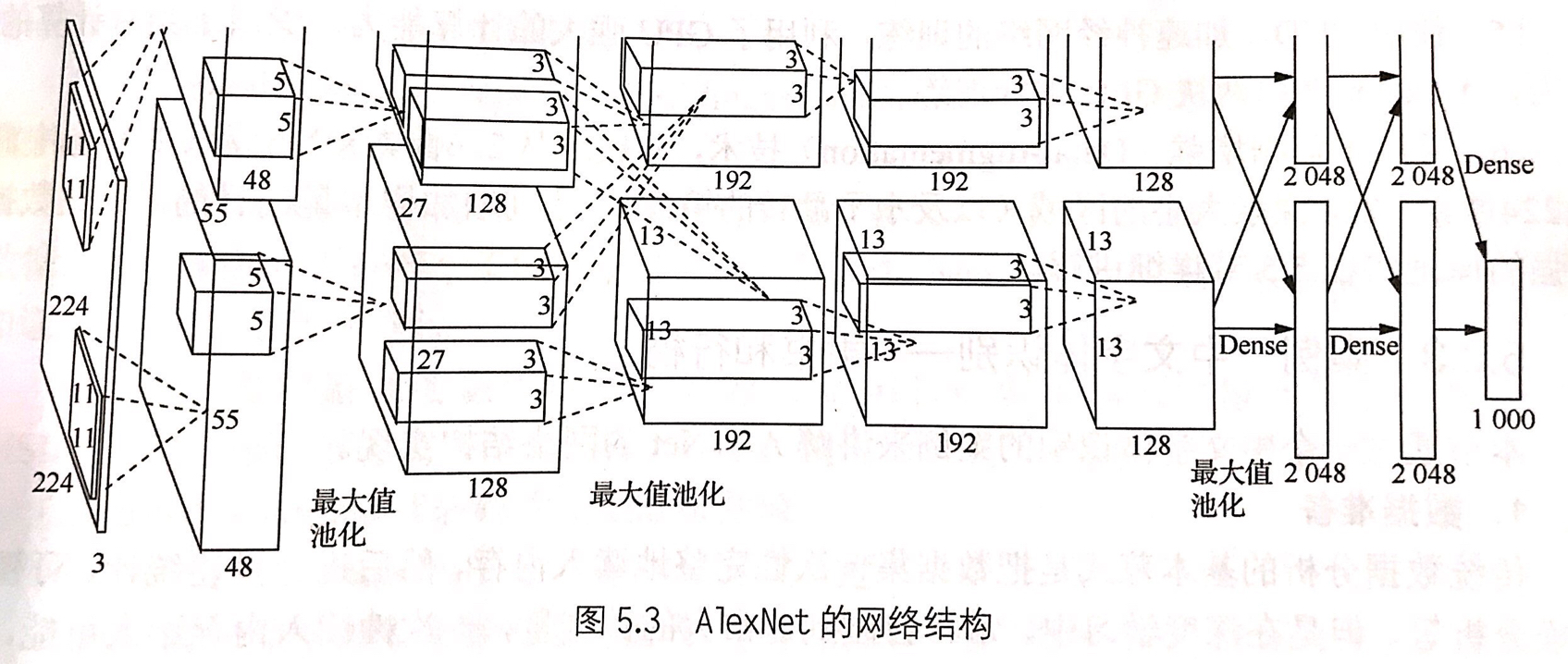

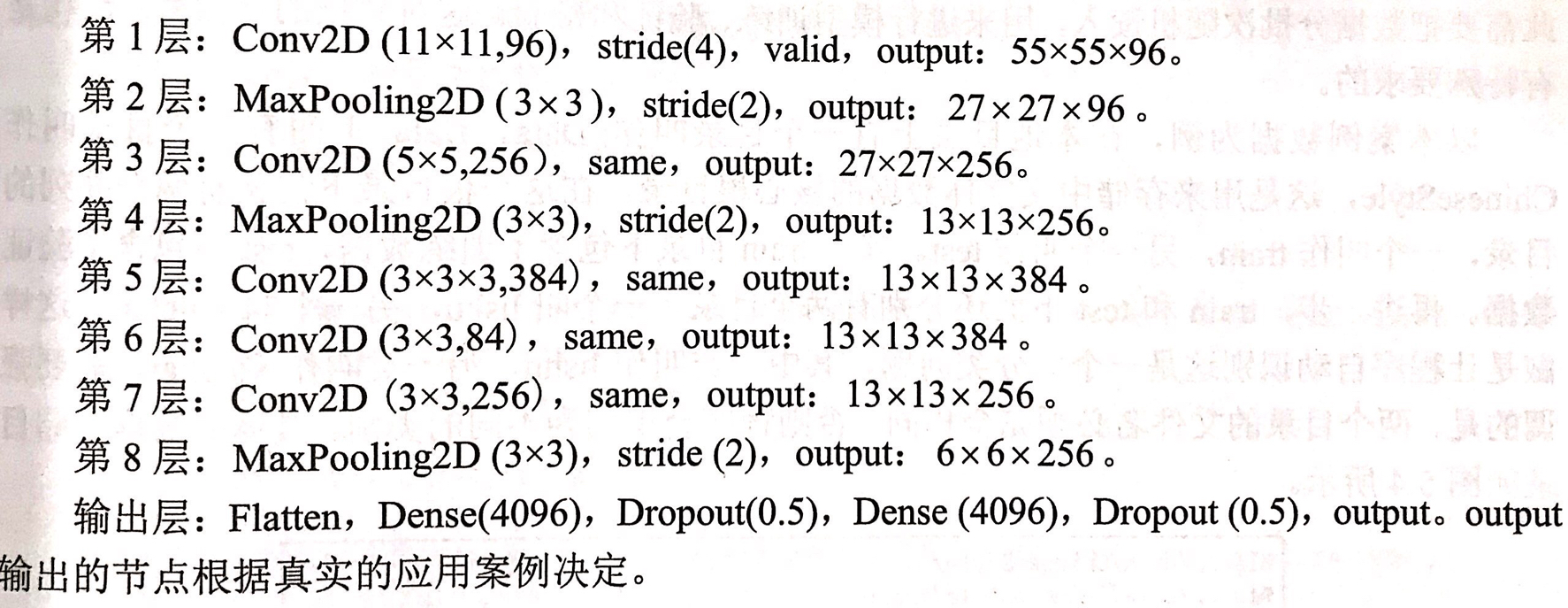

2.2 AlexNet

AlexNet网络结构,如果输入层不计入层数,则AlexNet总共有7层网络,网络结构如下:

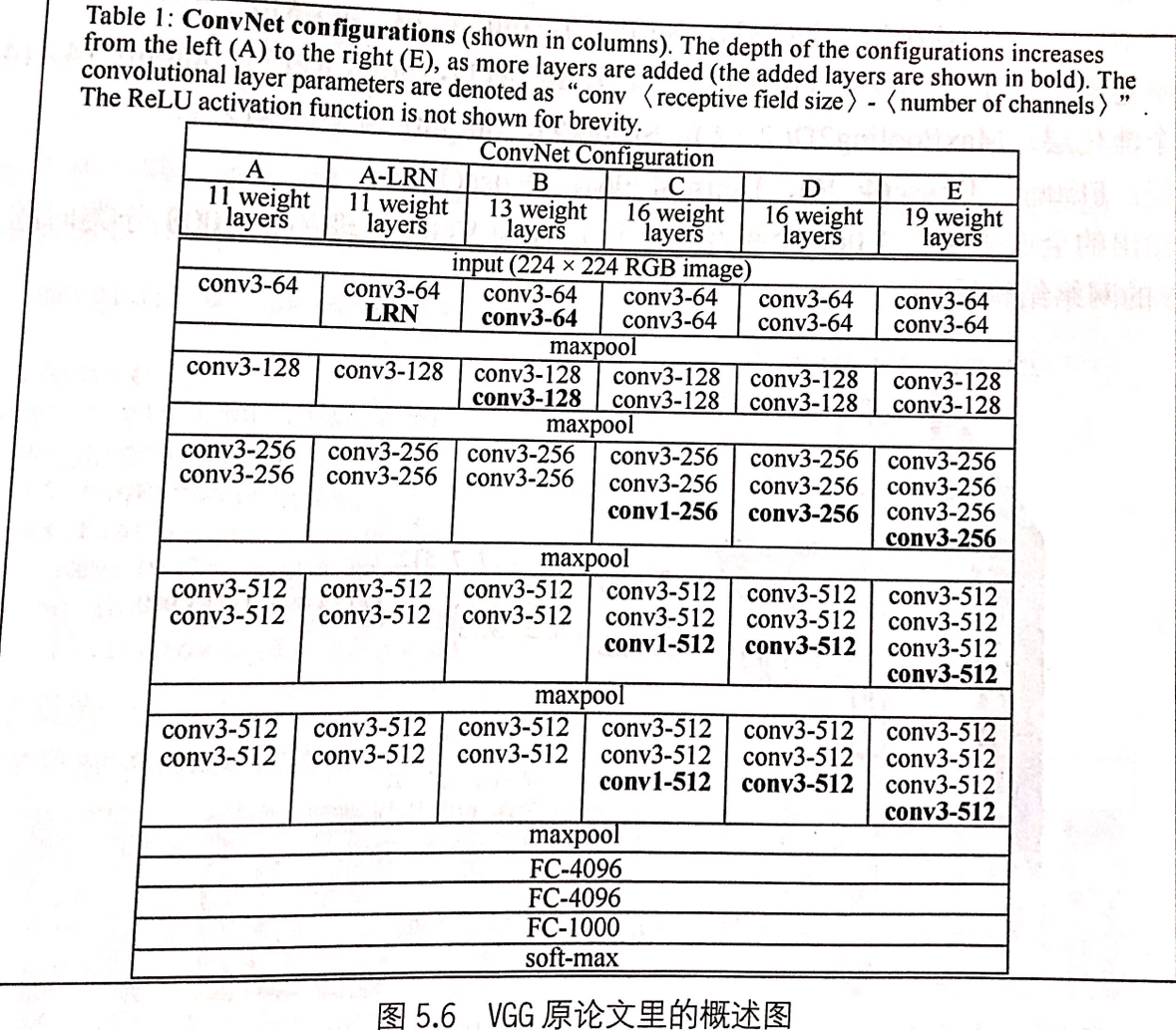

2.3 VGG(牛津大学和Goolge DeepMind公司)

VGG使用小卷积核和增强卷积神经网络的深度提升分类识别效果。VGG共有6种网络结构,如下图5.6所示。其中最广为流传的两种结构是VGG16和VGG19,两者并没有本质上的区别,只是网络深度不同,前者是16层,后者是19层。

2.4 Inception(Google)

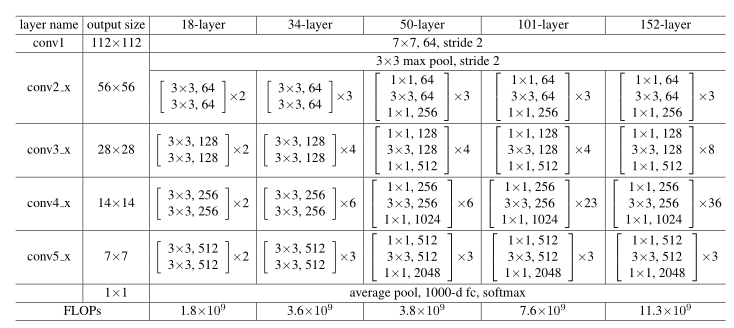

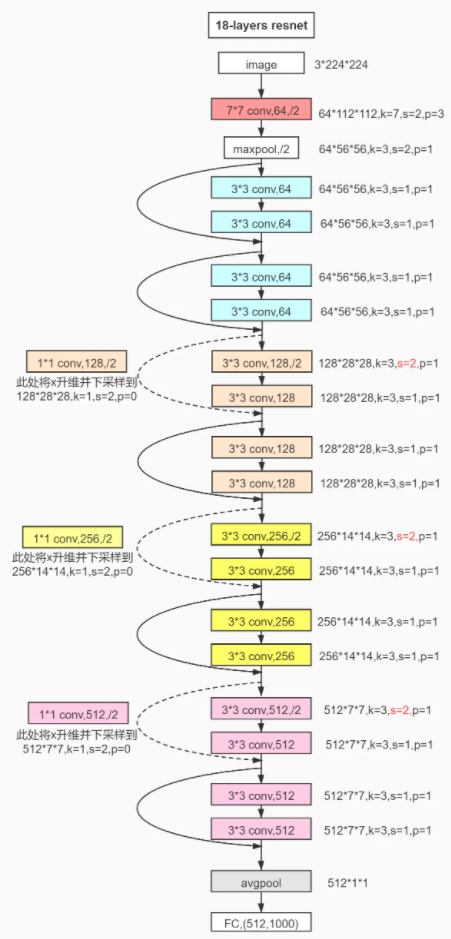

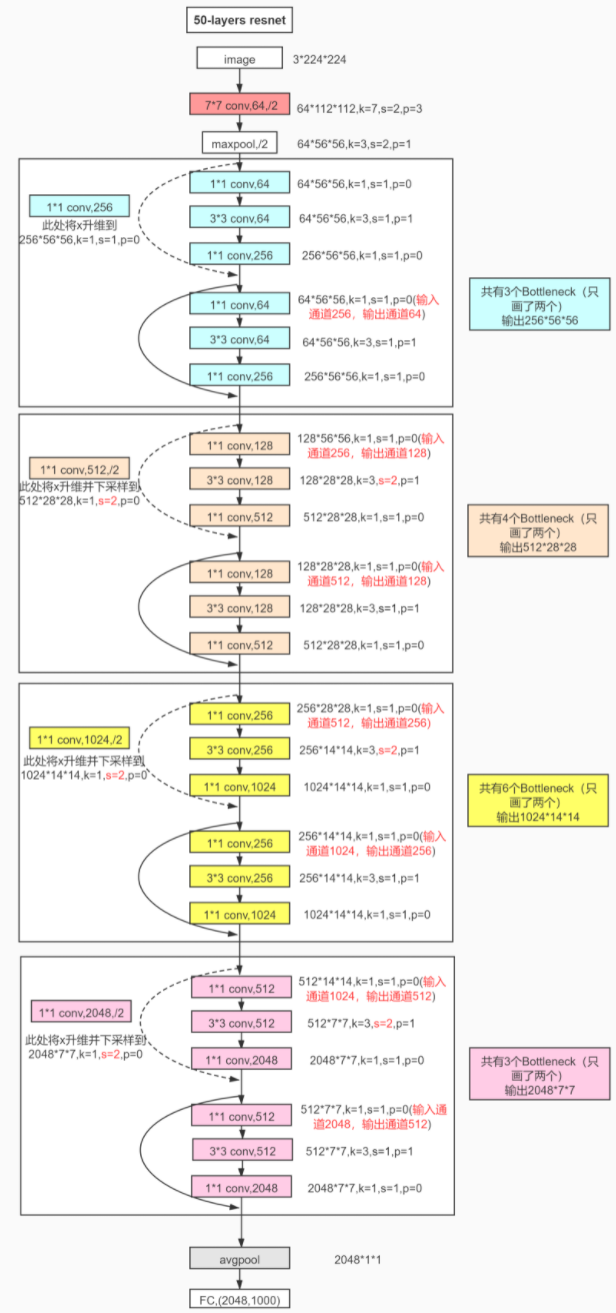

2.5 ResNet

2.6 DenseNet (CVPR2017)

2.7MobileNet(Google)

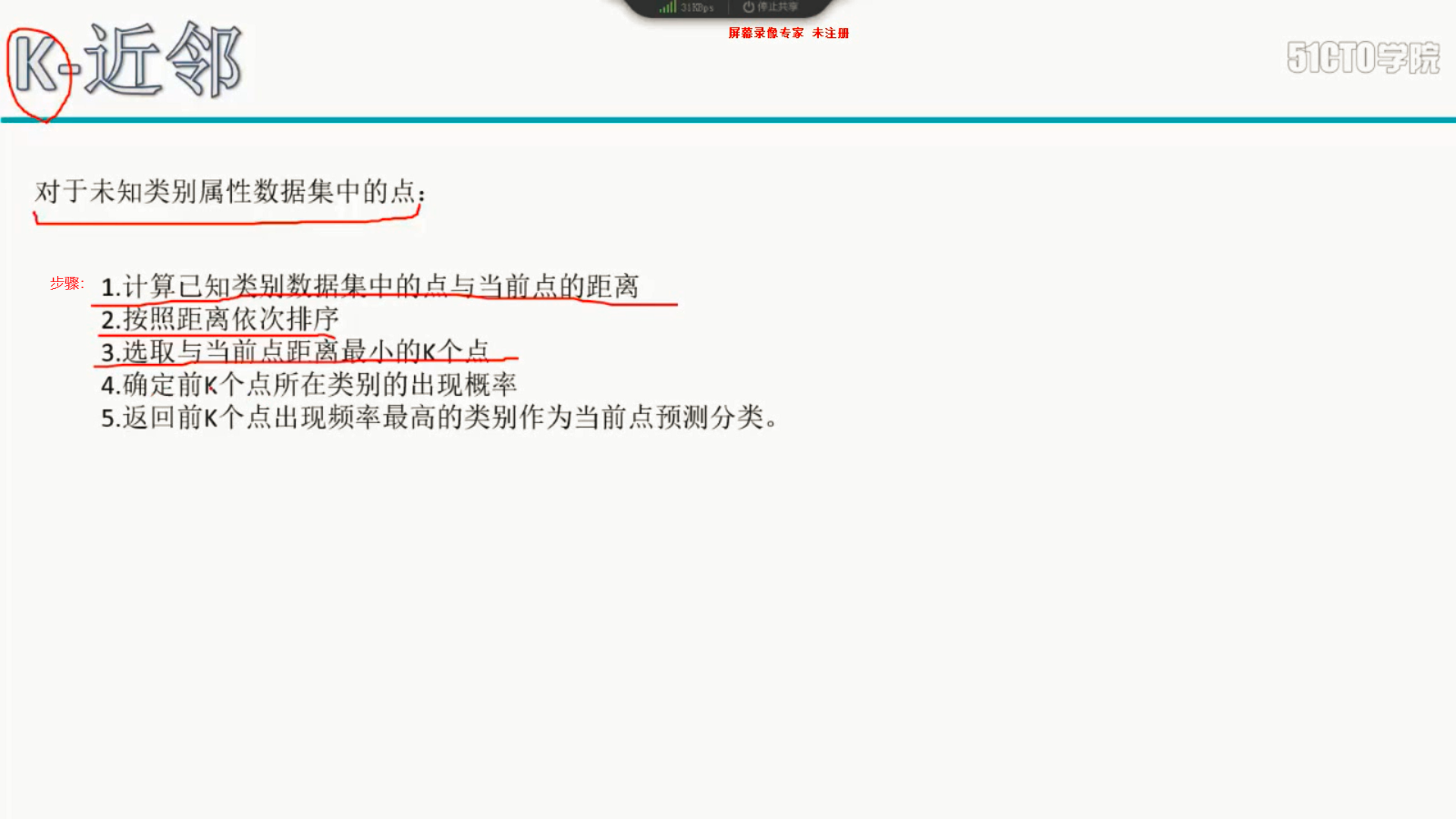

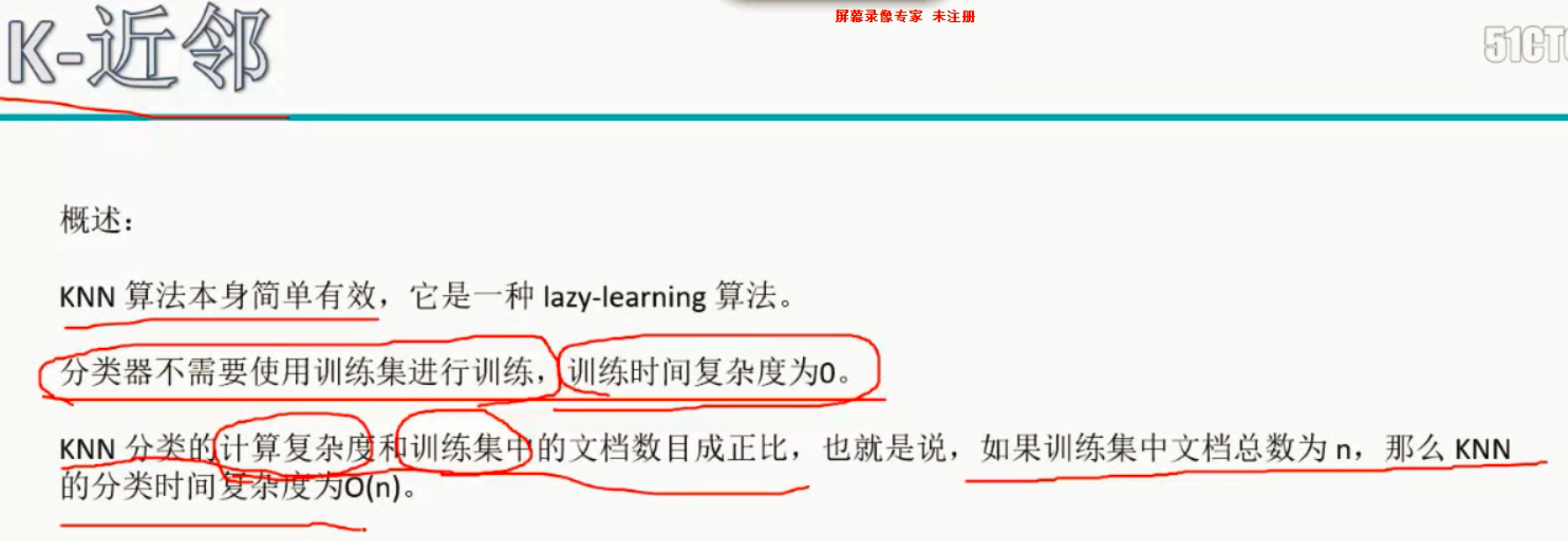

3、KNN(K近邻算法)

K近邻算法:KNN算法

3.1 KNN概念: 3.2 KNN计算步骤:

3.2 KNN计算步骤: 3.3 KNN性能

3.3 KNN性能 3.4 KNN的三个基本要素和解决的问题

3.4 KNN的三个基本要素和解决的问题

4、LSTM(长短期记忆神经网络)

Long Short-term Memory Neural Network:擅于识别文本。

5、GCN(图卷积神经网络)

Graph Convolutional Neural Network:擅于图像识别。

6、GNN(图神经网络)

7、RNN(循环神经网络 or 递归神经网络?)

很明显,它俩名字就是不一样的,循环神经网络是Recurrent Neural Network,递归神经网络是Recursive Neural Network。

当然循环神经网络也确实可以归类到递归神经网络,从广义上说,递归神经网络分为结构递归神经网络和时间递归神经网络。从狭义上说,递归神经网络通常指结构递归神经网络,而时间递归神经网络则称为循环神经网络。

两者最主要的差别就在于循环神经网络(Recurrent Neural Network)是在时间维度展开,递归神经网络(Recursive Neural Network)在空间维度展开。一个很重要的改型LSTM(长短期记忆神经网络)也是基于循环神经网络(Recurrent Neural Network)改进的。

8、 GAN(生成对抗网络)

参考博客:

二、字母缩写

1、FER(面部/人脸表情识别)

2、AU(面部/人脸运动单元)

Action Unit

3、FACS(面部动作编码系统)

Facial Action Coding System

4、SVM(支持向量机)

5、SVR(支持向量回归)

6、RF(随机森林)

7、LRN(局部响应归一化)

局部响应归一化(Local Response Normalization)层,即对当前层的输出结果做平滑处理,后来逐渐被BN(Batch Normalization 批量归一化 详情请看本笔记的深度学习常见的一些概念-5批量归一化 )代替。另一种方法是Data Augmentation(数据增强或数据增广 详情请看本笔记的深度学习常见的一些概念-6数据增强或数据增广 )。

[

">

">

">

">