说明:所有配置文件都存在 /home/bigdata/cluster 下,方便管理

配置步骤

当前路径

/home/bigdata/cluster在当前目录下通过 WGET 下载 Linux 版本的 Spark

wget https://d3kbcqa49mib13.cloudfront.net/spark-2.1.1-bin-hadoop2.7.tgz

- 解压文件并且重命名 spark

tar -xf spark-2.1.1-bin-hadoop2.7.tgz

mv spark-2.1.1-bin-hadoop2.7/ spark

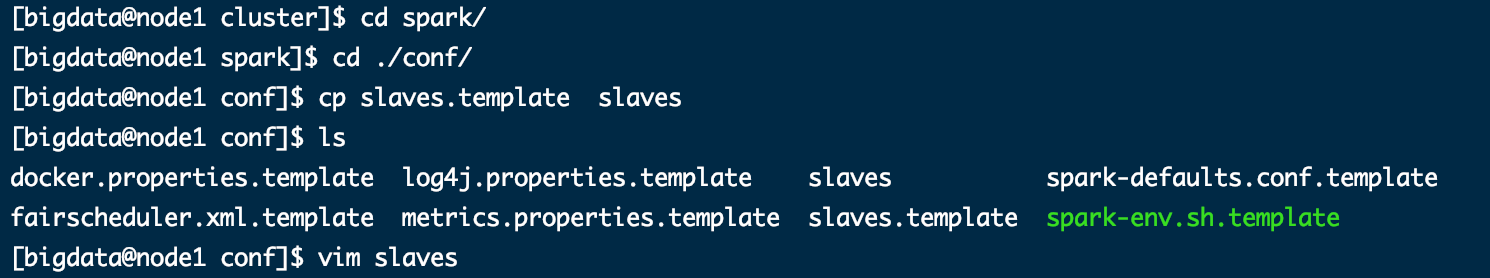

- 修改 slave 配置文件

cd spark/

cd ./conf/

cp slaves.template slaves

vim slaves

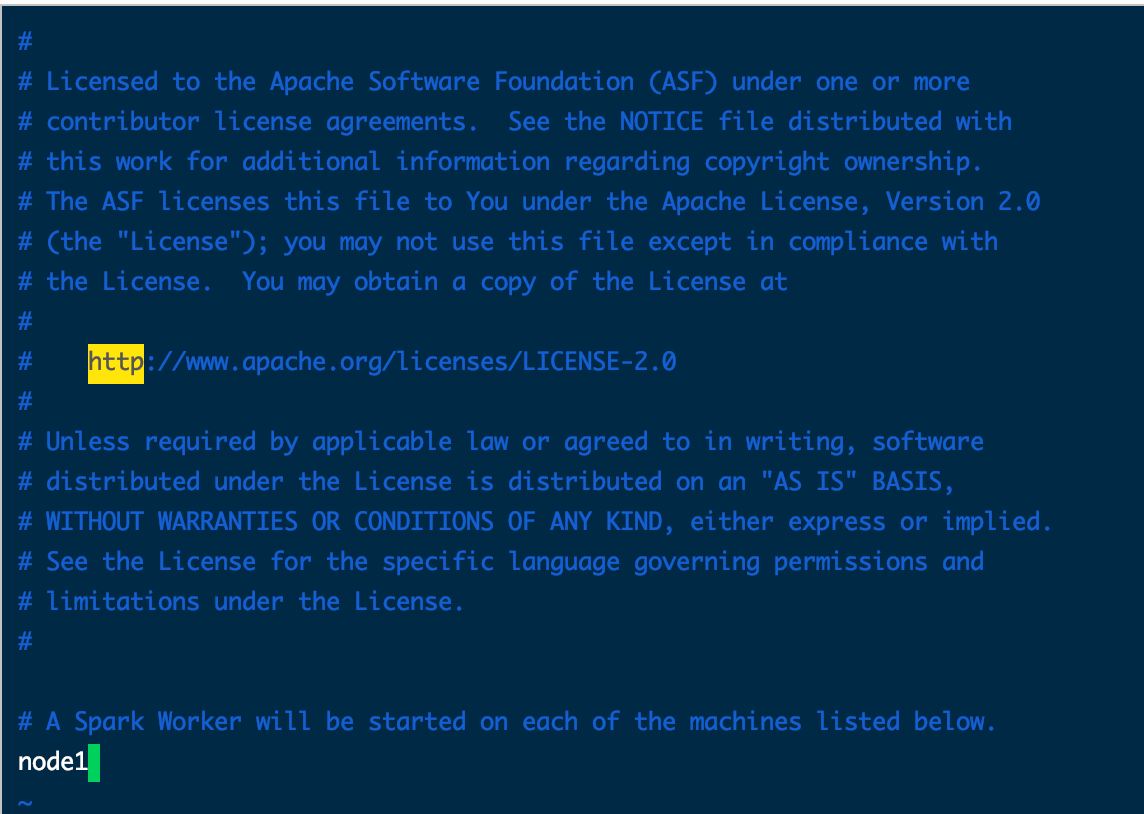

# 在配置中将localhost修改为自己的虚拟机主机名字 我的叫node1

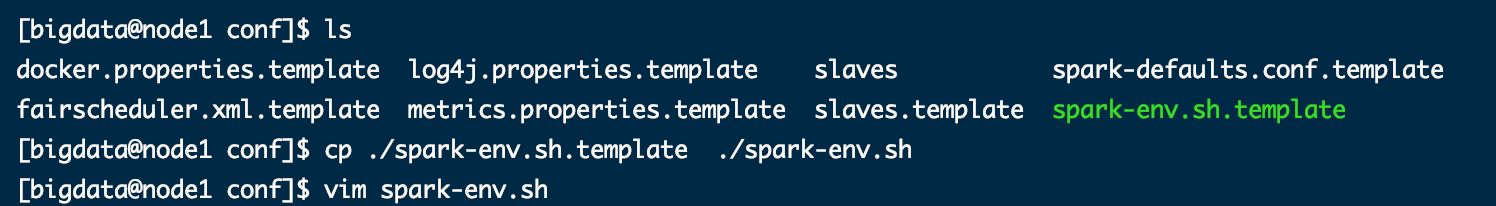

- 拷贝 spark-env.sh.template 另命名为 spark-env ,修改 spark-env 配置文件

cp ./spark-env.sh.template ./spark-env.sh

vim spark-env.sh

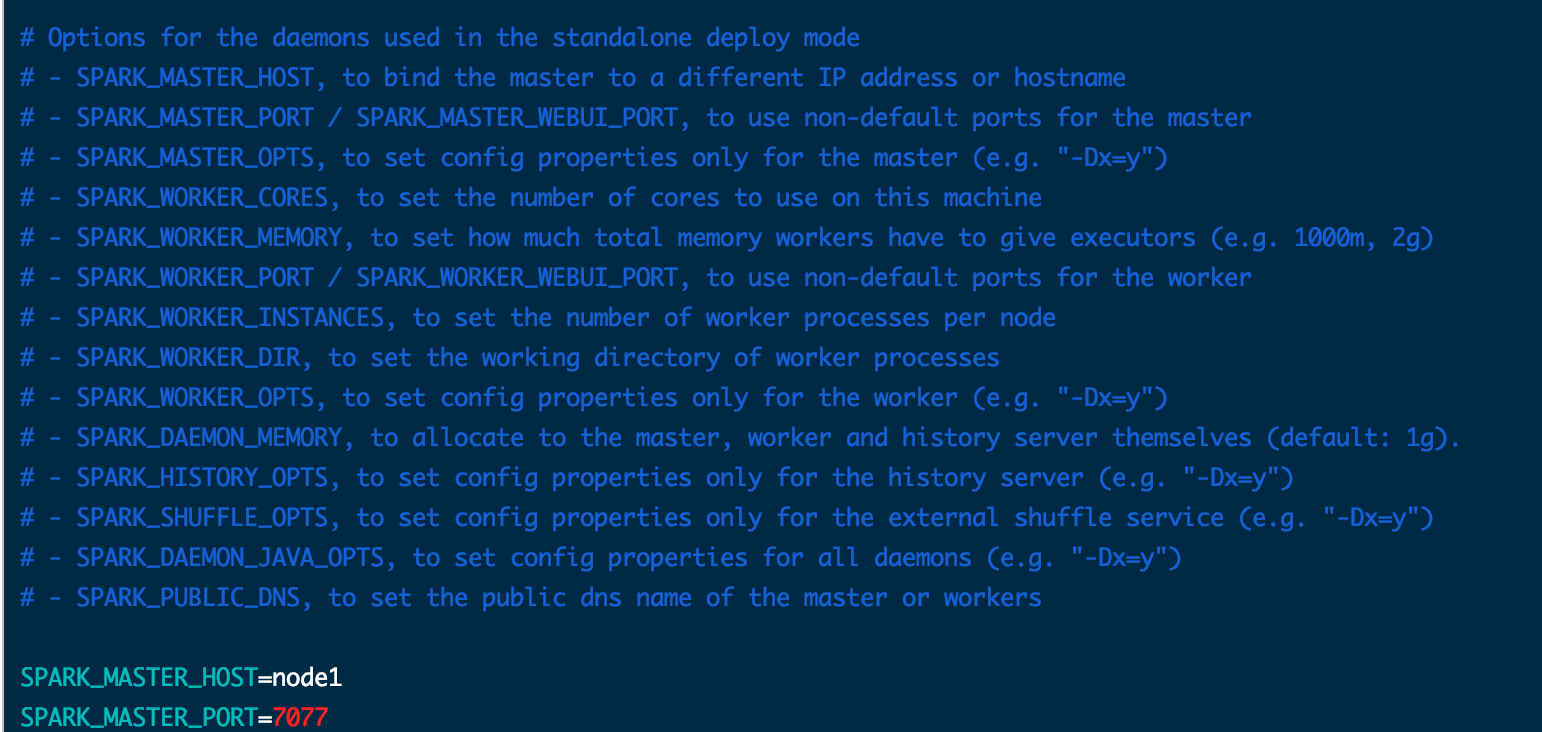

SPARK_MASTER_HOST=node1 #添加 spark master 的主机名

SPARK_MASTER_PORT=7077 #添加 spark master 的端口号

Spark服务的启动与停止

启动Spark服务

- 路径

/home/bigdata/cluster/spark,输入

sbin/start-all.sh

关闭Spark服务

- 路径

/home/bigdata/cluster/spark,输入

sbin/stop-all.sh