顾名思义,知识表示学习是面向知识库的实体和关系进行表示学习。表示学习的目标是通过机器学习将研究对象的语义信息表示为稠密低维实数向量。

知识表示学习的典型应用:

- 相似度计算

- 知识图谱的补全 利用知识表示学习模型,可以预测2个实体之间的关系,这一般称为知识库的链接预测

- 其他应用 关系抽取、自动问答、实体链指等任务。

知识表示学习的主要优点:

- 显著提升计算效率

- 有效缓解数据稀疏

- 实现异质信息融合

1.知识表示学习的主要方法

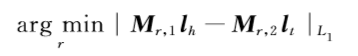

距离模型

将头实体向量

将头实体向量和尾实体向量

通过关系

的两个矩阵投影到

的对应空间中,然后在该空间中计算两投影向量的距离,能够利用学到的知识表示进行链接预测,通过计算

找到令两个实体距离最近的关系矩阵。

找到令两个实体距离最近的关系矩阵。

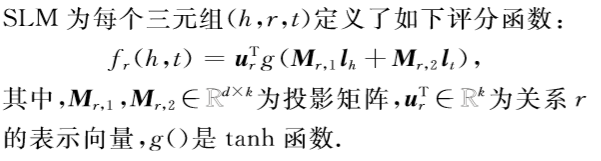

缺点:对头尾两个实体使用两个不同的矩阵进行投影,协同性较差,无法精确刻画两尸体与关系之间的语义联系。单层神经网络模型(Single Layer Model,SLM)

采用单层神经网络的非线性操作来减轻SE的方法无法精确刻画实体与关系的语义联系问题。

SLM有所改进但是它的非线性操作也引入更高的计算复杂度。

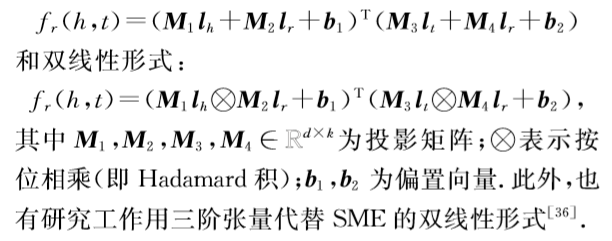

能量模型(Semantic Matching Energy,SEM)

更复杂的模型,提出寻找实体和关系之间的语义联系

SME为每个三元组定义了线性和双线性两种形式

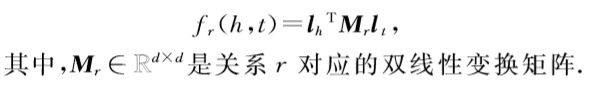

双线性模型

隐变量模型LFM提出利用基于关系的双线性变换,刻画实体和关系之间的二阶关系

LFM取得了巨大突破,通过简单有效的方法刻画了实体和关系的语义联系,协同性较好,复杂度较低。

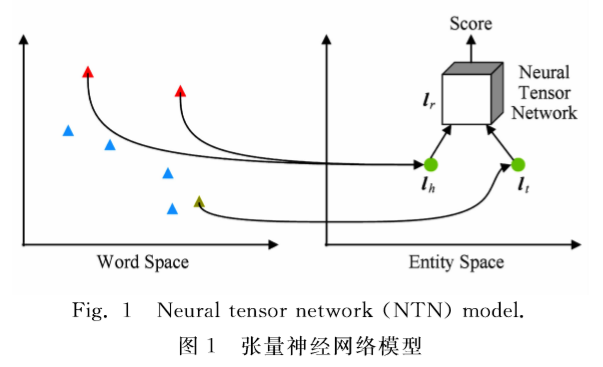

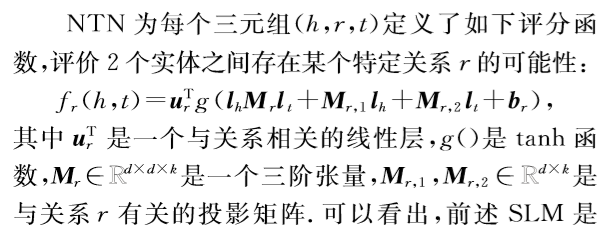

张量神经网络模型(NTN)

基本思想:用双线性张量取代传统神经网络中的线性变换层,将不同维度下将头尾实体向量联系起来

优点:更加准确的刻画实体和关系的复杂语义联系

缺点:计算复杂度很高,需要大量的三元组样例才能够得到充分学习,在大规模稀疏的知识图谱上效果较差。

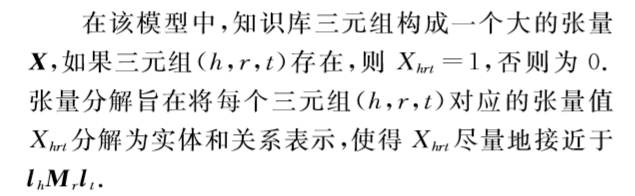

矩阵分解模型

翻译模型

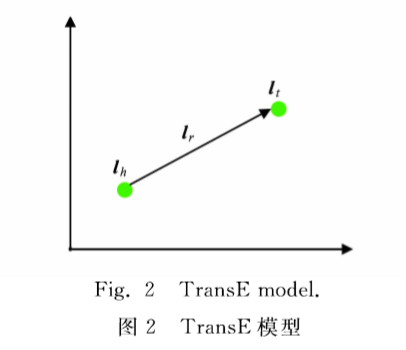

类比的NLP的word2vec模型,Bordes提出了TransE模型

用关系的向量

作为头实体向量

和尾实体向量

之间的平移,也可以看作是翻译,因此该模型也被称为翻译模型。希望

,TransE模型的损失函数如下:

,TransE模型的损失函数如下:

其他模型

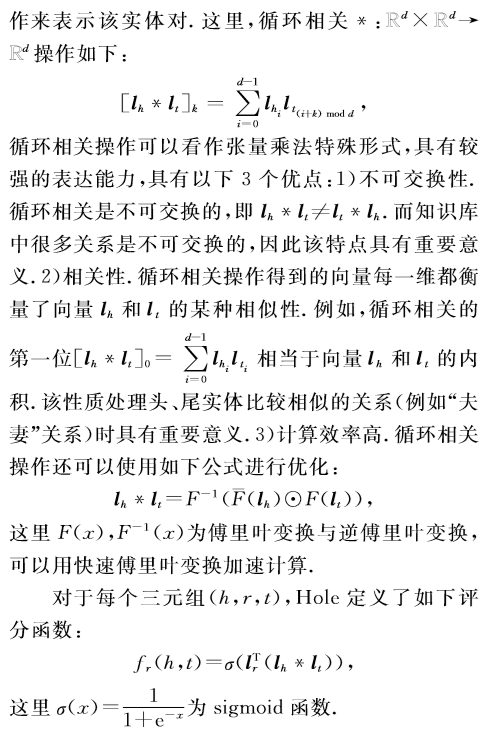

自从TransE模型提出之后,大部分知识表示学习模型是以TransE为基础的扩展,这里主要介绍全息表示模型(Hole)

Hole模型提出使用头尾实体向量循环相关操作来表示实体对。

2.KRL面临的挑战

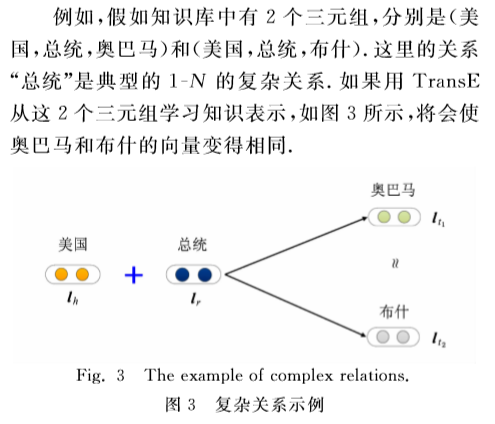

复杂关系建模

按照对应关系,可以分为1-1,1-N,N-1,N-N四种类型,后三者均称为复杂关系。

如何应对实现表示学习对复杂关系的建模?有大量关于TransE的扩展模型尝试解决这一问题,下面介绍其中的7个代表模型。

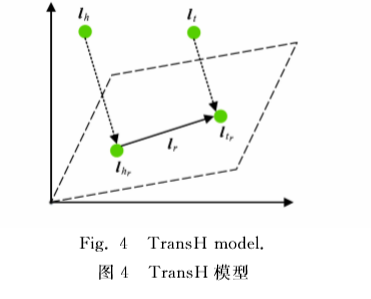

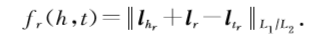

TransH Model

该模型同时使用平移向量和超平面的法向量

来表示它

先进行投影

TransH的损失函数:

优点:每个实体在不同关系下拥有了不同的表示

缺点:仍然假定实体和关系处于相同的语义空间

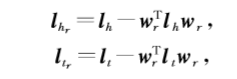

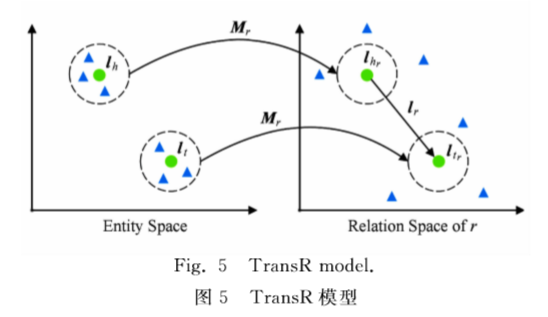

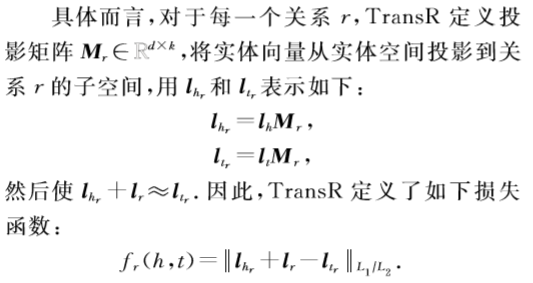

TransR/CTransR Model

TransR认为不同的关系拥有不同的语义空间,对每个三元组,实体首先投影到对应的关系空间中然后再建立从头实体到尾实体的翻译关系。

缺点:

- 在同一个关系

下,头尾实体共享相同的投影矩阵,这不是很合理,比如三元组(美国,总统,奥巴马);

- 投影矩阵仅与关系有关是不合理的;

- 引入了空间投影使得TransR模型参数剧增,复杂度提高;

Lin等人进一步提出了CTransR模型,通过把关系r进行更细致的划分,划分成多个子关系,这种模型的损失函数如下:

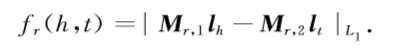

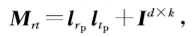

TransD Model

设置了两个投影矩阵和

,

,

,

损失函数如下:

优点:投影矩阵解决了原来TransR模型参数过多的问题 ?

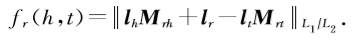

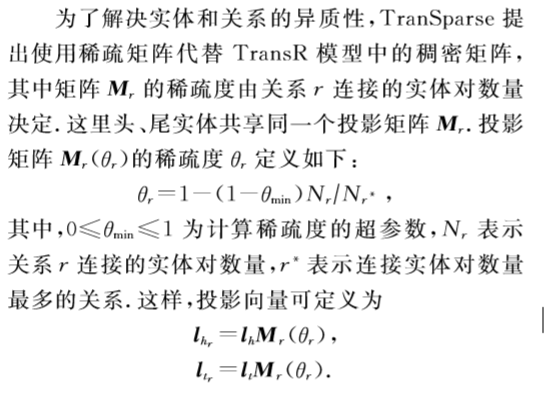

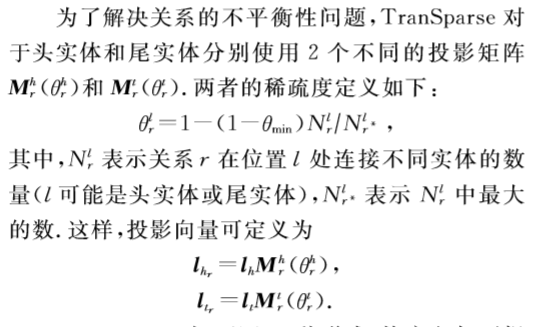

TranSparse Model

知识表示学习中实体和关系的异质性和不平衡性是制约知识表示学习的难题。

- 异质性:某些关系与大量实体有关系,某些实体与少量实体有连接

- 不平衡性:头实体和尾实体的种类和数量差别巨大,比如国籍这个关系

为了解决以上两个问题,使用稀疏矩阵代替稠密矩阵

对于以上两种形式,均使用如下的损失函数:

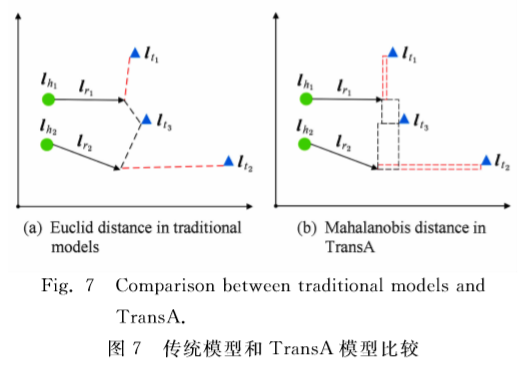

TransA Model

TransE之后的模型有两个问题:

- 损失函数只使用L1或者L2距离,不够灵活

- 损失函数过于简单,实体和关系向量每一维等同考虑

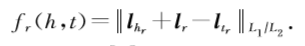

TransG Model

该模型认为:一种关系会对应多种语义,每种语义用一个高斯分布刻画。

优点:能够考虑的不同语义形成多个高斯分布,能够区分正确和错误实体。

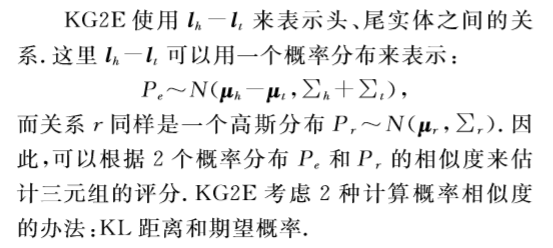

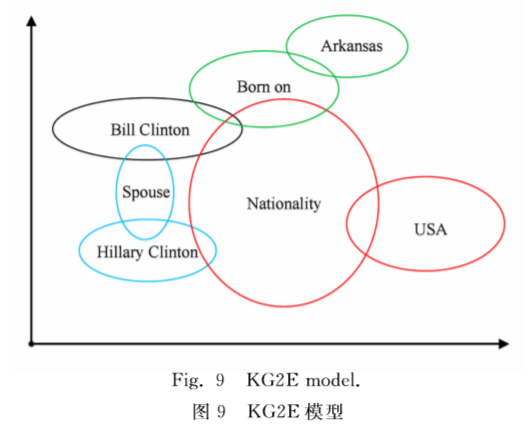

KG2E Model

使用高斯分布表示实体和关系,其中高斯分布表示的实体/关系在语义空间中的中心位置,而高斯分布的协方差则表示该实体或关系的不确定度。

多源信息融合

仅利用知识图谱的三元组结构信息进行表示学习,尚有大量与知识有关的其他信息没有得到有效利用。

考虑实体描述的知识表示学习模型(DKRL)

考虑知识库中提供的实体描述的文本信息,使用CBOW/CNN模型,不仅可以提升实体表示能力还能实现对新实体的表示。

文本与知识库融合的知识表示学习

用word2vec学习维基百科中词的表示,利用transE学习知识库中的知识表示,让二者尽可能的相近,实现文本与知识库融合的表示学习。

关系路径建模

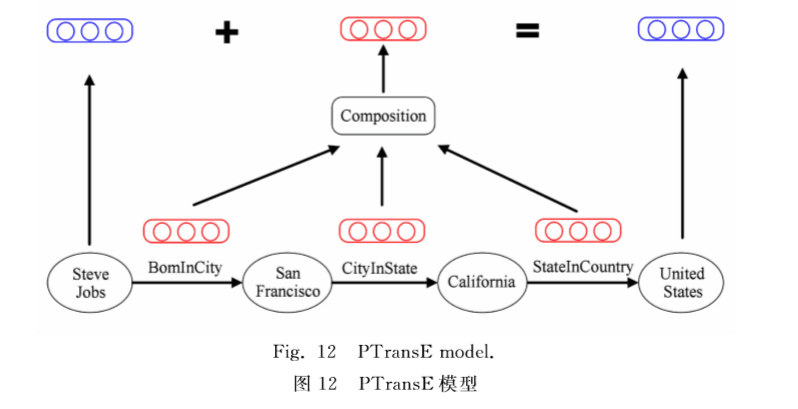

该方法提出考虑关系路径的表示学习方法,以TransE作为扩展基础,提出Path-based-Based TransE(PTransE)

该方法面临的挑战:

- 并不是实体间所有路径都是可靠的

- 需要建立关系路径的向量表示,参与从头到尾的翻译过程,典型的组合语义问题

实验结果表示:考虑关系路径能够极大提升知识表示学习的区分性,提高在知识图谱补全任务上的性能。

3.未来方向展望

- 面向不同知识类型的知识表示学习

- 多源信息融合的知识表示学习

- 复杂推理模式的知识表示学习

- 面向大规模知识库的在线学习和快速学习

- 基于知识分布式表示的应用