网页版教程:

首先,在虚拟机中安装Ubuntu系统。http://www.ubuntu.org.cn/download/desktop

1.创建Hadoop用户

sudo useradd -m hadoop -s /bin/bash # 创建hadoop用户sudo passwd hadoop # 设置密码sudo adduser hadoop sudo # 给hadoop用户添加管理员权限

2.更新apt和安装vim编辑器

sudo apt-get updatesudo apt-get install vim# sudo rm /var/lib/dpkg/lock-frontend #如果安装vim时提示无法获得锁,可以用该命令强制解锁后再安装# sudo rm /var/lib/dpkg/lock #如果仍然提示,再强制删除该锁# 以上强制解锁并不太好,可能会损坏文件

3.安装SSH和配置SSH无密码登录

sudo apt-get install openssh-server # Ubuntu自带客户端,这里只需要安装SSH服务端# 有密码登录ssh localhost #出现提示后,输入yes,然后输入密码就能登录,但每次都要输入密码# 设置无密码登录cd ~/.ssh/ssh-keygen -t rsa # 一路按回车cat ./id_rsa.pub >> ./authorized_keys

4.安装Java环境

https://www.oracle.com/java/technologies/downloads/archive/

# 我们首先去Oracle官网或者其他渠道下载jdk1.8或以上版本 到 /home/hadoop/Downloads/ 目录下,这是前提# jdk1.8 就是 jdk8 所以只要下载对应Linux系统版本的 jdk-8uxxx-linux-x64.tar.gz 就好了

你可以直接在 Linux 中的可视化界面通过浏览器下载,也可以在宿主机下载后通过 Xftp 传送到虚拟机中。

注意!一定要下载Linux版本的!

准备完毕后,开始安装:

cd /usr/libsudo mkdir jvm # 创建/usr/lib/jvm目录来存放JDK文件# 将hadoop用户Downloads目录下的jdk解压到jvm目录下su hadoopcd ~/Downloads/sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm/vim ~/.bashrc# 上面命令打开hadoop用户的环境变量配置文件,在这个文件的开头位置,添加如下几行内容:其中jdk的版本号按照自己下载的版本修改对应。export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/libexport PATH=${JAVA_HOME}/bin:$PATHsource ~/.bashrcjava -version #检查是否安装成功# 如果显示以下信息 代表成功:java version "1.8.0_162"Java(TM) SE Runtime Environment (build 1.8.0_162-b12)Java HotSpot(TM) 64-Bit Server VM (build 25.162-b12, mixed mode)

5.安装单机Hadoop

首先,下载Hadoop压缩包。书上用的版本是hadoop1.3.1,同样也是下载到 ~/Downloads目录下,和 jdk 一样

下载地址:https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz

Hadoop官方网址:https://hadoop.apache.org/releases.html

Hadoop1.3.1使用手册(英文):https://hadoop.apache.org/docs/r3.1.3/

准备好后开始安装单机Hadoop(使用本机存储,而不是分布式存储):

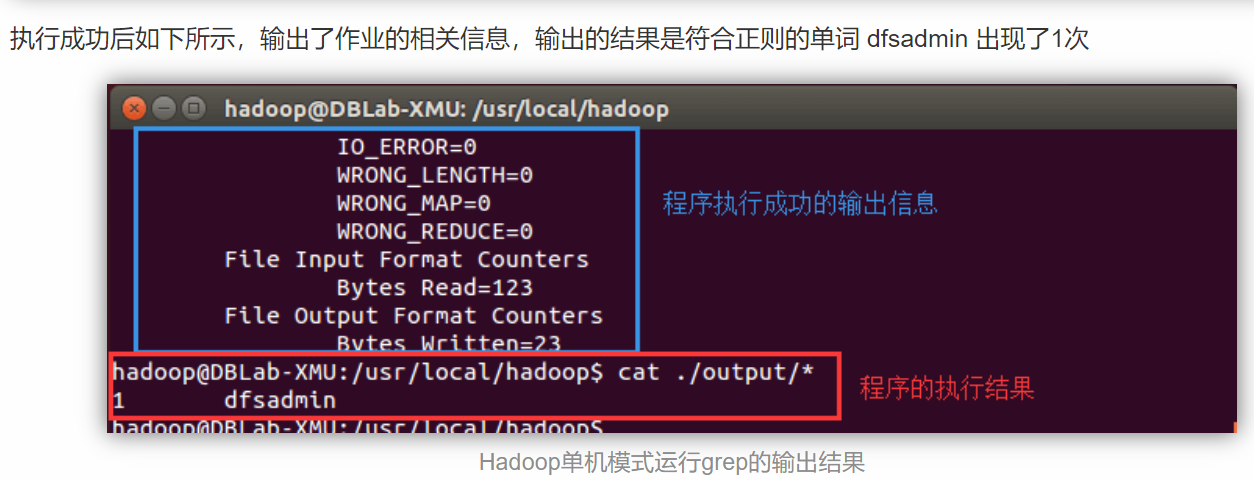

sudo tar -zxf ~/Downloads/hadoop-3.1.3.tar.gz -C /usr/local # 解压cd /usr/localsudo mv ./hadoop-3.1.3/ ./hadoop # 修改目录名称sudo chown -R hadoop ./hadoop # 修改目录权限cd /usr/local/hadoop # 转到安装目录下./bin/hadoop version # 使用hadoop目录下的bin,可以查看Hadoop的版本信息# 运行Hadoop文档中的一些测试实例,我们运行Grep实例来检测是否安装成功# 在安装目录下创建 input 目录,用来存放输入数据cd /usr/local/hadoopmkdir input# 将/usr/local/hadoop/etc/hadoop 目录下的配置文件复制到input目录下cp ./etc/hadoop/*.xml ./input# 执行如下代码运行Grep实例./bin/hadoop jar /usr/local/hadoop/share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep ./input ./output 'dfs[a-z.]+'# 查看输出信息cat ./output/*

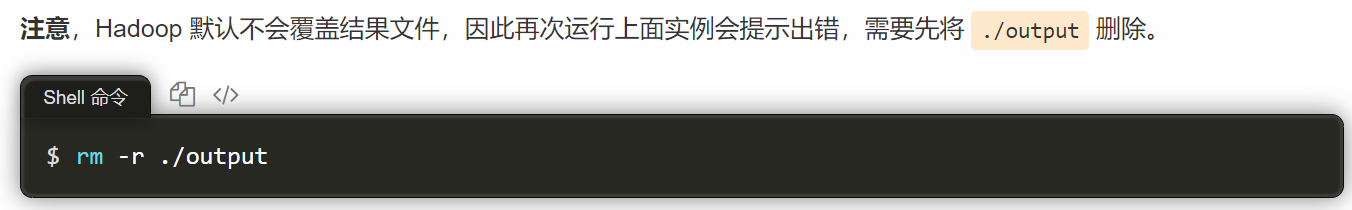

注意点:如果要重新运行实例,则需要先将./output删除,因为Hadoop默认不会覆盖结果文件

6.Hadoop伪分布式安装

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 名称节点NameNode 也作为 数据节点DataNode,同时,读取的是 HDFS 中的文件。

Hadoop 的配置文件位于 /usr/local/hadoop/etc/hadoop/ 中,伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。

# 修改配置文件 core-site.xml<configuration><property><name>hadoop.tmp.dir</name><value>file:/usr/local/hadoop/tmp</value><description>Abase for other temporary directories.</description></property><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration># 同样的,修改配置文件 hdfs-site.xml:<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.namenode.name.dir</name><value>file:/usr/local/hadoop/tmp/dfs/name</value></property><property><name>dfs.datanode.data.dir</name><value>file:/usr/local/hadoop/tmp/dfs/data</value></property></configuration>

Hadoop配置文件说明

对于hdfs-site.xml文件,这里设置replication值为1,它限制了HDFS中同一份数据的副本数量,也就是冗余值,1也是Hadoop运行的默认最小值。由于这里采用伪分布式,集群中只有一个节点,因此副本数量replication的值也只能设置为1

Hadoop 的运行方式是由配置文件决定的(运行 Hadoop 时会读取配置文件),因此如果需要从伪分布式模式切换回非分布式模式,需要删除 core-site.xml 中的配置项。

此外,伪分布式虽然只需要配置 fs.defaultFS 和 dfs.replication 就可以运行(官方教程如此),不过若没有配置 hadoop.tmp.dir 参数,则默认使用的临时目录为 /tmp/hadoo-hadoop,而这个目录在重启时有可能被系统清理掉,导致必须重新执行 format 才行。所以我们进行了设置,同时也指定 dfs.namenode.name.dir 和 dfs.datanode.data.dir,否则在接下来的步骤中可能会出错。

在配置完成后,首先需要初始化文件系统,由于Hadoop的很多工作是在自带的HDFS上完成的,因此,需要将文件系统初始化之后才能进一步执行计算任务。执行名称节点namenode初始化的命令如下:

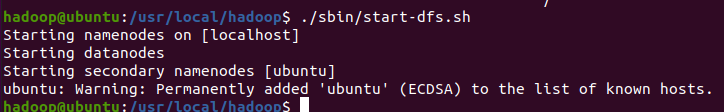

cd /usr/local/hadoop./bin/hdfs namenode -format# 文件系统初始化成功以后,可以用如下命令启动HDFScd /usr/local/hadoop./sbin/start-dfs.sh

消息提示:启动名称节点到localhost,启动数据节点,启动第二名称节点。

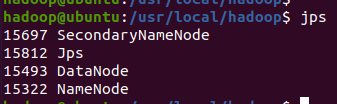

jps # 使用该命令查看是否启动成功

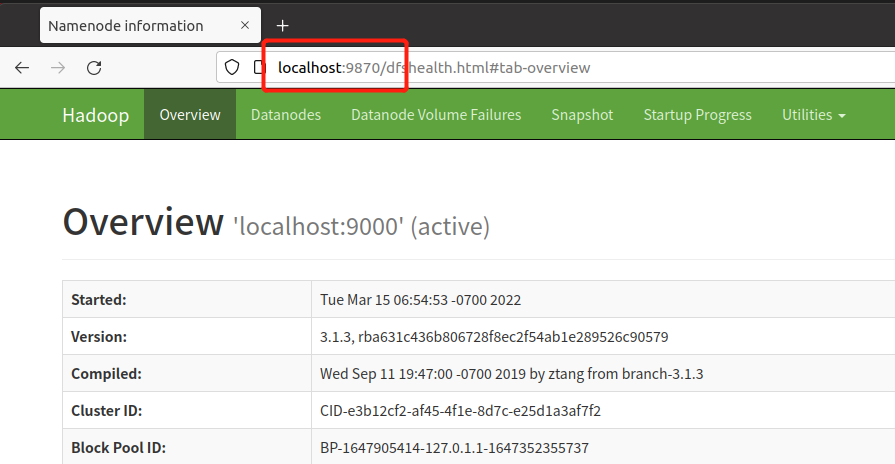

此时,可以访问Web页面,localhost:9870 来查看Hadoop的信息:

# 接下来,要使用HDFS必须创建一个用户,在HDFS中创建hadoop用户的用户目录:cd /usr/local/hadoop./bin/hdfs dfs -mkdir -p /user/hadoop# 接着将 ./etc/hadoop 中的 xml 文件作为输入文件复制到分布式文件系统中,即将 /usr/local/hadoop/etc/hadoop 复制到分布式文件系统中的 /user/hadoop/input 中。我们使用的是 hadoop 用户,并且已创建相应的用户目录 /user/hadoop ,因此在命令中就可以使用相对路径如 input,其对应的绝对路径就是 /user/hadoop/input:./bin/hdfs dfs -mkdir input./bin/hdfs dfs -put ./etc/hadoop/*.xml input./bin/hdfs dfs -ls input # 复制完成后可以用该命令查看文件列表

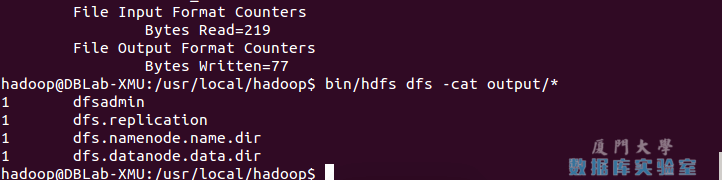

# 伪分布式运行 MapReduce 作业的方式跟单机模式相同,区别在于伪分布式读取的是HDFS中的文件(可以将单机步骤中创建的本地 input 文件夹,输出结果 output 文件夹都删掉来验证这一点)。./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar grep input output 'dfs[a-z.]+'./bin/hdfs dfs -cat output/* # 查看运行结果的命令(查看的是位于 HDFS 中的输出结果):

结果如下,注意到刚才我们已经更改了配置文件,所以运行结果不同。

Hadoop伪分布式运行grep结果

我们也可以将运行结果取回到本地:

rm -r ./output # 先删除本地的 output 文件夹(如果存在)./bin/hdfs dfs -get output ./output # 将 HDFS 上的 output 文件夹拷贝到本机cat ./output/*

Hadoop 运行程序时,输出目录不能存在,否则会提示错误 “org.apache.hadoop.mapred.FileAlreadyExistsException: Output directory hdfs://localhost:9000/user/hadoop/output already exists” ,因此若要再次执行,需要执行如下命令删除 output 文件夹:

./bin/hdfs dfs -rm -r output # 删除 output 文件夹

运行程序时,输出目录不能存在

运行 Hadoop 程序时,为了防止覆盖结果,程序指定的输出目录(如 output)不能存在,否则会提示错误,因此运行前需要先删除输出目录。在实际开发应用程序时,可考虑在程序中加上如下代码,能在每次运行时自动删除输出目录,避免繁琐的命令行操作:

Configuration conf = new Configuration();Job job = new Job(conf);/* 删除输出目录 */Path outputPath = new Path(args[1]);outputPath.getFileSystem(conf).delete(outputPath, true);

若要关闭 Hadoop,则运行

./sbin/stop-dfs.sh

注意

下次启动 hadoop 时,无需进行 NameNode 的初始化,只需要运行 ./sbin/start-dfs.sh 就可以!