1. HDFS appendToFile命令DFSClient问题

2.hadoop伪分布式运行时lease recovery is in progress解决办法

借鉴于https://blog.csdn.net/xutao_ccu/article/details/84729640

今天做厦门大学大数据系统的课的实验2时,出现了如题错误。按照链接的办法成功解决了。

出现问题的原因是:集群节点少于3个在运行时就会抛异常;

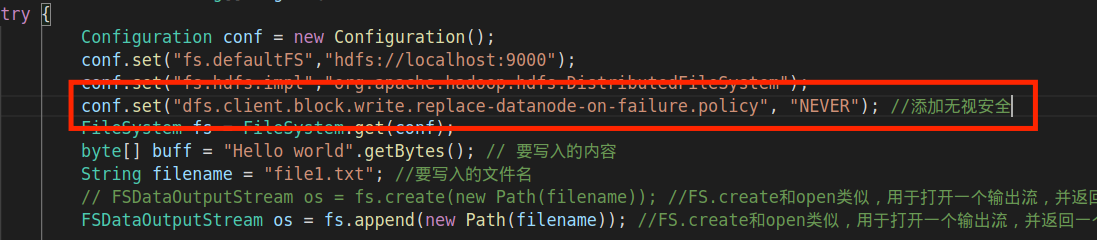

解决办法就是加入conf.set(“dfs.client.block.write.replace-datanode-on-failure.policy”, “NEVER”); 这条配置。

如下:

// 写入文件import org.apache.hadoop.conf.Configuration;import org.apache.hadoop.fs.FileSystem; //用于创建文件系统实例,用FileSystem.create方法可以打开一个输出流,返回FSDataOutputStreamimport org.apache.hadoop.fs.FSDataOutputStream;import org.apache.hadoop.fs.Path; // 用于创建和解决文件路径,且FileSystem的方法大部分要求必须传入Path对象public class WriteFIle {public static void main(String[] args) {try {Configuration conf = new Configuration();conf.set("fs.defaultFS","hdfs://localhost:9000");conf.set("fs.hdfs.impl","org.apache.hadoop.hdfs.DistributedFileSystem");conf.set("dfs.client.block.write.replace-datanode-on-failure.policy", "NEVER"); //添加无视安全FileSystem fs = FileSystem.get(conf);byte[] buff = "Hello world".getBytes(); // 要写入的内容String filename = "file1.txt"; //要写入的文件名// FSDataOutputStream os = fs.create(new Path(filename)); //FS.create和open类似,返回一个输出流对象,创建一个文件,会覆盖原有文件FSDataOutputStream os = fs.append(new Path(filename)); //append方法和create不同,是在文件末尾添加新内容,而非覆盖os.write(buff,1,buff.length-1);System.out.println("Create:"+ filename);os.close();fs.close();} catch (Exception e) {e.printStackTrace();}}}