一、 LayerDiffusion 简介

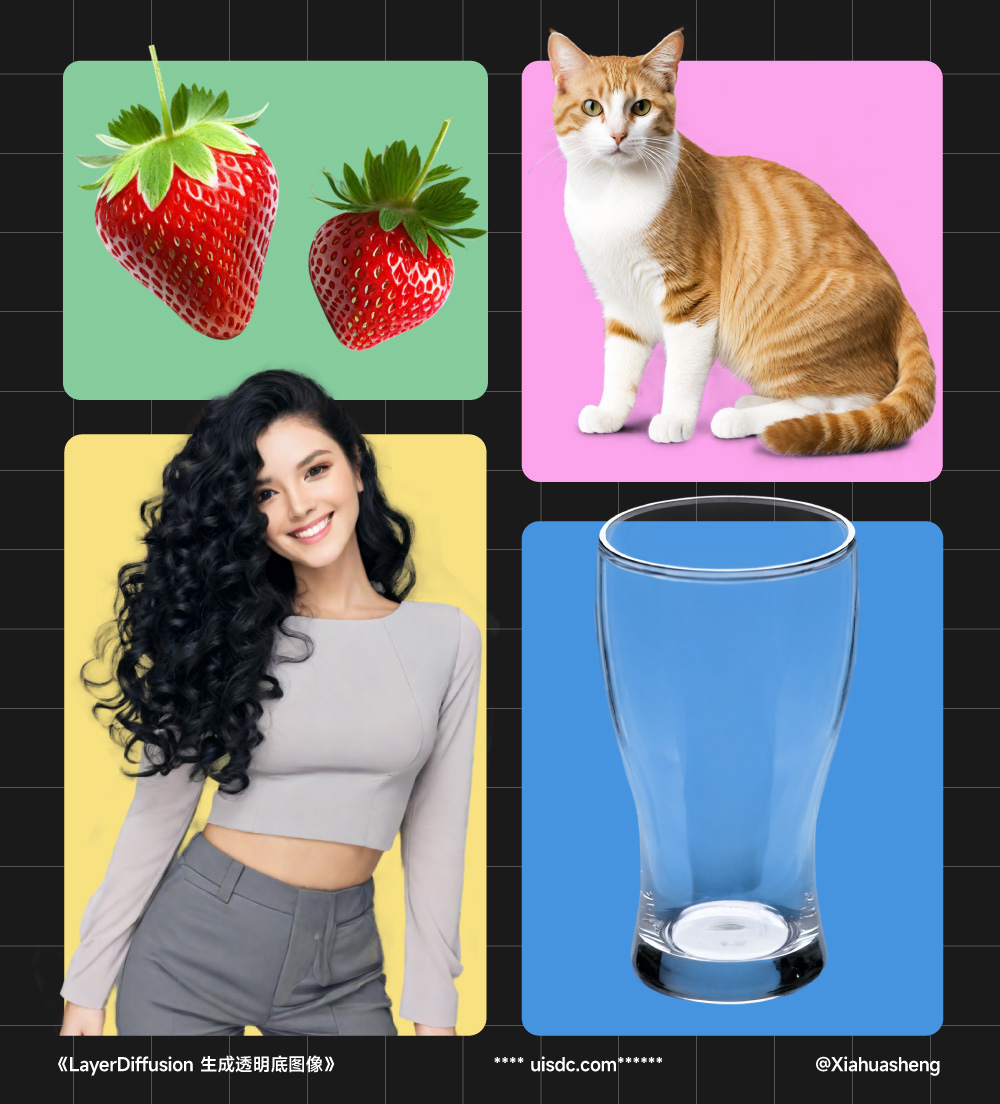

LayerDiffusion 是由 @ lllyasviel (没错就是那个开发出 Controlnet、Fooocus 和 SD WebUI Forge 的大神)最新推出的一种透明图像生成技术,它的核心所在是“潜在透明度”,即将 Alpha 通道整合到预训练模型的潜在结构中,使模型能够生成带有透明度的图。 官方给出的演示案例效果非常好,不仅可以生成一般物体,而且对于玻璃、发光这种透明/半透明的对象,以及头发丝这种精细的内容,生成的效果依旧完美。本文章封面图的卷发女生就是我直接用 LayerDiffusion 生成的,极大提升了出图效率,而且真正做到了“毫无抠图痕迹”,再也不用担心有白边了。

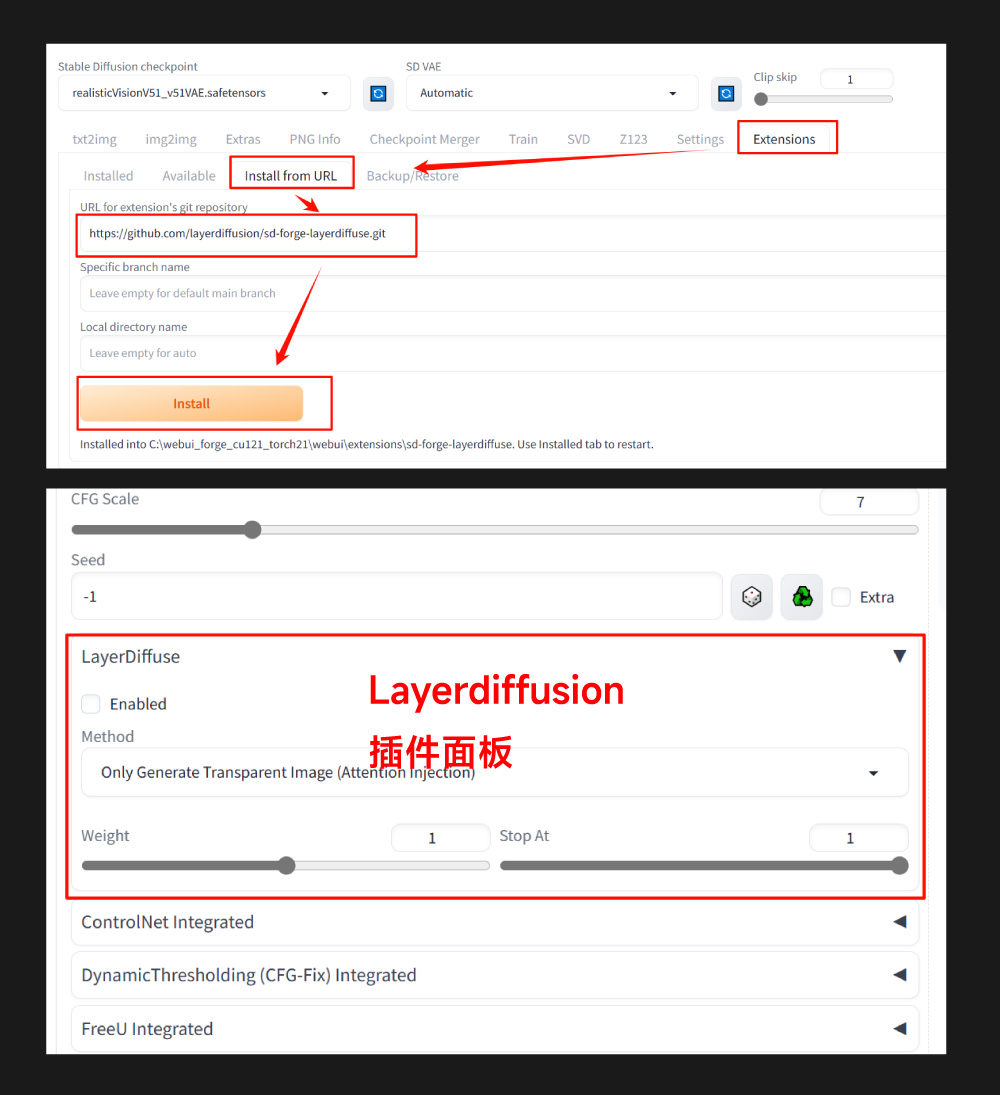

二、在 SD WebUI Forge 中使用 LayerDiffusion

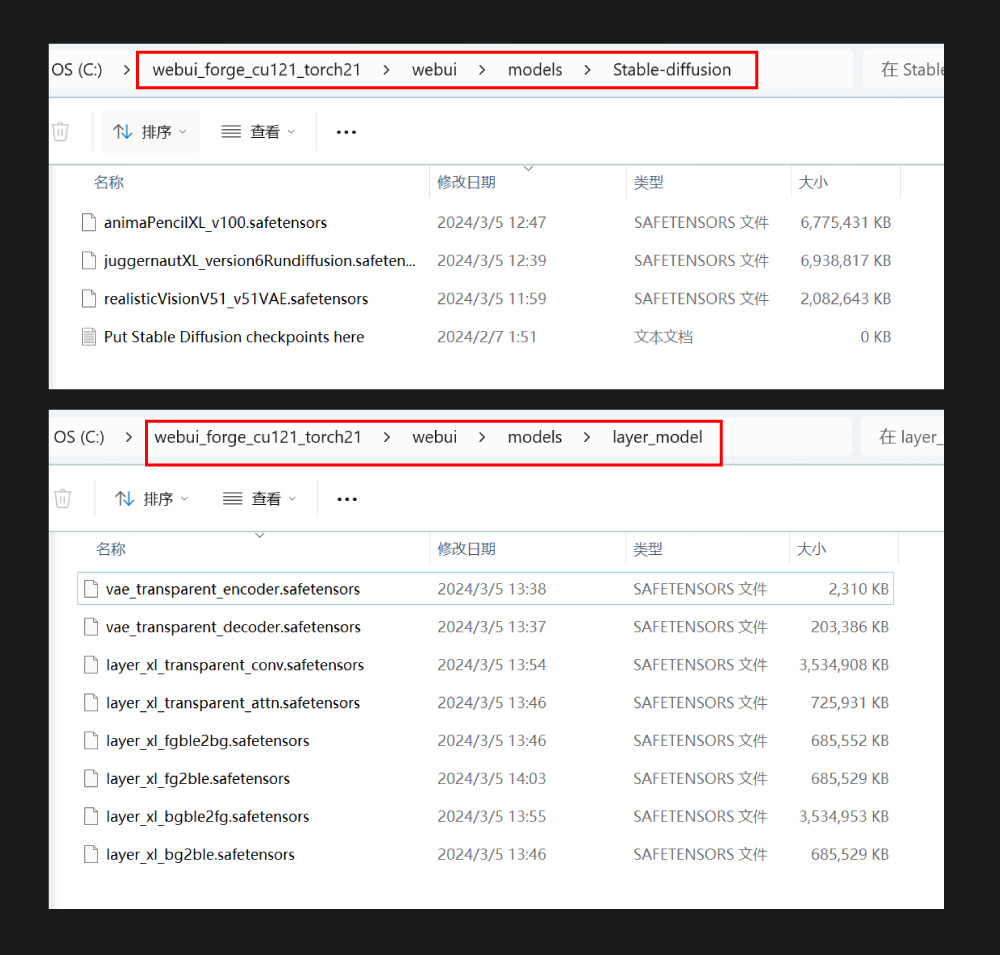

由于是同一个作者开发的,所以 SD WebUI Forge 最先实现了对 LayerDiffusion 的支持,界面操作非常方便,生成速度也很快。具体操作如下: ① 安装 SD WebUI Forge SD WebUI Forge 一键安装包: https://github.com/lllyasviel/stable-diffusion-webui-forge (附件有云盘资源,但但是软件后期会更新,还是建议去原网址下载) 先下载 WebUI Forge 官方一键安装包,解压后安装到本地;然后进入根目录,点击 update.bat 更新程序(必须点击),再点击 run.bat 启动 WebUI 界面。初次启动会下载很多配置文件,包括一个 1.99G 的 realisticVisionV51_v51VAE.safetensor 模型,所以时间会比较比较久,记得耐心等待,完成后会在浏览器中自动打开 UI 界面。

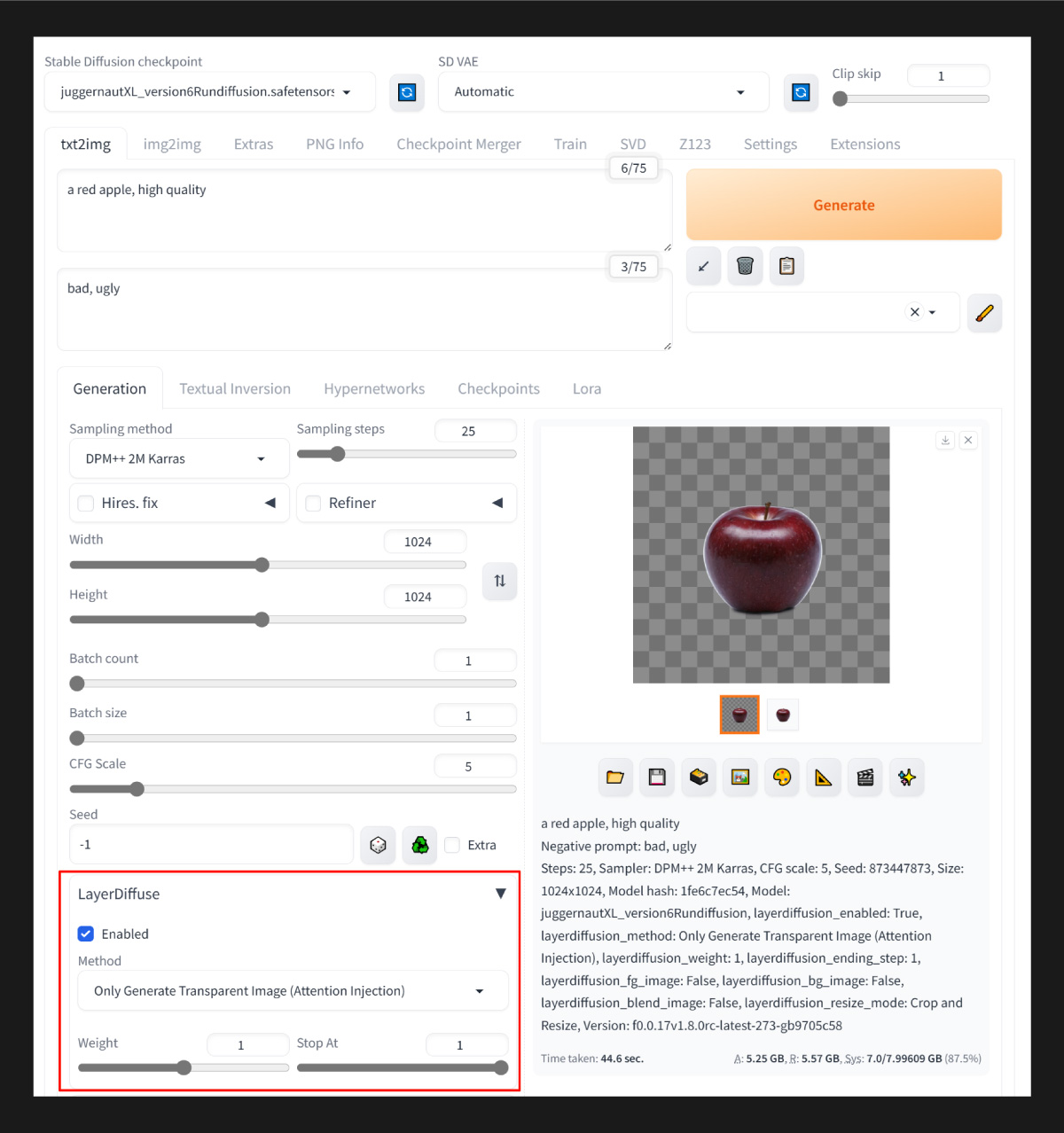

- 大模型:juggernautXL_version6Rundiffusion;VAE:automatic

- 正向提示词:a red apple, high quality;

- 反向提示词:bad, ugly;

- 生成参数:Steps: 25, Sampler: DPM++ 2M SDE Karras, CFG scale: 5, Size: 1024x1024,

- layerdiffusion 插件:layerdiffusion_method: Only Generate Transparent Image (Attention Injection), layerdiffusion_weight: 1, layerdiffusion_ending_step: 1

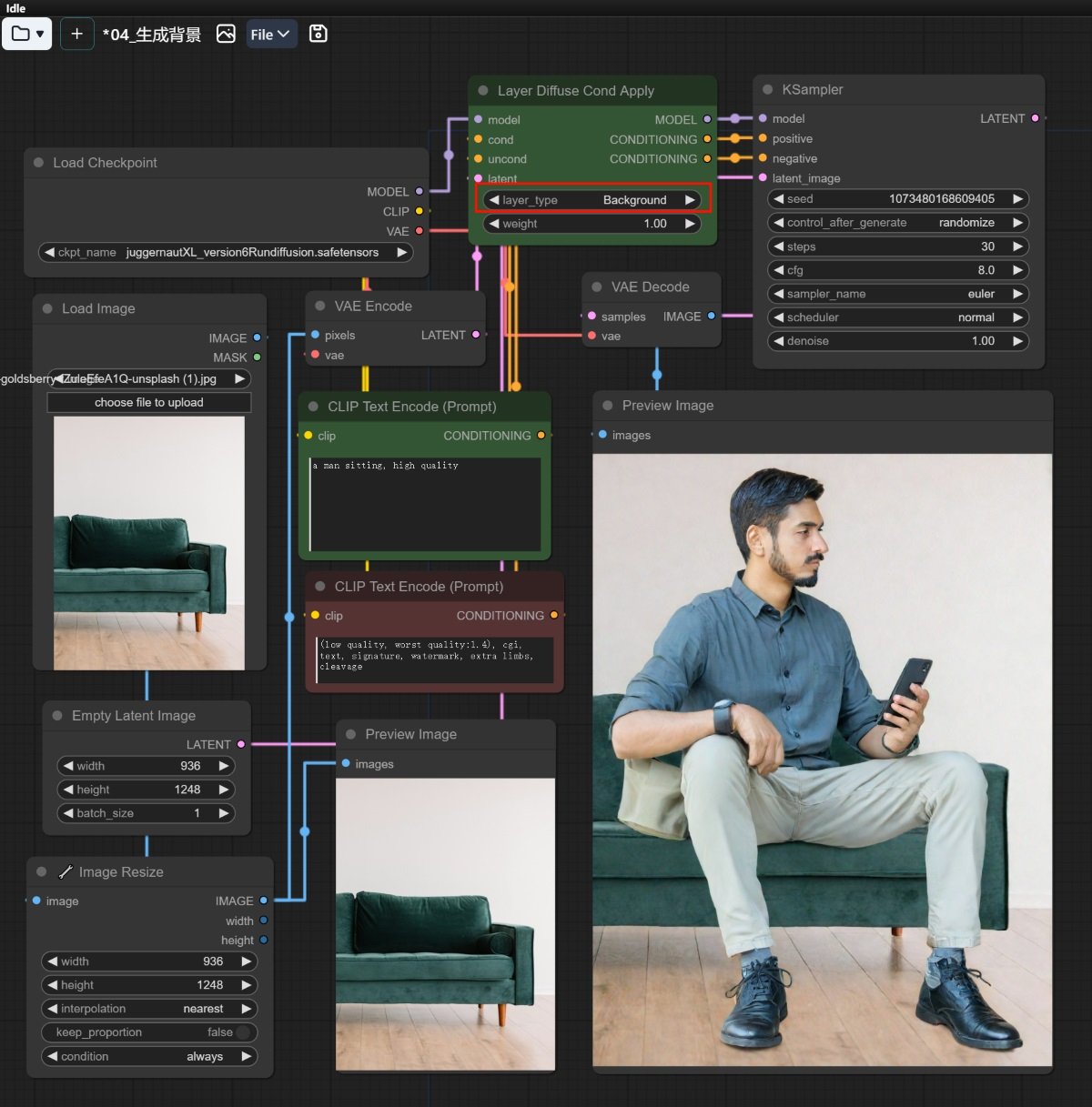

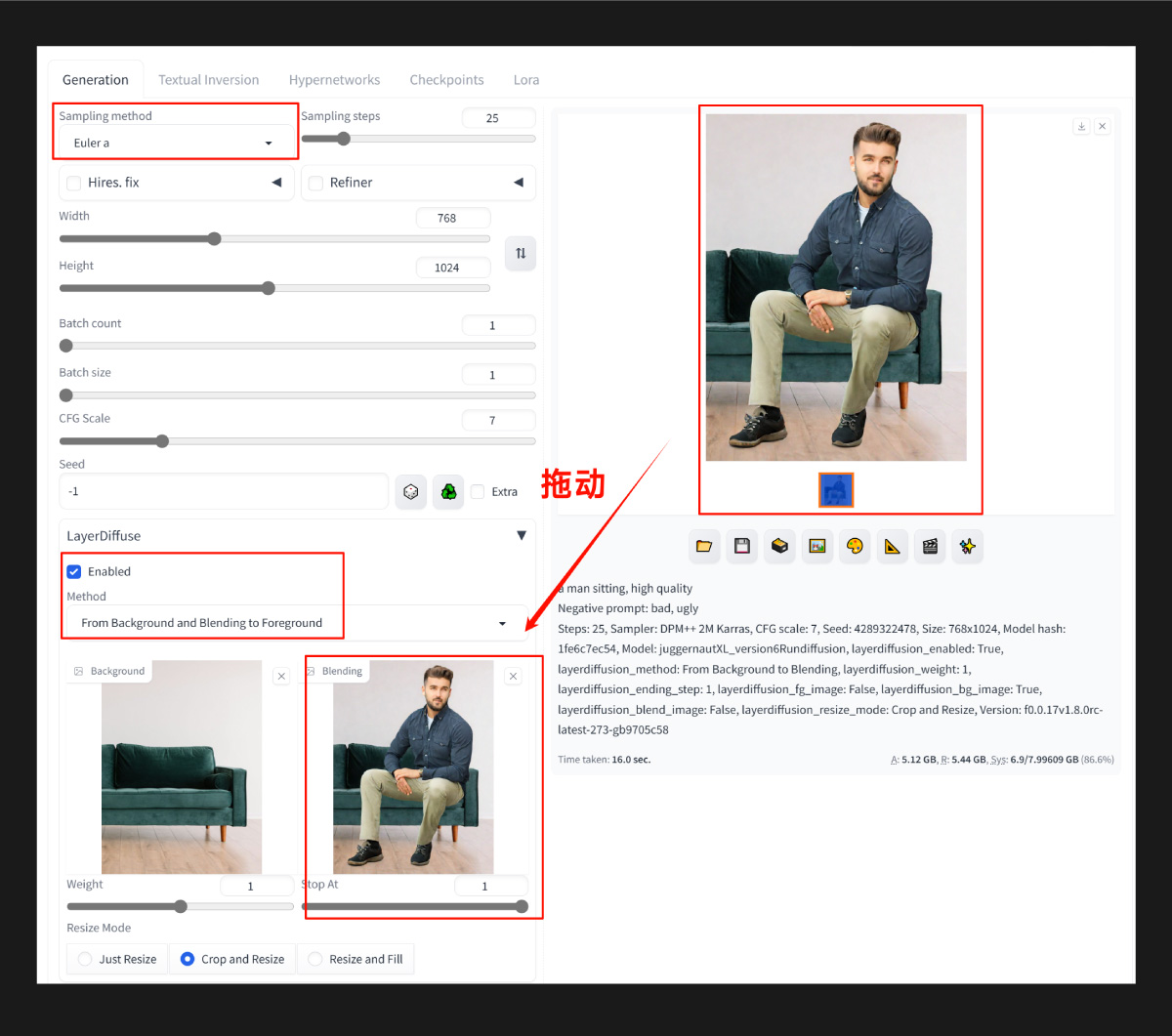

- 大模型:JuggernautXL_version6Rundiffusion;VAE:automatic;Clip Skip: 1

- 正向提示词:a man sitting, high quality;

- 反向提示词:bad, ugly;

- 生成参数:Steps: 25, Sampler: DPM++ 2M SDE Karras, CFG scale: 7, Size:768x1024,

- layerdiffusion 插件:layerdiffusion_method: From background to Blending, layerdiffusion_weight: 1, layerdiffusion_ending_step: 1, layerdiffusion_resize_mode: Crop and Resize

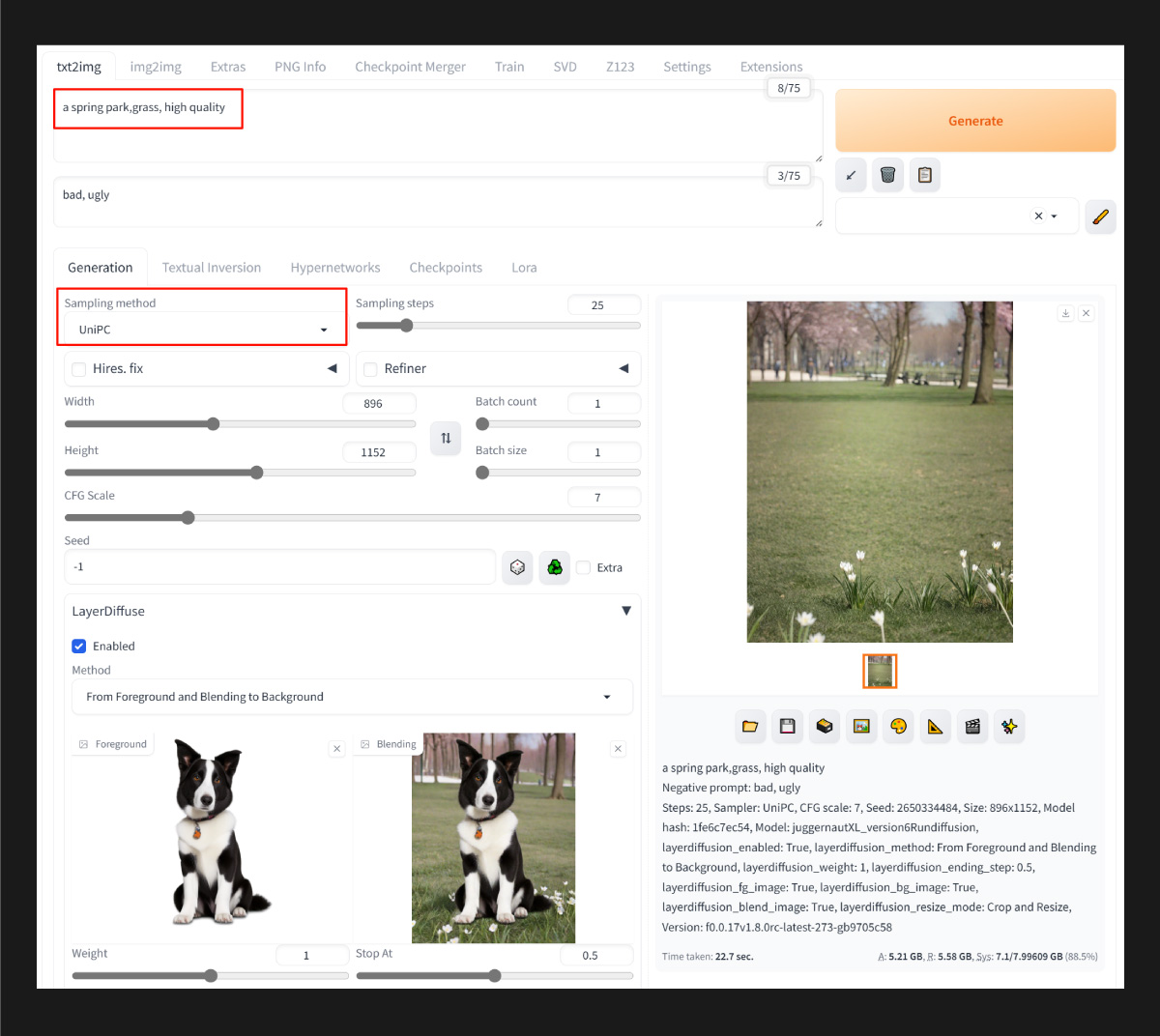

- 大模型:JuggernautXL_version6Rundiffusion;VAE:automatic;Clip Skip: 1

- 正向提示词:a dog sitting on the grass, in a spring park, high quality;

- 反向提示词:bad, ugly;

- 生成参数:Steps: 25, Sampler: DPM++ 2M SDE Karras, CFG scale: 7, Size:896*1152,

- layerdiffusion 插件:layerdiffusion_method: From Foreground to Blending, layerdiffusion_weight: 1, layerdiffusion_ending_step: 1, layerdiffusion_resize_mode: Crop and Resize

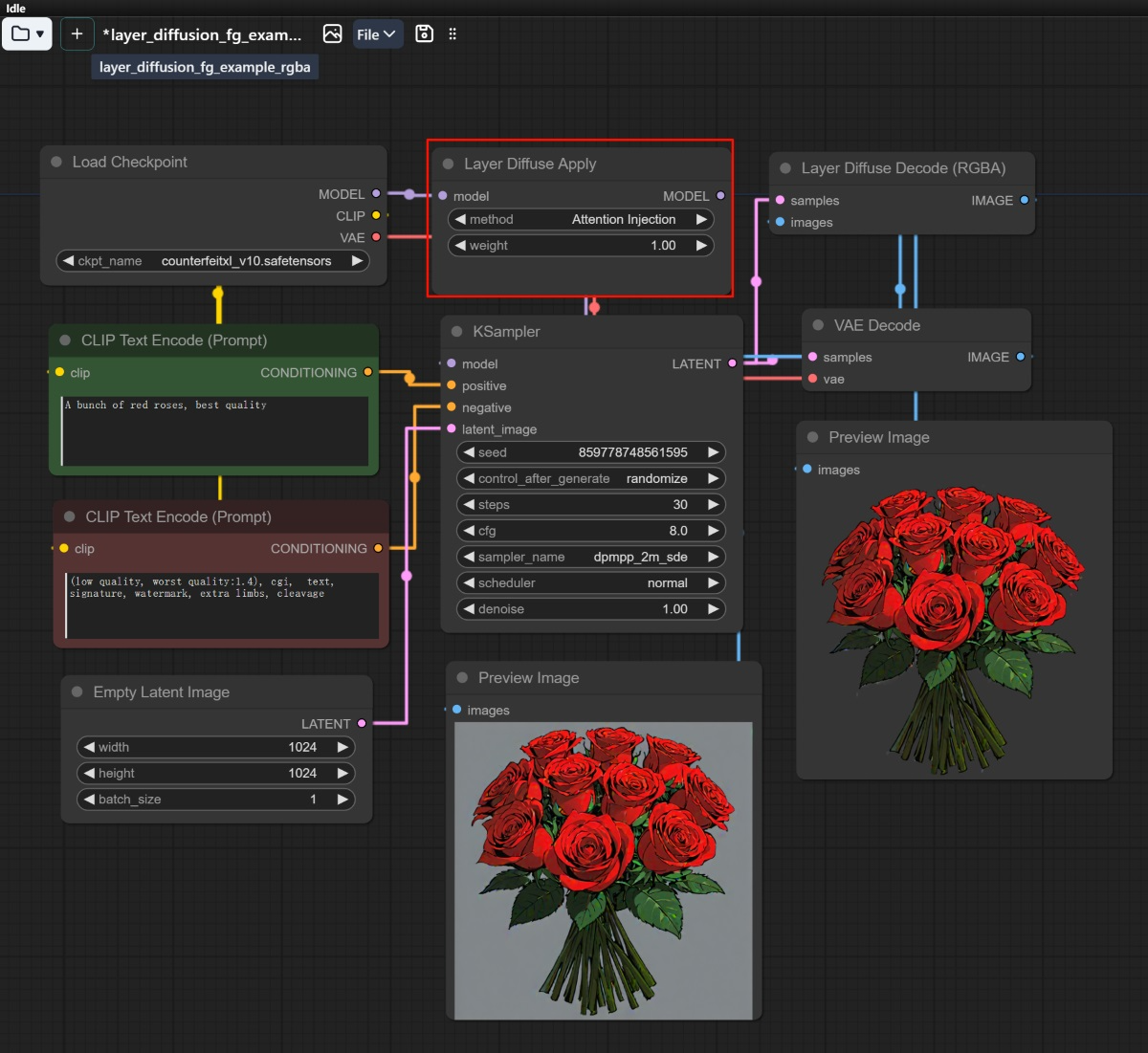

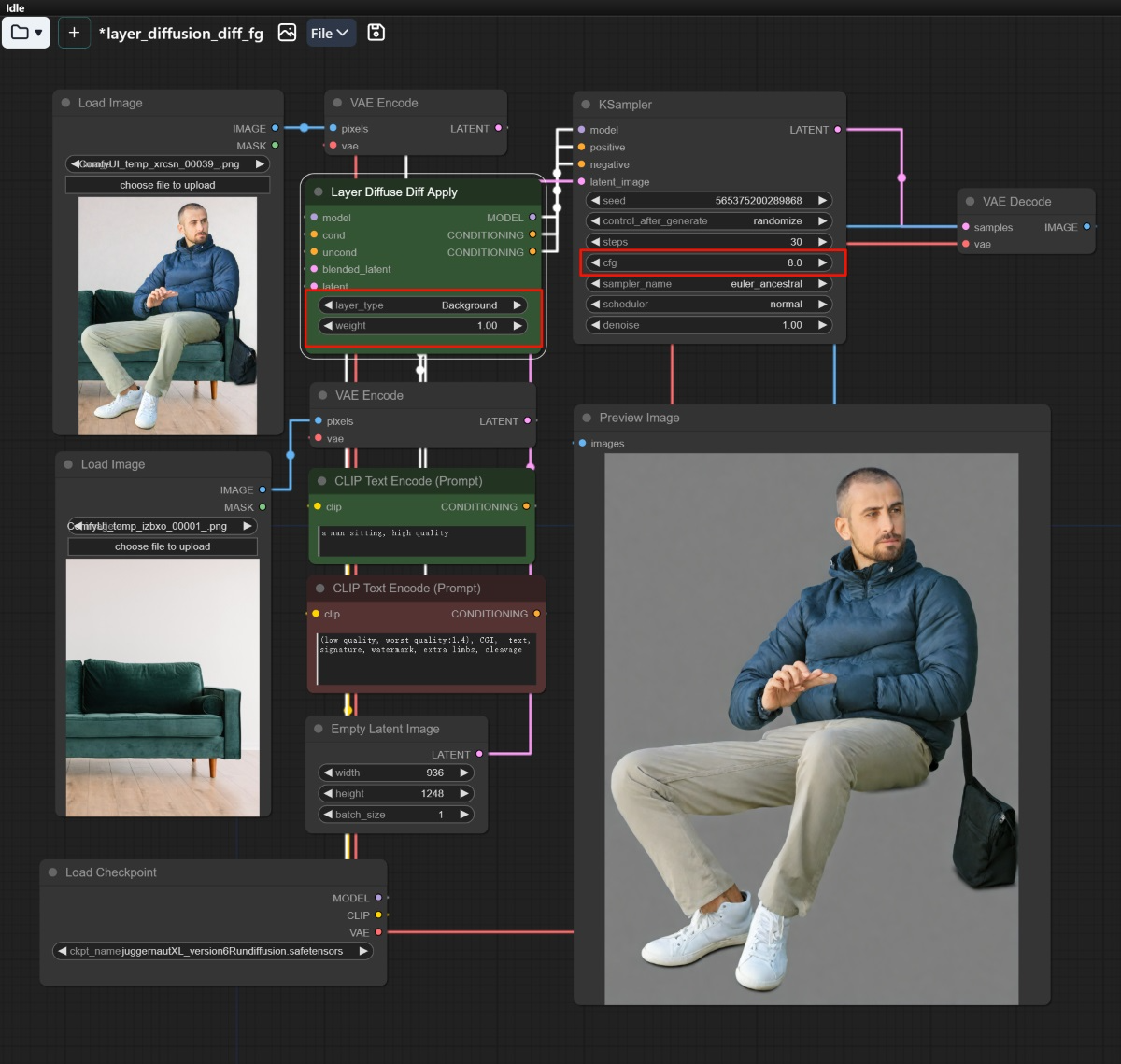

三、在 ComfyUI 中使用 LayerDiffusion

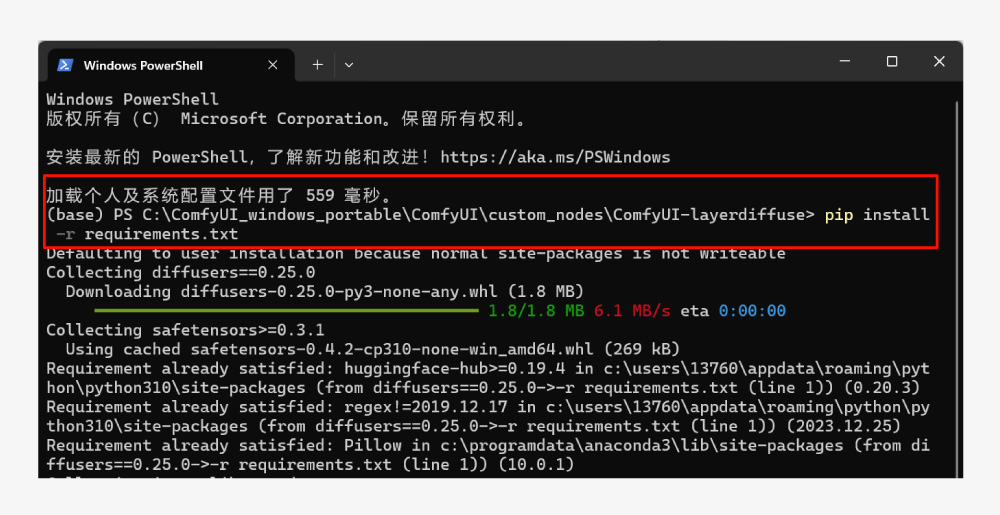

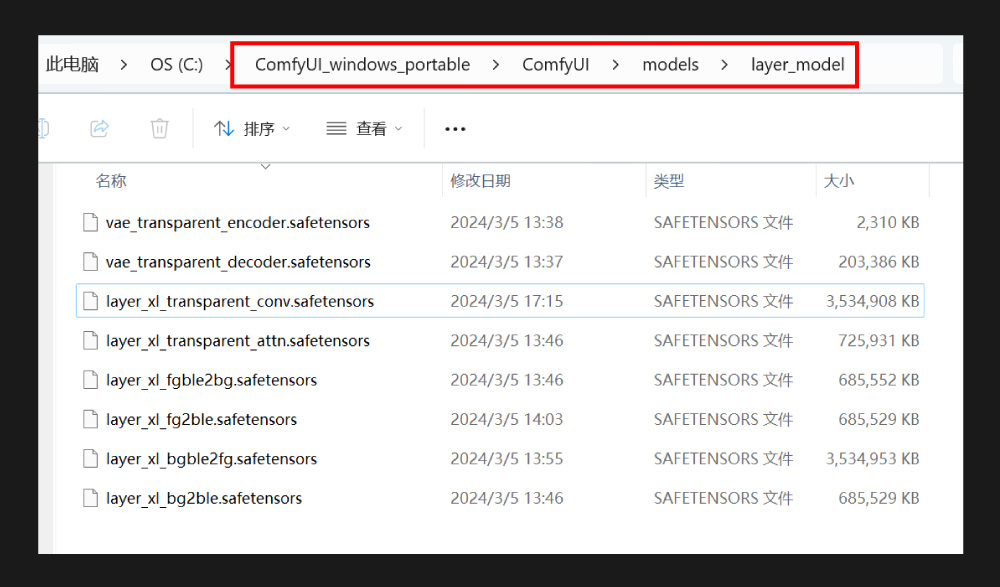

① 安装插件 ComfyUI-layerdiffuse 插件 git 网址: https://github.com/huchenlei/ComfyUI-layerdiffuse.git 首先将 ComfyUI 更新到最新版本。然后安装 layerdiffuse 插件,可以用过 manager 安装,也可以进入根目录的 custom_nodes 文件夹中,通过 git clone 命令安装;安装成功后,进入 ComfyUI-layerdiffuse 根目录,打开终端命令,运行 pip install -r requirements.txt 命令,安装 python 依赖项。