Netty模型

主从Reactor进阶

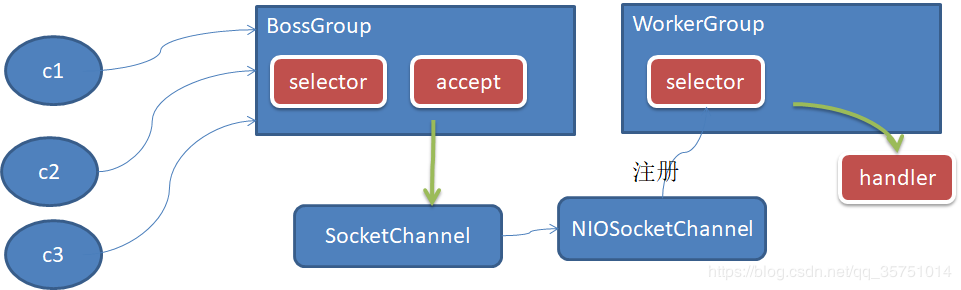

Netty主要是基于主从Reactor多线程模式做了一定的改进,其中主从Reactor都有单一的一个变成了多个。下面是简单的改进图。

如图所示

- 增加了BossGroup来维护多个主Reactor,主Reactor还是只关注连接的Accept;增加了WorkGroup来维护多个从Reactor,从Reactor将接收到的请求交给Handler进行处理。

- 在主Reactor中接收到Accept事件,获取到对应的SocketChannel,Netty会将它进一步封装成NIOSocketChannel对象,这个封装后的对象还包含了该Channel对应的SelectionKey、通信地址等详细信息。

- Netty会将装个封装后的Channel对象注册到WorkerGroup中的从Reactor中。

- 当WorkerGroup中的从Reactor监听到事件后,就会将之交给与此Reactor对应的Handler进行处理。

进阶版

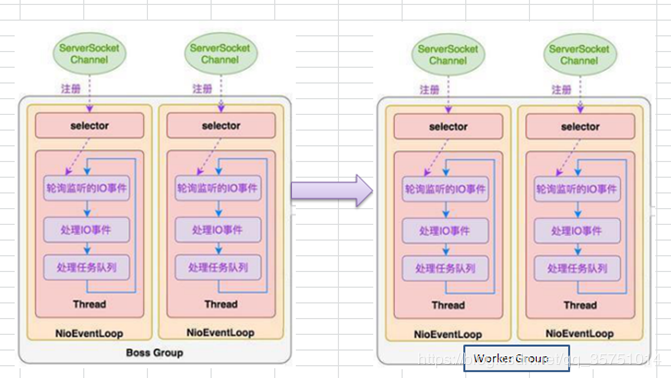

Netty将Selector以及Selector相关的事件及任务封装了NioEventLoop,这样BossGroup就可以通过管理NioEventLoop去管理各个Selector。

同时,Netty模型中主要存在两个大的线程池组BossGroup和WorkerGroup,用于管理主Reactor线程和从Reactor线程。

完整的Netty模型

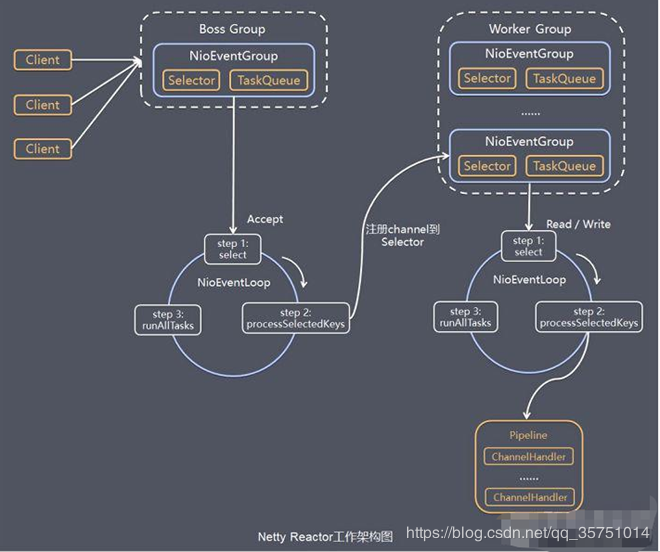

- Netty抽象出两组线程池,BossGroup专门负责接收客户端的连接,WorkerGroup专门负责网络的读写。

- BossGroup和WorkerGroup类型的本质都是NioEventLoopGroup类型。

- NioEventLoopGroup相当于一个线程管理器(类似于ExecutorServevice),它下面维护很多个NioEventLoop线程。(我认为图中的NioEventGroup的地方应该改成NioEventLoop,可能我的理解有点差错吧)。 在初始化这两个Group线程组时,默认会在每个Group中生成CPU*2个NioEventLoop线程,当n个连接来了,Group默认会按照连接请求的顺序分别将这些连接分给各个NioEventLoop去处理。同时Group还负责管理EventLoop的生命周期。

- NioEventLoop表示一个不断循环的执行处理任务的线程,它维护了一个线程和任务队列。每个NioEventLoop都包含一个Selector,用于监听绑定在它上面的socket通讯。每个NioEventLoop相当于Selector,负责处理多个Channel上的事件,每增加一个请求连接,NioEventLoopGroup就将这个请求依次分发给它下面的NioEventLoop处理。

- 每个Boss NioEventLoop循环执行的步骤有3步:

轮询accept事件。

处理accept事件,与client建立连接,生成NioSocketChannel,并将其注册到某个Worker NioEventLoop的selector上。

处理任务队列到任务,即runAllTasks。

- 每个Worker NioEventLoop循环执行的步骤:

轮询read,write事件

处理I/O事件,即read,write事件,在对应的NioSocketChannel中进行处理

处理任务队列的任务,即runAllTasks

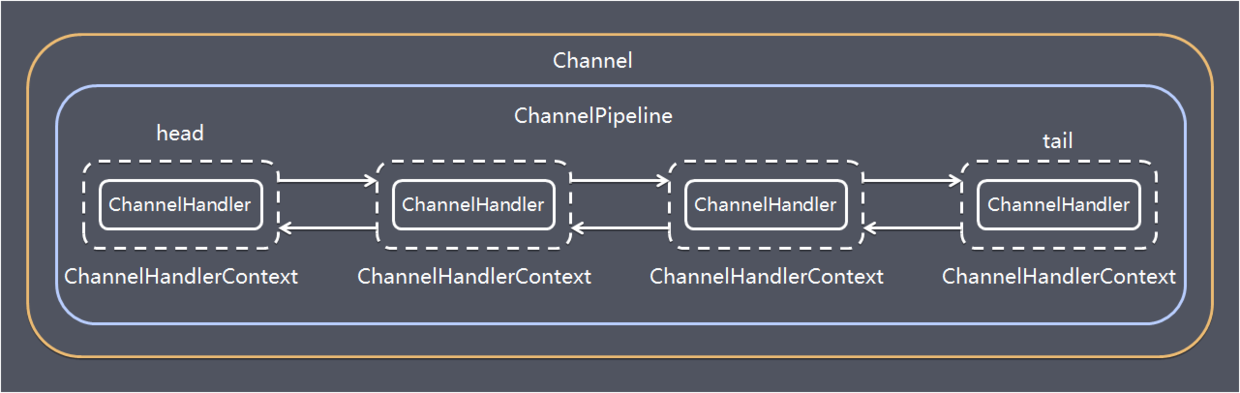

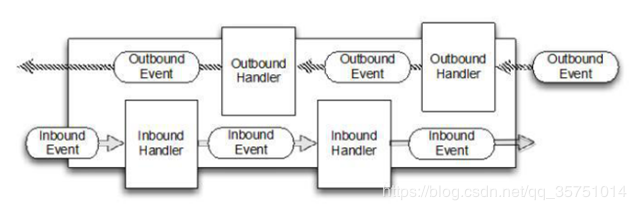

每个 Worker NioEventLoop处理业务时,会使用pipeline(管道),pipeline中维护了一个ChannelHandlerContext链表,而ChannelHandlerContext则保存了Channel相关的所有上下文信息,同时关联一个ChannelHandler对象。如图所示,Channel和pipeline一一对应,ChannelHandler和ChannelHandlerContext一一对应。

ChannelHandler是一个接口,负责处理或拦截I/O操作,并将其转发到Pipeline中的下一个处理Handler进行处理。

I/O Requestvia Channel orChannelHandlerContext|+---------------------------------------------------+---------------+| ChannelPipeline | || \|/ || +---------------------+ +-----------+----------+ || | Inbound Handler N | | Outbound Handler 1 | || +----------+----------+ +-----------+----------+ || /|\ | || | \|/ || +----------+----------+ +-----------+----------+ || | Inbound Handler N-1 | | Outbound Handler 2 | || +----------+----------+ +-----------+----------+ || /|\ . || . . || ChannelHandlerContext.fireIN_EVT() ChannelHandlerContext.OUT_EVT()|| [ method call] [method call] || . . || . \|/ || +----------+----------+ +-----------+----------+ || | Inbound Handler 2 | | Outbound Handler M-1 | || +----------+----------+ +-----------+----------+ || /|\ | || | \|/ || +----------+----------+ +-----------+----------+ || | Inbound Handler 1 | | Outbound Handler M | || +----------+----------+ +-----------+----------+ || /|\ | |+---------------+-----------------------------------+---------------+| \|/+---------------+-----------------------------------+---------------+| | | || [ Socket.read() ] [ Socket.write() ] || || Netty Internal I/O Threads (Transport Implementation) |+-------------------------------------------------------------------+

代码示例

服务端代码

public class NettyServer {public static void main(String[] args) throws InterruptedException {//创建BossGroup 和 WorkerGroup//1、创建两个线程组,bossGroup 和 workerGroup//2、bossGroup 只是处理连接请求,真正的和客户端业务处理,会交给 workerGroup 完成//3、两个都是无限循环//4、bossGroup 和 workerGroup 含有的子线程(NioEventLoop)个数为实际 cpu 核数 * 2EventLoopGroup bossGroup = new NioEventLoopGroup();EventLoopGroup worderGroup = new NioEventLoopGroup();try {//创建服务器端的启动对象,配置参数ServerBootstrap bootstrap = new ServerBootstrap();//使用链式编程来进行设置,配置bootstrap.group(bossGroup, worderGroup) //设置两个线程组.channel(NioServerSocketChannel.class) //使用 NioServerSocketChannel 作为服务器的通道实现.option(ChannelOption.SO_BACKLOG, 128) //设置线程队列得到连接个数.childOption(ChannelOption.SO_KEEPALIVE, true) //设置保持活动连接状态.childHandler(new ChannelInitializer<SocketChannel>() { //为accept channel的pipeline预添加的handler//给 pipeline 添加处理器,每当有连接accept时,就会运行到此处。@Overrideprotected void initChannel(SocketChannel socketChannel) throws Exception {socketChannel.pipeline().addLast(new NettyServerHandler());}}); //给我们的 workerGroup 的 EventLoop 对应的管道设置处理器System.out.println("........服务器 is ready...");//绑定一个端口并且同步,生成了一个ChannelFuture 对象//启动服务器(并绑定端口)ChannelFuture future = bootstrap.bind(6668).sync();//对关闭通道进行监听future.channel().closeFuture().sync();} finally {bossGroup.shutdownGracefully();worderGroup.shutdownGracefully();}}}

服务端Handler处理:

public class NettyServerHandler extends ChannelInboundHandlerAdapter {/***读取客户端发送过来的消息* @param ctx 上下文对象,含有 管道pipeline,通道channel,地址* @param msg 就是客户端发送的数据,默认Object* @throws Exception*/@Overridepublic void channelRead(ChannelHandlerContext ctx, Object msg) throws Exception {System.out.println("服务器读取线程:" + Thread.currentThread().getName());System.out.println("server ctx = " + ctx);//看看Channel和Pipeline的关系Channel channel = ctx.channel();ChannelPipeline pipeline = ctx.pipeline(); //本质是个双向链表,出栈入栈//将msg转成一个ByteBuf,比NIO的ByteBuffer性能更高ByteBuf buf = (ByteBuf)msg;System.out.println("客户端发送的消息是:" + buf.toString(CharsetUtil.UTF_8));System.out.println("客户端地址:" + ctx.channel().remoteAddress());}//数据读取完毕@Overridepublic void channelReadComplete(ChannelHandlerContext ctx) throws Exception {//它是 write + flush,将数据写入到缓存buffer,并将buffer中的数据flush进通道//一般讲,我们对这个发送的数据进行编码ctx.writeAndFlush(Unpooled.copiedBuffer("hello, 客户端~", CharsetUtil.UTF_8));}//处理异常,一般是关闭通道@Overridepublic void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) throws Exception {ctx.close();}}

客户端代码

public class NettyClient {public static void main(String[] args) throws InterruptedException {//客户端需要一个事件循环组EventLoopGroup group = new NioEventLoopGroup();try {//创建客户端启动对象//注意:客户端使用的不是 ServerBootStrap 而是 BootstrapBootstrap bootstrap = new Bootstrap();//设置相关参数bootstrap.group(group) //设置线程组.channel(NioSocketChannel.class) //设置客户端通道的实现类(使用反射).handler(new ChannelInitializer<SocketChannel>() {@Overrideprotected void initChannel(SocketChannel socketChannel) throws Exception {socketChannel.pipeline().addLast(new NettyClientHandler()); //加入自己的处理器}});System.out.println("客户端 OK...");//启动客户端去连接服务器端//关于 channelFuture 涉及到 netty 的异步模型ChannelFuture channelFuture = bootstrap.connect("127.0.0.1", 6668).sync();//给关闭通道进行监听channelFuture.channel().closeFuture().sync();} finally {group.shutdownGracefully();}}}

客户端Handler处理:

public class NettyClientHandler extends ChannelInboundHandlerAdapter {/*** 当通道就绪就会触发* @param ctx* @throws Exception*/@Overridepublic void channelActive(ChannelHandlerContext ctx) throws Exception {System.out.println("client: " + ctx);ctx.writeAndFlush(Unpooled.copiedBuffer("hello, server", CharsetUtil.UTF_8));}/*** 当通道有读取事件时,会触发* @param ctx* @param msg* @throws Exception*/@Overridepublic void channelRead(ChannelHandlerContext ctx, Object msg) throws Exception {ByteBuf buf = (ByteBuf)msg;System.out.println("服务器回复的消息:" + buf.toString(CharsetUtil.UTF_8));System.out.println("服务器的地址:" + ctx.channel().remoteAddress());}@Overridepublic void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) throws Exception {cause.printStackTrace();ctx.close();}}

任务队列

任务队列由NioEventLoop维护并不断执行。当我们就收到请求之后,在当前channel对应的pipeline中的各个Handler里面进行业务处理和请求过滤。当某些业务需要耗费大量时间的时候,我们可以将任务提交到由NioEventLoop维护的taskQueue或scheduleTaskQueue中,让当前的NioEventLoop线程在空闲时间去执行这些任务。下面将介绍提交任务的3种方式

用户程序自定义的普通任务:

该方式会将任务提交到taskQueue队列中。提交到该队列中的任务会按照提交顺序依次执行。

channelHandlerContext.channel().eventLoop().execute(new Runnable(){@Overridepublic void run() {//...}});

用户自定义的定时任务:

该方式会将任务提交到scheduleTaskQueue定时任务队列中。该队列是底层是优先队列PriorityQueue实现的,固该队列中的任务会按照时间的先后顺序定时执行。

channelHandlerContext.channel().eventLoop().schedule(new Runnable() {@Overridepublic void run() {}}, 60, TimeUnit.SECONDS);

为其他EventLoop线程对应的Channel添加任务

可以在ChannelInitializer中,将刚创建的各个Channel以及对应的标识加入到统一的集合中去,然后可以根据标识获取Channel以及其对应的NioEventLoop,然后就课程调用execute()或者schedule()方法。

异步模型

基本介绍

- 异步的概念和同步相对。当一个异步过程调用发出后,调用者不能立刻得到结果。实际处理这个调用的组件在完成后,通过状态、通知和回调来通知调用者。

- Netty 中的 I/O 操作是异步的,包括 Bind、Write、Connect 等操作会简单的返回一个 ChannelFuture。

- 调用者并不能立刻获得结果,而是通过 Future-Listener 机制,用户可以方便的主动获取或者通过通知机制获得 IO 操作结果。

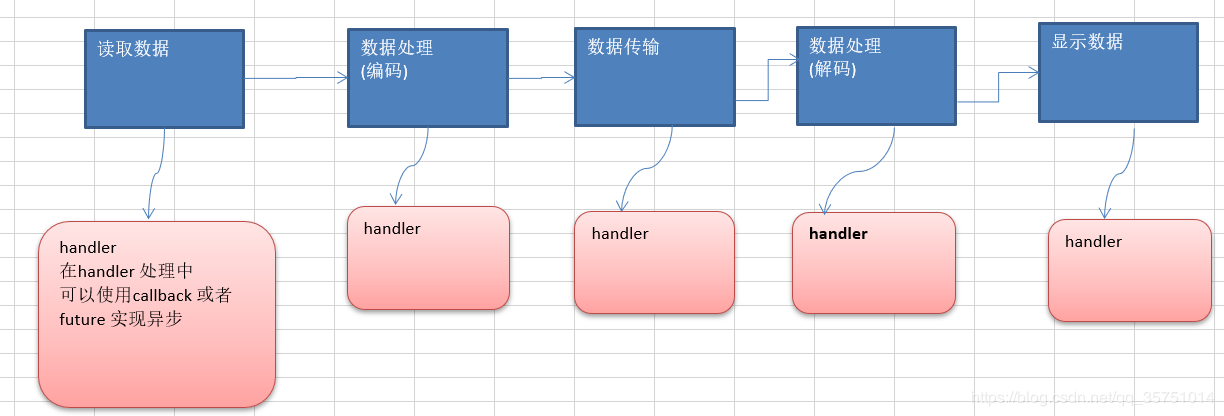

- Netty 的异步模型是建立在 future 和 callback 的之上的。callback 就是回调。重点说 Future,它的核心思想是:假设一个方法 fun,计算过程可能非常耗时,等待 fun返回显然不合适。那么可以在调用 fun 的时候,立马返回一个 Future,后续可以通过 Future去监控方法 fun 的处理过程(即 : Future-Listener 机制)。

Future说明

表示异步的执行结果, 可以通过它提供的方法来检测执行是否完成,比如检索计算等等.

ChannelFuture 是一个接口 : public interface ChannelFuture extends Future

工作原理示意图

在使用 Netty 进行编程时,拦截操作和转换出入站数据只需要您提供 callback 或利用future 即可。这使得链式操作简单、高效, 并有利于编写可重用的、通用的代码。

Netty 框架的目标就是让你的业务逻辑从网络基础应用编码中分离出来、解脱出来

Future-Listener机制

当 Future 对象刚刚创建时,处于非完成状态,调用者可以通过返回的 ChannelFuture 来获取操作执行的状态,注册监听函数来执行完成后的操作。

常用方法如下:

方法名称 方法作用

- isDone() 判断当前操作是否完成

- isSuccess() 判断已完成的当前操作是否成功

- getCause() 获取已完成当前操作失败的原因

- isCancelled() 判断已完成的当前操作是否被取消

- addListener() 注册监听器,当前操作(Future)已完成,将会通知指定的监听器

举例说明

绑定端口操作时异步操作,当绑定操作处理完,将会调用相应的监听器处理逻辑。

serverBootstrap.bind(port).addListener(future -> {if(future.isSuccess()) {System.out.println(newDate() + ": 端口["+ port + "]绑定成功!");} else{System.err.println("端口["+ port + "]绑定失败!");}});

HTTP 服务实例

快速入门实例-HTTP HelloWorld

浏览器访问Netty服务器后,返回HelloWorld

启动

public static void main(String[] args) throws InterruptedException {NioEventLoopGroup bossGroup = new NioEventLoopGroup(1);NioEventLoopGroup workerGroup = new NioEventLoopGroup();try {ServerBootstrap bootstrap = new ServerBootstrap();bootstrap.group(bossGroup, workerGroup).channel(NioServerSocketChannel.class).childHandler(new TestServerInitializer());ChannelFuture channelFuture = bootstrap.bind(8080).sync();channelFuture.channel().closeFuture().sync();} finally {bossGroup.shutdownGracefully();workerGroup.shutdownGracefully();}}

定义ChannelInitializer

用于给Channel对应的pipeline添加handler。该ChannelInitializer中的代码在SocketChannel被创建时都会执行

public class TestServerInitializer extends ChannelInitializer<SocketChannel> {@Overrideprotected void initChannel(SocketChannel socketChannel) throws Exception {//向管道加入处理器//得到管道ChannelPipeline pipeline = socketChannel.pipeline();//加入一个 netty 提供的 httpServerCodec:codec => [coder - decoder]//1、HttpServerCodec 是 netty 提供的处理http的编解码器pipeline.addLast("MyHttpServerCodec", new HttpServerCodec());//2、增加自定义的Handlerpipeline.addLast("MyTestHttpServerHandler", new TestHttpServerHandler());}}

自定义Handler

public class TestHttpServerHandler extends SimpleChannelInboundHandler<HttpObject> {/*** 读取客户端数据。** @param channelHandlerContext* @param httpObject 客户端和服务器端互相通讯的数据被封装成 HttpObject* @throws Exception*/@Overrideprotected void channelRead0(ChannelHandlerContext channelHandlerContext, HttpObject httpObject) throws Exception {//判断 msg 是不是 HTTPRequest 请求if (httpObject instanceof HttpRequest) {System.out.println("msg 类型 = " + httpObject.getClass());System.out.println("客户端地址:" + channelHandlerContext.channel().remoteAddress());//获取HttpRequest request = (HttpRequest) httpObject;//获取uri,进行路径过滤URI uri = new URI(request.uri());if ("/favicon.ico".equals(uri.getPath())) {System.out.println("请求了 favicon.ico,不做响应");}//回复信息给浏览器[http协议]ByteBuf content = Unpooled.copiedBuffer("HelloWorld", CharsetUtil.UTF_8);//构造一个http的响应,即HTTPResponseDefaultFullHttpResponse response = new DefaultFullHttpResponse(HttpVersion.HTTP_1_1, HttpResponseStatus.OK, content);response.headers().set(HttpHeaderNames.CONTENT_TYPE, "text/plain");response.headers().set(HttpHeaderNames.CONTENT_LENGTH, content.readableBytes());//将构建好的 response 返回channelHandlerContext.writeAndFlush(response);}}}