数据质量分析

数据质量分析是数据预处理的前提,是数据挖掘分析结论有效性和准确性的基础,其主要任务是检查原始数据中是否存在脏数据。

脏数据一般是指不符合要求,以及不能直接进行相应分析的数据。

在常见的数据挖掘工作中,脏数据包括:

- 缺失值

- 异常值

- 不一致的值

-

缺失值

数据的缺失主要包括记录的缺失和记录中某个字段信息的缺失,两者都会造成分析结果不准确,缺失值产生的原因:

有些信息暂时无法获取,或者获取信息的代价太大

- 有些信息是被遗漏的

-

异常值

异常值是指样本中的个别值,其数值明显偏离其余的观测值。

- 异常值分析是检验数据是否有录入错误,是否含有不合常理的数据。

- 异常值也称为离群点,异常值的分析也称为离群点的分析。

异常值分析方法主要有:简单统计量分析、3σ原则、箱型图分析、基于聚类的离群点检测。

不一致的值

数据不一致是指数据的矛盾性、不相容性。直接对不一致的数据进行挖掘,可能会产生与实际相违背的挖掘结果。

在数据挖掘过程中,不一致数据的产生主要发生在数据集成的过程中,可能是由于被挖掘数据是来自于不同的数据源、重复存放的数据未能进行一致性地更新造成的。

数据特征分析

一般通过绘制图表、计算某些特征量等手段进行数据的特征分析。

特征分析的方法有:分布分析

- 对比分析

- 统计量分析

- 周期性分析

- 贡献度分析

-

分布分析

分布分析能揭示数据的分布特征和分布类型

- 对于定量数据,欲了解其分布形式是对称的还是非对称的,通常可做频率分布直方图进行直观分析。

-

分布分析——定量数据

频率分布直方图一般按照以下步骤:

求极差

- 决定组距与组数

- 决定分点

- 列出频率分布表

- 绘制频率分布直方图

遵循的主要原则有:

- 各组之间必须是相互排斥的

- 各组必须将所有的数据包含在内

-

分布分析——定性数据

对于定性变量,常常根据变量的分类类型来分组,可以采用饼图和条形图来描述定性变量的分布。

对比分析

对比分析是指把两个相互联系的指标数据进行比较,从数量上展示和说明研究对象规模的大小、水平的高低、速度的快慢,以及各种关系是否协调。

对比分析主要有以下两种形式: 绝对数比较

-

对比分析——相对数比较

由于研究目的和对比基础不同,相对数可以分为以下几种:

结构相对数

- 比例相对数

- 比较相对数

- 强度相对数

- 计划完成程度相对数

-

统计量分析

用统计指标对定量数据进行统计描述,常从集中趋势和离中趋势两个方面进行分析。

描述集中趋势的度量指标主要有:均值、中位数

描述离中趋势的度量指标主要有:极差、标准差、变异系数、四分位间距

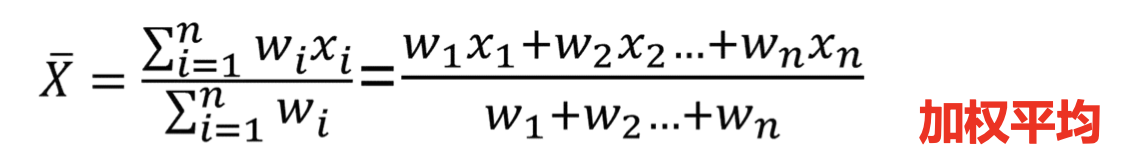

均值(加权值总和/权值总和)

意义

平均数是反映数据集中趋势最常用的统计量,它能充分利用数据所提供的信息。

不足

受极端值的影响比较大。中位数

意义

中位数是一个位置代表值,表明 一组数据中有一半的数据大于(或 小于)中位数,计算简便,不受极端值的影响。

不足

不能充分利用所有数据信息。极差

设x1,…xn是某个数值属性X的n个观测值,极差是最大值与最小值之差。

意义

反映一组数据的波动范围,计算简单。

不足

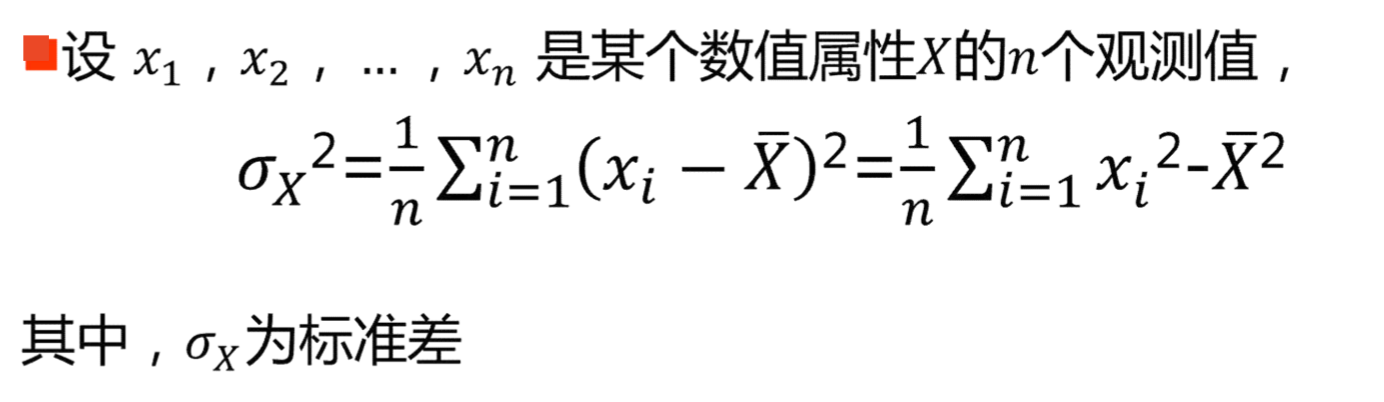

不能充分利用所有数据信息方差

低方差意味着数据集中分布在均值附近,高方差表示数据散布在一个大的值域中。

意义

反映一组数据的波动大小,方差越大,数据的波动就越大,方差越小波动越小。

不足

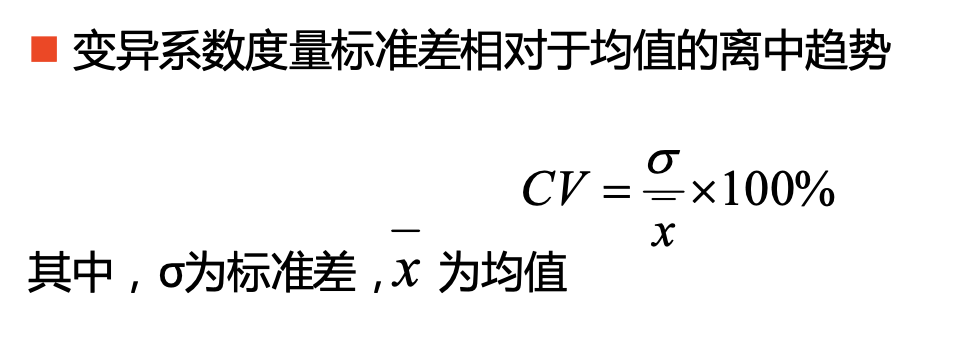

计算繁琐,单位与原单位不一致。变异系数

四分位数间距

由三个点Q1,Q2,Q3样本观察值划分为四段,Q3-Q1=IQR 即四分位数间距。

周期性分析

周期性分析是探索某个变量是否随着时间变化而呈现出某种周期变化趋势。

-

贡献度分析(帕累托分析,20/80定律)

对一个公司来说,80%的利润常来自于20%最畅销的产品;而其他80%的产品只产生了20%的利润。

相关性分析相关性分析

分析连续变量之间线性的相关程度的强弱,并用适当的统计指标表示出来的过程称为相关分析。

相关性分析方法主要有: 直接绘制散点图

- 绘制散点图矩阵

- 计算相关系数

Pearson相关系数,一般用于分析两个连续性变量之间的关系。

数据预处理

目的

- 提高数据的质量

-

主要任务

数据取样

- 数据清洗

- 数据集成

- 数据变换

-

数据取样

抽样数据的标准:一是相关性,二是可靠 性,三是有效性。

- 抽样:主要依赖随机化技术,从数据中随机选出一部分样本。

过滤:依据限制条件,仅选择符合要求的数据参与下一步骤的计算。

数据过滤

在大数据处理过程中,数据过滤可以采用数据库的基本操作 来实现,将过滤条件转换为选择操作来实现。

数据抽样

随机抽样,常用于总体个数较少时,从总体中逐个抽取。(抽签法、随机数法、水库抽样)

水库抽样:前k个数据直接保存在数组A中,第K+1个数据被选中替换的概率是k/(k+1)(因k+1>k时不发生替换),水库中原有数据被替换的概率(k/k+1)*(1/k)=1/(k+1);未被替换的概率是1-1/(k+1)=k/(k+1)

系统抽样

将总体分成均衡的几个部分,然后按照预先定出的规则,从 每一部分抽取一个个体,得到所需要的样本。

步骤:先对总体的N个个体编号,确定分段间隔k(将多余的样本用抽签或者随机方式剔除),对编号进行分段,在第一段用简单随机抽样确定第一个个体编号l(l<=k),按照一定的规则抽取样本。通常是将l加上间隔k得到第二个个体编号(l+k),再加上k得到第3个个体编号(l+2k),依次进行下去。。。

分层抽样

按一定比例,从每层抽一定数量的个体,每个个体被抽到的概率为N/M (M为总数,N为样本数)

加权抽样

对总体的各个样本设置不同的数量系数,使样本呈现出相对重要性程度

整体抽样

将总体中的个体归并为群,再以群为抽样单位进行抽样(直接抽群)

数据清洗

数据清洗主要是删除原始数据集中的无关数据,重复数据,平滑噪声数据,处理缺失值,异常值等。

缺失值的分析

对缺失值做简单统计分析

- 统计含有缺失值的属性个数

-

缺失值处理

删除记录

- 数据插补:拉格朗日插值法

-

异常值分析

简单统计量分析:常识分析

- 3σ原则:基于正态分布,距离平均值3σ之外的值为小概率事件

- 箱型图分析(最大值,Q3,Q2(中位数),Q1,最小值),IQR=Q3-Q1,若数据小于Q1-1.5IQR或大于Q3+1.5IQR,则认为是异常值

-

异常值处理

删除

- 视为缺失值

- 平均值修正

-

数据集成

实体识别

实体识别的任务是检测和解决同名异义,异名同义、单位不统一的冲突

冗余属性识别

同一属性多次出现

-

数据变换

数据变换主要是对数据进行规范化的操作,将数据转换成“适当的”格式,以适用于挖掘任务及算法的需要。

简单函数变换

- 规范化(归一化)

- 连续属性离散化

-

数据归约

数据归约是将海量数据进行归约,归约后的数据仍接近于保持原数据的完整性,但数据量小很多。

数据归约的意义: 降低无效、错误数据对建模的影响,提高建模的准确性

- 少量且具代表性的数据将大幅缩减数据挖掘所需的时间

- 降低储存数据的成本

属性归约

常用方法:合并属性、逐步向前选择、逐步向后删除、决策树归纳、主成分分析

(将多个类混合的属性,分为一个类)