- 确保你的back propagation是正确的

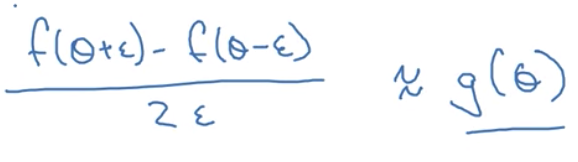

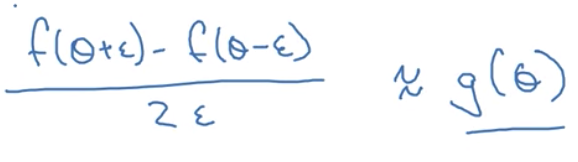

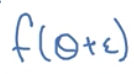

这个更准确,相对于只取

这个更准确,相对于只取 一边来说,即下图

一边来说,即下图

用这种gradient check可以检查g(theta)是否正确,

什么是g(theta)?g(theta)就是cost function f的slope

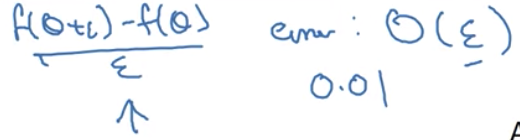

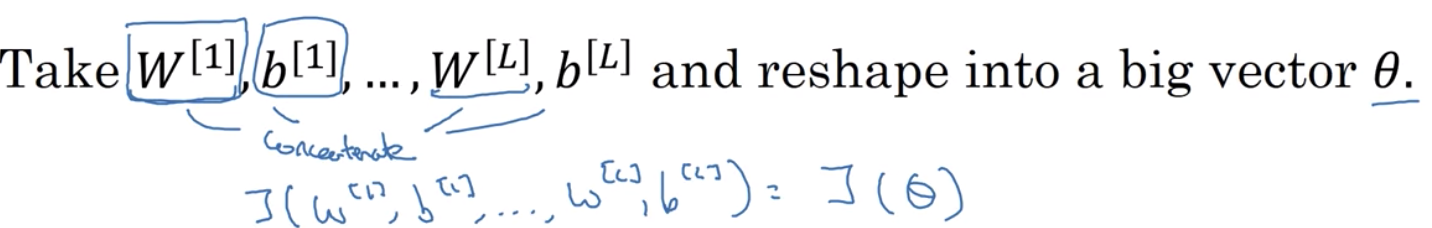

什么是theta?

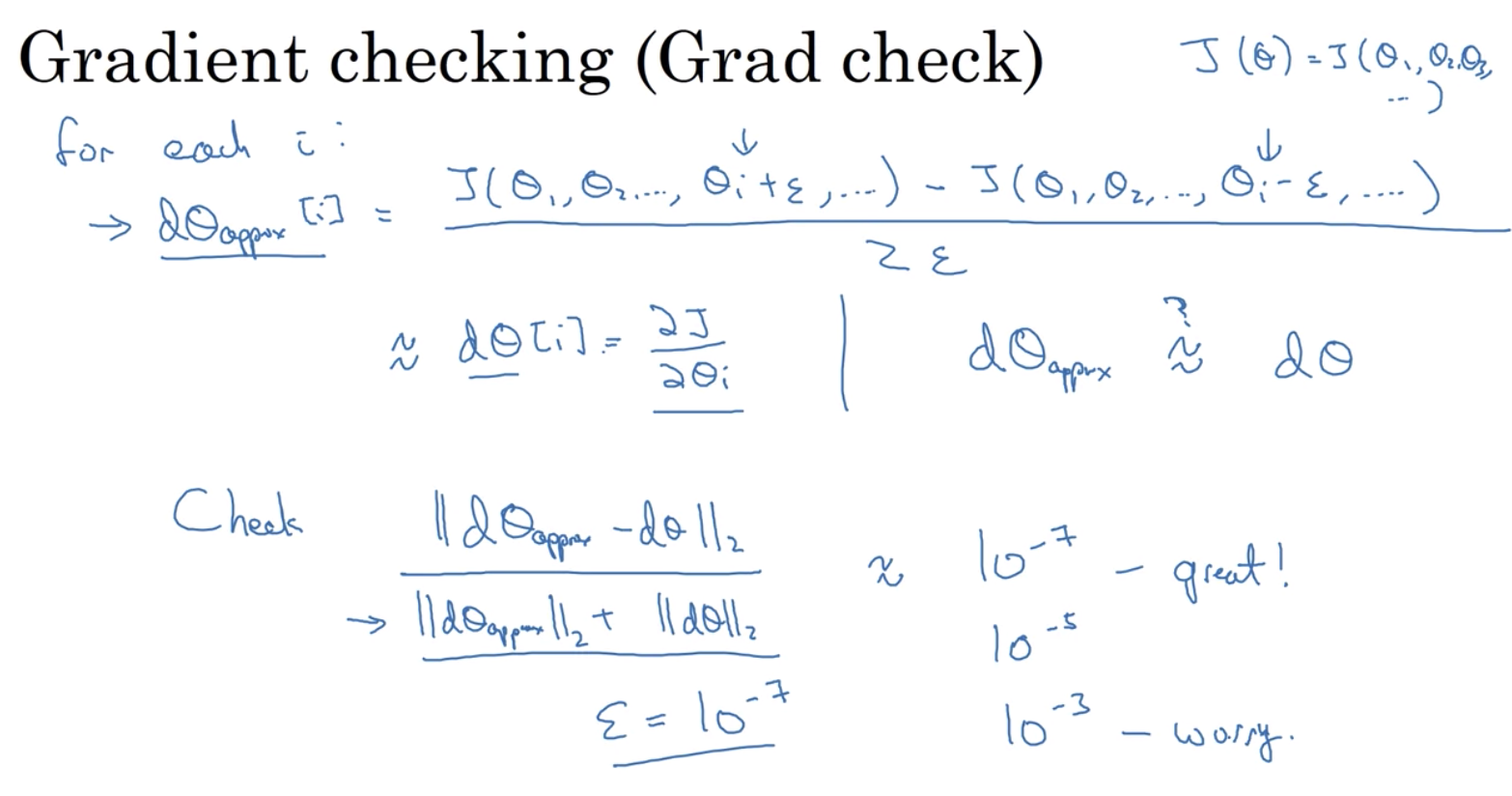

如何实现gradient checking?

实现gradient checking的小提示

1.别在训练的时候用,只在debug时候用。因为十分耗时

2.如果gradient check发现错误了,要去调出那个导致错误的layer或unit,不要将全部theta(w1,b1,w2,b2….wn,bn)看成bug的原因

3.如果有regularization(如L2),记得算gradient check的时候把regularization也放进去

4.对drop不适用,建议先进行gradient checking(如将keepdims设为1.0),再进行drop out

5.不太懂