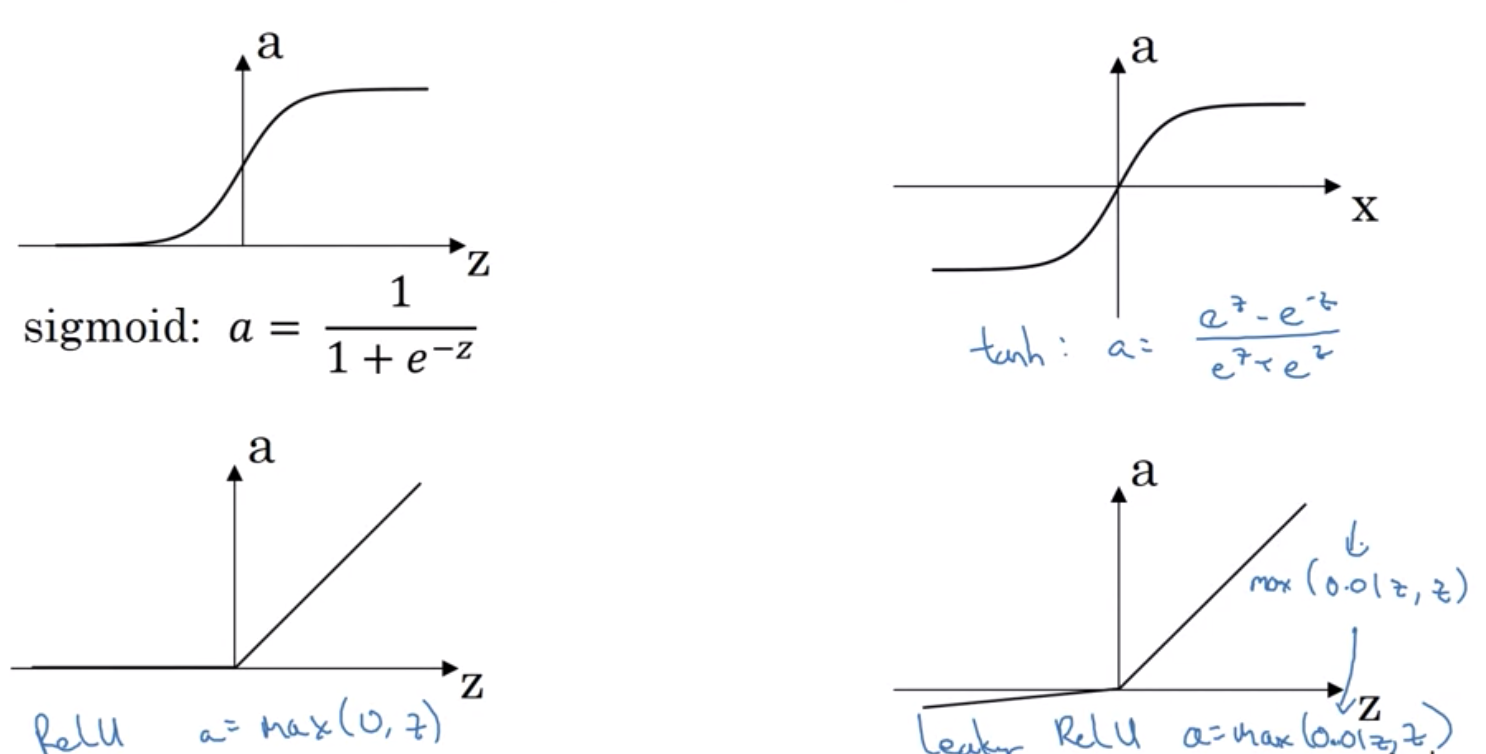

常见有四种activation function

- sigmoid

不常用,通常只有在output layer为binary classification时才会在output layer用

- tanh

比sigmoid更好,但也不常用

- ReLu (最常用)

- leaky ReLu

第二常用

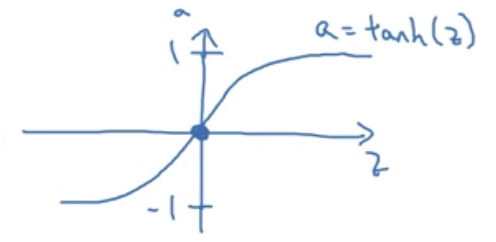

tanh (相当于把sigmoid向下移动0.5):

tanh的优势在于将数据集中到0附近而不是0.5(sigmoid)

sigmoid在binary classification (0/1)问题比较好用因为将数据集中到(0,1)

不同layer可以用不同的activation function