2021-05-13

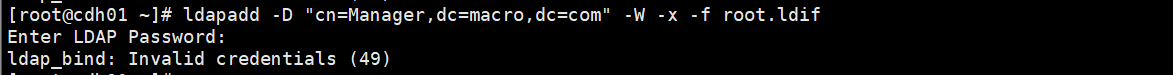

问题:输入密码验证失败(LDAP部署与Hive、Impala、Hue集成)

- 问题场景

ldapadd -D "cn=Manager,dc=macro,dc=com" -W -x -f root.ldif

- 原因1:配置文件错误

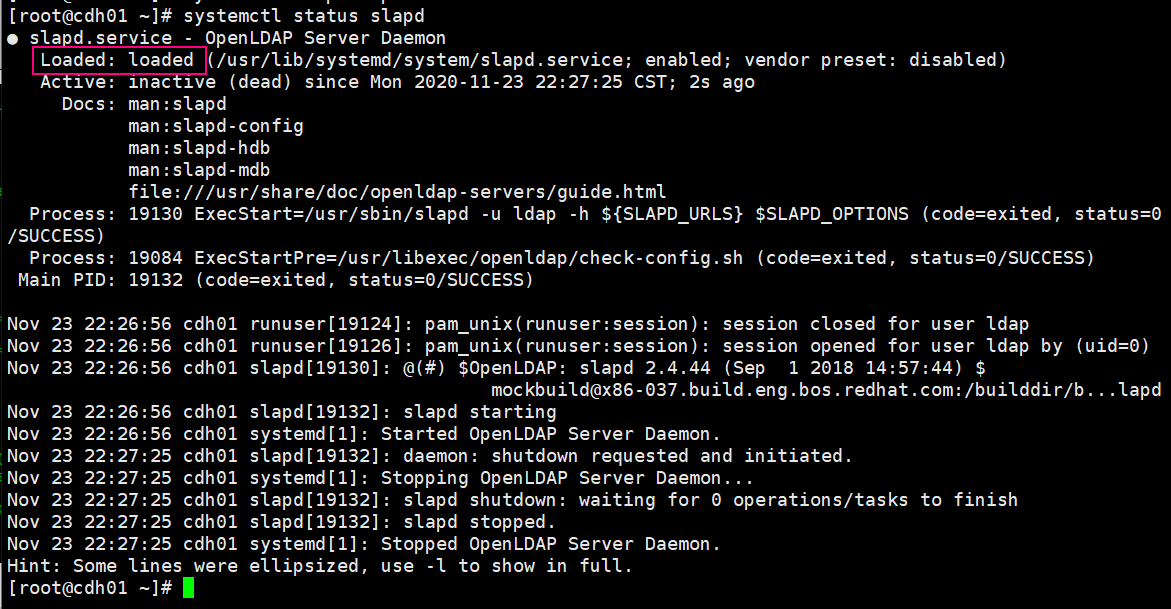

- 原因2:修改了配置却未重启sldap服务,导致当前运行服务的配置仍为之前配置的内容

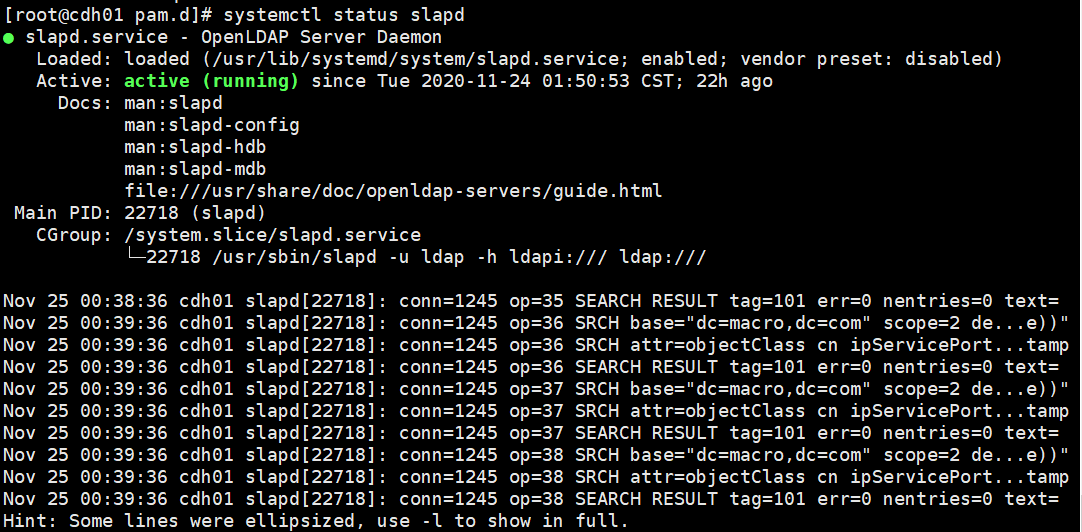

- 解决:检查配置文件,并重启slapd服务

systemctl restart slapd

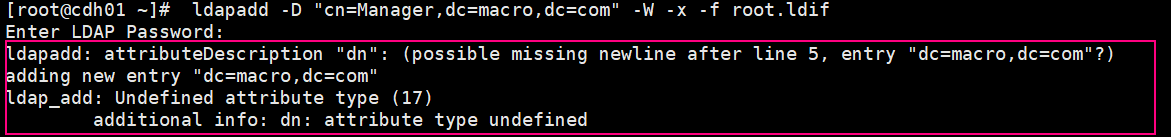

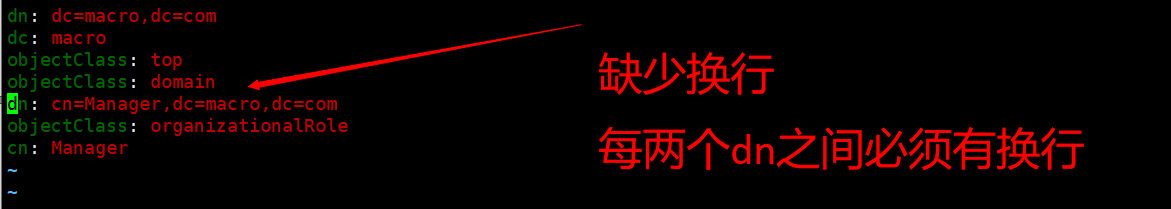

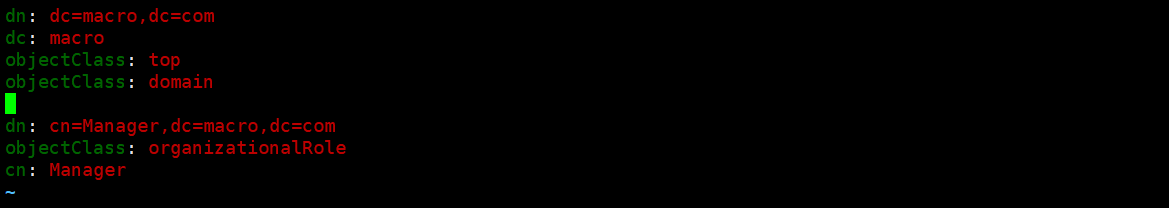

问题2、导入 OpenLDAP 失败

- 问题场景

ldapadd -D "cn=Manager,dc=macro,dc=com" -W -x -f root.ldif

- 原因:需要导入的ldif文件配置错误

- 解决:添加换行

- .ldif文件正确书写格式

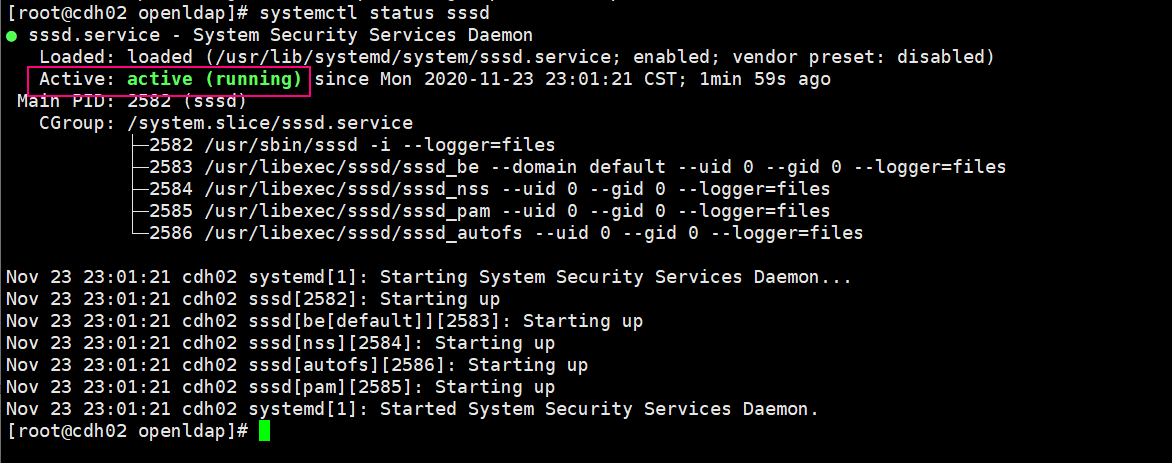

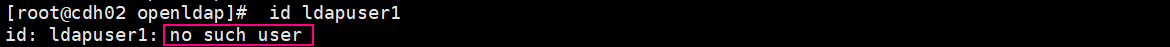

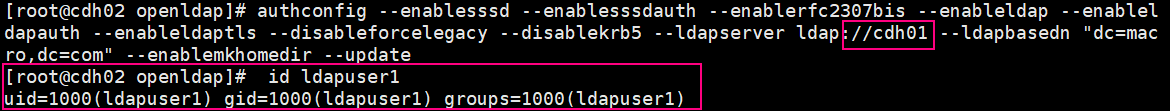

问题3、SSSD启动,但无法通过ID user查看OpenDAP的用户

- 问题场景

systemctl status sssd

id ldapuser1

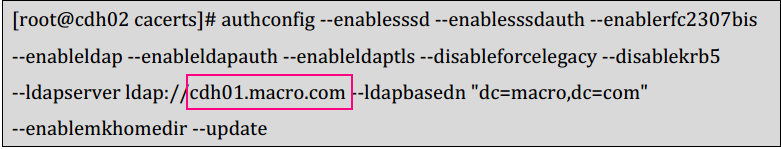

- 原因1:启动sssd服务参数错误

- 解决方式:修改为正确的主机名

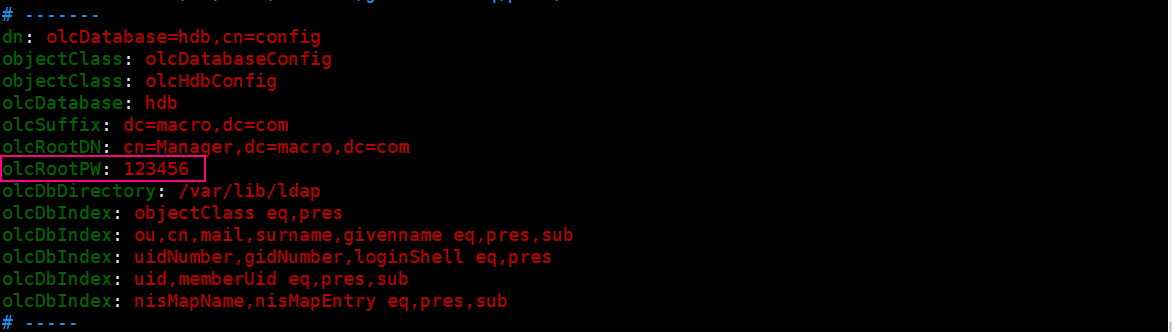

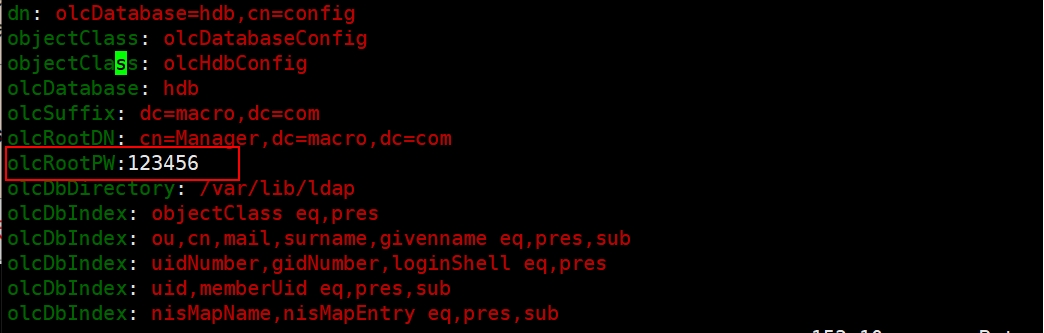

- 原因2:配置文件错误,如slapd.ldif配置文件密码前无空行等配置问题

- 解决:修改配置文件,重启服务

systemctl restart slapd

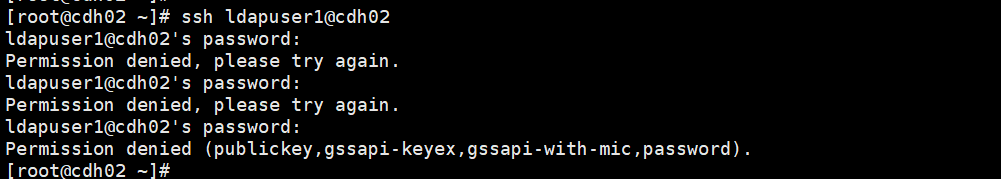

问题4、LDAP用户密码遗忘无法登录问题

- 问题场景

ssh ldapuser1@cdh01

- 原因:遗忘密码,认证失败

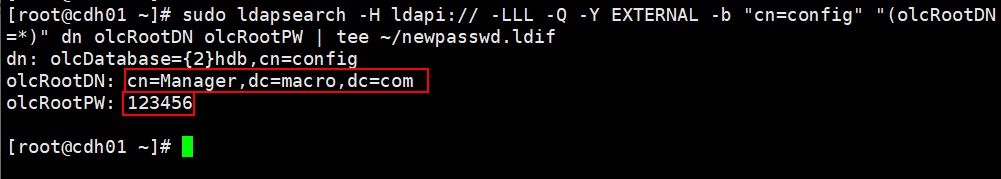

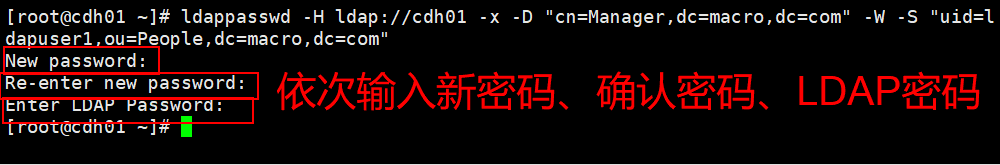

- 解决方式:在主节点重置LDAP密码,查看rootDN(服务器节点),使用rootDN重置指定节点用户密码

sudo ldapsearch -H ldapi:// -LLL -Q -Y EXTERNAL -b "cn=config" "(olcRootDN=*)" dn olcRootDN olcRootPW | tee ~/newpasswd.ldif

ldappasswd -H ldap://cdh01 -x -D "cn=Manager,dc=macro,dc=com" -W -S "uid=ldapuser1,ou=People,dc=macro,dc=com"

- 重启服务即可

systemctl restart sssdsystemctl restart nslcd

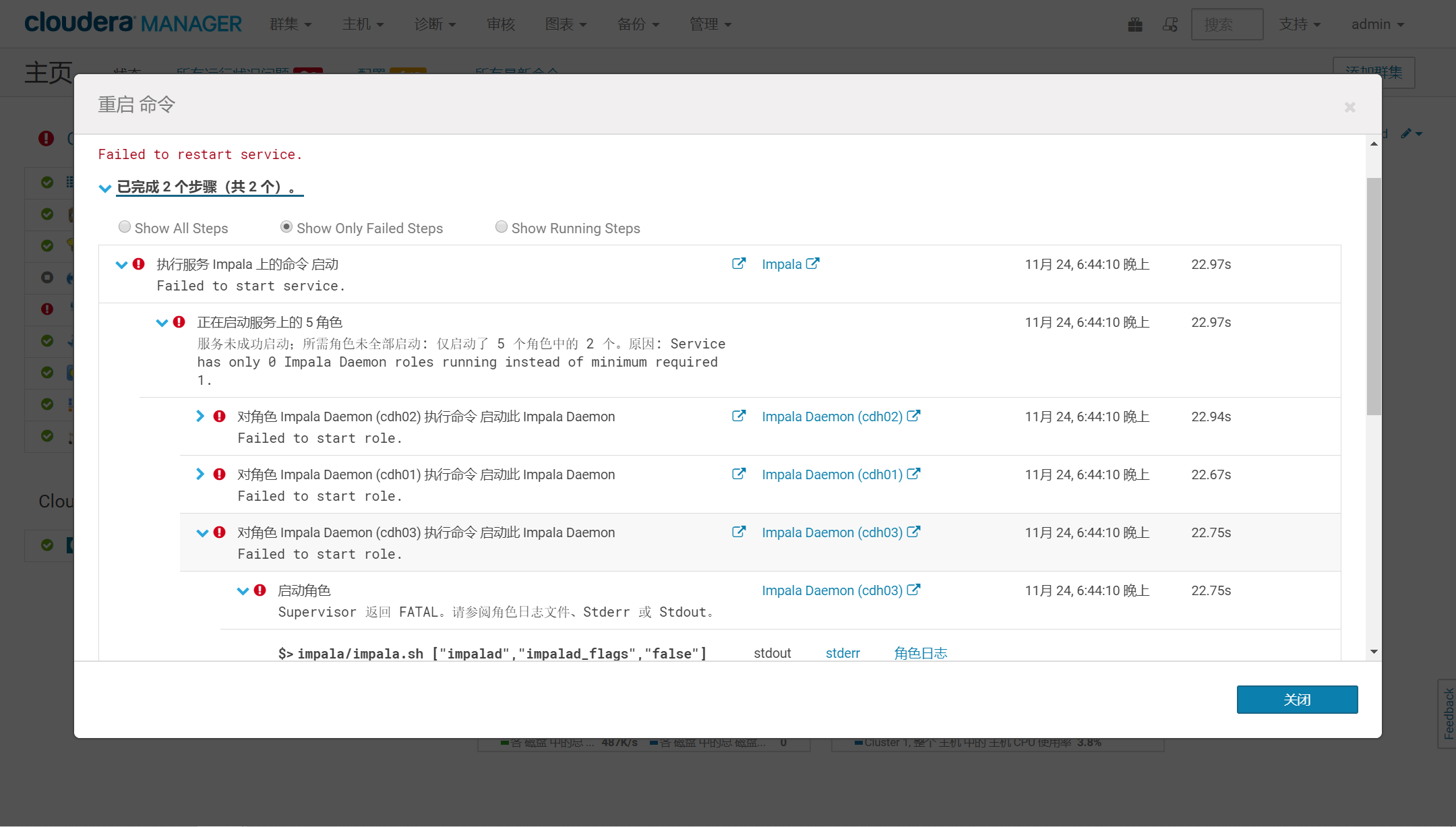

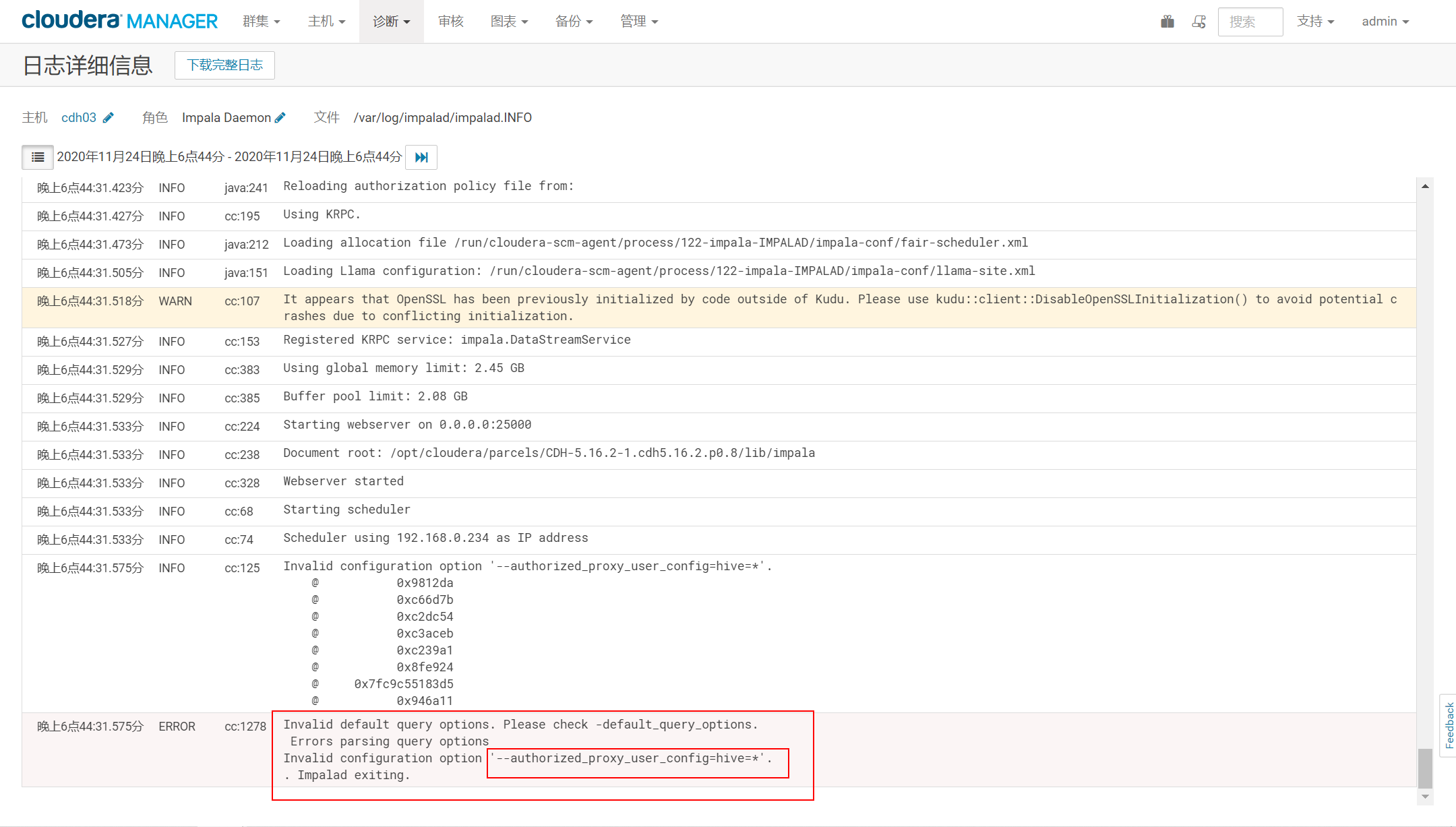

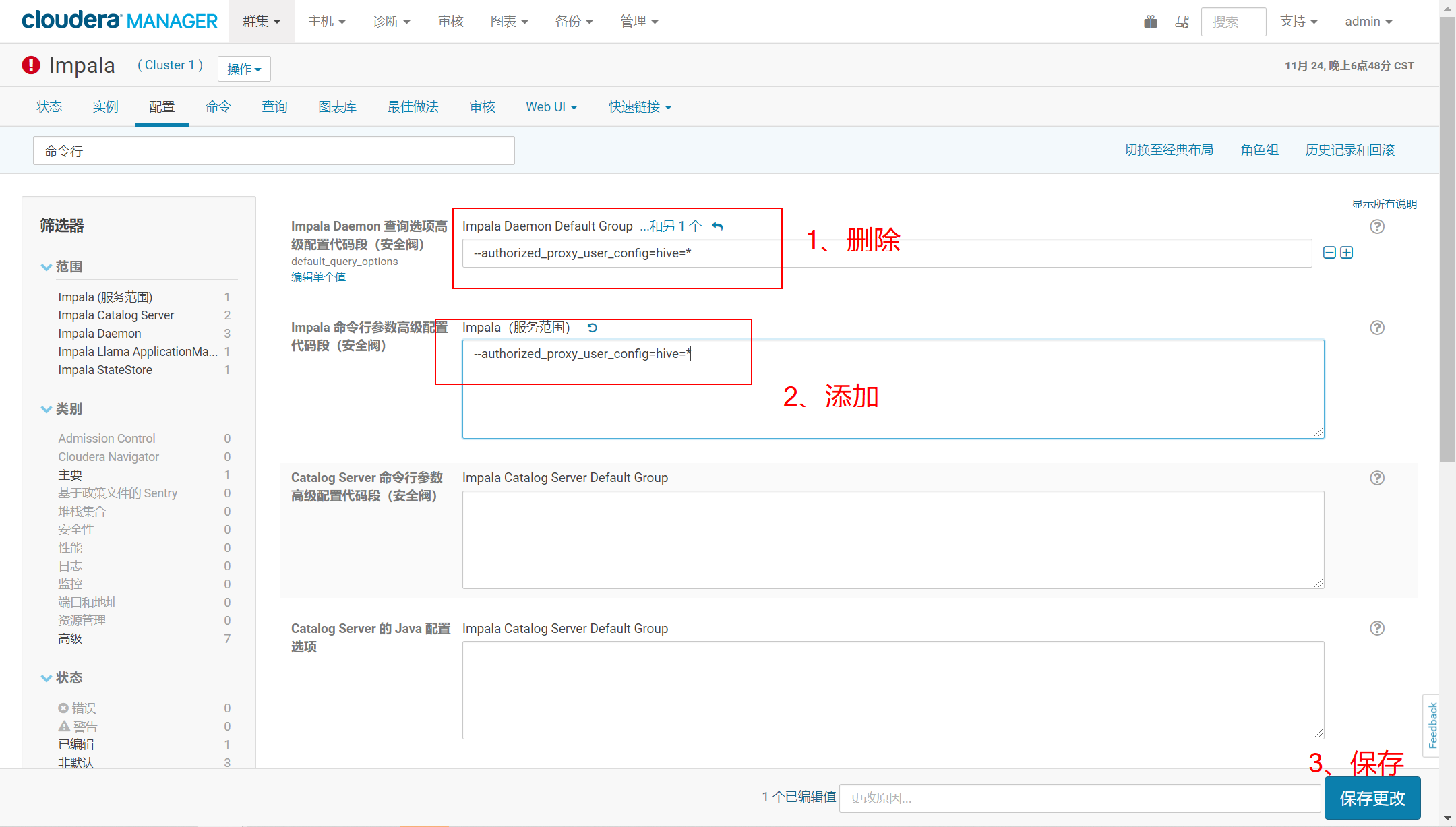

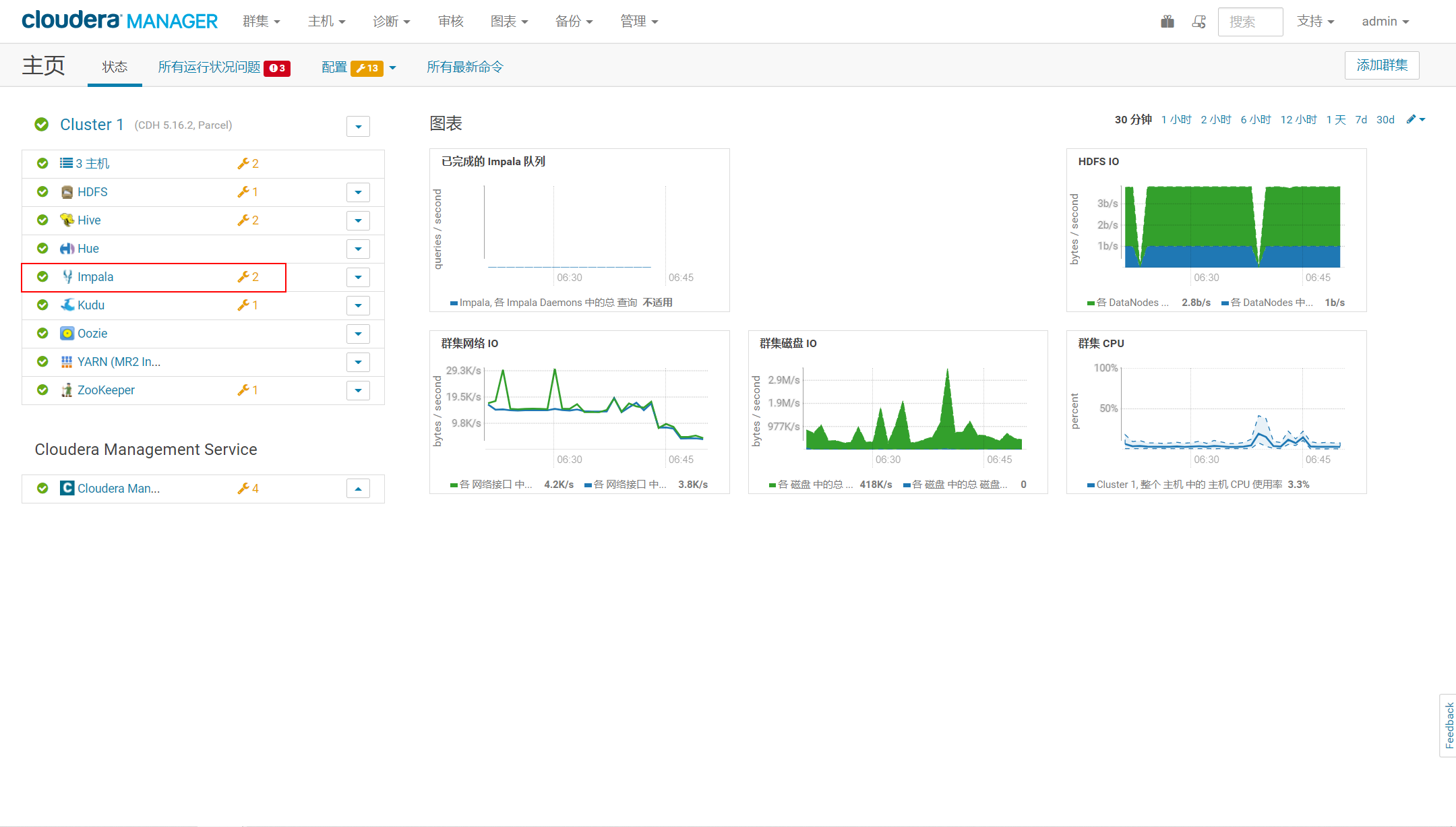

问题5、OpenLDAP集成Hive和hue后,impala启动失败

- 问题场景

- 原因:—authorized_proxy_user_config=hive=* 配置地方错误

- 解决:重新设置,并重启impala服务

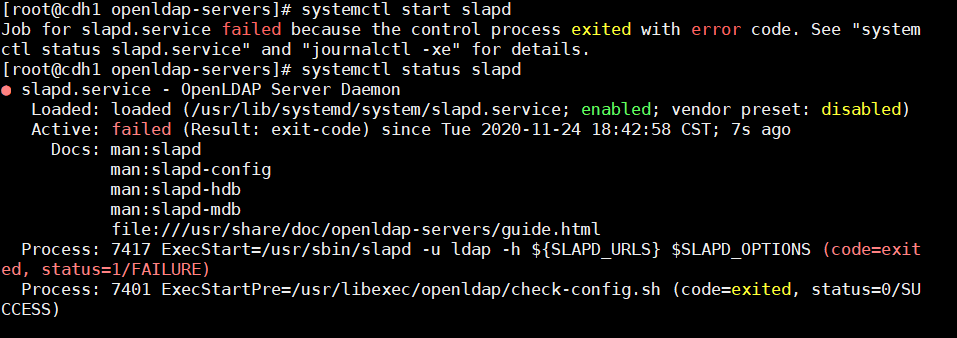

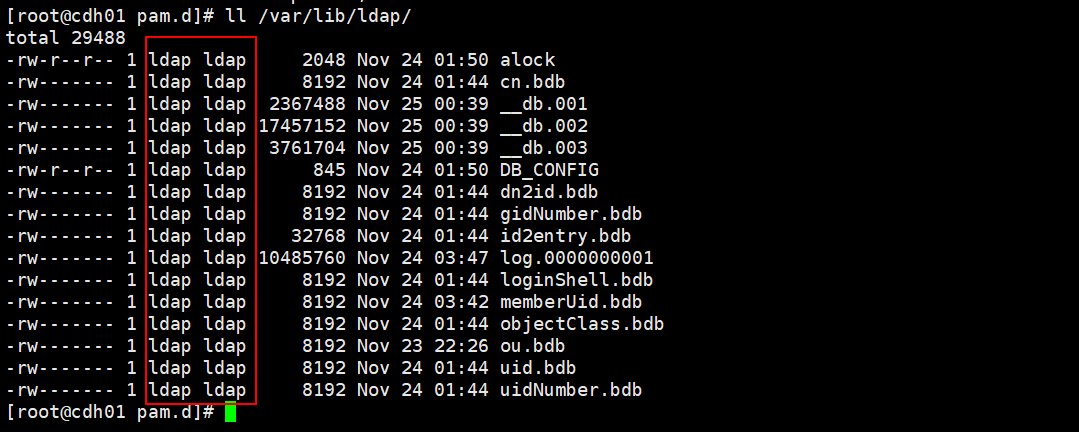

问题6、修改slapd.ldif后,启动OpenLDAP服务失败

- 原因:/var/lib/ldap 组权限问题,导致启动该服务读取文件失败

- 解决:检查发现ldap无组权限,修改组权限,重新执行启动命令

chown -R ldap. /var/lib/ldap

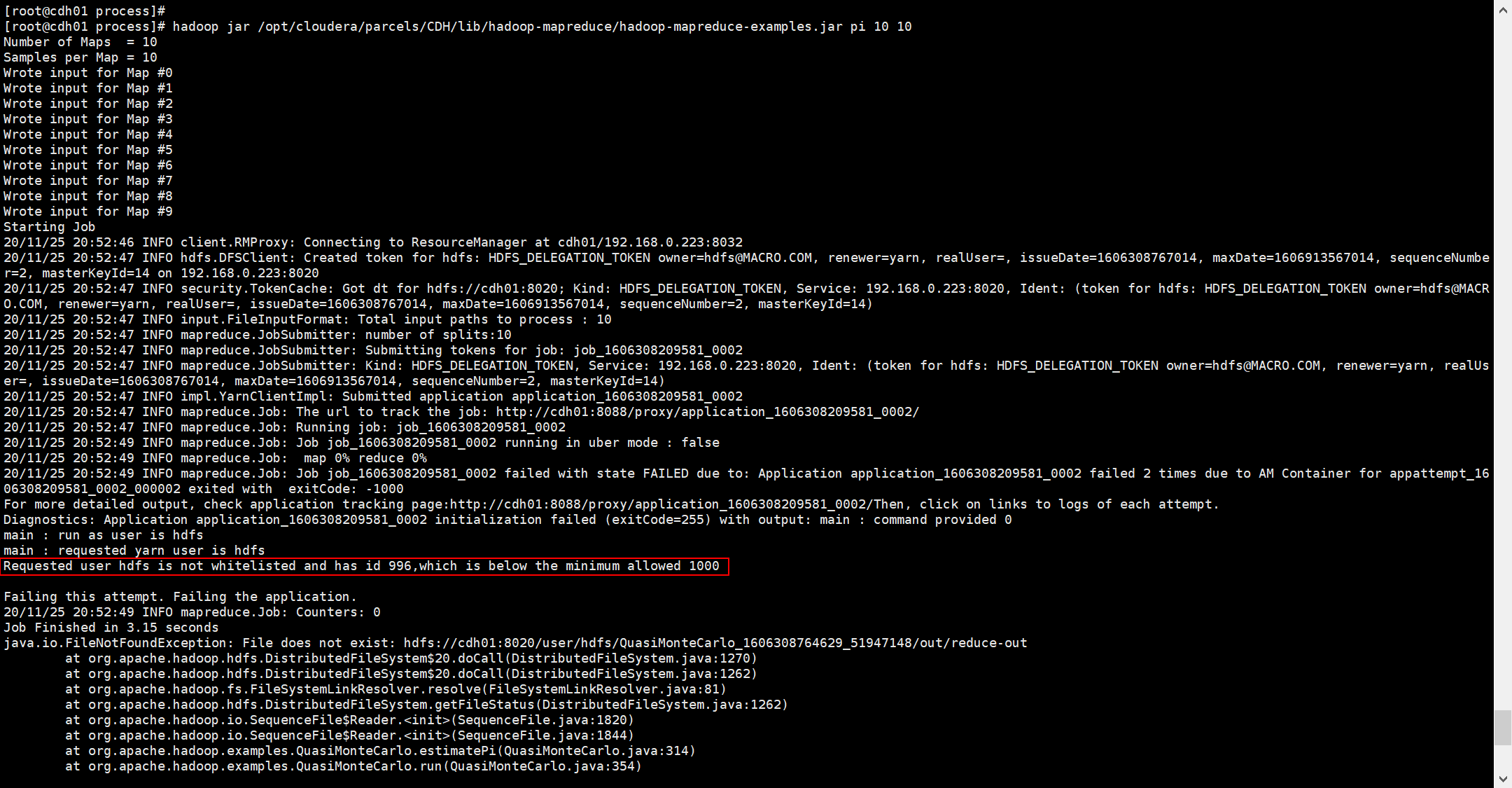

问题:请求的用户hdfs未被列入白名单,其id为996,低于允许的最小值1000(Kerberos集成认证)

hadoop jar /opt/cloudera/parcels/CDH/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar pi 10 10

- 原因:ID值小于1000

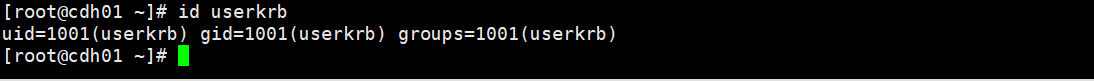

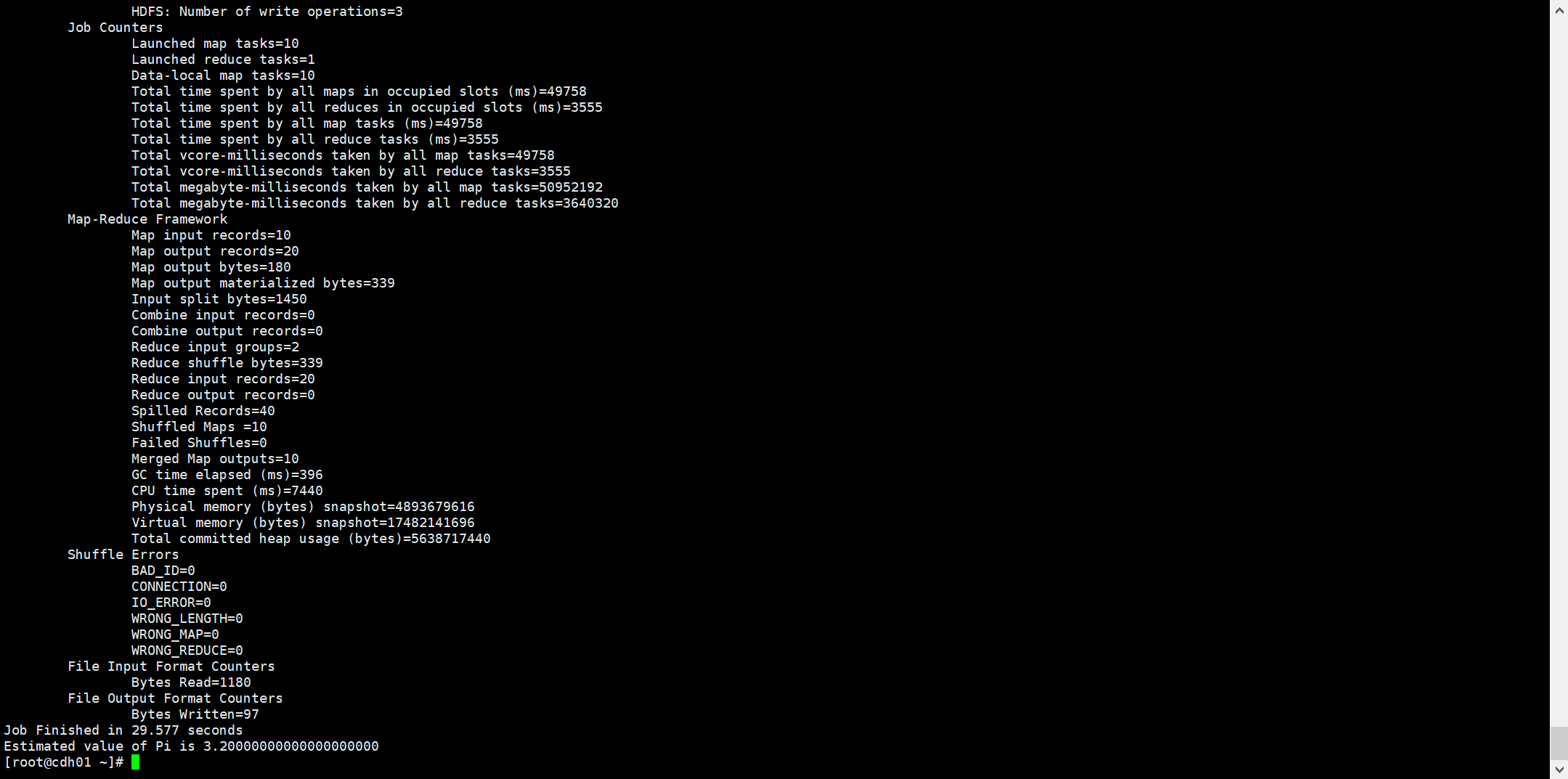

- 解决:切换ID大于1000的用户,查看ID,重新运行

hadoop jar /opt/cloudera/parcels/CDH/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar pi 10 10

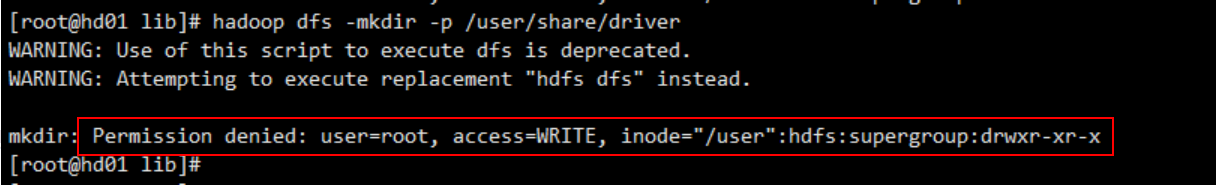

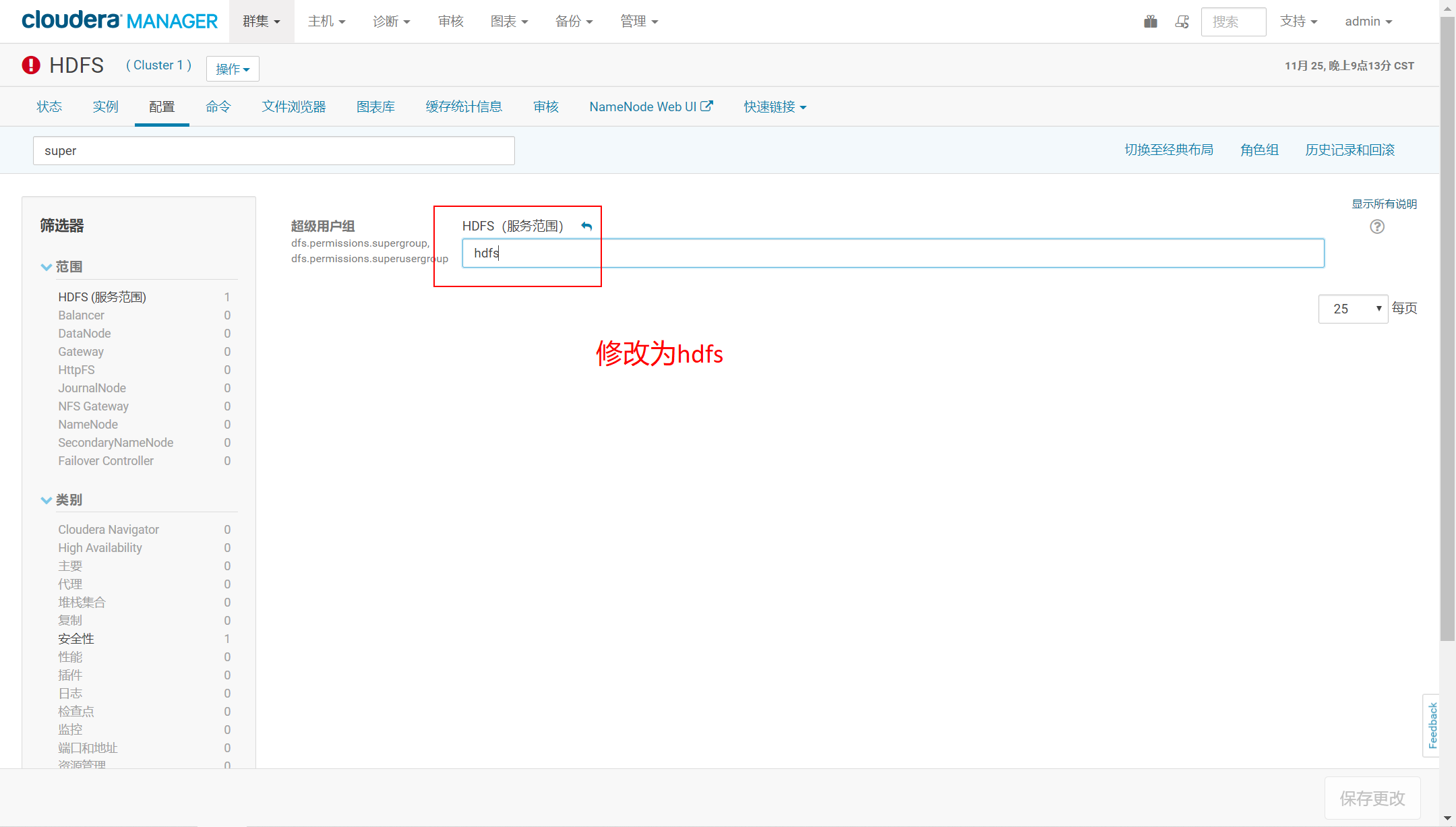

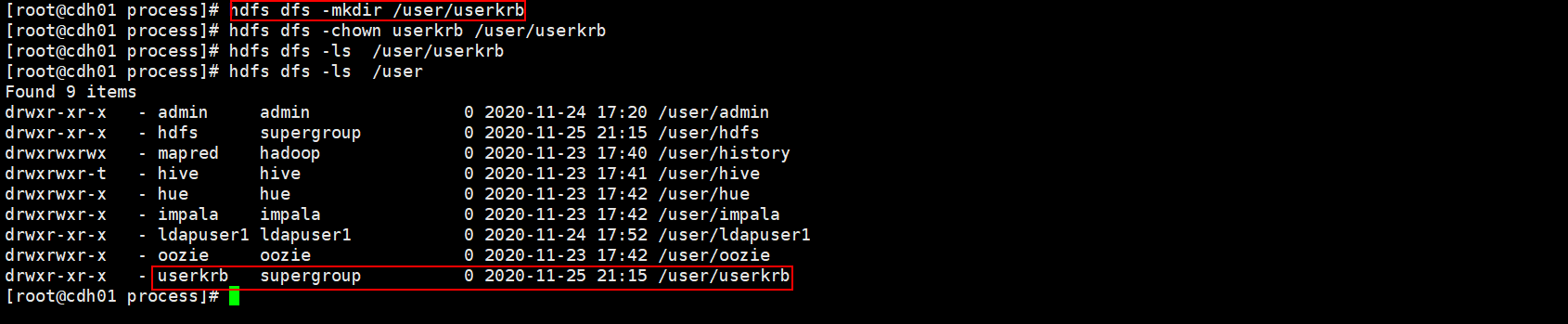

问题2、Kerberos的HDFS操作HDFS无权限

hdfs dfs -mkdir /user/userkrb

- 原因:当前用户不在super组当中,故无法操作。

- 解决方式:core-site.xml中,HDFS的超级用户组hdfs,重启HDFS

hdfs dfs -mkdir /user/userkrb

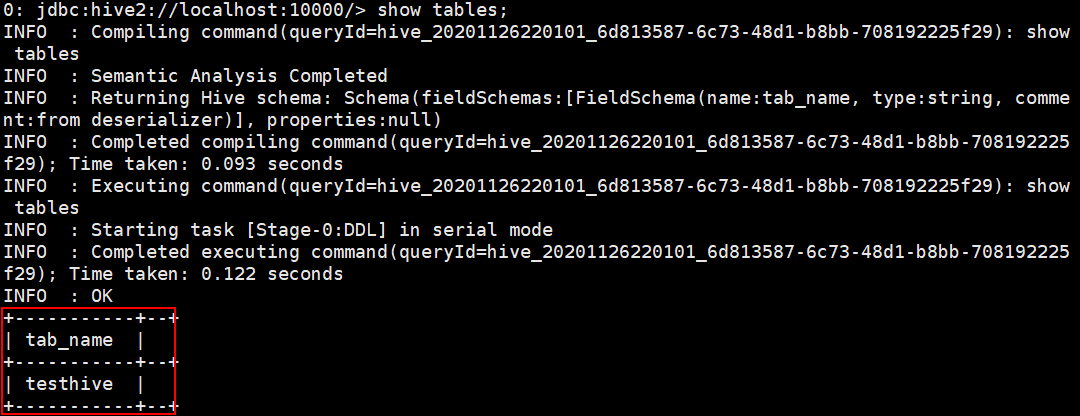

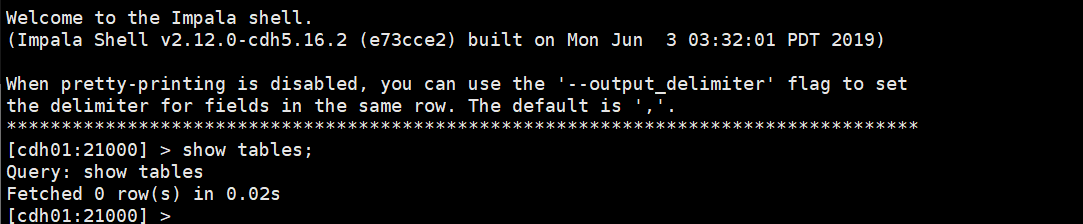

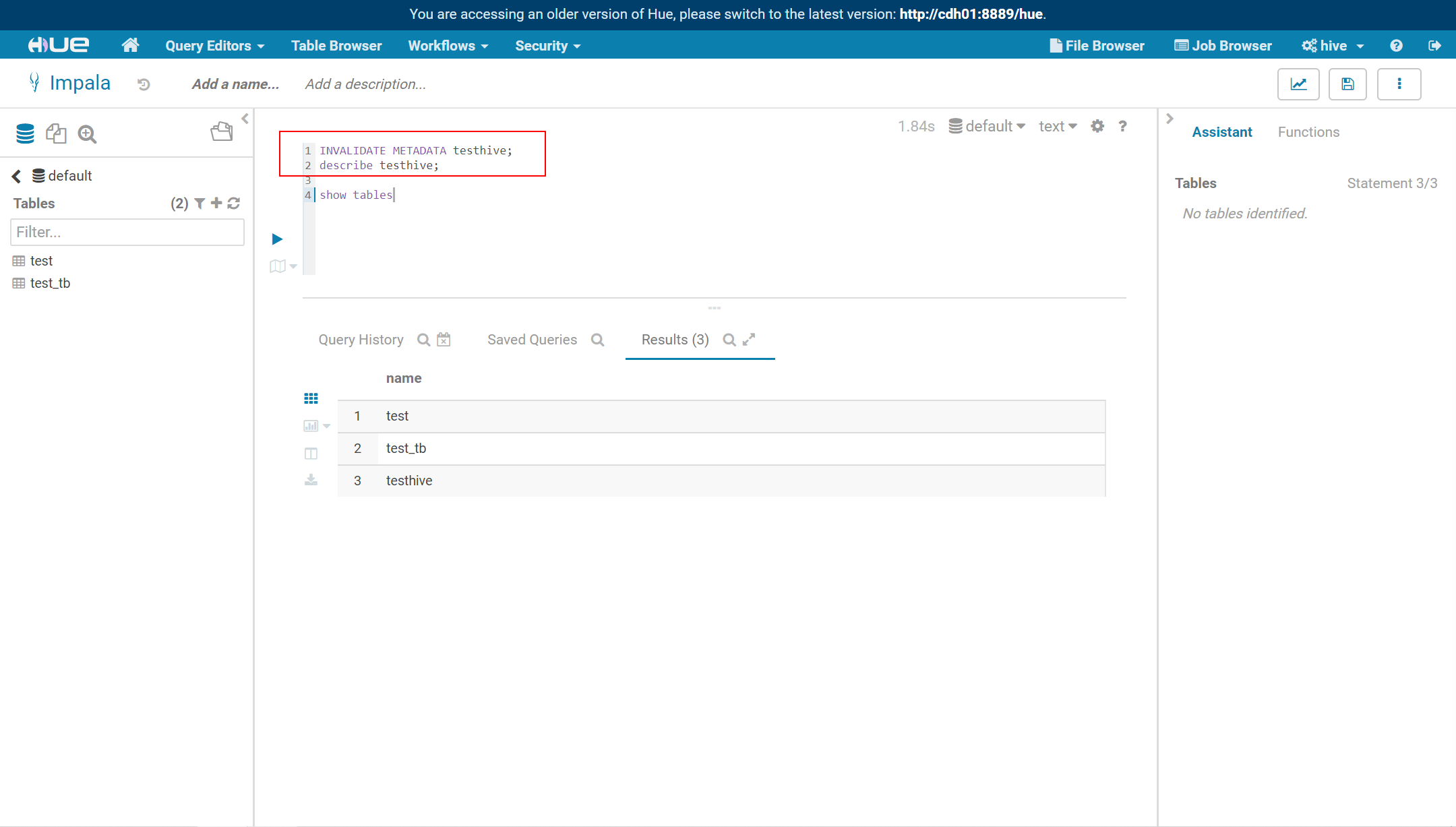

问题3、使用Kerberos账户可以查询hive但不能查询impala

- 解决办法:刷新impala元数据(使用hive管理账户),查看表结构

INVALIDATE METADATA testhive;desc testhive;

2021-05-02

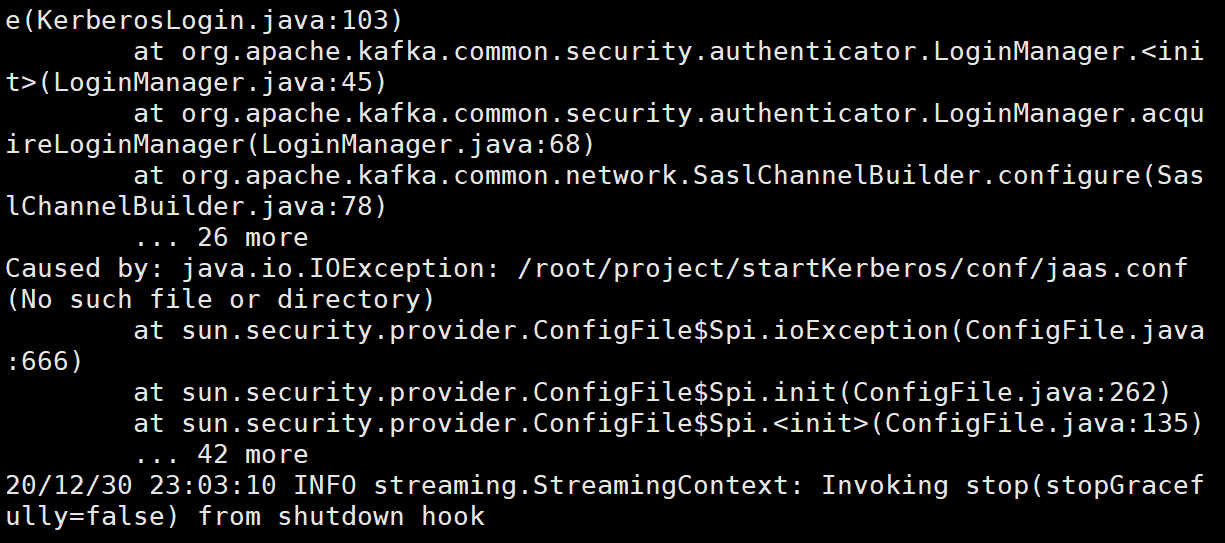

问题:Kerberos 环境下 读取不到指定文件

报错内容:

java.io.IOException: /root/project/startKerberos/conf/jaas.conf (No such file or directory)

原因:权限问题,赋予组权限即可

chown hive:hadoop ./hive.keytab ./jaas.conf ./jaas-keytab.conf