1.简述一下随机森林算法的原理

2.随机森林的随机性体现在哪里?

3.随机森林算法的优缺点?

4.随机森林为什么不能用全样本去训练m棵决策树?

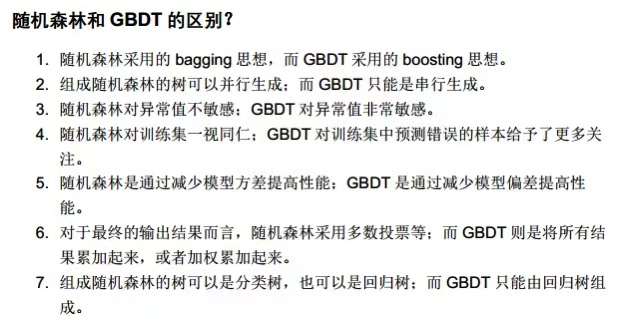

5.随机森林和GBDT的区别

衍生问题:

为什么随机森林对异常值不敏感,而GBDT对异常值敏感?

因为随机森林引入了抽样,而且是多个模型共同做决策。某个值除了问题,对整体影响不大。而GBDT是串行操作,一个异常值,几乎会影响到所有模型的训练。

随机森林缺点第二条 为什么划分较多的属性会对随机森林产生大的影响 属性权值是指? 它什么作用

相当的于这个属性多次被用来做判断,那么权重自然上升,对整个模型的表现影响就大。可以类比于我们上周讲的样本不平衡问题来理解,丰富类样本得到更多的训练机会,那么他们对模型的决策影响就大。

GBDT使用回归树做基学习器,那GBDT只能做回归任务?

不是,加上 sigmoid 和 softmax 可以把回归任务转换为分类任务。

随机森林的每个决策树之间,是平行的吗?相互没有影响吧?另外,对于确定维度的数据集,通过随机森林得到的决策树的数目如何确定?

是平行的。是的训练过程相互不干涉。树的数量是个超参数,可以调节。

用随机森林做回归和分类,最后的结果,回归问题取所有树的平均值,分类问题通过投票方法确定最后的类别吗?

是的

什么是多数投票,怎样投票的

关于bagging 投票方法增强的一个例子,如果 m1, m2, m3 三个模型分别对三个样本进行二分类,三个模型分的的结果分别为 1,是 是 否 2. 否 是 是 3. 是 否 是。假设三个样本的label 都为是。那么每个模型的准确率都是2/3 而bagging 后的模型准确率就达到了 100%