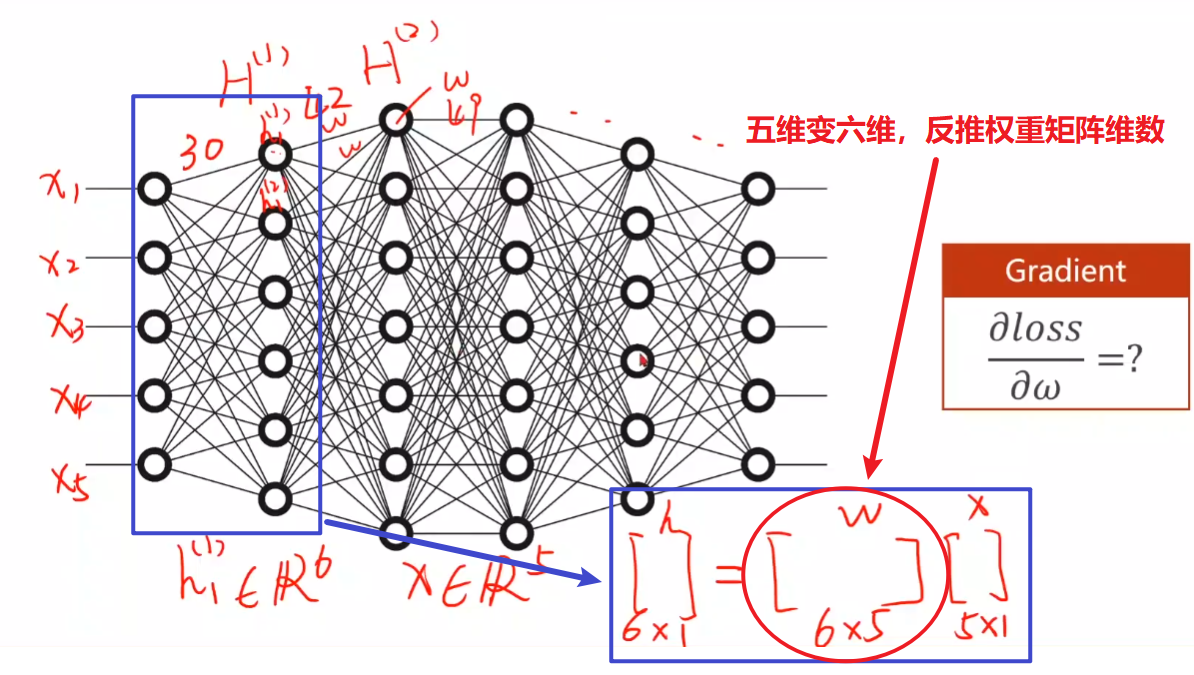

神经网络图

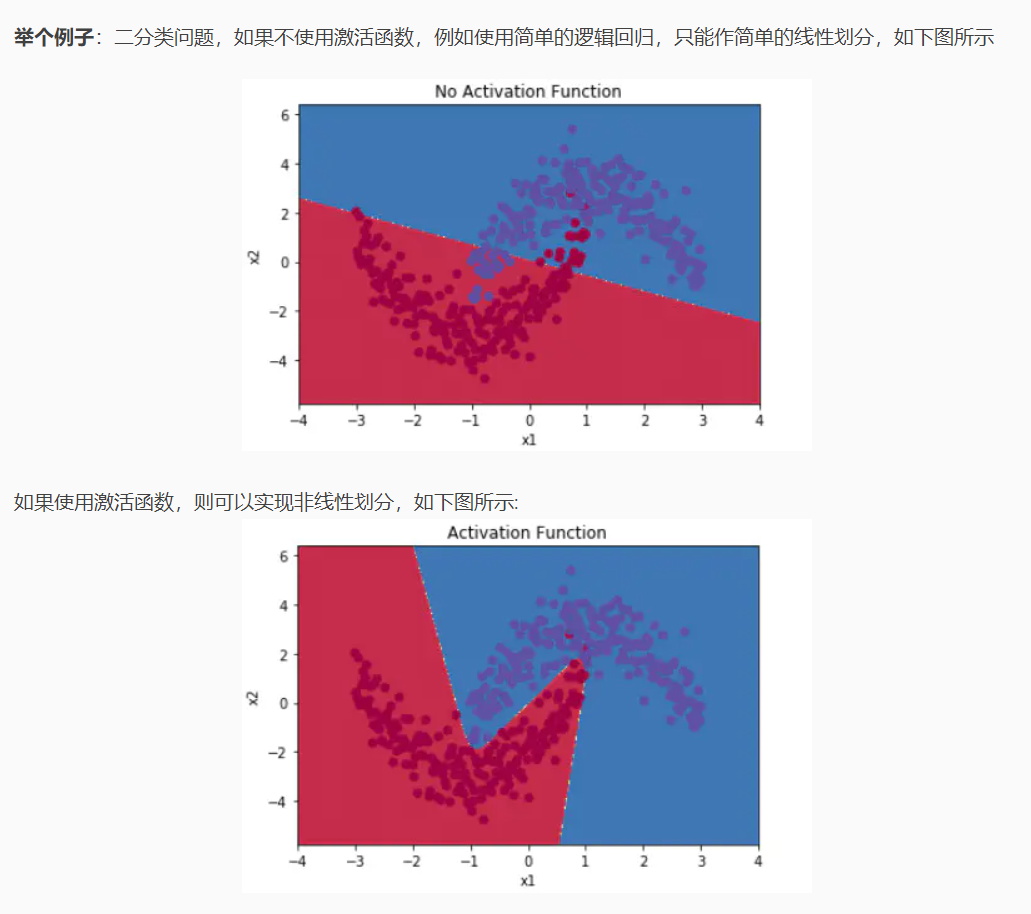

激活函数

目的:加入非线性因素,因为线性模型的表达力不够。

没有激活函数的每层都仅相当于矩阵相乘,叠加了再多层也还是矩阵相乘,那么网络的逼近能力就很有限。

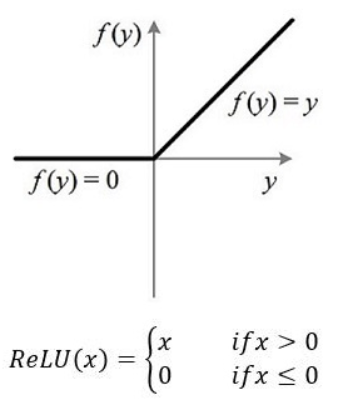

ReLU函数

ReLU函数把所有的负值都变为0,而正值不变,这种操作被称为单侧抑制。

在输入是负值的情况下,它会输出0,那么神经元就不会被激活。这意味着同一时间只有部分神经元会被激活,从而使得网络很稀疏,进而对计算来说是非常有效率的。

卷积神经网络

CNN(Convolutional Nerual Network).

三大参数:卷积核大小、填充、步长。

- kernel(filter):一般有33或55,实际上是一个权重矩阵。

- padding:最外圈补0,便于提取图像边缘特征。

- stride:步长。

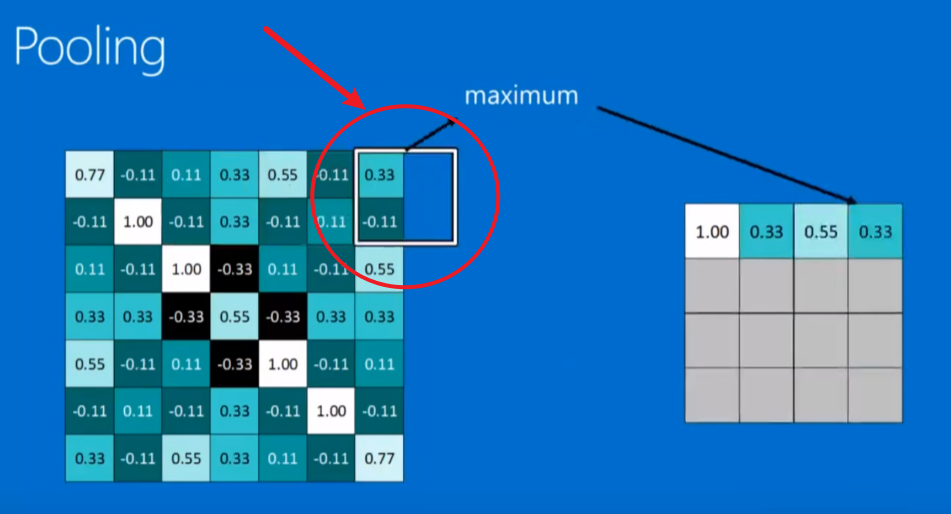

pooling:池化,也可以理解为汇聚。一般有取平均与取最大两种。

normalization:常用ReLUs,把负数变成0

Full connected:全连接(FC)。全连接层一般是作为最后的输出层使用,卷积的作用是提取图像的特征,最后的全连接层就是要通过这些特征来进行计算,输出我们所要的结果。每一层的每个神经元都与下一层的每个神经元相连。我们的特征都是使用矩阵表示的,所以再传入全连接层之前还需要对特征进行压扁,将这些特征变成一维的向量。

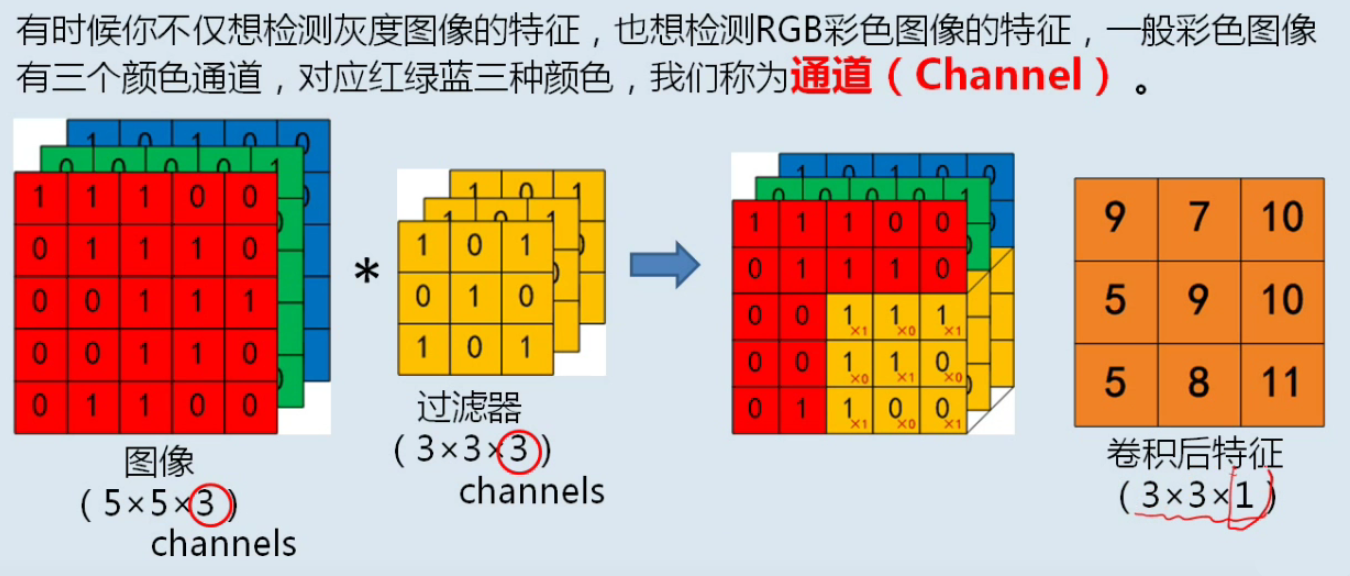

Channel:通道,不仅是灰度图,更是RGB。

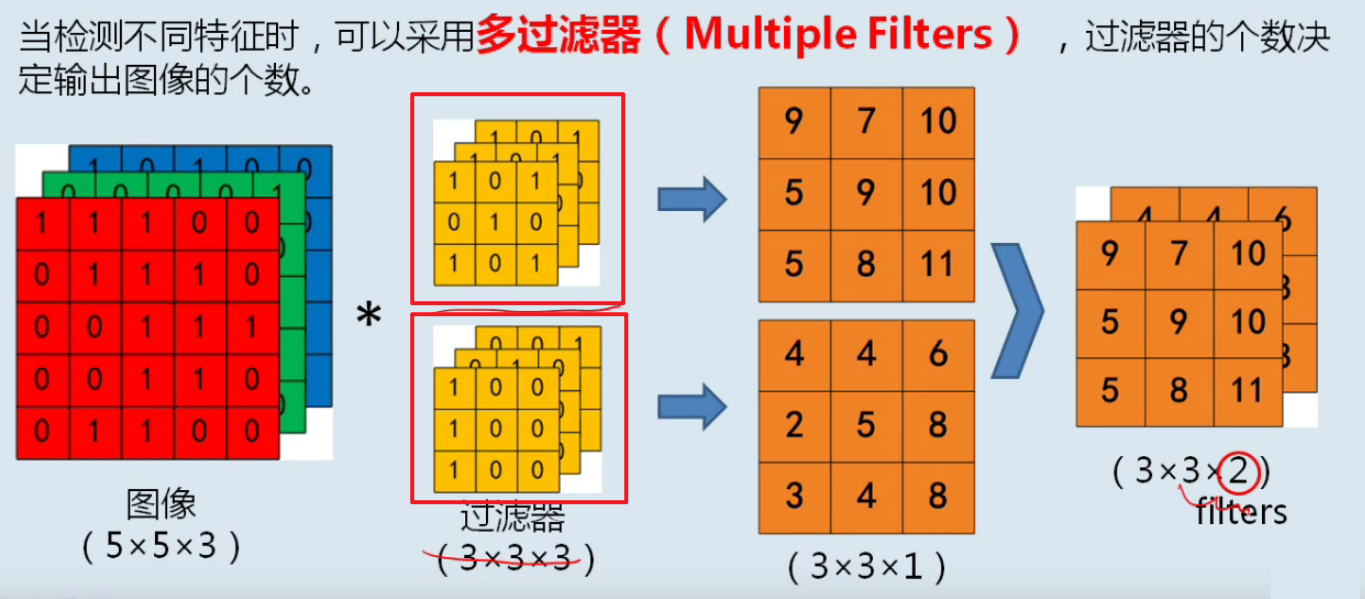

Multiple Filters:多过滤器。多个卷积核会产生多个结果。

计算卷积输出大小:

设输入图像大小为nn,卷积核为ff,填充为p,步长为s,则输出o为: