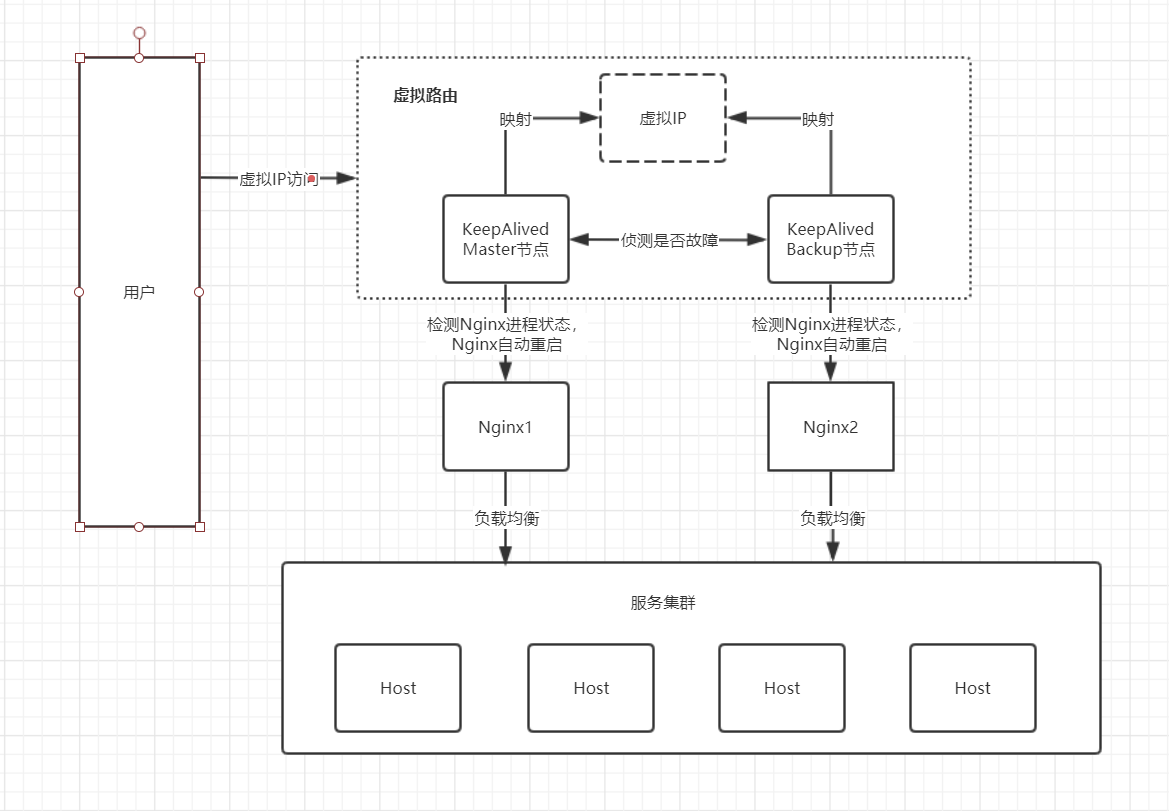

在通过 Nginx 构建 服务集群后, 为保证Nginx服务的高可用性, 配备第二台Nginx 作为后备, 通过keepalived虚拟路由实现双机主备,最终实现内网环境下高可用服务集群。

- 方案如下图所示:

环境准备,

- 两台服务器,本文以虚拟机为例。域名通过手动修改hosts文件绑定到ip

- 主服务器 IP:192.168.61.135

- 备用服务器 IP:192.168.61.130

- 虚拟IP 192.168.61.132 自行设置

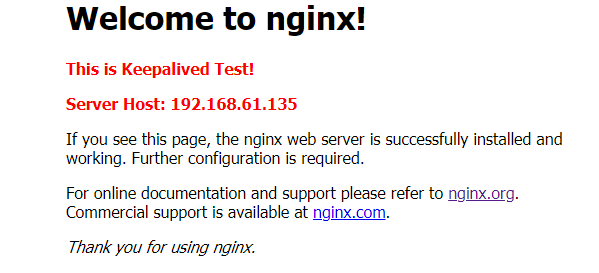

- 服务分别安装并启动nginx,并修改首页。

- Nginx 安装教程: https://www.yuque.com/u1949579/af0ak9/yhwhst

- 防火墙开放80端口

firewall-cmd --zone=public --add-port=80/tcp --permanent - nginx开启自启

systemctl enable nginx - 启动nginx

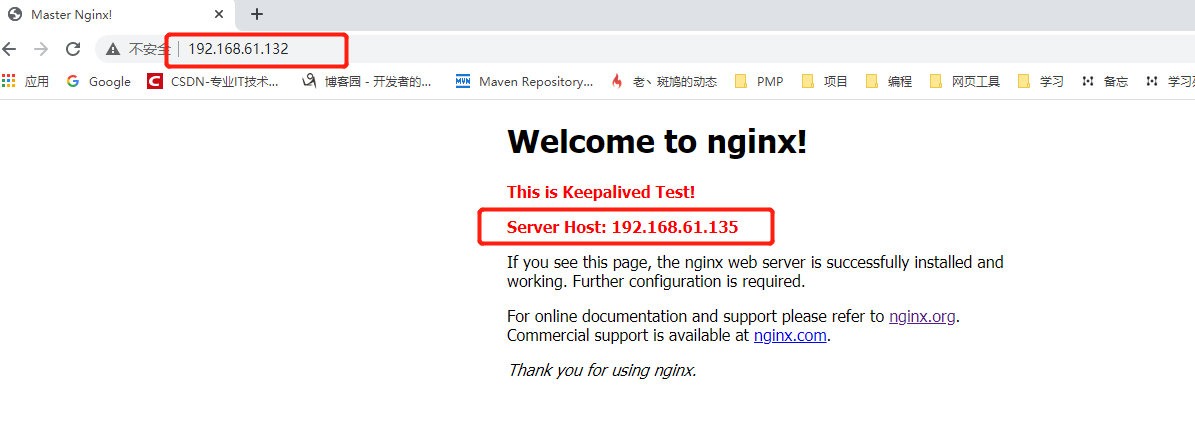

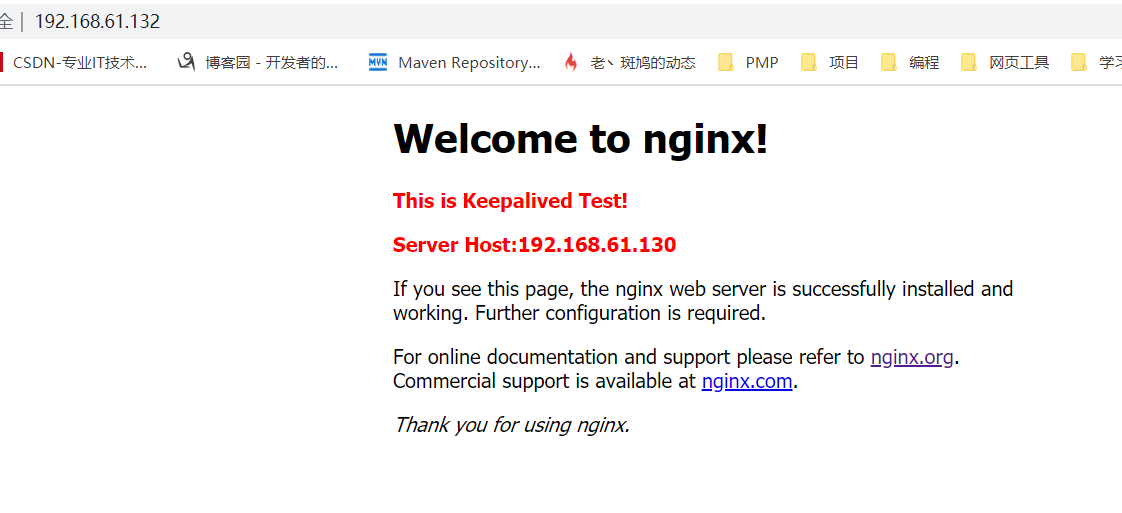

systemctl start nginx - 修改首页 效果如下

- 服务器分别安装keepalived

- keepalived 安装教程: https://www.yuque.com/u1949579/af0ak9/ioplet

- 建议使用源码包安装,yum安装的版本太早了,很多问题。

- keepalived开机启动:

systemctl enable keepalived

编写Nginx自动重启脚本

注意: 主备之间都需要编写该文件。

**

- 脚本中使用到的非linux默认安装的命令

- 安装killall 命令

yum install -y psmisc - 安装 netstat 命令

yum install -y net-tools

- 安装killall 命令

在keepalived配置文件存放目录中创建脚本 vim /etc/keepalived/chk_nginx.sh

#!/bin/bash# 这种方式是查询nginx的进程#A=`ps -C nginx --no-header | wc -l`# 这种方式是查询nginx的端口A=`netstat -tnlp | grep nginx | wc -l`if [ $A -eq 0 ];then# 启动Nginx ,根据你自己的路径启动/usr/local/nginx/sbin/nginxsleep 2#if [ `ps -C nginx --no-header | wc -l` -eq 0 ];thenif [ `netstat -tnlp | grep nginx | wc -l` -eq 0 ];thenkillall keepalivedfifi

使用 chmod +x ``/etc/keepalived/chk_nginx.sh 赋予文件执行权限

修改keepalived.conf 配置文件

vim /etc/keepalived/keepalived.conf

- 主机配置如下

```bash

! Configuration File for keepalived

全局配置

global_defs { router_id keep_135 #路由ID,局域网内应唯一 script_user root #运行脚本的用户,避免 WARNING - default user ‘keepalived_script’ for script execution does not exist - please create. enable_script_security #避免SECURITY VIOLATION警告 }

脚本检测

vrrp_script check_nginx_alived {

#脚本路径script "/etc/keepalived/chk_nginx.sh"

脚本运行间隔

interval 2

如果脚本运行成功,则升权+10,如果配置负数(-10),则运行失败,降权。

weight 10 }

虚拟路由配置

vrrp_instance VI_1 { state MASTER #初始情况下的主备状态 interface ens33 #网卡文件名,注意应填写你的主机使用的网卡名称 virtual_router_id 51 #虚拟路由id,主备应保持一致 priority 100 #权重,发生主备切换时成为主机的优先级 advert_int 1 #侦测心跳,单位s

#鉴权配置authentication {auth_type PASS #鉴权类型 PASSauth_pass 1111 #密码}#脚本追踪track_script {#对应vrrp_script 的namecheck_nginx_alived}#虚拟IP,可以有多个,一行一个,主备之间应保持一致virtual_ipaddress {192.168.61.132}

}

- 备用机配置如下```bash! Configuration File for keepalived#全局配置global_defs {router_id keep_130 #路由ID,局域网内应唯一script_user root #运行脚本的用户,避免 WARNING - default user 'keepalived_script' for script execution does not exist - please create.enable_script_security #避免SECURITY VIOLATION警告}#脚本检测vrrp_script check_nginx_alived {#脚本路径script "/etc/keepalived/chk_nginx.sh"# 脚本运行间隔interval 2# 如果脚本运行成功,则升权+10,如果配置负数(-10),则运行失败,降权。weight 10}#虚拟路由配置vrrp_instance VI_1 {state MASTER #初始情况下的主备状态interface ens33 #网卡文件名,注意应填写你的主机使用的网卡名称virtual_router_id 51 #虚拟路由id,主备应保持一致priority 80 #权重,发生主备切换时成为主机的优先级advert_int 1 #侦测心跳,单位s#鉴权配置authentication {auth_type PASS #鉴权类型 PASSauth_pass 1111 #密码}#脚本追踪track_script {#对应vrrp_script 的namecheck_nginx_alived}#虚拟IP,可以有多个,一行一个,主备之间应保持一致virtual_ipaddress {192.168.61.132}}

开启服务并测试

1. 测试主备切换

分别启动主备的keepalived systemctl start keepalived

稍等两秒,使用 ip address 查看虚拟ip的映射

主机

ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000link/ether 00:0c:29:1f:b9:16 brd ff:ff:ff:ff:ff:ffinet 192.168.61.135/24 brd 192.168.61.255 scope global noprefixroute ens33 #真实IPvalid_lft forever preferred_lft foreverinet 192.168.61.132/32 scope global ens33 #虚拟IPvalid_lft forever preferred_lft foreverinet6 fe80::4779:a90b:d19b:8490/64 scope link noprefixroutevalid_lft forever preferred_lft forever

备用机

ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000link/ether 00:0c:29:73:d8:b4 brd ff:ff:ff:ff:ff:ffinet 192.168.61.130/24 brd 192.168.61.255 scope global noprefixroute dynamic ens33 #真实IPvalid_lft 1594sec preferred_lft 1594secinet 192.168.61.132/32 scope global ens33 #虚拟IPvalid_lft forever preferred_lft foreverinet6 fe80::6765:fdf6:f71b:b2f8/64 scope link noprefixroutevalid_lft forever preferred_lft forever

访问虚拟IP 192.168.31.132

当前指向主节点

到主节点服务器下运行 systemctl stop keepalived 关闭主节点再次访问,

重新开启主节点后又恢复到主节点。由于没有配置非抢占,默认情况下主备之间将进行抢占,主要能访问到服务即可。

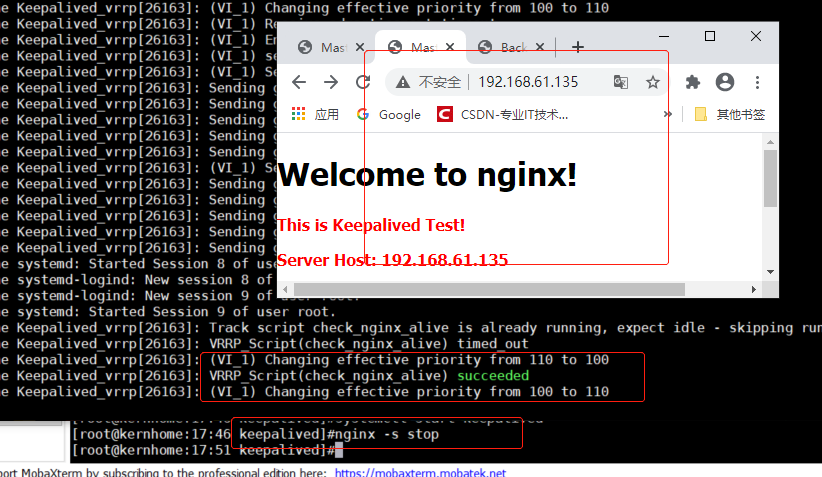

2. 测试Nginx自动重启

以主节点为例, 本例中ip192.168.61.135为主节点

打开两个ssh远程页面,其中一台输入 tail -f -n 50 /var/log/messages 动态查看系统消息

另外一台关闭nginx nginx -s stop

可以看到nginx仍然是可以访问的,日志显示 脚本运行成功

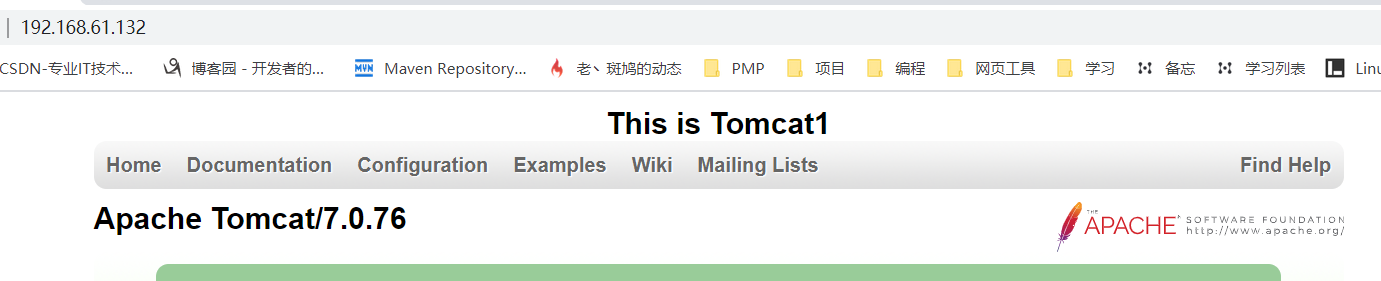

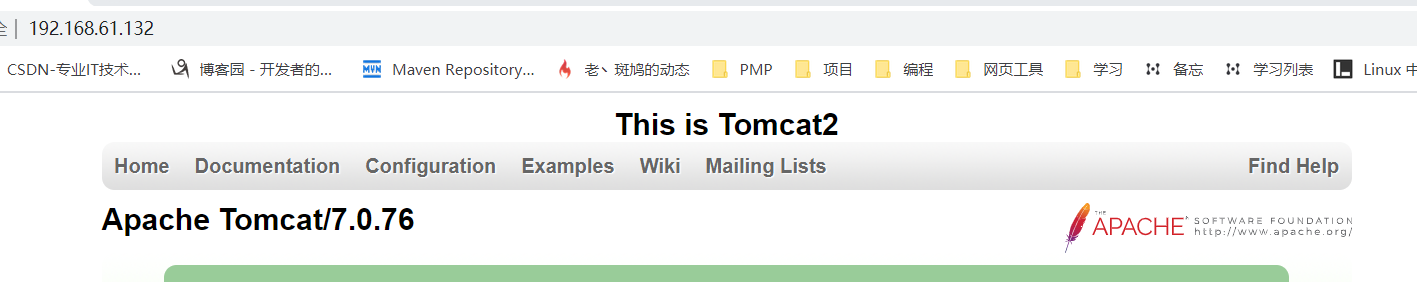

配置nginx-tomcat服务集群

本地另外两台虚拟机分别搭建tomcat服务并启动

- 192.168.61.128:8080

- 192.168.61.129:8080

nginx 配置如下 : 仅展示关键部分

upstream tomcats {server 192.168.61.128:8080;server 192.168.61.129:8080;}server {listen 80;server_name localhost;charset utf-8;location / {proxy_pass http://tomcats;}}

现在我们就能通过虚拟ip 192.168.61.132 访问tomcat提供的服务了。

实现内网环境下 keepalived + nginx + tomcat的高可用web服务集群了。