【推荐】模型解释的书籍

论文思路

主要提出一种新的框架SHAP,通过对现有几种模型解释方法都归结为 Additive Feature Attribution Methods加性特征归因方法,且由 加性特征归因方法的三个良好性质 的结论,在其结合六种现有方法基础上,并对其进行改进,最终得到了无关模型的解释方法 kernel SHAP(Linear LIME + Shapley values) 以及 特定模型的一系列相关算法Linear SHAP、Low-Order SHAP、Max SHAP 、Deep SHAP (DeepLIFT + Shapley values)

。

SHAP支持很多类型的explainer(例如deep, gradient, kernel, linear, tree, sampling)

TreeExplainer :TreeExplainer专为树集合方法开发,如XGBoost,LightGBM或CatBoost。 DeepExplainer :DeepExplainer是为深度学习模型开发的,支持TensorFlow / Keras。 GradientExplainer :GradientExplainer也是为深度学习模型中的SHAP值而开发的,但速度比DeepExplainer慢,并且做出了不同的假设。 此方法基于Integrated Gradient归因方法,并支持TensorFlow / Keras / PyTorch。 KernelExplainer :KernelExplainer使用加权线性回归近似任何类型模型的SHAP值。 使用特定于模型类型的算法(TreeExplainer,DeepExplainer)而不是通用**KernelExplainer**更快更有效。

摘要

通常解释一个模型为什么做出某种预测和模型预测的准确性一样重要。已经有很多方法解释复杂模型的预测,但是这些方法是怎样相关以及一种方法何时优于另一种方法还不清楚,为此提出了一个统一的解释预测的框架。SHAP(SHapley Additive exPlanations). 其功能是为特定的预测分配每个特征的重要性的值。

加性特征归因方法

定义:加性特征归因方法的解释模型是二元变量的线性函数。实际上就是线性归因于数据点的各个特征。

简单属性唯一确定加性特征属性

- Property 1 (Local accuracy)

模型解释所有特征相加的和就是模型预测的结果。

- Property 2 (Missingness)

没有贡献的特征其分配的结果为0

- Property 3 (Consistency)

相同贡献的特征其分配的结果是一样的

Theorem 1 只有一个可能的解释模型g遵循定义1并满足属性1、2和3:Shapley value

SHAP

根据以上性质,对现有算法做改进,比如很多线性可加归因方法并不一定能满足上述三个性质,可以对其进行改进以满足性质1-3。

模型无关的解释方法

Kernel SHAP (Linear LIME + Shapley values)

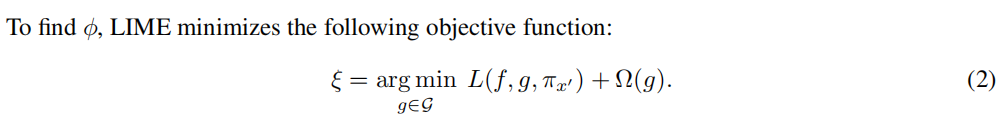

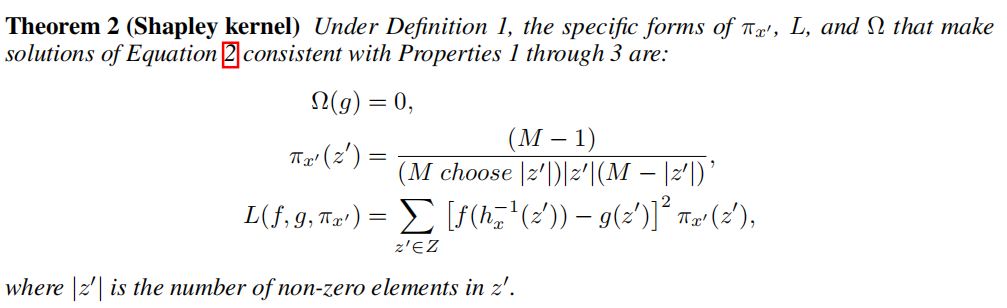

LIME

Theorem 2 (Shapley kernel)

在Theorem 1 下,使方程2的解与性质1到3一致的的具体形式是

暂时更新到这里。

**