1. CNN

1.1 CNN图像识别方向(适用)

卷积网络在计算机视觉上的发展:1989年成功应用于识别手写数字(LeNet)——>2012年扩大卷积网络(取得好效果)——>架构改进用于图像识别更准确(GoogLeNet,VGG,ResNet,DenseNet,挤压和激励)

从LeNet开始,所有这些网络几乎都基于离散卷积

self-attention已在NLP中采用

题目:Exploring Self-attention for Image Recognition

self-attention可以作为图像识别模型的组成部分

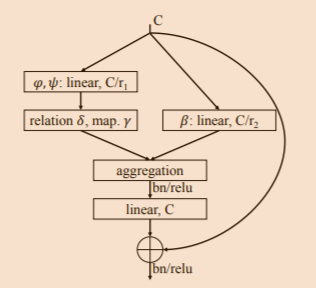

(1)成对的自我注意:集合运算符替代了序列运算符

(2)补丁式自我注意

图像识别的卷积网络中,各层执行:特征聚合+特征变换

1.2 图像识别,对象检测,实例分割和关键点检测(适用)

新进展:为CNN设计更复杂的体系结构以增强其表示学习能力

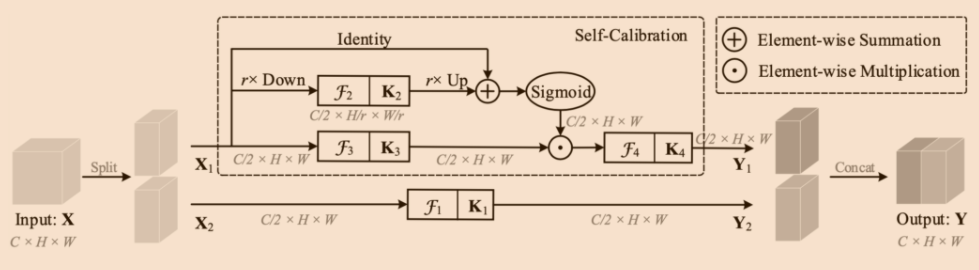

题目:Improving Convolutional Networks with Self-Calibrated Convolutions

本文工作:在不调整模型架构的情况下改进CNN的基本卷积特征转换过程

新方式:自校准卷积——通过内部通信明显地扩展了每个卷积层的眼界,从而丰富了输出特征;区别于使用小核融合空间和通道方向信息的标准卷积,自校准卷积通过自适应地围绕每个空间位置建立了远程空间和通道间依赖关系,可以通过显式合并更丰富的信息来帮助CNN生成更多区分性表示

优点:设计简单,同时能应用于增强标准卷积层,不会引入额外参数和复杂性

在自校准卷积中,原始滤波器分为四个部分,每个部分负责不同的功能。

实验表明将自校准卷积应用于不同的主干时,可以在各种视觉任务中显着改善基线模型,包括图像识别,对象检测,实例分割和关键点检测,而无需更改网络体系结构

1.3 模型性能提升

深度可分离卷积(DSC)

正常卷积核是对3个通道同时做卷积。也就是说,3个通道,在一次卷积后,输出一个数。 深度可分离卷积分为两步:

- 第一步用三个卷积对三个通道分别做卷积,这样在一次卷积后,输出3个数。

- 这输出的三个数,再通过一个1x1x3的卷积核(pointwise核),得到一个数。

这两种卷积是等效的,参考文章Network Decoupling: From Regular to Depthwise Separable Convolutions(https://arxiv.org/abs/1808.05517)

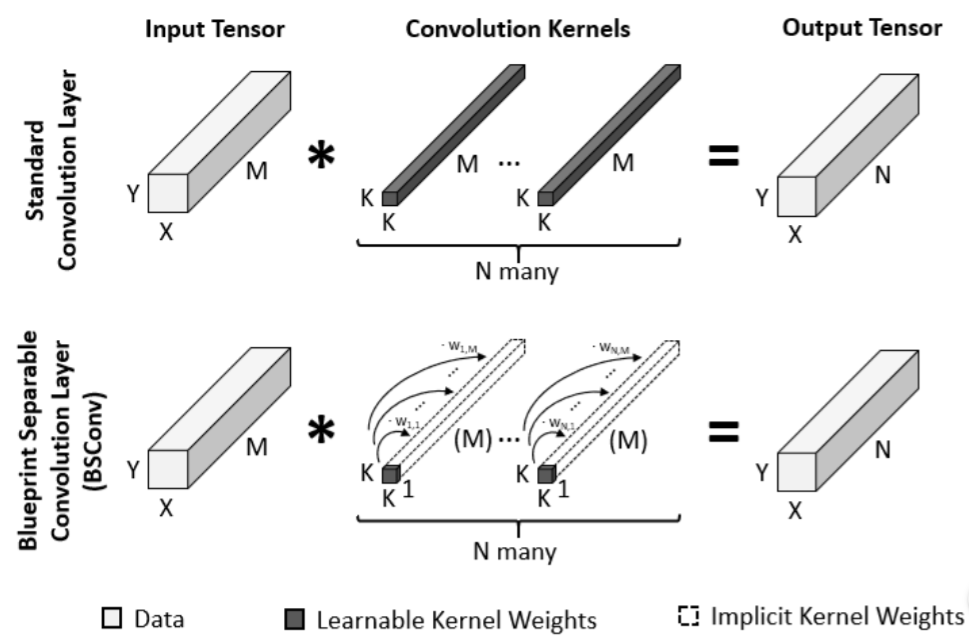

题目:Rethinking Depthwise Separable Convolutions: How Intra-Kernel Correlations Lead to Improved MobileNets

引入蓝图可分离卷积(BSConv)作为CNN的高效构建基块,BSConv使用一个2d蓝图表示每个过滤器内核,该2d蓝图使用权重矢量沿深度轴分布,用CNN内核沿深度轴的相关性。

过去CNN改进是增加模型容量+确保适当的训练行为=>参数大幅增加。

DSC通过利用过滤器权重的冗余性。

DSC和BSC对比,BSC在相同参数和时间复杂度的情况下,在各种大规模和细粒度数据集上始终优于基于DSC的体系结构

使用BSC可以改进已有模型,如mobileNets,MnasNets,efficientNets和ResNets

2. 图像分类

2.1 新深度模型——细粒度的视觉识别

题目:Interpretable and Accurate Fine-grained Recognition via Region Grouping

方法核心:在深度神经网络中基于区域的碎片发现和归属的集成

模型使用图像级对象标签进行训练,并通过对对象部分进行分割并确定其对分类的贡献来对结果进行解释。

可解释的用于细粒度分类的深度模型:该模型学习了对象的局部的字典,基于该字典,可以将2D特征图分组为零碎片段,通过将像素特征与学习字典中的零碎片段进行比较来完成;从结果片段中合并基于区域的特征,然后通过注意力机制选择片段的自己进行分类;每个零碎片段的出现都会强制执行Beta分配,以使其在每个小批量生产中称为二进制

2.2 网络结构——CCNN

题目:Compositional Convolutional Neural Networks: A Deep Architecture with Innate Robustness to Partial Occlusion(组成卷积神经网络:一种对部分遮挡具有先天鲁棒性的深度架构)

在partial occlusion下,深度卷积神经网络(DCNN)不能很好地泛化

采用架构:将组成模型和DCNN集成到具有对部分遮挡固有鲁棒性的统一深度模型中——组成卷积神经网络

3.视频分类

3.1 新网络结构——SmallBig网络

题目:SmallBigNet: Integrating Core and Contextual Views for Video Classification(SmallBigNet:集成 核心视图和语境(上下文)视图 进行视频分类)

视频分类方法:时间卷积

该方法的缺点:在时空上下文中以有限的视角执行的,这通常会削弱其学习视频表示的能力。

解决办法:提出了一个新型的SmallBig网络,并结合了小的和大的视图,小视图分支用于学习核心语义,而大视图分支用于捕获上下文语义。

额外考虑:小视图和大视图分支中共享卷积,提高模型的紧凑型并减轻过拟合

结果:SmallBigNet达到流量类似2D CNN的模型尺寸,提高了3D CNN的准确性

4. 目标检测

4.1 分类器

题目:Overcoming Classifier Imbalance for Long-tail Object Detection with Balanced Group Softmax(通过平衡组softmax克服用于长尾物体检测的分类器不平衡)

长尾物体检测的一种直接解决方案是直接在长尾训练数据上训练一个完善的检测模型

长尾检测性能差的直接原因:将检测框架中的表示和分类模块解耦,发现与不同类别相对应的提议分类器的权重准则严重失衡,因为低风险类别几乎没有机会被激活。

长尾检测性能差的根本原因:数据不平衡

方法:提出了一种新型的平衡组softmax(BAGS)模块;用于通过逐组训练来平衡检测框架内的分类器。它隐式地调整了头级和尾级的训练过程,并确保它们都得到了充分的训练,而无需对尾级的实例进行任何额外采样。

4.2 改进FPN金字塔模型

题目:AugFPN: Improving Multi-scale Feature Learning for Object Detection(AugFPN:改进用于对象检测的多尺度特征学习)

检测不同比例的物体方法:利用特征金字塔作为检测器;eg:FPN

推出AugFPN来弥补FPN中的设计缺陷

AugFPN组成部分:

(1)一致性监督:通过一致性监督,在特征融合之前缩小了不同尺度特征之间的语义鸿沟

(2)残差特征增强:特征融合中,通过残差特征增强提取比率不变的上下文信息,以减少最高金字塔级别的特征图的信息丢失

(3)软Rol选择:特征融合后,采用软Rol选择来自适应地学习更好的Rol特征

4.3 减少噪声——提出新框架

题目:Noise-Aware Fully Webly Supervised Object Detection(感知噪声的完全网络监控对象检测)

方法:提出了一个端到端框架,以共同学习网络监督的检测器并减少嘈杂标签的负面影响

噪声种类:背景噪声、前景噪声

对于背景噪声。提出了一种结合了弱监督检测的残差学习结构,此结构分解了背景噪声并为干净数据建模……

对于前景噪声,引入了套袋混合学习,抑制了来自错误标记图像的前景噪声信号,保持训练数据多样性

4.4 改进检测器

题目:Learning a Unified Sample Weighting Network for Object Detection(学习用于对象检测的统一样本加权网络)

方法:设计一个通用损失函数+提出了一个统一的样本加权网络用语预测样本的任务权重

5.目标跟踪

5.1 新的框架——SiamCAR框架

题目:SiamCAR: Siamese Fully Convolutional Classification and Regression for Visual Tracking(SiamCAR:用于视觉跟踪的连体全卷积分类和回归)

通过将视觉跟踪任务分解为:该像素的像素类别分类+该像素处对象边界框回归——>全卷积连体网络(以逐像素的方式解决端到端的视觉跟踪问题)

SiamCAR框架包含两个子网:用于特征提取的siamese子网+用于边界框预测的分类回归子网

优点:没有锚点,避免锚的棘手的超参数调整,减少了人工干预

5.2 新型跟踪器——D3C

题目:D3S — A Discriminative Single Shot Segmentation Tracker(D3S-区分性单发细分跟踪器)

目前主要的跟踪范例:基于模板的判别式跟踪器——缺点:定位精度不高

D3C——缩小了视觉对象跟踪和视频对象分段之间的差距

(1)无需按数据集进行微调,并且仅针对分段进行训练作为主要输出

(2)单发网络应用两个具有互补几何特性的目标模型,一个对广泛的变换(包括非刚性变形)是不变的,另一个假定刚性对象同时实现高鲁棒性和在线目标分割

5.3 设计跟踪模型——ROAM

题目:ROAM: Recurrently Optimizing Tracking Model(ROAM:反复优化跟踪模型)

跟踪模型:由响应生成和边界框回归组成;

第一个组件产生一个热图,以指示存在于不同位置的物体,第二部分将相对边界框偏移回归到安装在滑动窗口位置的锚点;两个组件都使用了可调整大小的卷积滤波器来适应对象的形状变化;

离线训练递归神经优化器以在神经元学习设置中更新跟踪模型,在几个梯度步骤中使模型收敛,提高更新跟踪模型的收敛速度

优点:不需要枚举大小不同的锚,从而节省了模型参数

跟踪器ROAM和ROAM++

测试环境:OTB、VOT、LaSOT、GOT-10K和Tracking

5.4 将Siam R-CNN连体式重新检测体系结构和基于轨迹的动态编程算法相结合

题目:Siam R-CNN: Visual Tracking by Re-Detection(Siam R-CNN:通过重新检测进行视觉跟踪)

Siam R-CNN:一种连体式重新检测体系结构,可释放用于视觉对象跟踪的两阶段对象检测方法的全部功能

将Siam R-CNN与新颖的基于轨迹的动态编程算法相结合,利用对第一帧模板和先前帧预测的重新检测优势, 对要跟踪的对象和潜在的干扰对象 的完整来历进行建模

提出一种新颖的硬示例挖掘策略以提高Siam R-CNN对相似对象的鲁棒性

5.5 欺骗跟踪器技术

题目:Cooling-Shrinking Attack: Blinding the Tracker with Imperceptible Noises(冷却收缩攻击:使跟踪器致盲并发出难以察觉的噪音)

方法:提出一种冷却收缩攻击方法来欺骗以及SiameseRPN的最新跟踪器

过程:使用精心设计的对抗损失,训练了有效而高效的扰动生成器,同时冷却热图中目标存在的高温区域,并迫使预测的边界框缩小从而使跟踪器看不到跟踪的目标

5.6 新元更新器嵌入长期跟踪框架中

题目:High-Performance Long-Term Tracking with Meta-Updater(使用Meta-Updater进行高性能的长期跟踪)

目前形势:大多数排名靠前的长期跟踪器均采用离线训练的连体体系结构;缺点:无法从在线更新的短期跟踪器的大进步中受益

提出一种新的离线训练元更新程序——解决的问题:跟踪器是否准备好在当前帧中进行更新

功能:本次元更新器可以按顺序有效地集成几何,判别和外观提示,然后使用设计的级联LSTM模块挖掘顺序信息;元更新器学习二进制输出以指导跟踪器的更新

新长期跟踪框架:由在线本地跟踪器、在线验证器、基于SiamRPN的重新检测器和我们的元更新器组成

测试环境:VOT2018LT,VOT2019LT,OxUvALT,TLP和LaSOT基准测试中

5.7 正则化项的改变

题目:AutoTrack: Towards High-Performance Visual Tracking for UAV with Automatic Spatio-Temporal Regularization(自动跟踪:通过自动时空正则化实现对无人机的高性能视觉跟踪)

方法:自动在线适应地学习时空正则化项;引入空间局部响应图变化作为空间正则化

目前形势:大多数基于判别相关滤波器(DCF)的跟踪器都试图引入预定义的正则化项来改善目标对象的学习;例图通过抑制背景学习或者限制相关滤波器的变化率。这些会花费很多精力

5.8 提出新模型公式

题目:Probabilistic Regression for Visual Tracking(视觉跟踪的概率回归)

解决问题:当前的主要范例依赖于估计与状态有关的置信度得分,缺乏概率上的解释

办法:提出概率回归公式,应用于跟踪;网络会根据输入图像预测目标状态的条件概率密度,还能对由于任务中不正确的注释和歧义而产生的标签噪声进行建模,通过最小化Kullback-Leibler散度来训练回归网络。

5.9 新跟踪器模型

题目:MAST: A Memory-Augmented Self-supervised Tracker(MAST:具有记忆增强功能的自我监督跟踪器)

问题:自监督密集跟踪性能还不及监督方法

办法:提出一种在视频上训练的,没有任何注释的密集跟踪模型;该方法性能和监督方法相当

实验方法:

(1)先进行彻底的实验,从而重新评估用于自我监督训练和重建损失的传统选择,最终阐明最佳选择

(2)使用关键的内存组件 扩展自己的体系结构 以进一步改进现有方法

(3)以大规模的半监督视频对象分割(也叫密集跟踪)为基准,提出新指标——可概括性

(1)+(2)=>自我监督的网络

5.10 新视觉跟踪框架

题目:Siamese Box Adaptive Network for Visual Tracking(用于视觉跟踪的连体盒自适应网络)

问题:现有的跟踪器多依赖于多尺度搜索方案或预定义的锚框来准确估算目标的尺度和纵横比,不足之处是通常要求乏味并且启发式的配置

办法:利用完全卷积网络(FCN)的表达能力,提出一个简单而有效的视觉跟踪框架SiamBAN;SiamBAN将视觉跟踪问题视为并行分类和回归问题,在同一的FCN中直接对对象进行分类并将其边界框回归

优势:无先例盒设计避免了与候选盒相关的超参数,使得SiamBAN更灵活通用

实验基准:VOT2018,VOT2019,OTB100,NFS,UAV123和LaSOT

5.11 新数据集的提出——多目标跟踪

题目:3D-ZeF: A 3D Zebrafish Tracking Benchmark Dataset(3D-ZeF:3D斑马鱼跟踪基准数据集)

方法:提出一个复杂度评分和用于斑马鱼3D跟踪的新型开源模块化基线系统

6. 语义分割

6.1 新方法—傅里叶域自适应

题目:FDA: Fourier Domain Adaptation for Semantic Segmentation(FDA:用于语义分割的傅里叶域自适应)

问题:最新方法过于复杂化

办法:采用简单的傅里叶变换及其逆运算

6.2 新方法—super-BPD

题目:Super-BPD: Super Boundary-to-Pixel Direction for Fast Image Segmentation(Super-BPD:超级 边界到像素 方向,用于快速图像分割)

方法:提出一种基于新型超边界像素方向的快速图像分割方法+基于超边界像素方向的定制分割算法;将每个像素上的BPD定义为从其最近边界指向像素的二维单位向量。在BPD中,来自不同区域的附近像素具有彼此相反的方向,并且同一区域中的相邻像素具有彼此指向的方向(即在中间点附近)。我们利用这种特性将图像划分为超级BPD。

6.3 新训练模型

题目:Single-Stage Semantic Segmentation from Image Labels(图像标签的单阶段语义分割)

问题:新方法提高了在弱监督环境下提高语义分割的准确性能力,但是以增加复杂性和复杂的多阶段训练程序作为代价的;

弱监督方法的三个理想属性:局部一致性、语义保真度、完整性

办法:以三个理想属性为指导,开发基于分段的网络模型和自我监督的训练方案,以在单个阶段中训练来自图像级别注释的语义蒙版。

6.4 分割前后的处理方式

题目:Learning Texture Invariant Representation for Domain Adaptation of Semantic Segmentation(为语义分割的领域匹配学习纹理不变表示法)

问题:为语义分割注释像素级标签很费力

解决方案:利用合成数据

新问题:合成域和真实域之间有域差距,使用合成数据训练的模型推广到真实数据具有挑战性

办法:考虑到两个域之间的基本差异作为纹理,提出一种适应目标域纹理的方法

流程:首先使用样式转移算法使合成图像的纹理多样化;生成的图像的各种纹理可防止分割模型过度适合一种特定的合成纹理;然后通过自我训练对模型进行微调,以直接监督目标纹理

6.5 新合成数据集——对分类法和注释进行操作

题目:MSeg: A Composite Dataset for Multi-domain Semantic Segmentation(MSeg:用于多域语义分割的复合数据集)

MSeg(一种组合数据集):一个可以统一来自不同领域的语义细分数据集

调和分类法和注释操作并带来像素级,重新标记多个注释来对齐图像的对象蒙版,组合的数据集可训练单个语义细分模型

6.6 基于新分割方法的某网络结构

题目:CascadePSP: Toward Class-Agnostic and Very High-Resolution Segmentation via Global and Local Refinement(CascadePSP:通过全局和局部优化实现与类无关和非常高分辨率的细分)

问题:先进的语义分割方法只针对固定分辨率范围内的图像进行训练,这对于高分辨率图像是不够准确的

解决方案:提出一种无需使用任何高分辨率训练数据即可解决高分辨率分割问题的方法,使用CascadePSP网络,该网络会完善和纠正局部边界

6.7 对CNN方法的改进

题目:Unsupervised Intra-domain Adaptation for Semantic Segmentation through Self-Supervision(通过自我监督实现语义分割的无监督域内适应)

问题1:基于卷积神经网络的方法在语义分割方面严重依赖劳动密集型的带注释数据

解决方案1:把从图形引擎生成的自动注释数据用于训练分割模型

问题2:从合成数据训练的模型很难转换为真实图像

方案2:考虑将模型从源数据直接适配到未标记的目标数据以减少域间差距

方案2的局限性:未考虑目标数据本身之间的较大分配差距(域内差距)

方案3:提出了两步自监督域自适应方法以最小化域间和域内的间隙

方案3的流程:首先进行模型的域间适配,使用基于熵的排名功能将目标划分为容易和困难;为减少域内间隙,从易分割到硬分割采用自监督自适应技术

6.8 基于CAM的改进

题目:Self-supervised Equivariant Attention Mechanism for Weakly Supervised Semantic Segmentation(自监督等变注意机制用于弱监督语义分割)

大问题:图像级弱监督语义分割

解决方案1:类激活图(CAM)

方案1的局限性:由于全面监督与弱监督之间的差距,CAMs几乎不能用作目标遮挡

本文解决方案(1)+(2)结合:

(1)提出一种自我监督的等变注意机制(SEAM);等方差是完全监督语义分割中的隐式约束,在数据扩充过程中,其像素级标签的空间变换与输入图像的空间变换相同。但是,这种约束在通过图像级监督训练的CAM上丢失了。因此对来自各种变换图像的预测CAM进行一致性正则化

(2)提出了一种像素相关模块(PCM),该模块利用上下文外观信息并通过其相似邻居细化当前像素的预测,从而进一步提高CAM的一致性

测试数据集:PASCAL VOC 2012

6.9 新网络结构——TDNet

题目:Temporally Distributed Networks for Fast Video Segmentation(临时分布式网络用于快速视频语义分割)

提出一个为快速准确地进行视频语义分割而设计的临时分布式网络——TDNet.

(1)通过组合从几个较浅的子网提取的特征来近似从深层CNN的某个高级层提取的特征;

(2)利用视频中固有的时间连续性,将这些子网分布在顺序的帧上;

(3)在每个时间步骤执行轻量级计算即可从单个子网中提取子功能组。

(4)然后,通过应用新颖的注意力传播模块来补偿用于分割的全部特征,该模块可以补偿帧之间的几何变形;

(5)还引入了分组知识蒸馏损失以进一步提高完整功能和子功能级别的表示能力。

6.10 改进上下文相关性方法

题目:Context Prior for Scene Segmentation(上下文优先用于场景分割)

好的上下文相关性能更准确的分割结果

问题:大多数方法很少区分不同类型的上下文依赖项

本文方法:直接监督特征聚合以清楚地区分类内和类间上下文;

(1)在亲和度损失的监督下开发上下文先验。

(2)给定输入图像和相应的基本事实,“亲和力损失”将构建理想的亲和力图来监督上下文先验的学习。

(3)所学习的上下文先验提取属于同一类别的像素,而相反的先验则专注于不同类别的像素;

(4)嵌入到传统的深层CNN中,提议的上下文先验层可以有选择地捕获类内和类间上下文相关性,从而实现健壮的特征表示。

6.11 空间池改进

题目:Strip Pooling: Rethinking Spatial Pooling for Scene Parsing(条带化池:重新考虑空间池以进行场景解析)

空间池作用:在捕获用于场景分析等像素级预测任务的远程上下文信息方面非常有效

方法:引入条带化池策略来重新考虑空间池化的公式

空间池化体系结构:

(1)引入一个新的条带池化模块,该模块使骨干网络能够有效地建模远程依赖关系

(2)提出一种以各种空间池化为核心的新颖构建基块

(3)系统地比较了建议的条带池和常规空间池技术的性能。两种新颖的基于池的设计都是轻量级的,并且可以在现有场景解析网络中用作有效的即插即用模块

6.12 针对城市场景的语义分割方法改进

题目:Cars Can’t Fly up in the Sky: Improving Urban-Scene Segmentation via Height-driven Attention Networks(汽车无法飞上蓝天:通过高度驱动的注意力网络改善城市场景分割)

方法:利用了城市场景图像的内在特征,并提出了一个通用的附加模块,称为高度驱动的注意力网络(HANet),用于改善城市场景图像的语义分割;根据像素的垂直位置选择性地强调信息性特征或类

6.13 分割新方式

题目:Learning Dynamic Routing for Semantic Segmentation(学习用于语义分割的动态路由)

老方法:在预定义的静态体系结构中处理各种规模的输入

新方法:动态路由——在概念上减轻语义表示中尺度差异的新方法。

提出的框架生成依赖于数据的路由,以适应每个图像的比例分布。

提出一种称为软条件门的可微分门控功能,以动态选择比例变换路径