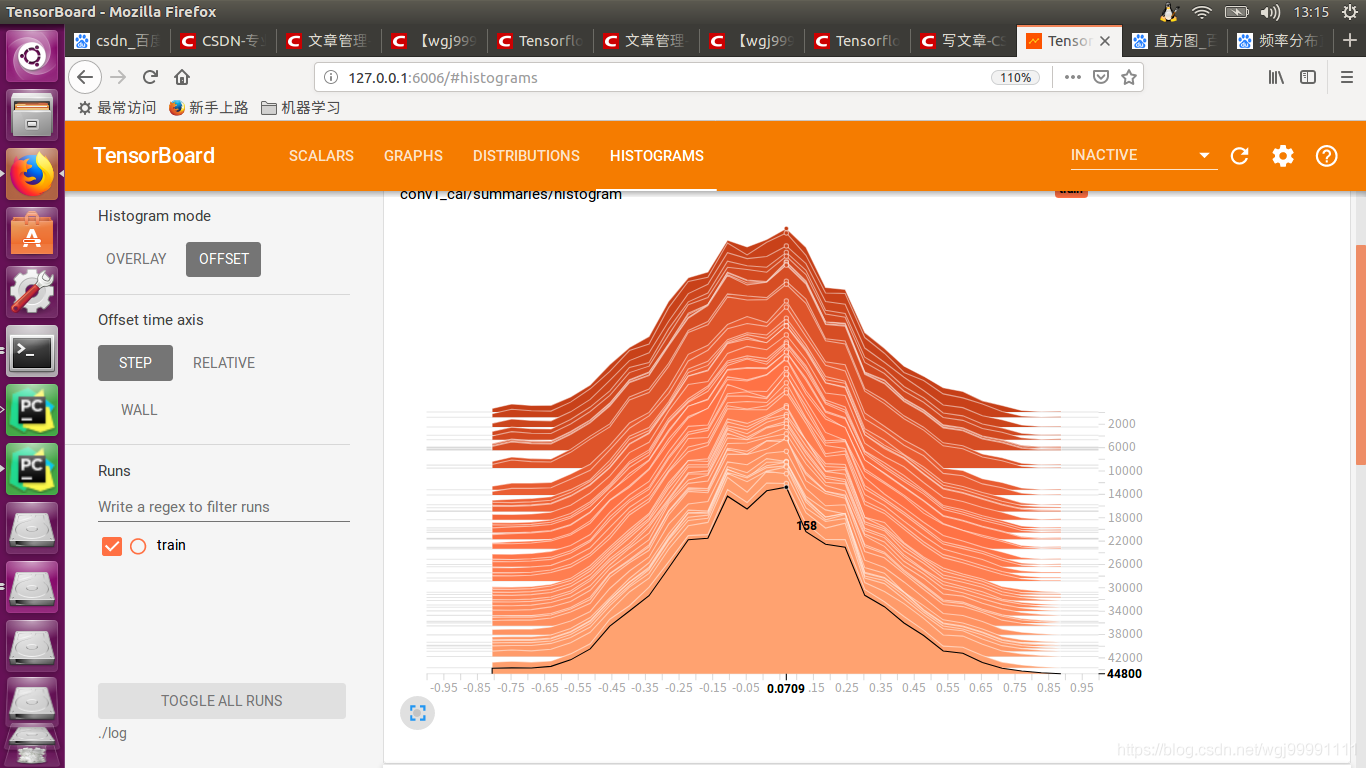

Histogram

图中,横坐标是权重值,纵坐标是训练次数,从远到近,随着颜色的变浅,表示训练次数逐步增加。举例来说,如图中的黑线,表示最近的一次训练,权重为0.0709的有158个。

解析这张图,权重分布随着迭代次数没有明显变化,所以训练其实并没有发挥作用?

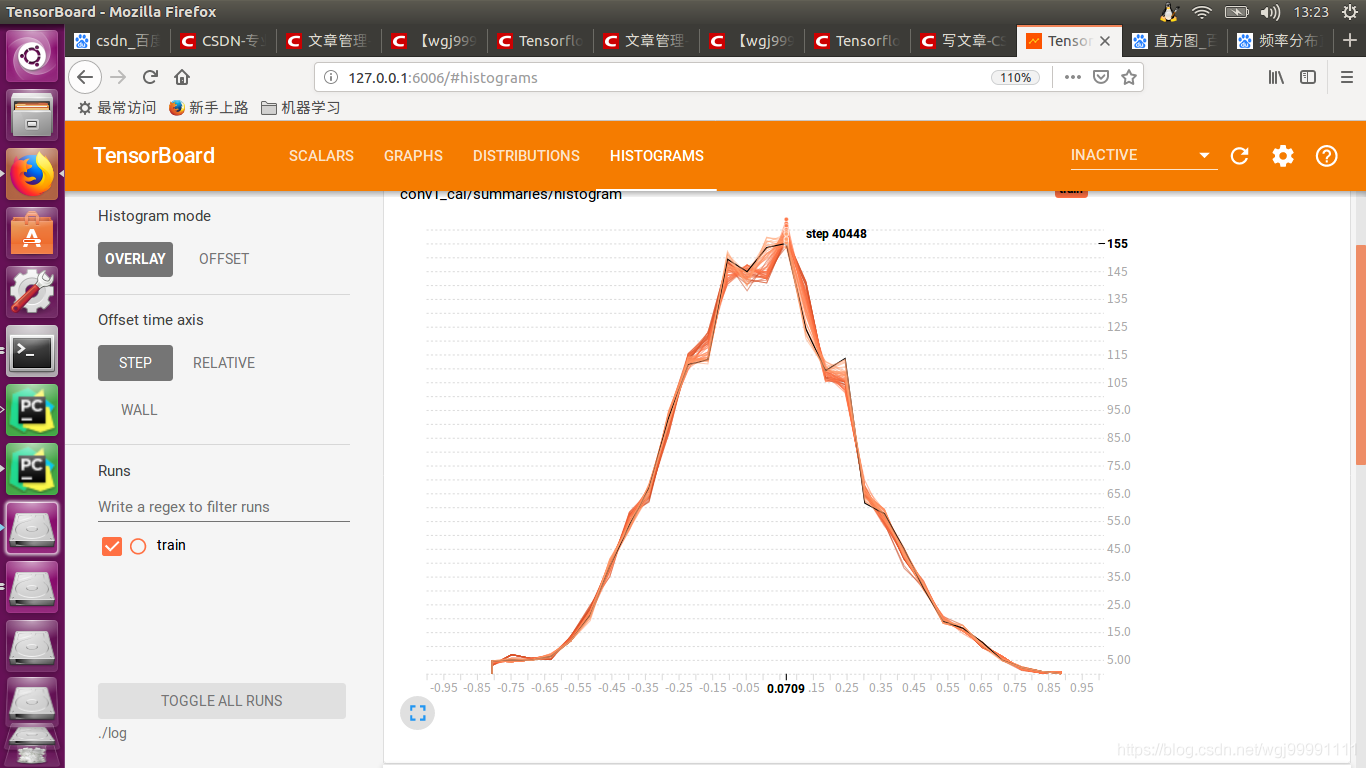

图中横坐标表示权重,纵坐标表示出现次数,中间的曲线是不同训练次数叠加的显示,以其中一条黑线为例,表示第40448次训练时,权重为0.0709的变量有155个(或者说0.0709出现了155次,我觉得两种说法在这种情况下是一致的)。

tensorborad看什么?

- 监测Loss, 和test result以及各种有意义的中间层输出

- 使用sigmoid或者tanh作为激活函数的网络(e.g. LSTM, GRU)需要监测Hidden Layer看看网络输出有没有过饱和(saturation), 算法出问题的时候经常用, 一般用tf.summary.histogram

- 使用Relu作为激发函数监测Hidden Layer看多少神经元输出是0挂掉了,也是用histogram (所以现在有些人用elu或者leakyrelu来防止神经元挂掉)。

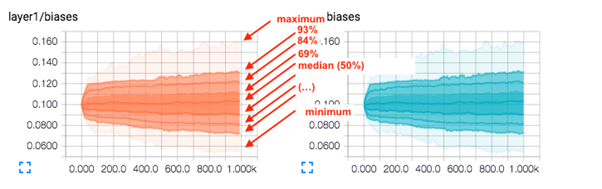

- 监测网络的weight和bias, 看看是否普遍过大, 来确定weight regularizer 有没有生效, 参数过大会影响神经网络的稳定性.