在写Spark Job的过程中往往会有第三方的依赖,如果是在IDE里开发,我们可以在pom.xml里添加依赖,那么在Zeppelin里如何添加第三方依赖呢?主要有以下三种方法 (其实这三个配置都是标准的spark配置选项)

- spark.jars

- spark.jars.packages

- spark.files

spark.jars

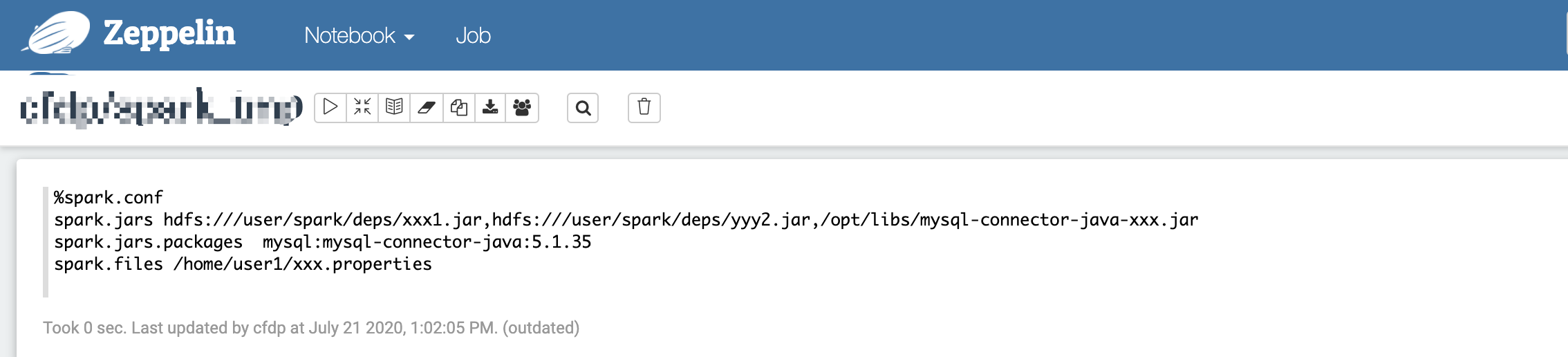

spark.jars 可以用来指定 jar文件,多个jar包可以用逗号隔开,如下图示例

spark.jars.packages

spark.jars.packages 可以用package的形式来指定依赖包,spark会动态下载这些package,然后放到classpath里,多个package以逗号分隔,如下图示例

spark.files

spark.files 用来指定 file文件,多个file文件以逗号分隔,如下图示例

使用方式

- 如上图所示做好配置之后,在启动spark解释器之前(即第一次运行spark、pyspark、sparkR或者sparkSQL相关代码之前)运行spark.conf段落即可对将要启动的spark解释器进行配置,从而加载自己想要依赖的第三方资源

- 另外这些配置也支持通过管理员在Spark解释器配置页面进行全局配置