1.客户端准备

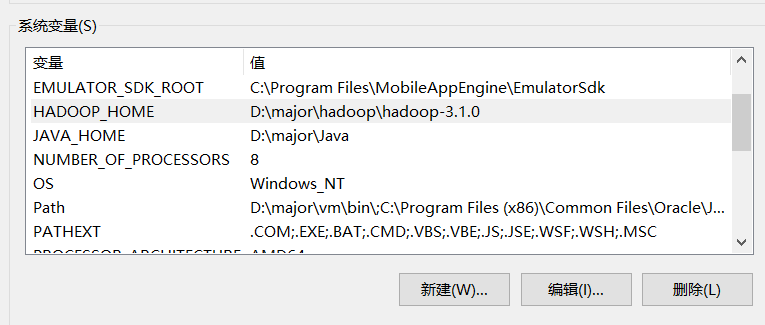

- 下载hadoop-3.1.0到指定路径。

- 配置环境变量

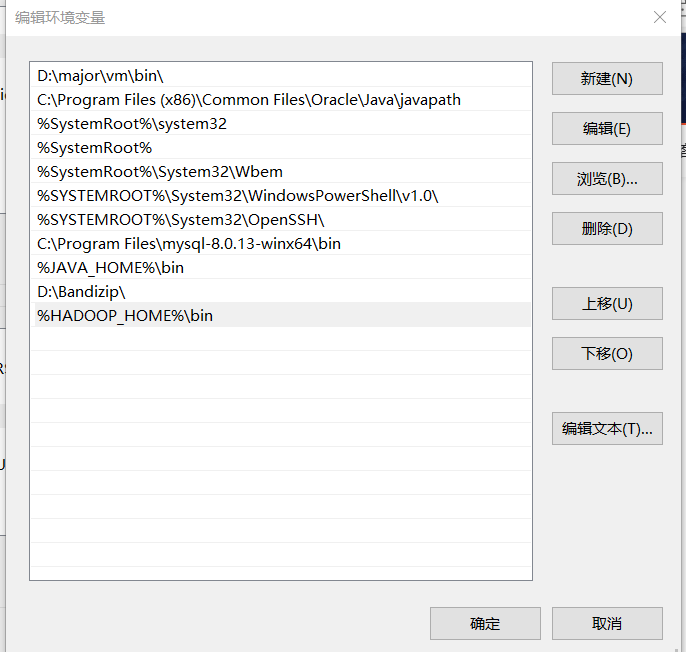

- 配置Path环境变量

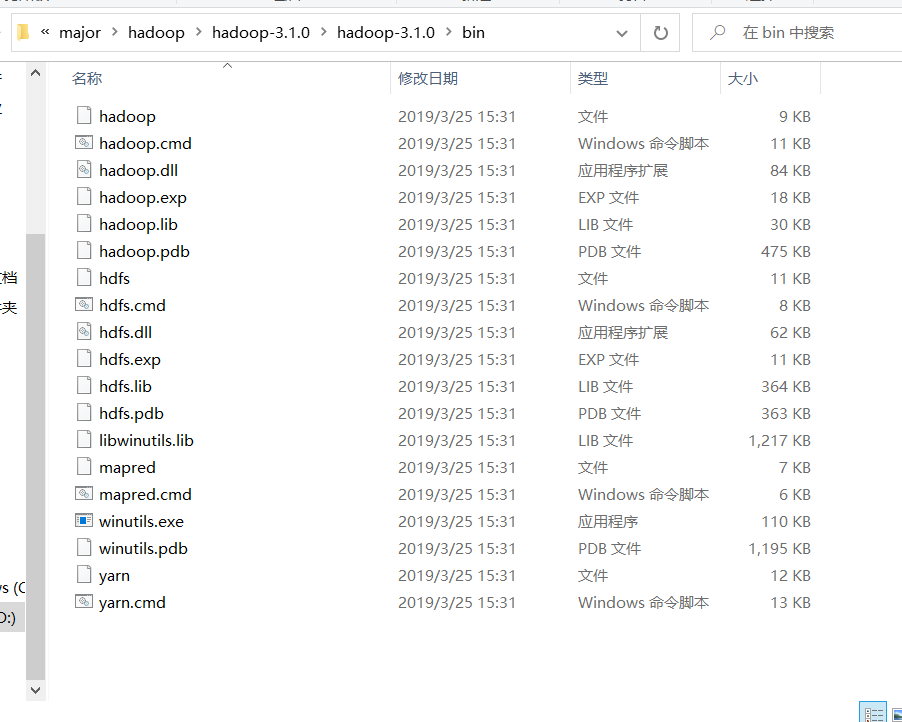

- 验证Hadoop环境变量是否正常。双击winutils.exe,如果报错误。说明缺少微软运行库,安装微软运行库即可。

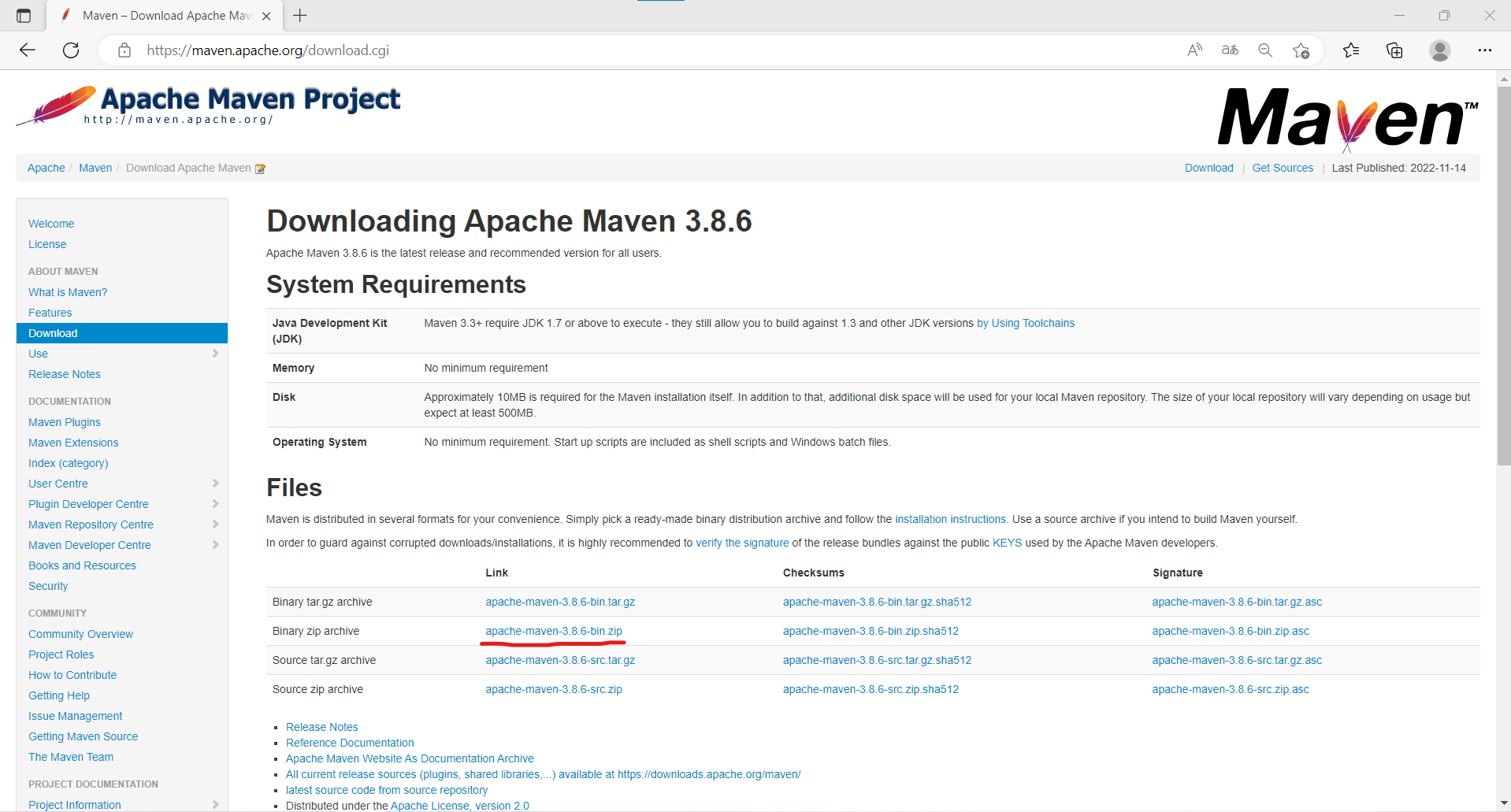

- 安装配置Maven 下载地址:https://maven.apache.org/download.cgi

- 下载

- 安装

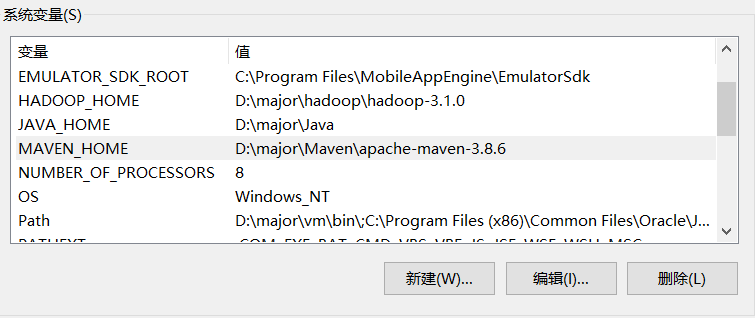

添加环境变量

a.复制安装路径:D:\major\Maven\apache-maven-3.8.6

b.添加系统环境变量

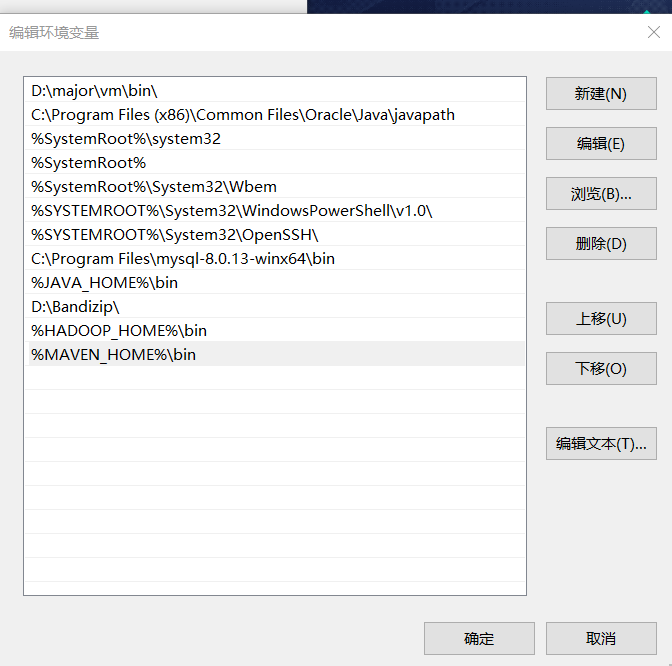

c.点击Path编辑环境变量

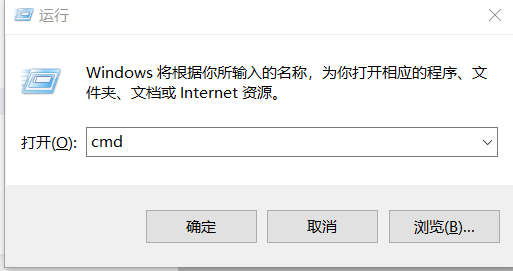

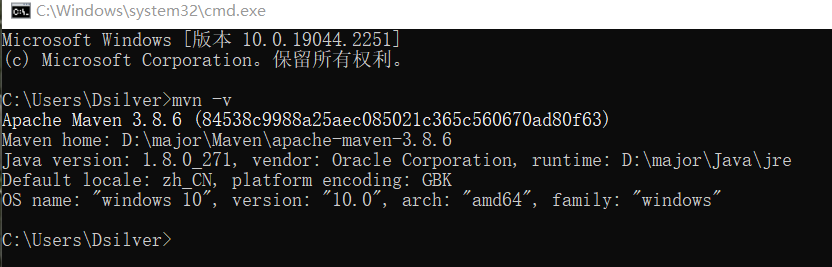

d.测试安装效果:使用win+r键,在运行窗口中输入cmd,单击”确定”。在弹出的窗口中输入:mvn -v命令,返回如图结果表示安装完成。

- 修改配置文件

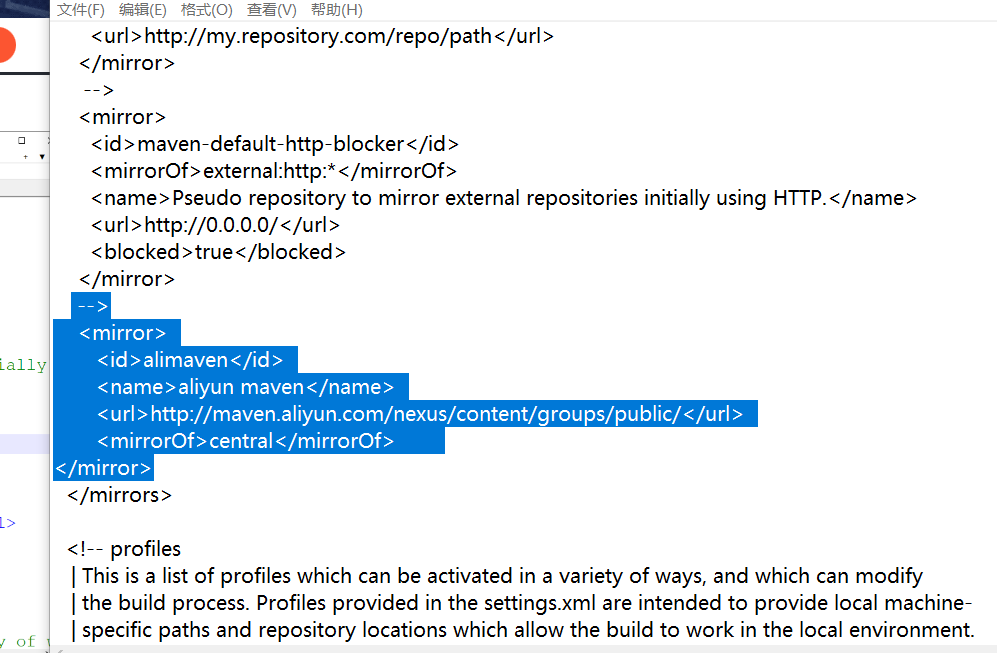

a.修改Maven的下载镜像地址

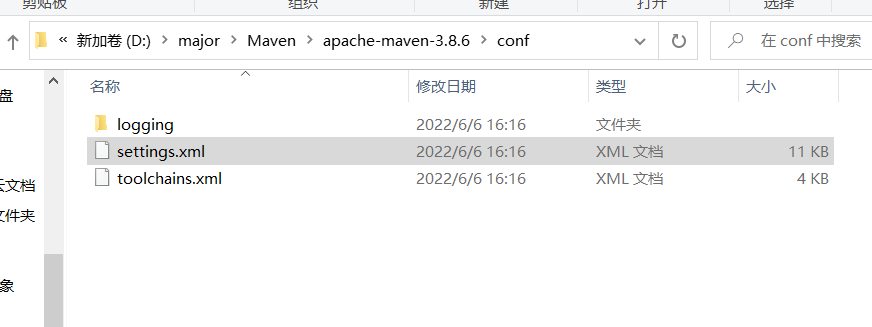

在conf文件夹中找到settings.xml文件,使用记事本打开。

alimaven

aliyun maven

http://maven.aliyun.com/nexus/content/groups/public/

central

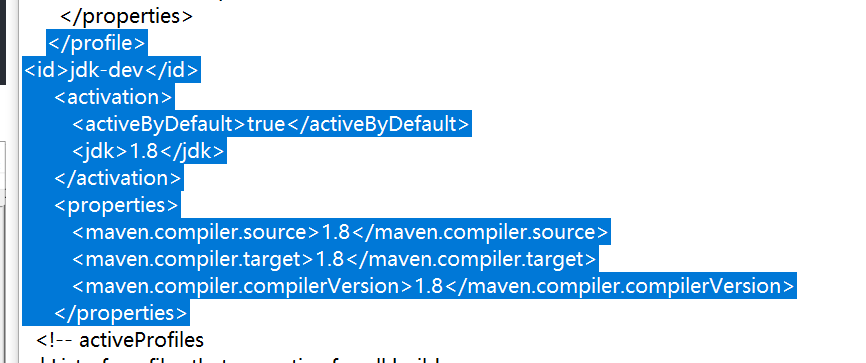

b.配置maven编译环境

找到jdk-dev true 1.8 1.8 1.8 1.8

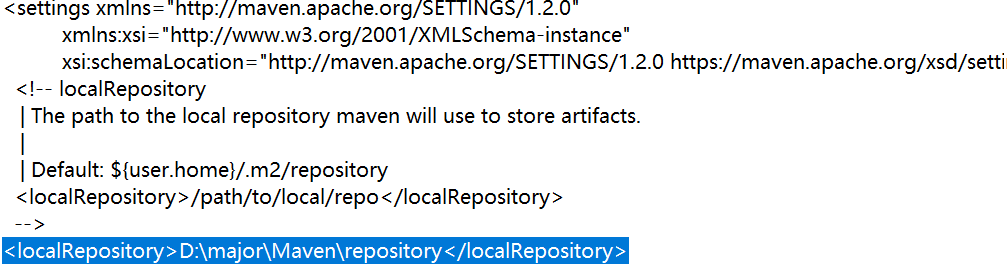

c.配置本地仓库路径

D:/major/Maven/repository

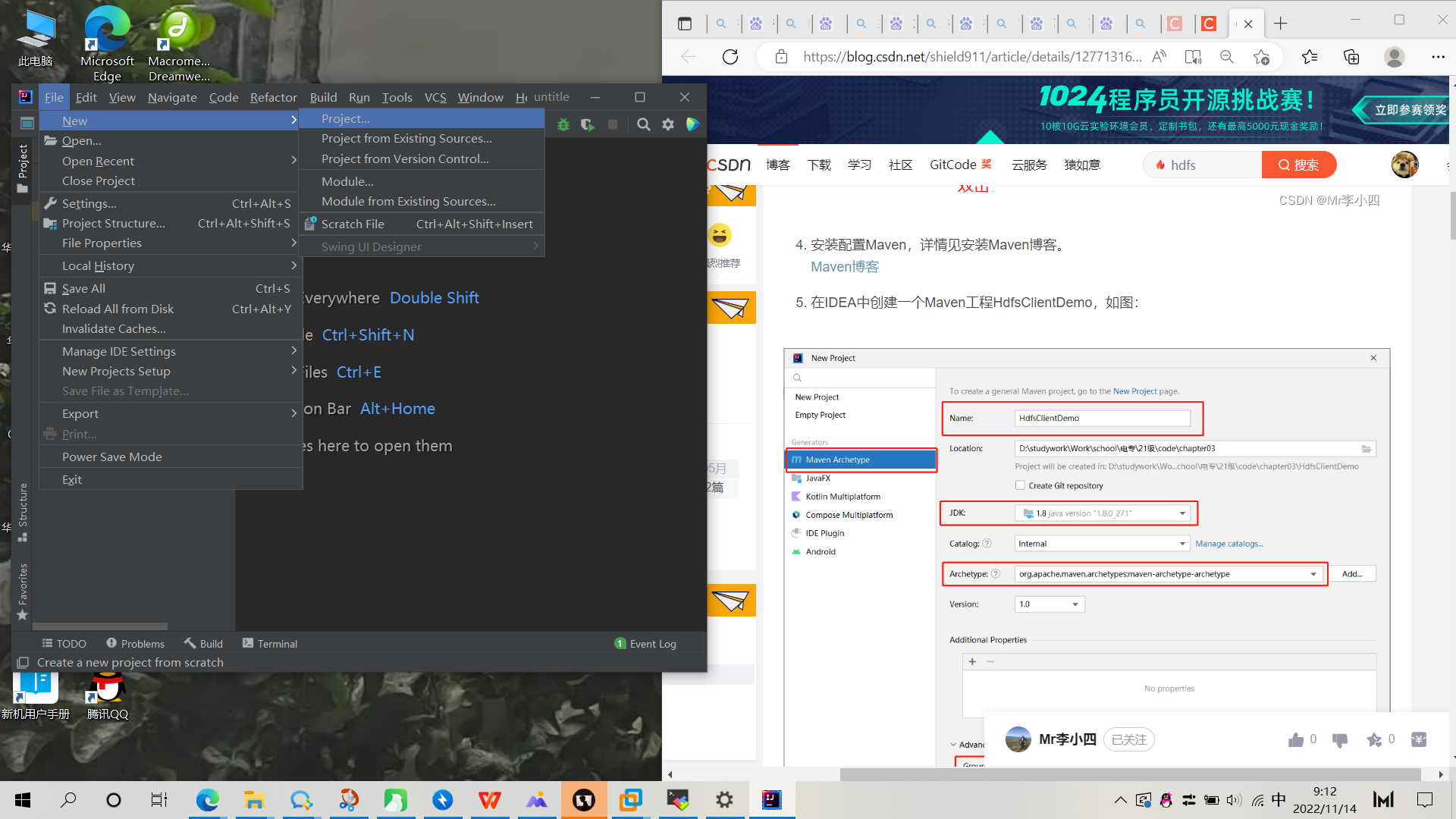

- 在IDEA中配置Maven环境

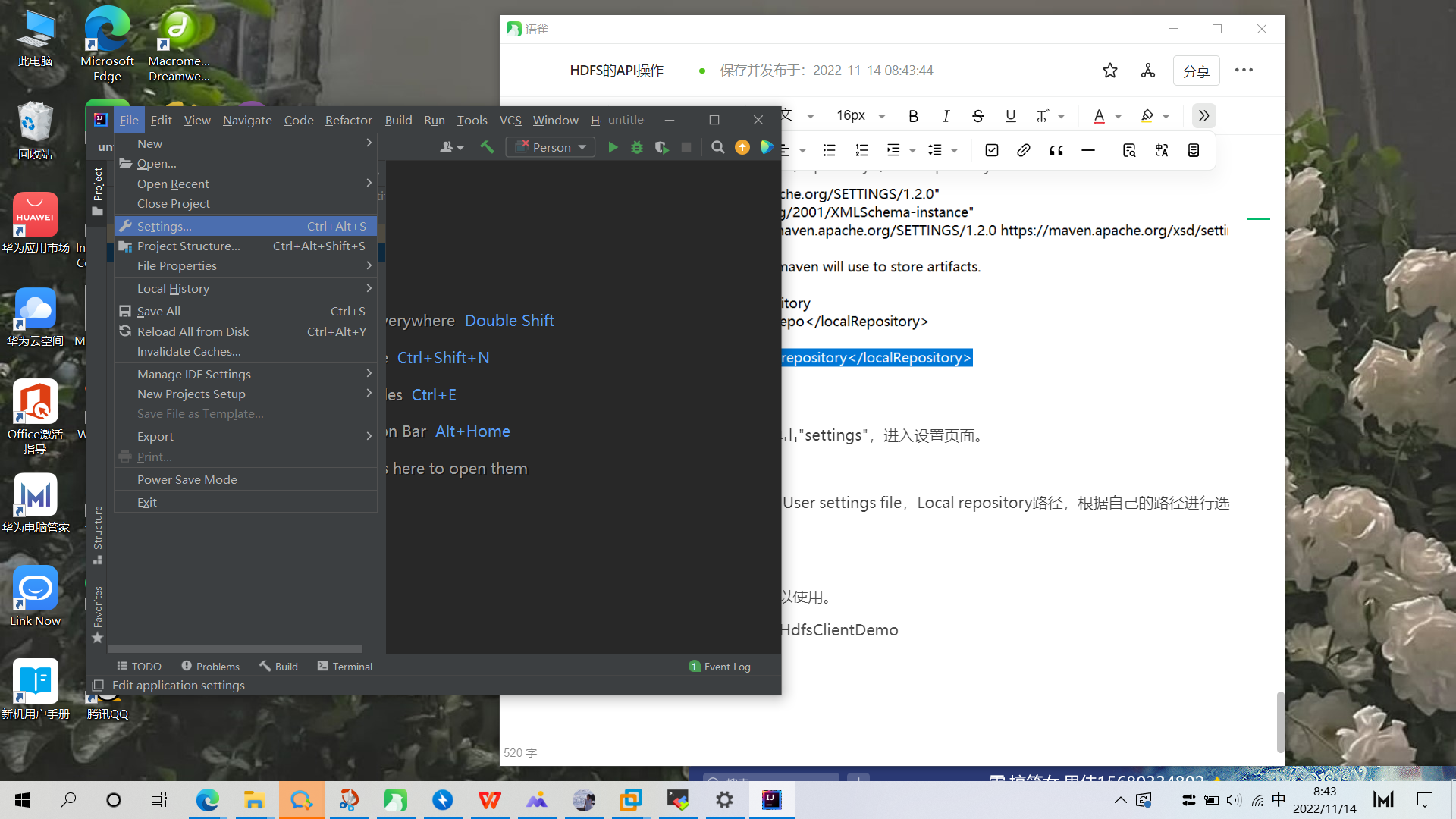

a.打开IDEA编辑器,单击”File”,单击”settings”,进入设置页面。

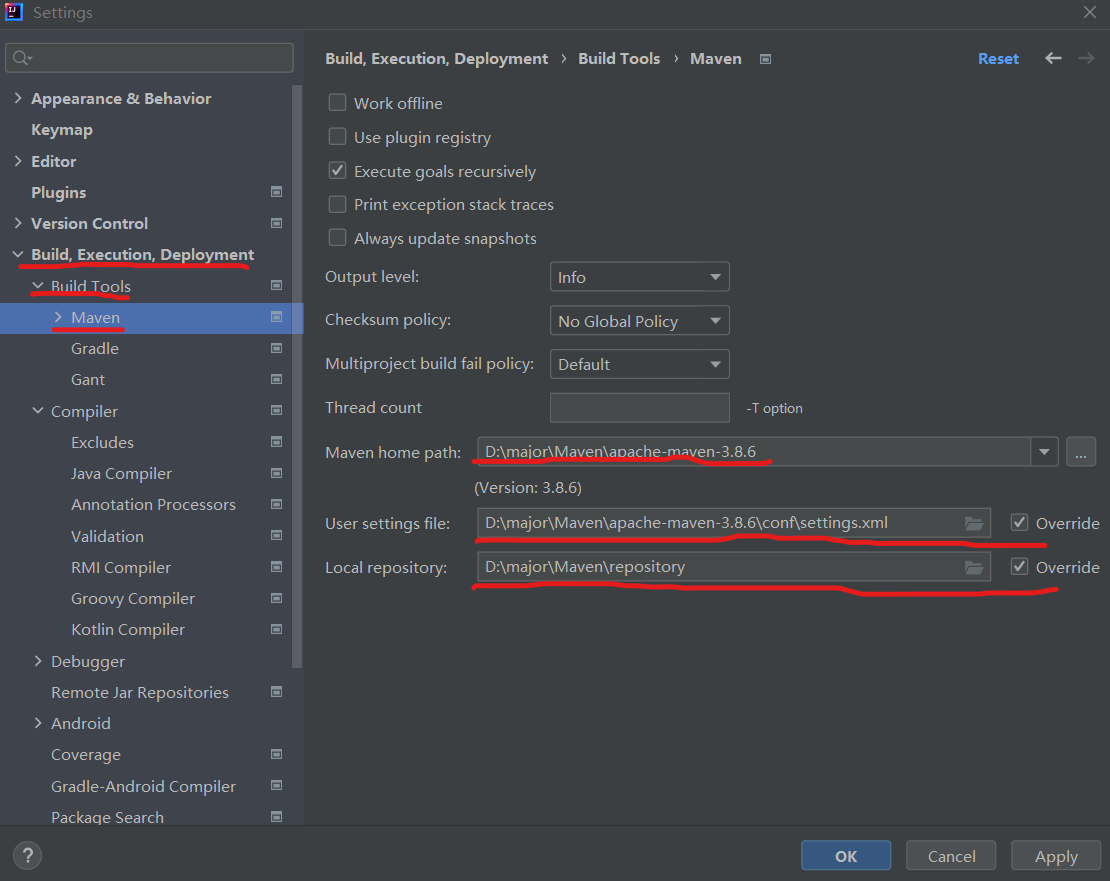

b.分别配置:Maven home path,User settings file,Local repository路径,根据自己的路径进行选择,然后单击”确定”,完成配置。

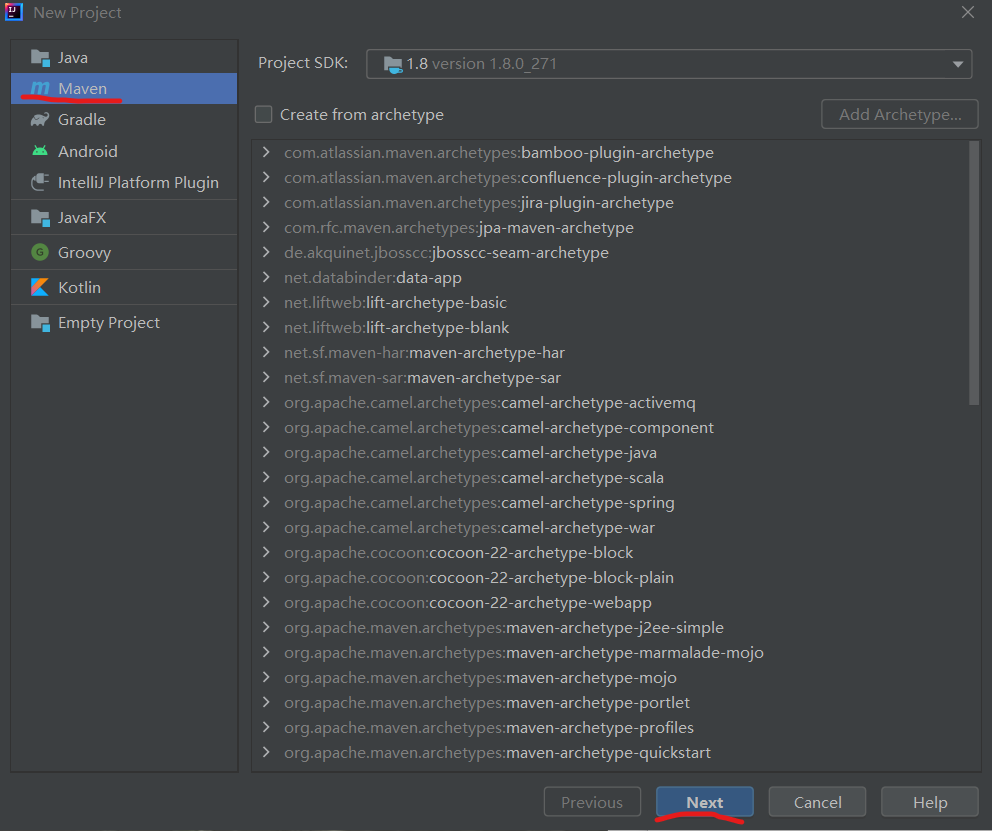

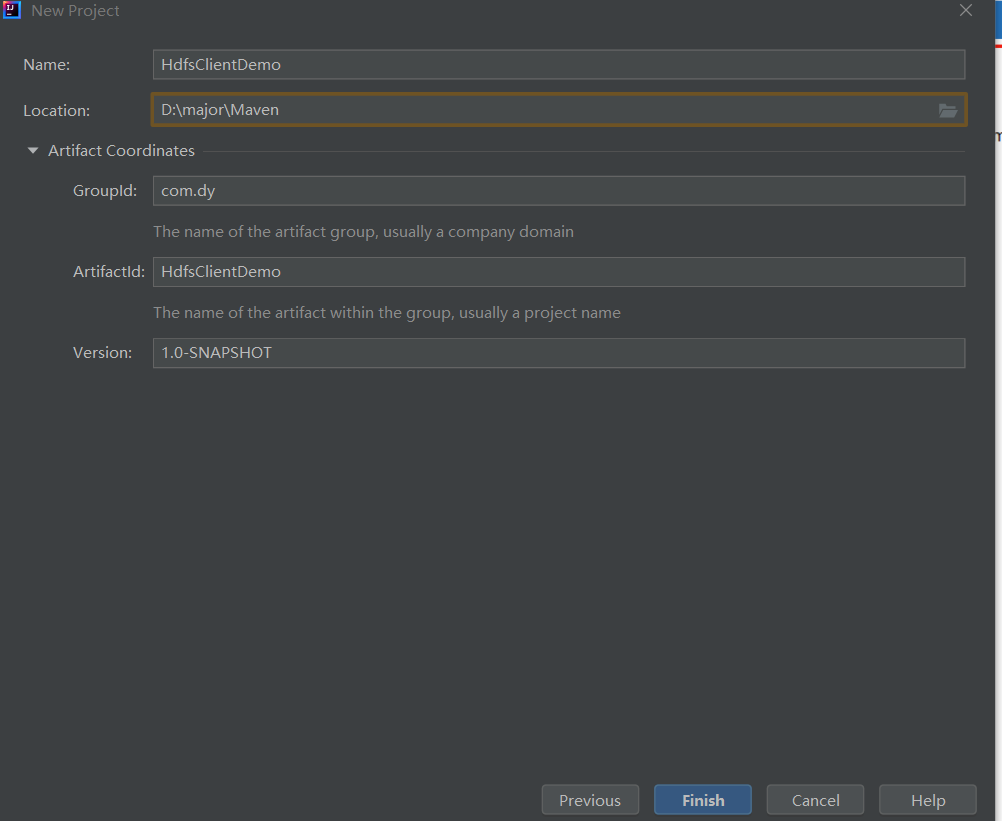

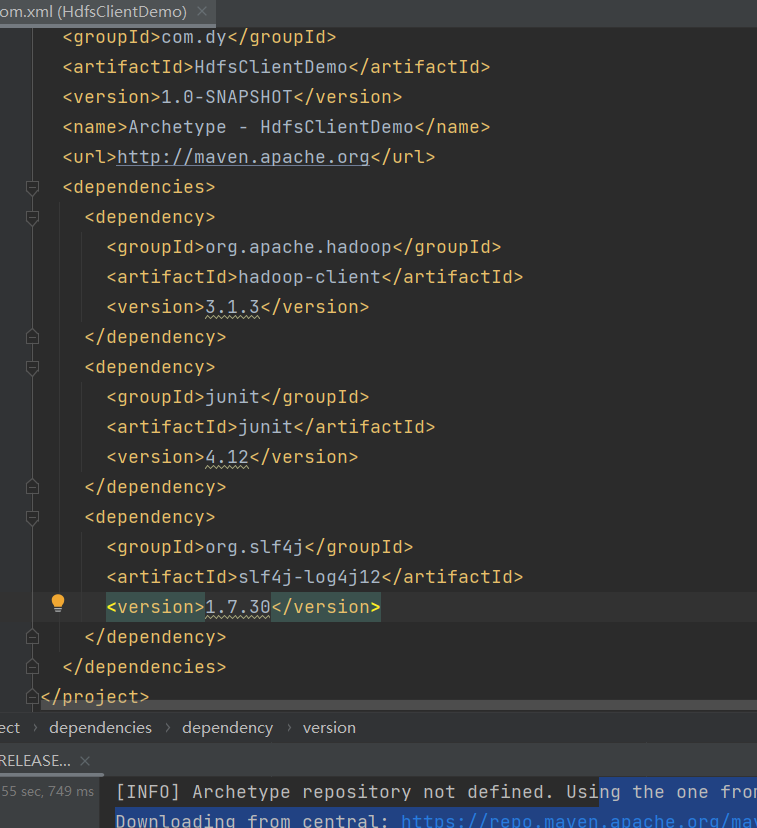

- 配置POM.xml

将配置代码复制到POM.xml文件中:

org.apache.hadoop hadoop-client 3.1.3 junit junit 4.12 org.slf4j slf4j-log4j12 1.7.30

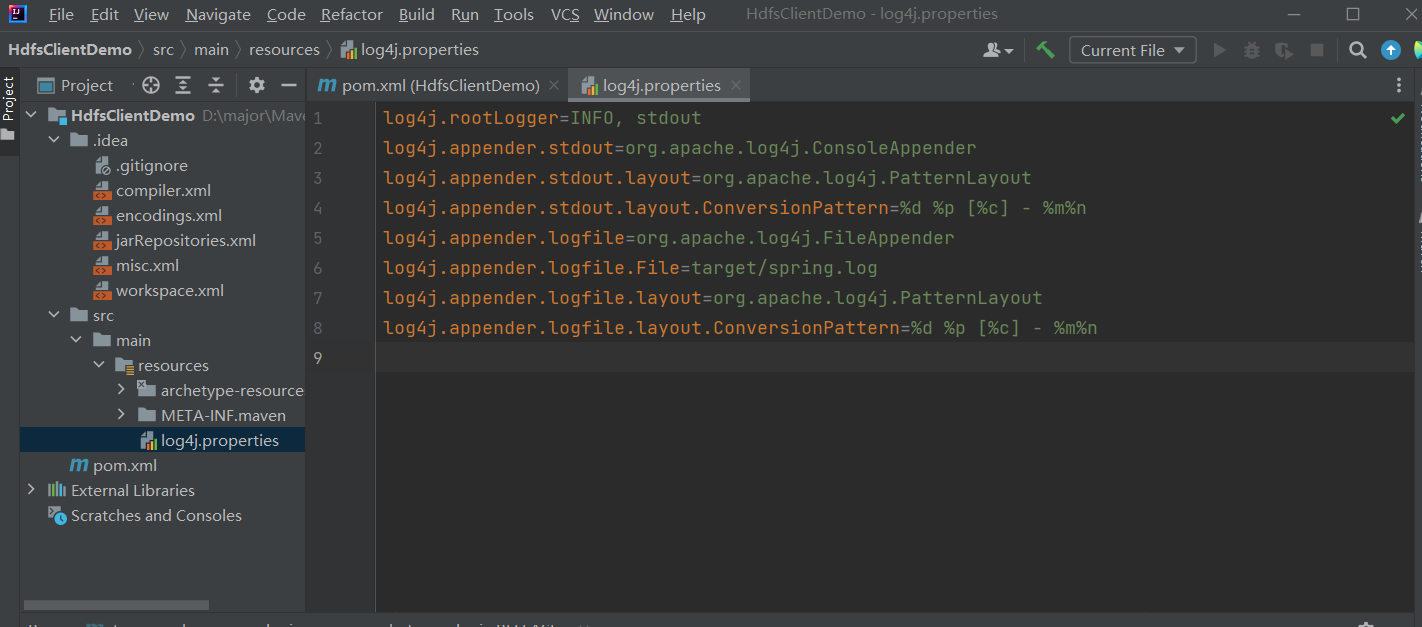

- 配置log4j.properties文件

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

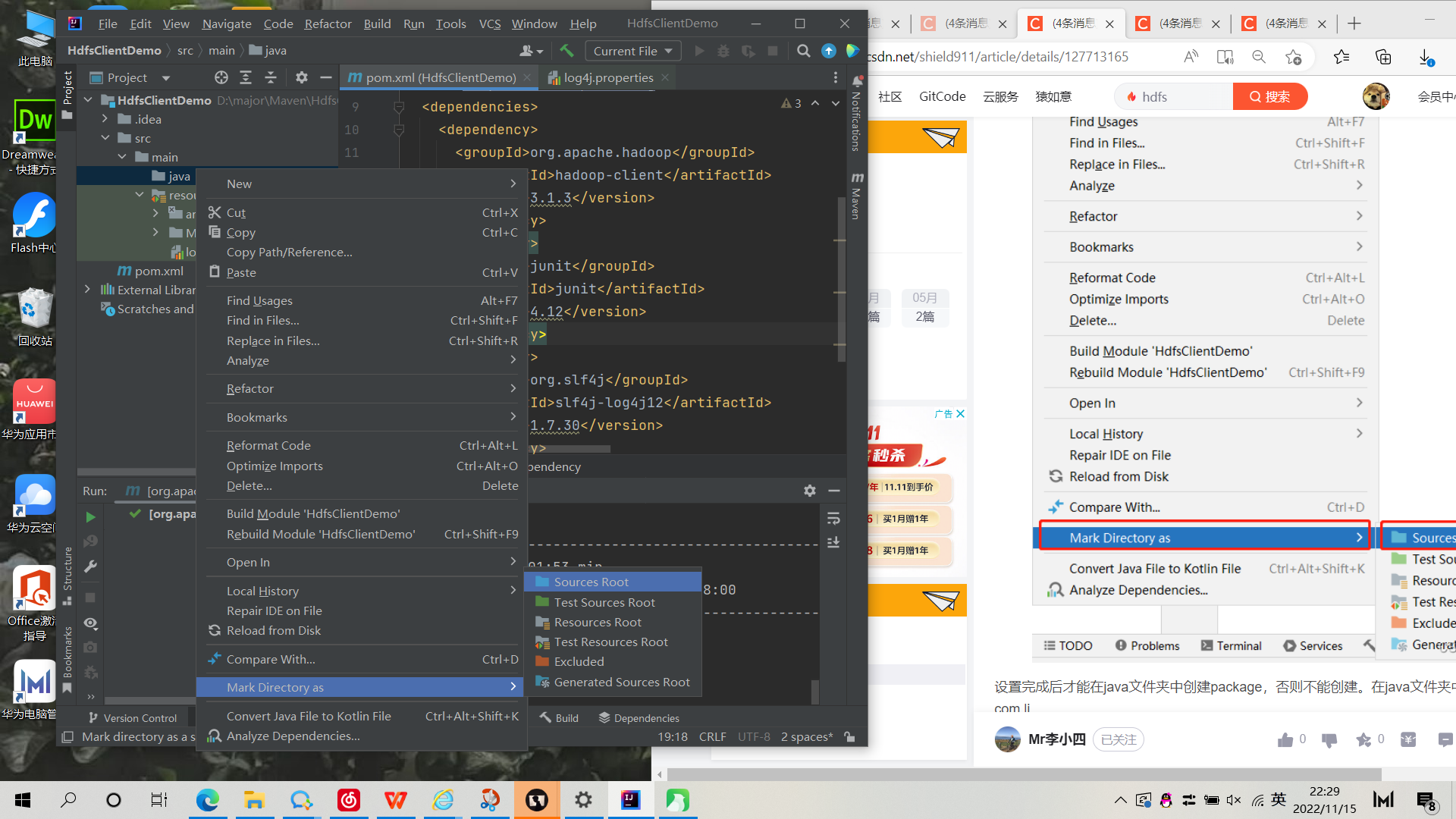

- 创建名为java的文件

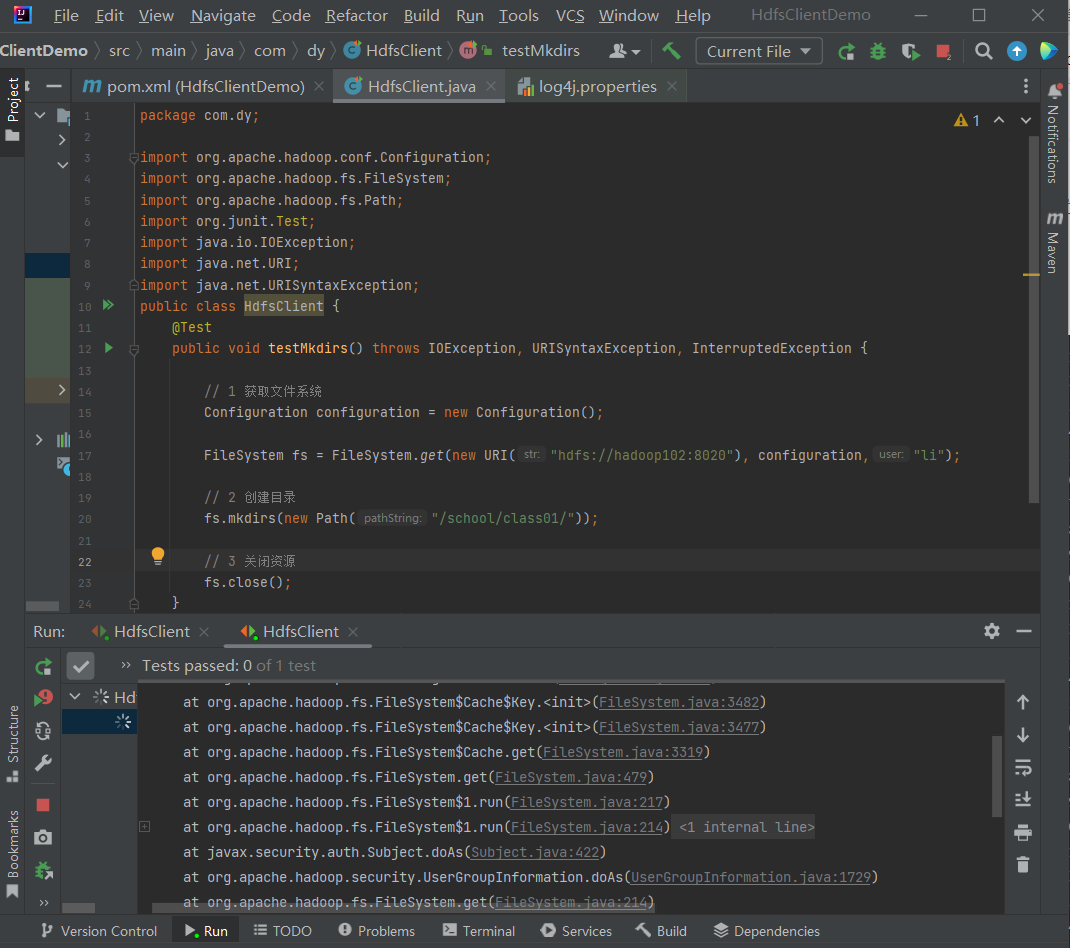

- 在com.li包中创建HdfsClient类,进行Java API测试,测试代码如下:

package com.dy;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

public class HdfsClient {

@Testpublic void testMkdirs() throws IOException, URISyntaxException, InterruptedException {// 1 获取文件系统Configuration configuration = new Configuration();FileSystem fs = FileSystem.get(new URI("hdfs://hadoop102:8020"), configuration,"li");// 2 创建目录fs.mkdirs(new Path("/school/class01/"));// 3 关闭资源fs.close();}}