参考:https://kaisery.github.io/trpl-zh-cn/ch20-03-graceful-shutdown-and-cleanup.html

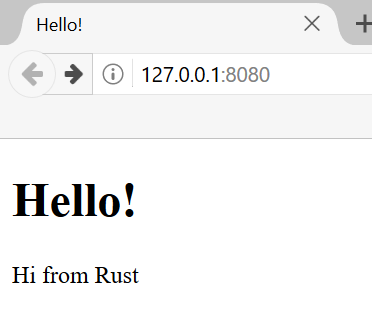

项目成果:

如下是我们将怎样构建此 web server 的计划:

- 学习一些 TCP 与 HTTP 知识

- 在套接字(socket)上监听 TCP 请求

- 解析少量的 HTTP 请求

- 创建一个合适的 HTTP 响应

- 通过线程池改善 server 的吞吐量

这里使用的方法并不是使用 Rust 构建 web server 最好的方法。crates.io 上有很多可用于生产环境的 crate,它们提供了比我们所要编写的更为完整的 web server 和线程池实现。

然而,本章的目的在于学习,而不是走捷径。因为 Rust 是一个系统编程语言,我们能够选择处理什么层次的抽象,并能够选择比其他语言可能或可用的层次更低的层次。因此我们将自己编写一个基础的 HTTP server 和线程池,以便学习将来可能用到的 crate 背后的通用理念和技术。

cargo new web-servercd web_server

单线程 server

一个小而简单的 server,它对一个请求返回页面内容而对所有其他请求返回 404 响应:

use std::fs;use std::io::prelude::*;use std::net::TcpListener;use std::net::TcpStream;fn main() {// 绑定端口,如果端口被占用、或者权限不够,则直接 paniclet listener = TcpListener::bind("0.0.0.0:7878").unwrap();// let listener = TcpListener::bind("127.0.0.1:7878").unwrap();for stream in listener.incoming() {let stream = stream.unwrap();println!("成功连接!");handle_connection(stream);}}fn handle_connection(mut stream: TcpStream) {let mut buffer = [0; 1024];stream.read(&mut buffer).unwrap();println!("Request: {}", String::from_utf8_lossy(&buffer[..]));// 响应成功,但浏览器访问时返回 空白页面// let response = "HTTP/1.1 200 OK\r\n\r\n";let get = b"GET / HTTP/1.1\r\n";let (status_line, filename) = if buffer.starts_with(get) {("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else {("HTTP/1.1 404 NOT FOUND\r\n\r\n", "404.html")};let contents = fs::read_to_string(filename).unwrap();let response = format!("{}{}", status_line, contents);stream.write(response.as_bytes()).unwrap();stream.flush().unwrap();}

目前 server 运行于单线程中,它一次只能处理一个请求。意味着它在完成第一个连接的处理之前不会处理第二个连接。如果 server 正接收越来越多的请求,这类串行操作会使性能越来越差。如果一个请求花费很长时间来处理,随后而来的请求则不得不等待这个长请求结束,即便这些新请求可以很快就处理完。

让我们模拟一些慢请求来看看这如何会成为一个问题,并进行修复以便 server 可以一次处理多个请求。

use std::fs;use std::io::prelude::*;use std::net::TcpListener;use std::net::TcpStream;use std::thread;use std::time::Duration;fn main() {// 绑定端口,如果端口被占用、或者权限不够,则直接 paniclet listener = TcpListener::bind("0.0.0.0:7878").unwrap();// let listener = TcpListener::bind("127.0.0.1:7878").unwrap();for stream in listener.incoming() {let stream = stream.unwrap();println!("成功连接!");handle_connection(stream);}}fn handle_connection(mut stream: TcpStream) {let mut buffer = [0; 1024];stream.read(&mut buffer).unwrap();println!("Request: {}", String::from_utf8_lossy(&buffer[..]));// 响应成功,但浏览器访问时返回 空白页面// let response = "HTTP/1.1 200 OK\r\n\r\n";let get = b"GET / HTTP/1.1\r\n";let sleep = b"GET /sleep HTTP/1.1\r\n";let (status_line, filename) = if buffer.starts_with(get) {("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else if buffer.starts_with(sleep) {thread::sleep(Duration::from_secs(3));("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else {("HTTP/1.1 404 NOT FOUND\r\n\r\n", "404.html")};let contents = fs::read_to_string(filename).unwrap();let response = format!("{}{}", status_line, contents);stream.write(response.as_bytes()).unwrap();stream.flush().unwrap();}

使用 cargo run 启动 server,并接着打开两个浏览器窗口:一个请求 http://127.0.0.1:7878/ 而另一个请求 http://127.0.0.1:7878/sleep 。如果像之前一样多次请求 / ,会发现响应的比较快速。不过如果请求 /sleep 之后在请求 / ,就会看到 / 会等待直到 sleep 休眠完五秒之后才出现。

使用线程池改善吞吐量

线程池 (thread pool )是一组预先分配的等待或准备处理任务的线程。当程序收到一个新任务,线程池中的一个线程会被分配任务,这个线程会离开并处理任务。其余的线程则可用于处理在第一个线程处理任务的同时处理其他接收到的任务。当第一个线程处理完任务时,它会返回空闲线程池中等待处理新任务。线程池允许我们并发处理连接,增加 server 的吞吐量。

当新进请求时,将请求发送到线程池中做处理。线程池会维护一个接收请求的队列。每一个线程会从队列中取出一个请求,处理请求,接着向对队列索取另一个请求。通过这种设计,则可以并发处理 N 个请求,其中 N 为线程数。如果每一个线程都在响应慢请求,之后的请求仍然会阻塞队列,不过相比之前增加了能处理的慢请求的数量。

这个设计仅仅是多种改善 web server 吞吐量的方法之一。其他可供探索的方法有 fork/join 模型和单线程异步 I/O 模型。

另外可以使用编译器驱动开发(compiler-driven development):我们将编写调用所期望的函数的代码,接着观察编译器错误告诉我们接下来需要修改什么使得代码可以工作。就像测试驱动开发那样。

// src/main.rsuse std::fs;use std::io::prelude::*;use std::net::{TcpListener, TcpStream};use std::thread;use std::time::Duration;use web_server::ThreadPool;fn main() {let listener = TcpListener::bind("0.0.0.0:7878").unwrap();let pool = ThreadPool::new(4);for stream in listener.incoming() {let stream = stream.unwrap();pool.execute(|| {handle_connection(stream);});}}fn handle_connection(mut stream: TcpStream) {let mut buffer = [0; 1024];stream.read(&mut buffer).unwrap();println!("Request: {}", String::from_utf8_lossy(&buffer[..]));let get = b"GET / HTTP/1.1\r\n";let sleep = b"GET /sleep HTTP/1.1\r\n";let (status_line, filename) = if buffer.starts_with(get) {("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else if buffer.starts_with(sleep) {thread::sleep(Duration::from_secs(3));("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else {("HTTP/1.1 404 NOT FOUND\r\n\r\n", "404.html")};let contents = fs::read_to_string(filename).unwrap();let response = format!("{}{}", status_line, contents);stream.write(response.as_bytes()).unwrap();stream.flush().unwrap();}

// src/lib.rs// #![allow(unused)]use std::sync::mpsc;use std::sync::{Arc, Mutex};use std::thread;pub struct ThreadPool {workers: Vec<Worker>,sender: mpsc::Sender<Job>,}type Job = Box<dyn FnOnce() + Send + 'static>;impl ThreadPool {/// 创建线程池。////// 线程池中线程的数量。////// # Panics////// `new` 函数在 size 为 0 时会 panic。pub fn new(size: usize) -> Self {assert!(size > 0);let (sender, receiver) = mpsc::channel();let receiver = Arc::new(Mutex::new(receiver));let mut workers = Vec::with_capacity(size);for id in 0..size {workers.push(Worker::new(id, Arc::clone(&receiver)));}Self { workers, sender }}/// 执行线程,需要传入闭包。////// 使用 Sender 对线程进行通信。pub fn execute<F>(&self, f: F)where F: FnOnce() + Send + 'static {let job = Box::new(f);self.sender.send(job).unwrap();}}struct Worker {id: usize,thread: thread::JoinHandle<()>,}impl Worker {fn new(id: usize, receiver: Arc<Mutex<mpsc::Receiver<Job>>>) -> Self {let thread = thread::spawn(move || loop {let job = receiver.lock().unwrap().recv().unwrap();println!("Worker {} got a job; executing.", id);job(); // 闭包最终被调用});Self { id, thread }}}

优雅清理

// web-server/src/main.rsuse std::fs;use std::io::prelude::*;use std::net::{TcpListener, TcpStream};use std::thread;use std::time::Duration;use web_server::ThreadPool;fn main() {let listener = TcpListener::bind("0.0.0.0:7878").unwrap();let pool = ThreadPool::new(4);for stream in listener.incoming().take(2) {let stream = stream.unwrap();pool.execute(|| {handle_connection(stream);});}println!("Shutting down.");}fn handle_connection(mut stream: TcpStream) {let mut buffer = [0; 1024];stream.read(&mut buffer).unwrap();println!("Request: {}", String::from_utf8_lossy(&buffer[..]));let get = b"GET / HTTP/1.1\r\n";let sleep = b"GET /sleep HTTP/1.1\r\n";let (status_line, filename) = if buffer.starts_with(get) {("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else if buffer.starts_with(sleep) {thread::sleep(Duration::from_secs(3));("HTTP/1.1 200 OK\r\n\r\n", "hello.html")} else {("HTTP/1.1 404 NOT FOUND\r\n\r\n", "404.html")};let contents = fs::read_to_string(filename).unwrap();let response = format!("{}{}", status_line, contents);stream.write(response.as_bytes()).unwrap();stream.flush().unwrap();}

// web-server/src/lib.rsuse std::sync::mpsc;use std::sync::{Arc, Mutex};use std::thread;type Job = Box<dyn FnOnce() + Send + 'static>;enum Message {NewJob(Job),Terminate,}pub struct ThreadPool {workers: Vec<Worker>,sender: mpsc::Sender<Message>,}impl ThreadPool {/// 创建线程池。////// 线程池中线程的数量。////// # Panics////// `new` 函数在 size 为 0 时会 panic。pub fn new(size: usize) -> Self {assert!(size > 0);let (sender, receiver) = mpsc::channel();let receiver = Arc::new(Mutex::new(receiver));let mut workers = Vec::with_capacity(size);for id in 0..size {workers.push(Worker::new(id, Arc::clone(&receiver)));}Self { workers, sender }}/// 执行线程,需要传入闭包。////// 使用 Sender 对线程进行通信。pub fn execute<F>(&self, f: F)where F: FnOnce() + Send + 'static {let job = Box::new(f);self.sender.send(Message::NewJob(job)).unwrap();}}impl Drop for ThreadPool {fn drop(&mut self) {println!("Sending terminate message to all workers.");for _ in &mut self.workers {self.sender.send(Message::Terminate).unwrap();}for worker in &mut self.workers {println!("Shutting down worker {}", worker.id);if let Some(thread) = worker.thread.take() {// 将 thread 移动出拥有其所有权的 Worker 实例以便 join 可以消耗掉这个线程thread.join().unwrap();}}}}struct Worker {id: usize,thread: Option<thread::JoinHandle<()>>,}impl Worker {fn new(id: usize, receiver: Arc<Mutex<mpsc::Receiver<Message>>>) -> Self {let thread = thread::spawn(move || loop {let message = receiver.lock().unwrap().recv().unwrap();match message {Message::NewJob(job) => {println!("Worker {} got a job; executing.", id);job(); // 闭包最终被调用}Message::Terminate => {println!("Worker {} was told to terminate.", id);break;}}});Self { id, thread: Some(thread) }}}

todo:web-server# 这里还有很多可以做的事!如下是一些点子:

- 为

ThreadPool和其公有方法增加更多文档 - 为库的功能增加测试

- 将

unwrap调用改为更健壮的错误处理 - 使用

ThreadPool进行其他不同于处理网络请求的任务 - 在 crates.io 上寻找一个线程池 crate 并使用它实现一个类似的 web server,将其 API 和鲁棒性与我们的实现做对比