围绕数据基础、现代卷积网络主流模型、卷积网络的应用案例、发展方向等展开。

数学基础

内容包括激活函数、矩阵运算、导数公式、梯度下降算法、反向传播算法、通用逼近定理、卷积运算、池化、局部响应归一化、权值偏置、随机梯度下降、动态规划算法等。

激活函数

激活函数是神经网络模型重要的组成部分,该函数被添加到神经网络中,帮助网络学习数据中的复杂模式。

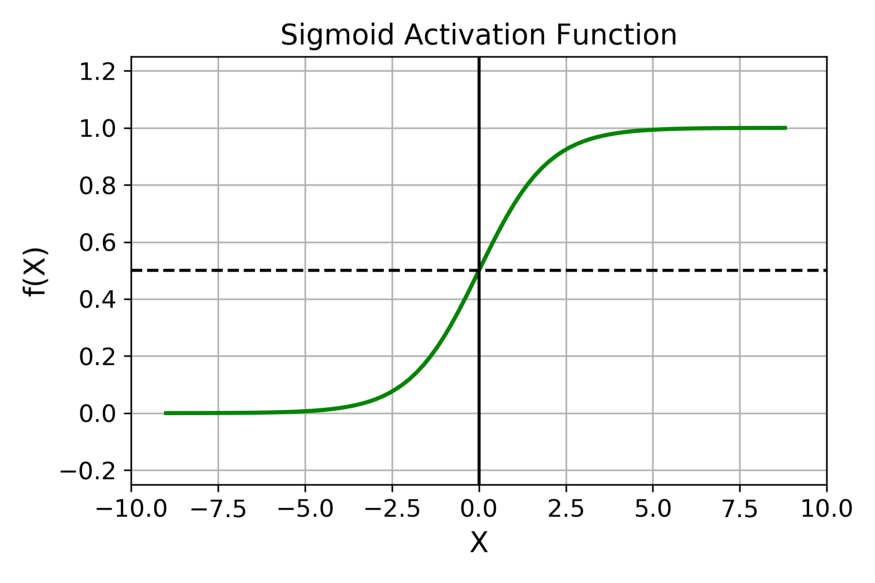

Sigmoid函数

Sigmoid函数曲线看起来就像一个S形曲线。

Sigmoid函数表达式如下:

什么时候选择Sigmoid函数?

Sigmoid函数的优缺点?

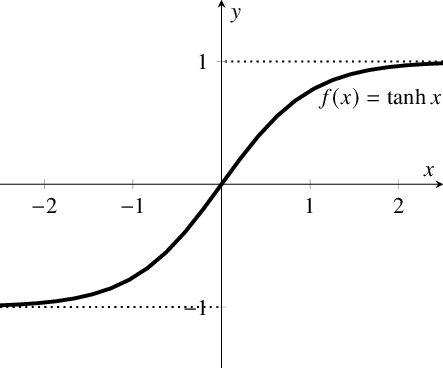

tanh/双曲正切激活函数

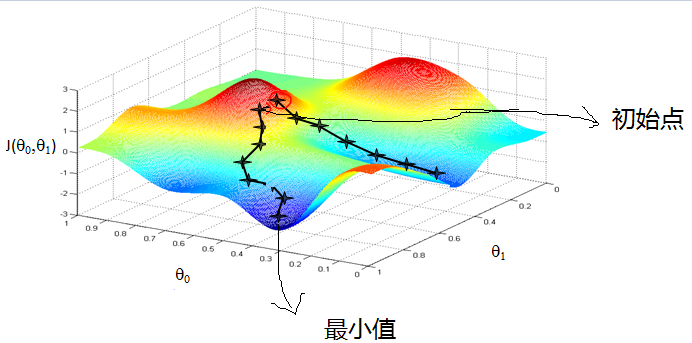

梯度下降算法(Gradient Descent)

在求解机器学习算法的模型参数,即无约束优化问题时,梯度下降是最常采用的方法之一。

概念

直观解释:

比如我们在一座大山上的某处位置,由于我们不知道怎么下山,于是决定走一步算一步,也就是在每走到一个位置的时候,求解当前位置的梯度,沿着梯度的负方向,也就是当前最陡峭的位置向下走一步,然后继续求解当前位置梯度,向这一步所在位置沿着最陡峭最易下山的位置走一步。这样一步步的走下去,一直走到觉得我们已经到了山脚。

梯度下降算法背后的原理是:

目标函数关于参数

的梯度将是损失函数(loss function)上升最快的方向。而我们要最小化loss,只需要将参数沿着梯度相反的方向前进一个步长,就可以实现目标函数(loss function)的下降。

这个步长又称为学习率,用表示,于是参数更新的公式如下:

其中,是参数的梯度。

经典梯度下降算法

更加详细的算法原理,可以参考下面这些资料:

简单易懂的梯度下降算法讲解

点击查看【bilibili】

反向传播算法

定义

当我们使用前馈神经网络接收输入并产生输出

时,信息通过网络向前流动。输入

提供初始信息,然后传播到每一层的隐藏单元,最终产生输出

。这称之为前向传播(forward propagation)。在训练过程中,前向传播可以持续向前直到产生一个标量代价函数

。反向传播算法,经常称之为backprop,允许来自代价函数的信息通过网络向后流动,以便计算梯度。

— 《深度学习》Ian Goodfellow

参考

1.详解激活函数

2.深度学习领域常用的激活函数,详解数学原理及优缺点

3.一文看懂常用的梯度下降算法