摘要:定位作为自动驾驶中最基本的环节之一,目的在于明确车辆相对于全局的绝对位置或相对于交通参与者的相对位置,其准确性直接影响了自动驾驶系统的安全性。当前,自动驾驶技术正在对我们的出行产生越来越深远的影响,但是在复杂的真实道路环境中,面向自动驾驶的定位方法还不够成熟。本文对已有的定位方法进行了全面而系统的梳理,首先针对单个定位方式逐类别地进行了归纳,包含基于通信的、基于航位推算的、和基于特征匹配的方式三种类别,并重点分析对比了各种定位方式的基本原理和优缺点;然后调研和讨论了现阶段典型的融合定位方式;最后对当前面临的挑战和进一步研究的方向进行了阐述。

关键词:自动驾驶;定位;融合;通信定位;航位推算;特征匹配

1 引言

自动驾驶主要包含环境感知、定位导航、决策规划和控制执行四大部分[3]。定位问题是自动驾驶中必不可少的一环,从广义上讲,旨在解决“我在哪儿”的问题;从狭义上讲,它的目标是确定当前车辆在全球中,或在数字地图中的绝对位置,或者是当前车辆对于周边环境(如道路、其他车辆、行人)的相对位置。它为自动驾驶提供基本的位置信息,其精度(厘米级)直接决定自动驾驶的安全性和准确性。因此,对定位的研究就显得尤为基础和重要。

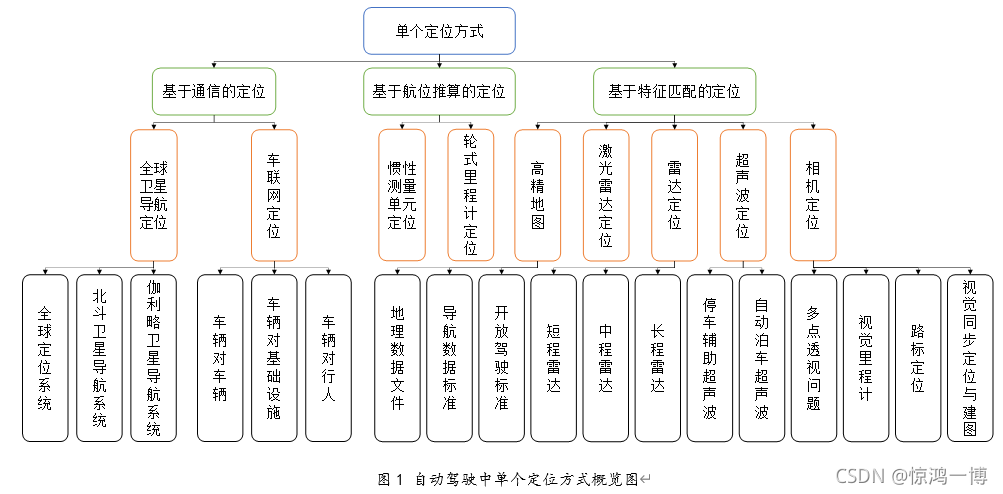

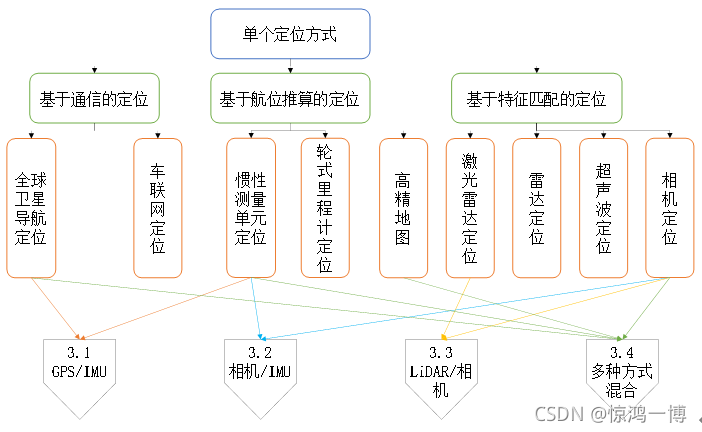

本文尝试从定位方法的层次上,对各种定位方式进行分析对比,分为单个定位方式和融合定位方式两大类进行探讨。对于单个定位方式而言有三类:基于通信的方式、基于航位推算的方式和基于特征匹配的方式,这将在第2部分分别进行讨论,重点论述其工作原理及优缺点;然后,在第3部分,针对目前比较流行的融合定位方式进行调研;最后,第4部分探讨定位技术的最新进展和未来趋势。

2 典型的单个定位方式

从所使用的方法层面上,单个定位方式可以划分成三类:基于通信、基于航位推算和基于特征匹配的方式[5]。本节将对相应的定位方式逐一进行概述,重点分析其工作原理和优缺点,并在最后做了定性和定量的对比。自动驾驶中单个定位方式的概览图如下所示。

2.1 基于通信的定位方式

2.1.1 全球卫星导航系统定位

全球卫星导航系统(Global Navigation Satellite System,GNSS)包含美国的全球定位系统(Global Positioning System,GPS)、中国的北斗卫星导航系统、欧洲的伽利略(Galileo)等,是目前自动驾驶中最常用最基本的定位方式。

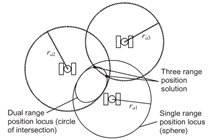

GNSS主要有空间卫星群、地面控制站和用户端三部分组成。它利用飞行时间原理(Time of Flight,TOF)进行定位。当使用一个卫星时,可以在一个球面上定位物体的位置;当使用两个卫星时,可以在两个球面的交集——圆上进行定位;当使用三个卫星时,可以将物体定位到上述圆与球面的两个交点上(如图2所示)。在实践中,可以很容易判断其中一个交点在太空中,所以理论上讲,可以利用至少三颗卫星定位物体的位置[4]。由于卫星和地面接收机的距离也是未知的,所以一般至少需要四颗卫星实现定位。

图2 GNSS 定位原理图[4]

GNSS定位技术目前发展较为成熟,定位精度一般在米级(10米左右)。其中高精度的定位方案:实时动态相位差分技术(Real Time Kinematic,RTK)定位精度可以达到1cm~2cm,但RTK技术依靠于参考基站的观测数据,其准确度会因与参考基站的距离的增加而逐渐降低,且存在基站切换延时,同时RTK成本较高。

总体来说,

GNSS定位优点是:1)全球性的定位;2)全天候;3)成本较低,使用方便。

缺点在于: 1)在高建筑物、地下车库、室内或山区地形等条件下,信号会被遮挡,并存在多路效应,会导致定位精度下降,甚至错误;2)易受电磁波、大气层等因素的干扰;3)传输时延大、更新频率较低(1Hz~50Hz)。

2.1.2 车联网定位

车联网(Vehicle to Everything,V2X)指车 V2I定位采用与路边单元 (Road Side Unit,RSU)或者蜂窝基站通信的方式,获取位置信息。它有以下优点:1)因使用固定安装的RSU,定位精度高;2)稳定性好。当然也有缺点:1)为实现连续通信,需要安装大量的RSU,因此,成本较高。

由于自动驾驶对车辆定位有低延时、高精度的要求,5G技术受到越来越多的重视,因为它被认为是目前达到该要求的重要条件。Del等人[8] 对在5G技术下使用V2I网络时的定位能力进行了可行性研究,其仿真结果表明:在高速公路上,使用50MHz ~ 100MHz的信号带宽,在99%的情况下,定位精度可以达到20cm~ 25cm。与其他一切事物的连接和信息交互,包含车辆对车辆通信(Vehicle to Vehicle,V2V)、车辆对基础设施通信(Vehicle to Infrastructure,V2I)、车辆对行人通信(Vehicle to Pedestrian,V2P)等,实现“聪明的车,智能的路”的协同。目前主流的通信标准有两个,一个是专用短程通信技术 (Dedicated Short-Range Communications, DSRC),它多应用在碰撞预警等场合;另一个是采用蜂窝通信网络的长期演进技术-车辆通信( Long Term Evolution - Vehicle,LTE-V)标准,该标准在从LTE-V2X逐步向NR-V2X演进发展[6]。

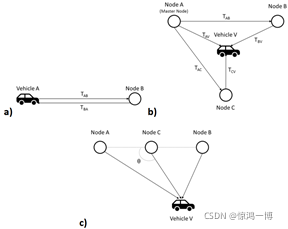

通过车辆网实现定位,也称为合作定位技术。它通过广播无线信号(如 Wi-Fi、cellular、UWB等),评估广播者的相对位置或者距离。若是为了确定相对距离,1个这样的广播信号即可;若是为了确定相对位置,则一般需要3个广播信号。通常定位和测距基于以下几个标准:到达时间(Time of Arrival,TOA)、到达时差(Time Different of Arrival,TDOA)、到达角度(Angle of Arrival,AOA) 和无线电信号强度(Received Signal Strength,RSS),如图3所示。

图3 车联网定位方式。a)TOA方式 b)TDA方式 c) AOA方式[1]

(1)V2V

V2V定位的基本原理是利用车辆自组网(Vehicular Ad-hoc Network,VANET),整合相邻车辆的位置信息进行定位[7]。优点是:1)可以获取视野以外的车辆位置, 2)成本低,3)数据处理量小。缺点是在高速移动场景下,车辆与车辆之间的连接切换频繁,导致稳定性低。

(2)V2I

V2I定位采用与路边单元 (Road Side Unit,RSU)或者蜂窝基站通信的方式,获取位置信息。

它有以下优点:1)因使用固定安装的RSU,定位精度高;2)稳定性好。当然也有缺点:1)为实现连续通信,需要安装大量的RSU,因此,成本较高。

由于自动驾驶对车辆定位有低延时、高精度的要求,5G技术受到越来越多的重视,因为它被认为是目前达到该要求的重要条件。Del等人[8] 对在5G技术下使用V2I网络时的定位能力进行了可行性研究,其仿真结果表明:在高速公路上,使用50MHz ~ 100MHz的信号带宽,在99%的情况下,定位精度可以达到20cm ~ 25 cm。

2.2 基于航位推测的定位方式

航位推测法(Dead Reckoning,DR)是利用物体的初始位置,通过观测物体的移动方向和距离,推测下一时刻位置的方法。此种方法是比较传统的定位方式,主要分为惯性导航定位系统(Inertial Navigation System,INS)和里程计定位两种方式[9]。

2.2.1 惯性测量单元定位

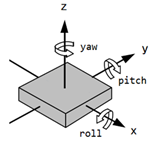

在惯性导航定位系统中,最常用的器件是惯性测量单元(Inertial Measurement Unit,IMU)。它通过测量出物体的三个轴上的加速度和角速度实现相对定位,其坐标系示意图如图4所示。一般情况,它包含3个方向的加速度计(用于获取加速度,积分后得到速度)和3个单轴的陀螺仪(用于获得方位角角速度,积分后得到俯仰角pitch和翻滚角roll)。为了提高姿态的估计精度,一些IMU内还会添加磁力计(估计偏航角yaw)。

图4 IMU 坐标系示意图

该定位方式重要有以下优点:1)不依赖于外部环境,可独立工作,也可复杂环境条件下工作;2)更新频率高(100Hz);3)可获取六个自由度的信息。主要缺点有:1)长程离定位,误差会累计,存在漂移现象;2)精度受环境温度影响。因GPS没有累计误差,IMU不受多路效应和遮挡的影响,所以IMU常与GPS结合一起定位(详见3.1节)。

2.2.2 轮式里程计定位

轮式里程计是一种直接从安装在轮子上的传感器获取车辆速度和位移的常用装置。它一般分为三类:纯机械式、机械-电子式和纯电子式。例如纯电子式旋转编码器,根据电磁感应原理,将轮胎转动圈数转变成电压信号,以此测量行驶速度和角度;再通过对速度在时间轴上的积分,实现定位的目的。

轮式里程计定位优点在于1)简单易用;2)体积小、成本低;3)短距离内,定位精确高。与IMU定位类似,该方法也有类似的缺点:1)误差会随时间而累积;2)轮子滑动或者道路不平情况下,会导致定位精度降低。因此,在行人导航和室内导航中应用较多,在自动驾驶中,常用作辅助定位。

2.3 基于特征匹配的定位方式

2.3.1 高精地图

为了实现高度自动驾驶,业界普遍认为,高精地图(High Definition Map,HD Map)是必不可少的。对于基于特征匹配的定位方式,更是如此。高精地图直接影响定位的精度,同时为规划模块提供基本的数据支持。

但对于高精地图的具体形式,目前还没有统一的标准。Kuutti 等[1]将高精地图分为两类:平面分层地图和3D点云地图。前者通过卫星和航空影像,获取基本的地图图层信息,再加上车道级别路网信息,形成HD Map。它在不同的地图层上显示不同的道路环境信息;后者通过3D传感器,如激光雷达、相机等,获取地图中元素的三维信息,形成HD Map,如图5所示。Liu 等[10]给出了类似但不完全相同的分类方式。它将高精地图分为三个子模型:用于导航整体路线的道路模型(Road Model)、用于车道局部路线规划的车道模型(Lane Model),及用于辅助定位的定位模型(Localization Model),同样具有重要的参考意义。

图5 高精地图示例。绿色点为道路及周边点云模型,带箭头的直线和弧线为车道矢量模型。

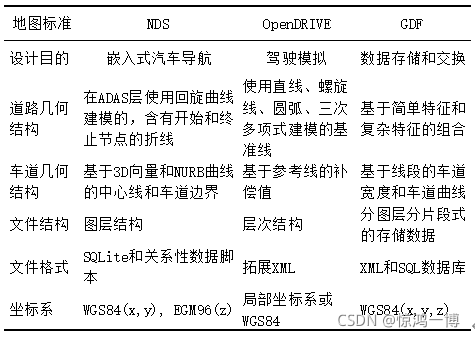

关于HD Map的数据格式标准,目前有2种较为流行:导航数据标准(Navigation Data Standard,NDS)和开放驾驶标准(OpenDRIVE)。这两者与传统的地理数据文件(Geographic Data File,GDF)标准对比如表1所示。不论使用哪一种分类方式,高精地图在基于特征匹配定位的方式上,都起重要作用。

表1 三种格式的地图标准对比[10]

值得说明的是,高精地图区别于传统地图的重要一方面是,地图的精度从米级上升到厘米级。一个典型的例子是定位精度从道路级别,上升到车道级别。同时,未来的高清地图需要依靠空中下载技术(Over The Air,OTA)进行实时动态更新,5G技术和云计算的发展将推动其快速前进。

2.3.2 激光雷达定位

激光雷达(Light Detection and Ranging,LiDAR),是由传统的雷达技术和现代的激光技术结合而成,通过发射“激光”,检测飞行时间,以确定自身到测量物之间的距离。根据测量维数的不同,LiDAR可分为线性、平面和三维3种类型。目前较有代表性的厂家Velodyne生产的128线激光雷达(探测距离可达300米)如图6所示。

图6 Velodyne VLS-128TM LiDAR示意图

使用激光雷达进行定位时,首先通过采集车获取道路信息,利用建图技术生产出3D点云地图,然后使用特定的算法(如基于REGISTRATION的方法、基于FEATURES的方法或基于DEEP LEARNING的方法[11]),对比当前采集的点云数据特征,找出车辆所在的位置和朝向。

激光雷达具有如下优点:1)可直接产生丰富的空间数据,如点的3D坐标和纹理等;2)因为分辨率较高(距离、角度和速度),所以精度高、实时性好;3)抗干扰能力强,因激光波长较短,一定程度减小了多路效应;4)不受光照强度影响;5)体积小,安装方便。但也有一些缺点:1)受环境中气候的影响较大,如在雨、雪、雾、尘等极端天气下,传播距离会急剧衰减;2)价格高,这是目前很多汽车厂商(如TESLA)试图寻找其他定位方案的重要原因;3)数据量较大,需要高效的处理流程。

因自动驾驶对定位精度有较高的要求,所以激光雷达发挥越来越重要的作用。目前在RTK信号缺失时,使用激光雷达和高精地图进行匹配是主流的高精定位方式。机械式的激光雷达现阶段比较成熟,但因其旋转部件成本较高,低成本的固态式的激光雷达获得了逐步发展的机会。不过固态激光雷达也有自身的局限性,如水平视角(小于180°)不如机械式的激光雷达。所以多个固态激光雷达组合使用,可能是未来一种成本低、覆盖范围广的高精度定位方式。

2.3.3 雷达定位

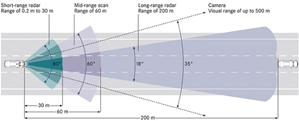

雷达(Radio Detection and Ranging,RADAR)是利用“电磁波”探测物体的距离、方向、速度或高度等的设备。按照波长,它可划分为毫米波雷达、分米波雷达等。目前在自动驾驶领域,应用较广泛的是毫米波雷达(频率范围10GHz~300GHz,其中常用的频段有24GHz和77GHz)。根据传播的距离,可将毫米波雷达分为短程雷达 (Short Range RADAR,SRR)、 中距雷达 (Medium Range RADAR,MRR)和长程雷达 (Long Range RADAR,LRR)。

整体来说,毫米波雷达有如下优点:1)可全天候工作,因其对烟雾和灰尘等有较强的穿透能力(除大雨天);2)空间分辨率高;3)相对视觉和激光雷达而言,可以用来测量物体速度;4)天线尺寸较小,功耗低。当然,它也有自身的缺点:1)探测距离受制于频段损耗,即频段越高,探测距离才有可能越远;2)现阶段高频(如77GHz)的毫米波技术发展不成熟。

(1)SRR

短程雷达,主要使用24GHz的频段。它的探测距离较近,有30m左右,不过探测角度相对较大,最高可达120°左右。短程雷达有成本低,技术发展相对成熟的优点,同时也有体积相对较大的缺点。鉴于上述情况,短程雷达主要用于盲区检测、车道保持、变道辅助和泊车辅助等场合。

(2)MRR/LRR

中程雷达,主要使用76-77GHz的频段,探测距离在60m左右,探测角度可达60°左右。对于长程雷达,主要使用77GHz频段,探测距离一般可达在200m左右,探测角度一般只有20°左右。中长程雷达相对短程雷达,具有1)检测精度较高,2)体积小的优点;但同时也有1)制作工艺要求高,2)目前发展还不够成熟的缺点。鉴于此,它一般应用场合有辅助刹车、和紧急制动等。图7为三种车载毫米波雷达探测范围的一个示例。

图7 不同类型的毫米波雷达测量范围示意图[12]

2.3.4 超声波定位

超声波(Ultrasound,又称超声波雷达)定位,即使用发射探头发出频率大于20KHz的声波和计算飞行时间来探测距离。常用的超声波频率有40KHz、48KHz和58KHz,其中最常用的频率是40KHz。使用超声波定位,一般精度在1cm3cm之间,探测适用范围在0.2m5m之间。

优点如下:1)穿透能力强,一定程度上可以防水、防沙、防尘;2)成本低;3)不受电磁效应的干扰。这种方式也有一些缺点:1)检测角度小、探测距离短,因此一辆车上会选择安装多个超声波传感器,并在低速行驶中使用;2)无法精确描述障碍物的位置,如两个障碍物同时返回相同的探测距离时;3)抗干扰能力差,易受到车速、震动、温度及湿度的影响。

由于以上特点,超声波在倒车、自动泊车、盲区检测等方面广泛应用,如图8所示。常用的超声波雷达有两种,停车辅助(Ultrasonic Parking Assistance,UPA)超声波雷达和自动泊车(Automatic Parking Assistance,APA)超声波雷达。UPA超声波雷达探测范围较近,一般在0.1m2.5m,常安装在车辆的前后保险杠上,辅助倒车。APA超声波雷达探测距离稍远,在0.3m5m左右,一般安装在车辆的侧面,且具有较强的指向性,用于探测车辆左右两侧的障碍物。不过相比之下,APA功率略大,成本略高。

图8 超声波在倒车时的应用示意图。蓝色扇形区域为APA超声波雷达探测范围,透明扇形区域为UPA超声波雷达探测范围。

2.3.5 相机定位

基于图像的相机定位,是基于视觉的定位(Vision-Based Localization,VBL)中的一个重要研究领域。视觉定位是指在一个已知的空间表示(如矢量地图、点云地图等)中,使用视觉类的数据元素,检索出物体位姿(位置和朝向)的方法[13]。这些视觉元素有图像、3D模型和彩色点云等,它们包含光学信息、几何信息和语义信息等。

总体来说,视觉定位有以下优点:1)硬件成本低,技术相对成熟;2)特定场合精度高(如交通标示识别);3)提供的信息量充足;4)信息直观方便。但也有缺点:1)对光照依赖较大,在逆光、强光、黑夜、雾、霾及雨雪天气情况下定位困难;2)纹理少的区域,定位精度低;3)精度依赖图像分辨率、计算量较大,距离较远时物体分辨困难。

这里主要讨论自动驾驶应用场景下的基于图像的视觉定位的几个重要方法[13][15][17][20]:多点透视问题(Perspective n Point,PnP)问题、视觉里程计(Visual Odometry,VO)、路标定位,以及与此关系密切的基于视觉的同步定位与地图构建技术(Visual Simultaneous Localization And Mapping,V-SLAM,或称为视觉SLAM)。

(1)PnP问题

使用相机采集的图像定位车辆,等价于求解相机的位姿(旋转矩阵R和平移向量t)。而解决PnP问题,正是在相机内参、图像坐标系下的2D图像点坐标、对应的世界坐标系下的3D空间点坐标已知情况下,求解相机的外参(R和t)[30]。

PnP问题常见的算法有三种:三点透视(Perspective 3 Point,P3P)、直接线性变换(Direct Linear Transform,DLT)和高效的多点透视(Efficient Perspective n Point,EPnP)。进行矩阵求解时,经常采用正交三角(Quadrature Rectangle,QR)分解或奇异值分解(Singular Value Decomposition,SVD)来加速求解过程(比如比较耗时的矩阵求逆运算)。在解方程过程中,经常需要做非线性优化,捆绑调整(Bundle Adjustment,BA)被认为是一种有效的方法(即以空间点和摄像机矩阵为优化变量、以最小化重投影误差为目标的优化过程[29])。值得一提的是,由于PnP的算法复杂度O(n5)较高,Vincent提出的改进方法EPnP[31]因将复杂度降到了O(n),目前应用比较广泛。

(2)VO

视觉里程计是仅利用单个或多个相机的图像作为输入,评估智能体(如车辆、行人、机器人)自我运动的过程[15][26][28]。 它是由Nister于2004年正式提出[14]。与PnP问题类似,VO也是求解相机的运动,即求相机的位姿。

VO的基本理论框架包含特征提取、特征匹配和运动估计三部分。按照使用图像信息的方式不同,VO可以分为间接法(提取特征点)、直接法(不提取特征,如使用光流估计)和半直接法(以上两者的结合,如SVO[32]);按照使用相机的不同,可以分为单目(Monocular VO)、立体(Stereo VO)和RGB-D视觉里程计[16]。

单目视觉里程计使用单个相机采集图像,进行运动评估。但这并不意味着只可以使用一幅图像,使用同一个相机在不同时刻拍摄的多幅图像进行运动评估也属于单目视觉。它具有如下优点:1)设备简单;2)成本低。当然也有缺点:1)估计目标的绝对尺度较困难(因此有时会结合IMU使用);2)误差会累计。立体视觉里程计使用双目或多目相机(如三目或者全景相机)采集图像,进行运动估计。它的优点有:1)可以在一定范围内获取深度信息;2)在近距离处精度较高(毫米级)。缺点有:1)设备标定复杂;2)成本高、体积稍大;3)测量范围受相机之间的基线的限制(以双目为例,双目距离越远,测量范围越大),超过一定距离时将退化为单目视觉;4)误差也会累计。RGB-D视觉里程计使用RGB-D相机同时采集场景的颜色信息和深度数据,进行运动评估。它有如下优点:1)信息非常丰富;2)深度信息直接获取,节省了计算时间。缺点如下:1)测量范围较小;2)对光照比较敏感。所以目前室内场景应用较多。

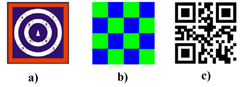

(3)路标定位

该种定位方式指利用环境中,一些具有特殊含义的物体(人工路标或自然路标),作为标志(事先知道其坐标和形状),通过检测该标志进行定位。其优点在于1)简单易用,灵活性高;2)定位速度快;3)精度高。同时也有缺点:需大量人工操作(如真实场景中安装布置路标或在数字地图中进行标定)。人工路标具有各种各样的形式,如同心圆路标、彩色方格路标和二维码等[33](图9所示)。从广义上讲,本文前面提到的V2X定位方式中的RSU(路边单元),是一种电子式的路标。使用自然路标定位的方法则需要找到一些稳定的、不易遮挡的或特征突出的物体(如大型建筑物),并提前在地图中标记其精确位置。当车辆检测到该路标时,根据路标的位置信息,推算出自身的位置。相比人工路标,其特征一般相对复杂。

图9 人工路标定位示例。 a)同心圆路标 b)彩色方格路标 c)二维码路标[33]。

(4)V-SLAM

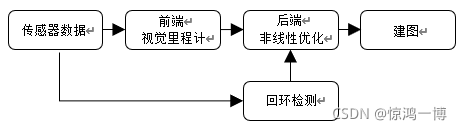

对于视觉定位而言,一个重要的研究课题是SLAM。SLAM要解决的问题是,移动机器人是否有可能在未知环境的未知位置中,逐步构建该环境的一致性地图,同时确定自己在该地图中的位置[34]。V-SLAM重要包含五部分:传感器数据获取、视觉里程计(Visual Odometry,VO,又称前端)、非线性优化(Optimization,又称后端)、回环检测(Loop Closing)和建图(Mapping)。整体流程如图10所示。

图10 视觉SLAM整体流程图[38]

这里可以看出V-SLAM技术将VO和建图的任务结合到了一起。V-SLAM和VO主要的区别在于:前者关注的是全局轨迹一致性,后者关注的是局部轨迹一致性

这里可以看出V-SLAM技术将VO和建图的任务结合到了一起。V-SLAM和VO主要的区别在于:前者关注的是全局轨迹一致性,后者关注的是局部轨迹一致性[15]。

SLAM分类方式有多种。根据数据处理方式的不同,可以分为传统的基于滤波的SLAM(如扩展卡尔曼滤波器、粒子滤波)和基于优化的SLAM(如BA优化、目前主流的基于图优化的SLAM)。按照联动方式,可分为单车SLAM和多车SLAM[35]。根据使用的传感器不同,可以分为激光SLAM和V-SLAM。V-SLAM与VO分类类似,根据使用相机的不同,又可以分为单目SLAM、多目SLAM和RGB-D SLAM。

激光SLAM起步较早,理论和技术都相对比较成熟,是目前较稳定、主流的定位方式。其定位精度高,但成本也较高,给了V-SLAM发展的机会。V-SLAM起步略晚,近年来随着计算机视觉研究的进步,加上其成本低,信息丰富,获得了快速发展。V-SLAM也有自身的局限性:对光照、纹理依赖度高,且计算量较大。目前比较经典的SLAM方案有:首次引入非线性优化和关键帧机制,并实现实时后端处理的PTAM[21](Parallel Tracking And Mapping,G Klein,2007)、基于特征点的实现较完整的ORB-SLAM[22](Oriented FAST and Rotated BRIEF SLAM,R Mur-Artal,2015)、采用单目直接法[27]的可以建立大尺度场景地图的LSD-SLAM[23](Large-Scale Direct Monocular SLAM ,J Engel,2014)、采用半直接法运行速度较快的SVO[24](Semi-direct Visual Odometry,Forster,2014),以及基于机器学习的Pop-up SLAM[25](S Yang,2016)。

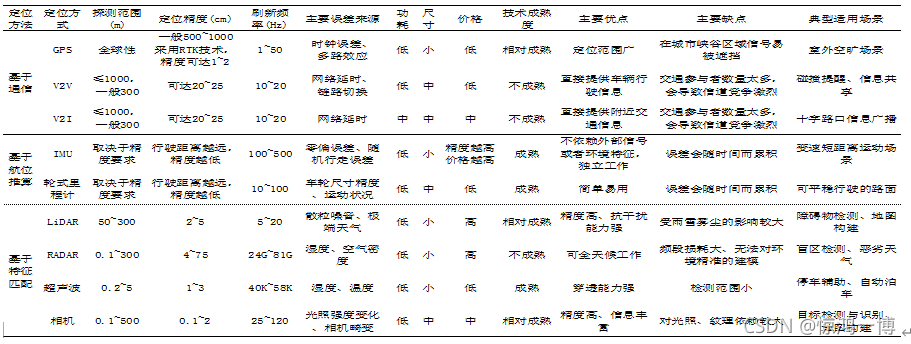

2.4 单个定位方式对比

如上所述,不同的单个定位方式有不同的作用范围和适用场景,本小节对它们做了定量和定性的对比,如表2所示。

表2单个定位方式对比

从表中可以看出,GPS在大场景室外定位中扮演重要角色;V2X提供的精确的信息对车辆定位有较大帮助;IMU因其独立作业的优点,对环境的鲁棒性较好;LiDAR在获取精确的尺度信息和地图构建上很有优势;RADAR定位在兼顾精度和距离的同时,对天气的适应能力更强;相机定位在精度和距离上有很大的发展空间。当然,没有哪种定位方式可以适用于所有场景,最终的决定因素在于用户的需求。

3 典型的融合定位方式

不同的传感器或数据形式,能满足不同的特定需求。但现实环境的情况是复杂的,如天气和季节变化、光照和纹理条件、电磁干扰、道路及周边建筑状况等;而且不同的传感器有不同的固有缺点,需要其他传感器进行弥补。此时出现了融合定位的方式。融合方式及本节内容安排如图11所示。

图11 融合定位方式及本节内容安排

采用融合定位的方式,需要考虑融合的一些关键因素,如探测范围(如距离和角度)、刷新频率、数据规模、数据类型、坐标系的统一、成本和硬件大小等。这些因素共同决定了融合定位的方式。按照融合的内容分为多种传感器融合、多种特征基元融合和几何与语义融合3种[37]。这里我们重点讨论第一种融合方式中的典型方案。几种典型的传感器作用范围示意图如下所示。

图12 各种传感器作用范围示意图[36]

3.1 GPS/IMU融合定位

融合GPS和IMU进行定位是较典型的方式。一方面GPS依赖于外部卫星信号,易受天气、电磁波等的干扰,面临隧道无信号、有多路效应等问题;而IMU不依赖于外部信号,不会受上述因素的影响。一方面IMU有累计误差,而GPS的误差不会累计,所以两者取长补短[2]。但是在这种融合方式下,IMU在匀速运动时加速度计失效的情况,只能靠GPS单方面进行速度估计,不过普通GPS的米级精度对自动驾驶来说是不够的。然而,随着RTK-GPS技术的发展和普及,低成本的厘米级精度的方案也是可以预见的事情。

GPS和IMU的融合方式有两种:松耦合和紧耦合。松耦合的工作原理是两个系统单独工作,得到最终结果(位置和速度)后,再进行卡尔曼滤波,对IMU进行补偿校验。它具有简单易实现的优点,也有定位精度低的缺点。紧耦合将接收到的GPS原始数据直接与IMU的输出一起进行校正,最终得到一个统一的估计结果。它具有精度高的优点,但实现较复杂。基于GPS/IMU定位的方式,还可以与轮式里程计定位相结合。如冼承钧等[40]提出的多传感器融合导航方法,Dedicated Short-Range Communications, DSRC当GPS有效时,使用GPS/IMU定位;当GPS失效时,使用里程计抑制IMU误差的累计,进行定位。

此外人们还提出了不依赖与GNSS的定位,如下面两种融合方式。

3.2 Camera/IMU融合定位

将相机与惯性测量单元进行融合,形成的视觉惯性里程计(Visual-Inertial Odometry,VIO),也是目前较为经典的、低成本的融合定位方式。它们组合在一起的导航系统,被称之为视觉惯性导航系统(Visual-Inertial Navigation System,VINS)。

融合的主要原因在于,相机可以提供丰富的场景信息,但获取尺度信息困难,且受环境(光照、天气等)影响较大,而IMU可提供尺度信息,基本不受环境影响。同时两者成本都较低、功耗小,所以常被用作GNSS无效的情况下、低成本、高精度的定位方案。

作为一个状态估计问题,VINS同样可以分为松耦合和紧耦合融合两种方式。松耦合分别处理相机和IMU的运动约束,然后对约束进行融合。这种方式,优点在于计算效率较高,但解耦合时,会丢失部分信息。而紧耦合在同一个运动过程中,直接进行测量值的融合,精度更高[39]。代表的VINS方案有采用非线性优化、证实紧耦合精度更高的OKVIS[41]和实现完整、鲁棒性较强的VINS-Mono[42]。

3.3 LiDAR/Camera融合定位

相机可以获取丰富的信息,但尺度信息获取较为困难,但LiDAR能获取精确的尺度信息,两者可以优势互补。在制作HD Map过程中,两者都发挥着不可或缺的作用。在车辆行驶过程中,可以通过LiDAR和Camera获取当前位置的特征(如点云信息、车道信息等),然后跟事先已经建立好的HD Map进行对比,实现精确定位。

Xu等人[43]提出使用立体图像匹配3D点云数据(位置、强度等信息)的定位方法。该方法首先将3D点坐标从世界坐标系转换到相机坐标系,然后与图像上对应的点进行对比定位。其定位误差可达0.08m~0.25m。为满足在不同季节变化环境中的定位,Viswanathan等人[44]首先采集不同季节的卫星图像;然后依据LiDAR数据将车辆全景相机拍摄的图像分成地面和非地面部分,再进行变换得到鸟瞰图;最后对比卫星图像的地面部分和上述鸟瞰图以实现定位。Zuo等人[46]为了提高定位的鲁棒性和精度,提出LIC-Fusion,使用多状态约束卡尔曼滤波器(Multi-State Constraint Kalman Filter,MSCKF)架构,将LiDAR、IMU和Camera进行数据融合。与此融合方式类似的工作,还有Zhao[47]提出的融合了VIO和激光里程计(Lidar Odometry and Mapping,LOAM[48])、将精度优化到1cm的VIL-SLAM。

当然欲达到自动驾驶的高精度、高可靠性,定位信息应该有冗余,以便于在某一个传感器失效时,系统还能正常工作。下面探讨多种传感器混合的定位方式。

3.4 多种方式混合定位

自动驾驶是一个综合性的任务,同一个传感器不一定只能满足一种需求(如使用相机可以用于定位,也可以用于检测目标、分析语义);同样,多个传感器可能都具备某一种功能(如定位)。所以,充分发挥每一种传感器的功能,是十分有意义的。

百度Apollo项目组的Wan等人[49],提出基于RTK-GNSS/IMU/LiDAR融合的定位方案。其充分利用LiDAR的强度和高度信息,在预先建立好的GMM(Gaussian Mixture Model)网格单元地图上进行初步定位,然后融合RTK和IMU的定位结果,在复杂场景下(市区道路、隧道)达到5cm~10cm的横向和纵向精度。与此类似,Levinson等人[50]同样使用GPS/IMU/LiDAR及概率网格地图以实现高精度的定位;不同的是,该方法使用Bayes推理以减少地图元素的不确定性,并试图通过离线SLAM方法对地图中的环境元素作对齐操作,以提高在动态环境中定位的鲁棒性。

但是使用RTK或者LiDAR意味着成本较高。Suhr等人[51]提出基于粒子滤波(Particle Filter,PF)的GPS/IMU/Camera融合的低成本定位方式。其使用道路标记(symbolic road marking,SRM,如车道线、直行箭头和左转箭头等)制作轻量级的地图,再使用相机检测这些特定标记得到初步的位置信息,然后融合GPS/IMU/里程计的信息实现定位。不过该方式在没有道路标记的地方,精度会有所下降。

4 总结与展望

作为自动驾驶中的基本而又关键的问题,定位被人们广泛研究。虽然目前已经有很多的成果,但面对信号干扰或丢失、剧烈晃动、动态物体、极端天气、季节变化、物体遮挡、缺乏纹理、光照不佳等场景,定位效果仍然不尽人意。目前业界中Google主要采用以LiDAR为主的定位方案;Tesla和Mobileye选择以视觉为主的定位方案;而Bosch更倾向于毫米波雷达为主的定位方案。它们都具备一定的适应性和局限性。

当前,多传感器融合是研究者们普遍认可的高精定位解决方案之一,根据各个传感器的特性取长补短。特别是基于LiDAR或基于视觉的、在复杂环境中的融合定位方案,是目前研究的热点。虽然融合的传感器越多,意味着系统的复杂度越高,但系统的鲁棒性和安全性也会提高。V2X技术虽然面临着网络拥堵、信息安全、需大量基础设施成本投入的问题,但因其信息共享机制、分布式服务、协同合作等固有优势,将极大推动自动驾驶的发展。与此同时,高精地图的日益发展对自动驾驶,包含定位在内的问题,发挥越来越重要的作用。虽然高精地图还面临着标准不统一、数据采集和数据标注耗时耗力等问题,但是随着云技术、5G和OTA的发展,它会在离线数据处理和在线实时更新等方面找到一个平衡点。

参考文献

- Kuutti S, Fallah S, Katsaros K, et al. A survey of the state-of-the-art localization techniques and their potentials for autonomous vehicle applications[J]. IEEE Internet of Things Journal, 2018, 5(2): 829-846.

- Yurtsever E, Lambert J, Carballo A, et al. A survey of autonomous driving: Common practices and emerging technologies[J]. IEEE Access, 2020, 8: 58443-58469.

- Jo K, Kim J, Kim D, et al. Development of autonomous car—Part I: Distributed system architecture and development process[J]. IEEE Transactions on Industrial Electronics, 2014, 61(12): 7131-7140.

- Groves P D. Principles of GNSS, inertial, and multisensor integrated navigation systems, [Book review][J]. IEEE Aerospace and Electronic Systems Magazine, 2015, 30(2): 26-27.

- 中国智能网联汽车产业创新联盟自动驾驶地图与定位工作组.自动驾驶地图与定位技术产业发展报告[J].智能网联汽车,2019,(3):58-67.

- 陈山枝,时岩,胡金玲.蜂窝车联网(C-V2X)综述[J].中国科学基金,2020,34(02):179-185.

- Harding J, Powell G, Yoon R, et al. Vehicle-to-vehicle communications: readiness of V2V technology for application[R]. United States. National Highway Traffic Safety Administration, 2014.

- Del Peral-Rosado J A, López-Salcedo J A, Kim S, et al. Feasibility study of 5G-based localization for assisted driving[C].2016 International Conference on Localization and GNSS (ICL-GNSS). IEEE, 2016: 1-6.

- Levi R W, Judd T. Dead reckoning navigational system using accelerometer to measure foot impacts: U.S. Patent 5,583,776[P]. 1996-12-10.

- Liu R, Wang J, Zhang B. High definition map for automated driving: Overview and analysis[J]. The Journal of Navigation, 2020, 73(2): 324-341.

- Elhousni M, Huang X. Review on 3D Lidar Localization for Autonomous Driving Cars[J]. arXiv preprint arXiv:2006.00648, 2020.

- KEYSIGHTCN.智能化、网联化、新能源化——未来汽车的技术迭代[EB/OL]. http://news.eeworld.com.cn/mp/KEYSIGHT/a64133.jspx 2019-04-10/2020-06-08

- Piasco N, Sidibé D, Demonceaux C, et al. A survey on visual-based localization: On the benefit of heterogeneous data[J]. Pattern Recognition, 2018, 74: 90-109.

- Nistér D, Naroditsky O, Bergen J. Visual odometry[C]//Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition, 2004. CVPR 2004. Ieee, 2004, 1: I-I.

- Scaramuzza D, Fraundorfer F. Visual odometry [tutorial][J]. IEEE robotics & automation magazine, 2011, 18(4): 80-92.

- 慈文彦, 黄影平, 胡兴. 视觉里程计算法研究综述[J]. 计算机应用研究, 2019 (9): 1.

- 马玉娇. 基于立体视觉里程计的移动机器人定位研究[D]. 武汉科技大学, 2009.

- Moravec H P. Obstacle avoidance and navigation in the real world by a seeing robot rover[R]. Stanford Univ Ca Dept of Computer Science, 1980.

- Yousif K, Bab-Hadiashar A, Hoseinnezhad R. An overview to visual odometry and visual SLAM: Applications to mobile robotics[J]. Intelligent Industrial Systems, 2015, 1(4): 289-311.

- Wu Y, Tang F, Li H. Image-based camera localization: an overview[J]. Visual Computing for Industry, Biomedicine, and Art, 2018, 1(1): 1-13.

- Klein G, Murray D. Parallel tracking and mapping on a camera phone[C]//2009 8th IEEE International Symposium on Mixed and Augmented Reality. IEEE, 2009: 83-86.

- Mur-Artal R, Montiel J M M, Tardos J D. ORB-SLAM: a versatile and accurate monocular SLAM system[J]. IEEE transactions on robotics, 2015, 31(5): 1147-1163.

- Engel J, Schöps T, Cremers D. LSD-SLAM: Large-scale direct monocular SLAM[C]//European conference on computer vision. Springer, Cham, 2014: 834-849.

- Forster C, Pizzoli M, Scaramuzza D. SVO: Fast semi-direct monocular visual odometry[C]//2014 IEEE international conference on robotics and automation (ICRA). IEEE, 2014: 15-22.

- Yang S, Song Y, Kaess M, et al. Pop-up slam: Semantic monocular plane slam for low-texture environments[C]//2016 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE, 2016: 1222-1229.

- 俞毓锋, 赵卉菁, 崔锦实, 等. 基于道路结构特征的智能车单目视觉定位[J]. 自动化学报, 2017, 43(5): 725-734.

- 潘林豪, 田福庆, 应文健, 等. 基于直接法的视觉同时定位与地图构建技术综述[J]. 计算机应用研究, 2019, 36(4): 961-966.

- 赵霞, 袁家政, 刘宏哲. 基于视觉的目标定位技术的研究进展[J]. 计算机科学, 2016, 43(6): 10-16.

- 吴福朝. 计算机视觉中的数学方法[M]. 科学出版社, 2008.

- Hartley R, Zisserman A. Multiple view geometry in computer vision[M]. Cambridge university press, 2003.

- Lepetit V, Moreno-Noguer F, Fua P. Epnp: An accurate o (n) solution to the pnp problem[J]. International journal of computer vision, 2009, 81(2): 155.

- Forster C, Pizzoli M, Scaramuzza D. SVO: Fast semi-direct monocular visual odometry[C]//2014 IEEE international conference on robotics and automation (ICRA). IEEE, 2014: 15-22.

- 许磊.基于角点特征匹配的机器人路标定位方法研究[D].重庆:重庆大学,2018.

- Durrant-Whyte H, Bailey T. Simultaneous localization and mapping: part I[J]. IEEE robotics & automation magazine, 2006, 13(2): 99-110.

- Bresson G, Alsayed Z, Yu L, et al. Simultaneous localization and mapping: A survey of current trends in autonomous driving[J]. IEEE Transactions on Intelligent Vehicles, 2017, 2(3): 194-220.

- Bram Geenen A, Ali Nasseri V, Adriaan Schiphorst A. 2020 AUTONOMOUS VEHICLE TECHNOLOGY REPORT[ER/OL] https://www.wevolver.com/article/2020.autonomous.vehicle.technology.report 2020-03-06/2020-06-12

- 刘勇. 多源融合SLAM-现状与挑战[R]. 第二届全国SLAM技术论坛, 清华大学, 中国图象图形学学会(CSIG), 2019-7-27

- 高翔. 视觉 SLAM 十四讲: 从理论到实践[M]. 电子工业出版社, 2017.

- Huang G. Visual-inertial navigation: A concise review[C]//2019 International Conference on Robotics and Automation (ICRA). IEEE, 2019: 9572-9582.

- 冼承钧,徐铭鸿,时广轶,王春波,吴志刚,徐开明,金玉丰. 基于多传感器融合的组合导航方法及系统[P]. 江苏省:CN111141273A,2020-05-12.

- Leutenegger S, Furgale P, Rabaud V, et al. Keyframe-based visual-inertial slam using nonlinear optimization[J]. Proceedings of Robotis Science and Systems (RSS) 2013, 2013.

- Qin T, Li P, Shen S. Vins-mono: A robust and versatile monocular visual-inertial state estimator[J]. IEEE Transactions on Robotics, 2018, 34(4): 1004-1020.

- Xu Y, John V, Mita S, et al. 3D point cloud map based vehicle localization using stereo camera[C]//2017 IEEE Intelligent Vehicles Symposium (IV). IEEE, 2017: 487-492.

- Viswanathan A, Pires B R, Huber D. Vision-based robot localization across seasons and in remote locations[C]//2016 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2016: 4815-4821.

- Badue C, Guidolini R, Carneiro R V, et al. Self-driving cars: A survey[J]. arXiv preprint arXiv:1901.04407, 2019.

- Zuo X, Geneva P, Lee W, et al. LIC-Fusion: LiDAR-Inertial-Camera Odometry[J]. arXiv preprint arXiv:1909.04102, 2019.

- Shao W, Vijayarangan S, Li C, et al. Stereo visual inertial lidar simultaneous localization and mapping[J]. arXiv preprint arXiv:1902.10741, 2019.

- Zhang J, Singh S. LOAM: Lidar Odometry and Mapping in Real-time[C]//Robotics: Science and Systems. 2014, 2(9).

- Wan G, Yang X, Cai R, et al. Robust and precise vehicle localization based on multi-sensor fusion in diverse city scenes[C]//2018 IEEE International Conference on Robotics and Automation (ICRA). IEEE, 2018: 4670-4677.

- Levinson J, Thrun S. Robust vehicle localization in urban environments using probabilistic maps[C]//2010 IEEE International Conference on Robotics and Automation. IEEE, 2010: 4372-4378.

- Suhr J K, Jang J, Min D, et al. Sensor fusion-based low-cost vehicle localization system for complex urban environments[J]. IEEE Transactions on Intelligent Transportation Systems, 2016, 18(5): 1078-1086.