NIO 的类库和 API 繁杂,使用麻烦:需要熟练掌握Selector、 ServerSocketChannel、 SocketChannel、 ByteBuffer等。 开发工作量和难度都非常大: 例如客户端面临断线重连、 网络闪断、心跳处理、半包读写、 网络拥塞和异常流的处理等等。

Netty 对 JDK 自带的 NIO 的 API 进行了良好的封装,解决了上述问题。且Netty拥有高性能、吞吐量更高,延迟更低,减少资源消耗,最小化不必要的内存复制等优点。

NIO具体特点及用法可以参考《I/O多路复用原理》

Netty使用场景:

在分布式系统中,各个节点之间需要远程服务调用,高性能的 RPC 框架必不可少,Netty 作为异步高性能的通信框架,往往作为基础通信组件被这些 RPC 框架使用。典型的应用有:阿里分布式服务框架 Dubbo 的 RPC 框架使用 Dubbo 协议进行节点间通信,Dubbo 协议默认使用 Netty 作为基础通信组件,用于实现。各进程节点之间的内部通信。Rocketmq底层也是用的Netty作为基础通信组件。

Netty通讯实示例

服务端代码示例:

public class NettyServer {public static void main(String[] args) throws Exception {// 创建两个线程组bossGroup和workerGroup, 含有的子线程NioEventLoop的个数默认为cpu核数的两倍// bossGroup只是处理连接请求 ,真正的和客户端业务处理,会交给workerGroup完成EventLoopGroup bossGroup = new NioEventLoopGroup(1);EventLoopGroup workerGroup = new NioEventLoopGroup(8);try {// 创建服务器端的启动对象ServerBootstrap bootstrap = new ServerBootstrap();// 使用链式编程来配置参数bootstrap.group(bossGroup, workerGroup) //设置两个线程组// 使用NioServerSocketChannel作为服务器的通道实现.channel(NioServerSocketChannel.class)// 初始化服务器连接队列大小,服务端处理客户端连接请求是顺序处理的,所以同一时间只能处理一个客户端连接。// 多个客户端同时来的时候,服务端将不能处理的客户端连接请求放在队列中等待处理.option(ChannelOption.SO_BACKLOG, 1024)//创建通道初始化对象,设置初始化参数,在SocketChannel建立起来之前执行.childHandler(new ChannelInitializer<SocketChannel>() {@Overrideprotected void initChannel(SocketChannel ch) throws Exception {//对workerGroup的SocketChannel设置处理器ch.pipeline().addLast(new NettyServerHandler());}});System.out.println("netty server start。。");// 绑定一个端口并且同步, 生成了一个ChannelFuture异步对象,通过isDone()等方法可以判断异步事件的执行情况// 启动服务器(并绑定端口),bind是异步操作,sync()方法是等待异步操作执行完毕ChannelFuture cf = bootstrap.bind(9000).sync();// 等待服务端监听端口关闭,closeFuture是异步操作// 通过sync方法同步等待通道关闭处理完毕,这里会阻塞等待通道关闭完成,内部调用的是Object的wait()方法cf.channel().closeFuture().sync();} finally {bossGroup.shutdownGracefully();workerGroup.shutdownGracefully();}}}---------------------------------------------------------------------/*** 自定义Handler需要继承netty规定好的某个HandlerAdapter(规范)*/public class NettyServerHandler extends ChannelInboundHandlerAdapter {/*** 当客户端连接服务器完成就会触发该方法** @param ctx* @throws Exception*/@Overridepublic void channelActive(ChannelHandlerContext ctx) {System.out.println("客户端连接通道建立完成");}/*** 读取客户端发送的数据** @param ctx 上下文对象, 含有通道channel,管道pipeline* @param msg 就是客户端发送的数据* @throws Exception*/@Overridepublic void channelRead(ChannelHandlerContext ctx, Object msg) {//Channel channel = ctx.channel();//ChannelPipeline pipeline = ctx.pipeline(); //本质是一个双向链接, 出站入站//将 msg 转成一个 ByteBuf,类似NIO 的 ByteBufferByteBuf buf = (ByteBuf) msg;System.out.println("收到客户端的消息:" + buf.toString(CharsetUtil.UTF_8));}/*** 数据读取完毕处理方法** @param ctx* @throws Exception*/@Overridepublic void channelReadComplete(ChannelHandlerContext ctx) {ByteBuf buf = Unpooled.copiedBuffer("HelloClient".getBytes(CharsetUtil.UTF_8));ctx.writeAndFlush(buf);}/*** 处理异常, 一般是需要关闭通道** @param ctx* @param cause* @throws Exception*/@Overridepublic void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) {ctx.close();}}

客户端代码:

public class NettyClient {public static void main(String[] args) throws Exception {//客户端需要一个事件循环组EventLoopGroup group = new NioEventLoopGroup();try {//创建客户端启动对象//注意客户端使用的不是ServerBootstrap而是BootstrapBootstrap bootstrap = new Bootstrap();//设置相关参数bootstrap.group(group) //设置线程组.channel(NioSocketChannel.class) // 使用NioSocketChannel作为客户端的通道实现.handler(new ChannelInitializer<SocketChannel>() {@Overrideprotected void initChannel(SocketChannel ch) throws Exception {//加入处理器ch.pipeline().addLast(new NettyClientHandler());}});System.out.println("netty client start。。");//启动客户端去连接服务器端ChannelFuture cf = bootstrap.connect("127.0.0.1", 9000).sync();//对通道关闭进行监听cf.channel().closeFuture().sync();} finally {group.shutdownGracefully();}}}----------------------------------------------public class NettyClientHandler extends ChannelInboundHandlerAdapter {/*** 当客户端连接服务器完成就会触发该方法** @param ctx* @throws Exception*/@Overridepublic void channelActive(ChannelHandlerContext ctx) {ByteBuf buf = Unpooled.copiedBuffer("HelloServer".getBytes(CharsetUtil.UTF_8));ctx.writeAndFlush(buf);}//当通道有读取事件时会触发,即服务端发送数据给客户端@Overridepublic void channelRead(ChannelHandlerContext ctx, Object msg) {ByteBuf buf = (ByteBuf) msg;System.out.println("收到服务端的消息:" + buf.toString(CharsetUtil.UTF_8));}@Overridepublic void exceptionCaught(ChannelHandlerContext ctx, Throwable cause) {cause.printStackTrace();ctx.close();}}

看完以上代码,我们可以发现很多写法都是Netty规定好了,我们只需要编写专注于业务处理的Handler。这也是Netty框架的一大特点,让你的业务逻辑从网络基础应用编码中分离出来,让你可以专注业务的开发,而不需写一大堆类似NIO的网络处理操作。

Netty模块组件

NioEventLoopGroup

相当于一个事件循环线程组, 这个组中含有多个事件循环线程,每一个事件循环线程是NioEventLoop,NioEventLoopGroup主要管理 eventLoop 的生命周期,可以理解为一个线程池,内部维护了一组线程,每个线程负责处理多个 Channel 上的事件,而一个 Channel 只对应于一个线程。

NioEventLoop

每个NioEventLoop都有一个selector , 用于监听注册在其上的socketChannel的网络通讯,NioEventLoop 中维护了一个任务队列,支持异步提交执行任务,线程启动时会调用 NioEventLoop 的 run 方法,执行 I/O 任务和非 I/O 任务:

- I/O 任务:即 selectionKey 中 ready 的事件,如 accept、connect、read、write 等,由 processSelectedKeys() 方法触发

- 非 IO 任务:添加到 taskQueue 中的任务,如 register0,由 runAllTasks() 方法触发

BootStrap、ServerBootStrap

Bootstrap 意思是引导,一个 Netty 应用通常由一个 Bootstrap 开始,主要作用是配置整个 Netty 程序,串联各个组件,Netty 中 Bootstrap 类是客户端程序的启动引导类,ServerBootstrap 是服务端启动引导类

Future、ChannelFuture

在 Netty 中大部分的 IO 操作都是异步的,不能立刻得知消息是否被正确处理。 但是可以过一会等它执行完成或者直接注册一个监听,具体的实现就是通过 Future 和ChannelFutures,他们可以注册一个监听,当操作执行成功或失败时监听会自动触发注册的监听事件。

ChannelHandler

ChannelHandler 是一个接口,处理 I/O 事件或拦截 I/O 操作,并将其转发到其ChannelPipeline中的下一个处理程序。 ChannelHandler 本身并没有提供很多方法,因为这个接口有许多的方法需要实现,方便使用期间,可以继承它的子类:

- ChannelInboundHandler 用于处理入站 I/O 事件

- ChannelOutboundHandler 用于处理出站 I/O 操作

ChannelHandlerContext

保存 Channel 相关的所有上下文信息,同时关联一个 ChannelHandler 对象。

ChannelPipeline

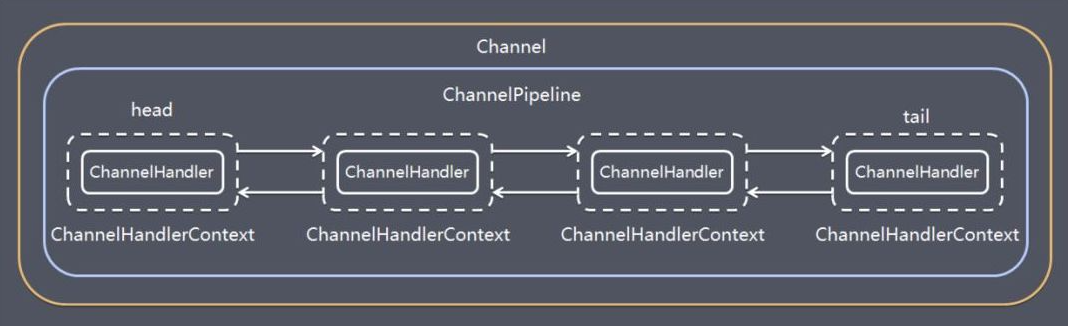

保存 ChannelHandler 的 List,用于处理或拦截 Channel 的入站事件和出站操作。 ChannelPipeline 实现了一种高级形式的拦截过滤器模式,使用户可以完全控制事件的处理方式,以及 Channel 中各 个的 ChannelHandler 如何相互交互。 在 Netty 中每个 Channel 都有且仅有一个 ChannelPipeline 与之对应,它们的组成关系如下:

一个 Channel 包含了一个 ChannelPipeline,而 ChannelPipeline 中又维护了一个由 ChannelHandlerContext 组成的双向链表,并且每个 ChannelHandlerContext 中又关联着一个 ChannelHandler。 read事件(入站事件)和write事件(出站事件)在一个双向链表中,入站事件会从链表 head 往后传递到最后一个入站的 handler,出站事件会从链表 tail 往前传递到最前一个出站的 handler,两种类型的 handler 互不干扰

Netty线程模型

Netty线程模型是基于主从Reactor模型演变而来

Reactor模型相关特点可以阅读《Reactor线程模型》

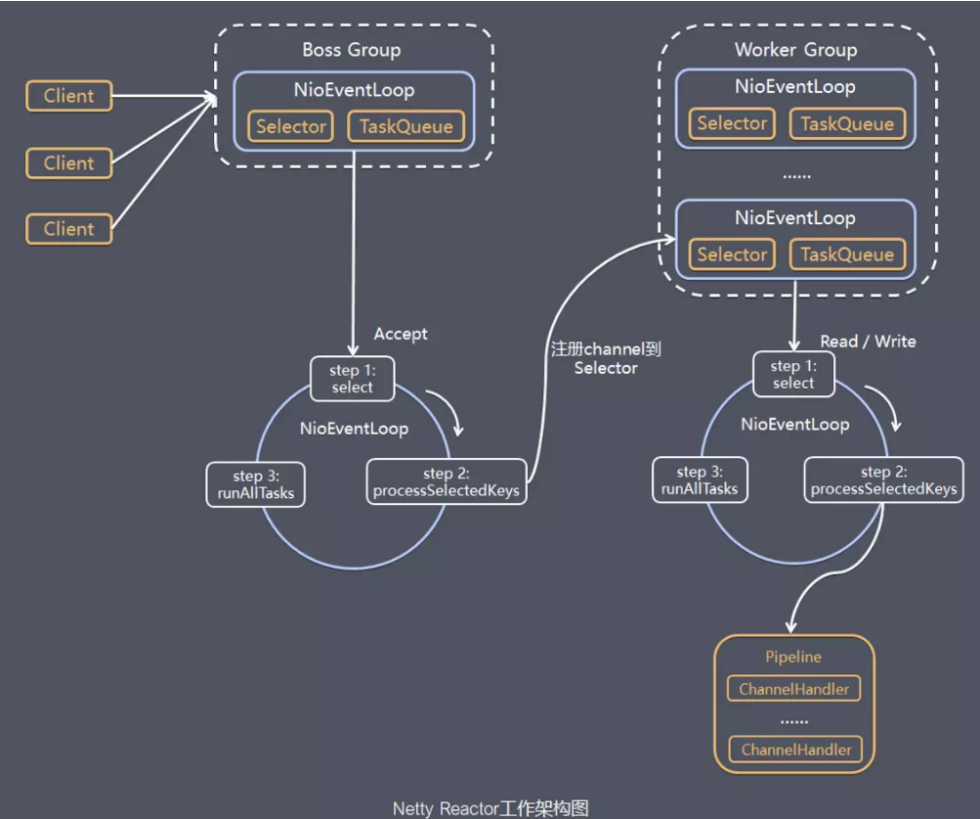

- BossGroup:专门负责接收客户端的连接

- workerGroup:专门负责网络的读写(BossGroup和WorkerGroup类型都是NioEventLoopGroup )

- 每个BossGroup 中 NioEventLoop 内部循环执行的步骤

- 处理accept事件 , 与client 建立连接 , 生成 NioSocketChannel

- 将NioSocketChannel注册到某个workerGroup 的 NioEventLoop上的selector

- 处理任务队列的任务 , 即runAllTasks

- 每个workerGroup 中 NioEventLoop线程循环执行的步骤

- 轮询注册到自己selector上的所有NioSocketChannel 的read, write事件

- 处理 I/O 事件, 即read , write 事件, 在对应NioSocketChannel 处理业务

- runAllTasks处理任务队列TaskQueue的任务 ,一些耗时的业务处理一般可以放入TaskQueue中慢慢处理,这样不影响数据在 pipeline 中的流动处理

- 每个 NioEventLoop 处理 NioSocketChannel 业务时,会使用 pipeline,管道中维护了很多 handler 处理器用来处理 channel 中的数据