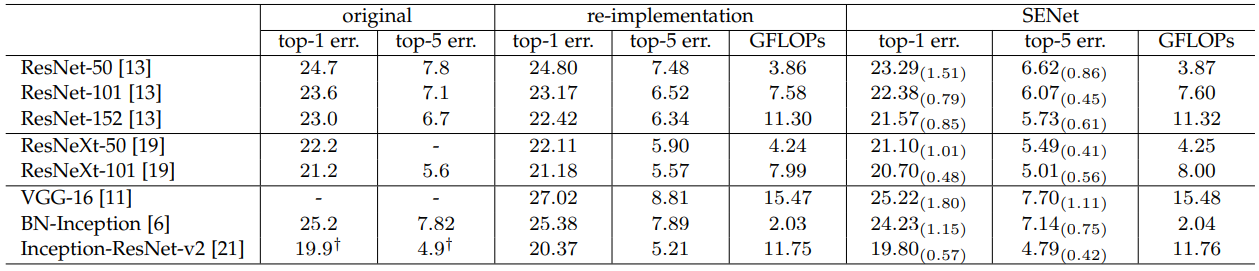

SE Net

论文:Squeeze-and-Excitation Networks

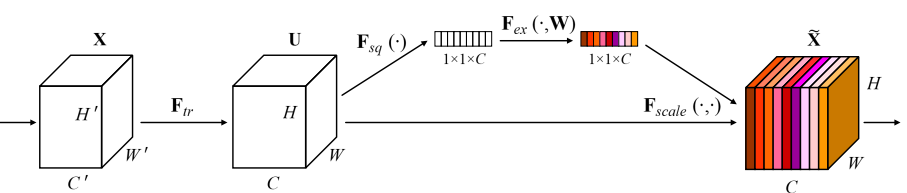

提出了SE模块,是注意力机制的一种,希望模型能够更多的关注信息量大的通道而忽略信息量小的通道。SE模块的核心是将卷积后得到的FeatureMap中的每一个通道都乘以一个不同的数以起到通道级注意力机制的作用。SE Net本身不是一种网络结构,但它可以非常方便地将SE模块嵌入到其它网络中获得可观的性能提升。

↑↑↑↑↑图中Ftr是传统卷积过程,Fsq是squeeze操作,Fex是excitation操作。

传统卷积层中的每一个滤波器都是在其感知域内进行操作,因此无法利用到感知域外的上下文信息,为了解决这个问题作者引入了squeeze,将FeatrueMap从CHW压缩为了C11,去除所有空间信息,得到全局信息以进行辅助。论文中作者直接用了最简单的全局平均池化,当然用其它方法也可以。

为了能够良好地应用每个通道内的全局信息,需要对压缩后的结果做一定的特征提取。都拉平了提取特征肯定只能用全连接了,论文中作者引入了一个bottleneck结构,做了两层全连接,和

,其中第一层全连接使用传统的激活函数ReLU,第二层的输出需要直接和FeatureMap相乘,需要将范围框定在0~1范围内(想想SE注意力机制的初衷,抑制信息量少的通道),因此选用Sigmoid做激活函数。通常取

。

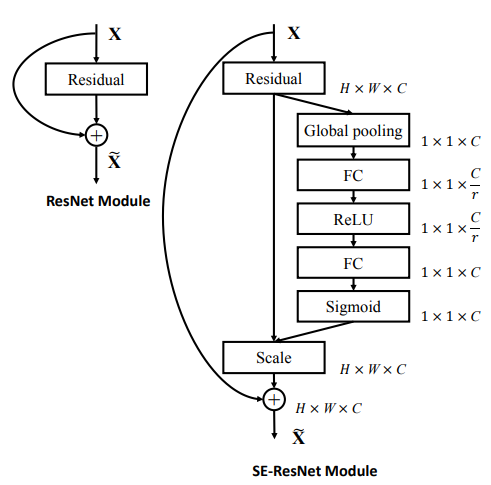

以vgg为代表的非残差网络中,每层权重层后都加SE模块(加在conv、bn、relu后,下一个conv前),以ResNet为代表的残差网络中,每个残差单元加SE模块,如上图所示(第一层卷积不加SE模块)。