任务说明

- 学习主题:论文分类(数据建模任务),利用已有数据建模,对新论文进行类别分类;

- 学习内容:使用论文标题完成类别分类;

-

数据处理步骤

在原始arxiv论文中论文都有对应的类别,而论文类别是作者填写的。在本次任务中我们可以借助论文的标题和摘要完成:

对论文标题和摘要进行处理;

- 对论文类别进行处理;

-

文本分类思路

思路1:TF-IDF+机器学习分类器

直接使用TF-IDF对文本提取特征,使用分类器进行分类,分类器的选择上可以使用SVM、LR、XGboost等

- 思路2:FastText

FastText是入门款的词向量,利用Facebook提供的FastText工具,可以快速构建分类器

- 思路3:WordVec+深度学习分类器

WordVec是进阶款的词向量,并通过构建深度学习分类完成分类。深度学习分类的网络结构可以选择TextCNN、TextRnn或者BiLSTM。

- 思路4:Bert词向量

具体代码实现以及讲解

为了方便大家入门文本分类,我们选择思路1和思路2给大家讲解。首先完成字段读取:

# 导入所需的packageimport seaborn as sns #用于画图from bs4 import BeautifulSoup #用于爬取arxiv的数据import re #用于正则表达式,匹配字符串的模式import requests #用于网络连接,发送网络请求,使用域名获取对应信息import json #读取数据,我们的数据为json格式的import pandas as pd #数据处理,数据分析import matplotlib.pyplot as plt #画图工具

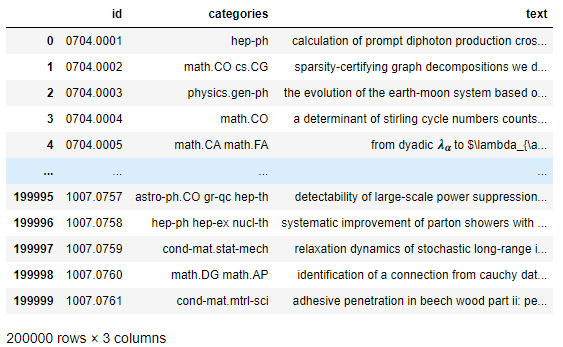

def readArxivFile(path, columns=['id', 'submitter', 'authors', 'title', 'comments', 'journal-ref', 'doi','report-no', 'categories', 'license', 'abstract', 'versions','update_date', 'authors_parsed'], count=None):'''定义读取文件的函数path: 文件路径columns: 需要选择的列count: 读取行数'''data = []with open(path, 'r') as f:for idx, line in enumerate(f):if idx == count:breakd = json.loads(line)d = {col : d[col] for col in columns}data.append(d)data = pd.DataFrame(data)return datadata = readArxivFile('arxiv-metadata-oai-snapshot.json',['id', 'title', 'categories', 'abstract'],200000)

为了方便数据的处理,我们可以将标题和摘要拼接一起完成分类。

data['text'] = data['title'] + data['abstract']data['text'] = data['text'].apply(lambda x: x.replace('\n',' '))data['text'] = data['text'].apply(lambda x: x.lower())data = data.drop(['abstract', 'title'], axis=1) # 删掉abstract 和 title列

看一下data的样子:

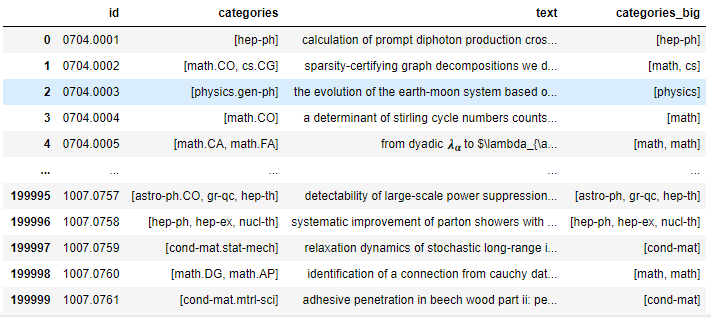

# 多个类别,包含子分类data['categories'] = data['categories'].apply(lambda x : x.split(' '))# 单个类别,不包含子分类data['categories_big'] = data['categories'].apply(lambda x : [xx.split('.')[0] for xx in x]) # 取每个类别的第一个data

然后将类别进行编码,这里类别是多个,所以需要多编码:

from sklearn.preprocessing import MultiLabelBinarizermlb = MultiLabelBinarizer()data_label = mlb.fit_transform(data['categories_big'].iloc[:])

思路1

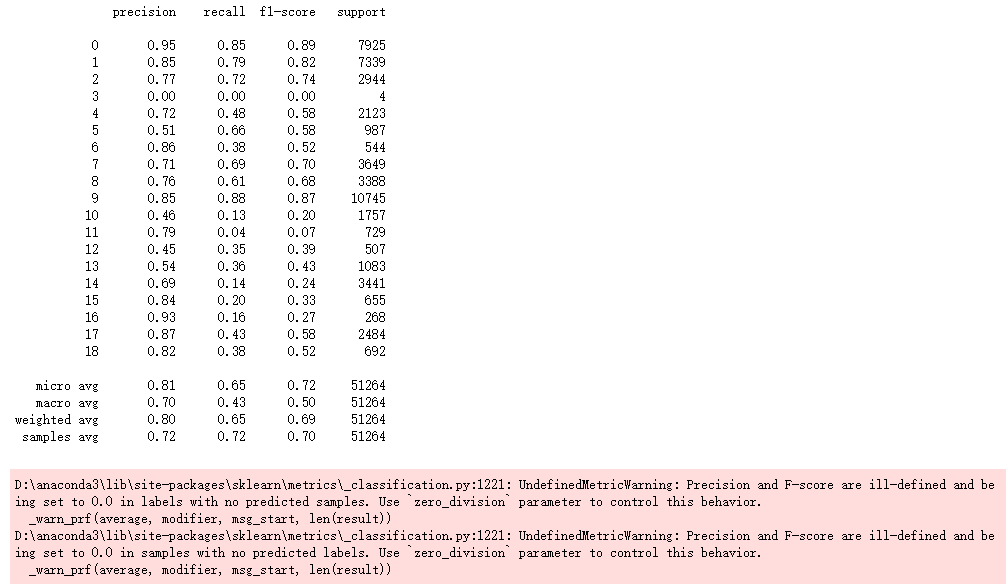

思路1使用TFIDF提取特征,限制最多4000个单词:

from sklearn.feature_extraction.text import TfidfVectorizervectorizer = TfidfVectorizer(max_features=4000)data_tfidf = vectorizer.fit_transform(data['text'].iloc[:])

由于这里是多标签分类,可以使用sklearn的多标签分类进行封装:

# 划分训练集和验证集from sklearn.model_selection import train_test_splitx_train, x_test, y_train, y_test = train_test_split(data_tfidf, data_label,test_size = 0.2,random_state = 1)# 构建多标签分类模型from sklearn.multioutput import MultiOutputClassifier # 多输出分类,可以支持任何分类器from sklearn.naive_bayes import MultinomialNBclf = MultiOutputClassifier(MultinomialNB()).fit(x_train, y_train)

from sklearn.metrics import classification_reportprint(classification_report(y_test, clf.predict(x_test)))

这里出现warning是因为存在一些样本 label 为 y_true,但是 y_pred 并没有预测到。但是又因为,要计算所有分类结果的平均得分就必须将这项得分为 0 的情况考虑进去,所以,scikit-learn出来提醒你,warning警告一下。

思路2(深度学习还没开始看)

思路2使用深度学习模型,单词进行词嵌入然后训练。将数据集处理进行编码,并进行截断:

from sklearn.model_selection import train_test_splitx_train, x_test, y_train, y_test = train_test_split(data['text'].iloc[:100000],data_label[:100000],test_size = 0.95,random_state = 1)

# parametermax_features= 500max_len= 150embed_size=100batch_size = 128epochs = 5from keras.preprocessing.text import Tokenizerfrom keras.preprocessing import sequencetokens = Tokenizer(num_words = max_features)tokens.fit_on_texts(list(data['text'].iloc[:100000]))y_train = data_label[:100000]x_sub_train = tokens.texts_to_sequences(data['text'].iloc[:100000])x_sub_train = sequence.pad_sequences(x_sub_train, maxlen=max_len)

定义模型并完成训练:

# LSTM model# Keras Layers:from keras.layers import Dense,Input,LSTM,Bidirectional,Activation,Conv1D,GRUfrom keras.layers import Dropout,Embedding,GlobalMaxPooling1D, MaxPooling1D, Add, Flattenfrom keras.layers import GlobalAveragePooling1D, GlobalMaxPooling1D, concatenate, SpatialDropout1D# Keras Callback Functions:from keras.callbacks import Callbackfrom keras.callbacks import EarlyStopping,ModelCheckpointfrom keras import initializers, regularizers, constraints, optimizers, layers, callbacksfrom keras.models import Modelfrom keras.optimizers import Adamsequence_input = Input(shape=(max_len, ))x = Embedding(max_features, embed_size, trainable=True)(sequence_input)x = SpatialDropout1D(0.2)(x)x = Bidirectional(GRU(128, return_sequences=True,dropout=0.1,recurrent_dropout=0.1))(x)x = Conv1D(64, kernel_size = 3, padding = "valid", kernel_initializer = "glorot_uniform")(x)avg_pool = GlobalAveragePooling1D()(x)max_pool = GlobalMaxPooling1D()(x)x = concatenate([avg_pool, max_pool])preds = Dense(19, activation="sigmoid")(x)model = Model(sequence_input, preds)model.compile(loss='binary_crossentropy',optimizer=Adam(lr=1e-3),metrics=['accuracy'])model.fit(x_sub_train, y_train,batch_size=batch_size,validation_split=0.2,epochs=epochs)