任务说明

- 任务主题:论文代码统计,统计所有论文出现代码的相关统计;

- 任务内容:使用正则表达式统计代码连接、页数和图表数据;

-

数据处理步骤

在原始arxiv数据集中作者经常会在论文的

comments或abstract字段中给出具体的代码链接,所以我们需要从这些字段里面找出代码的链接。 确定数据出现的位置;

- 使用正则表达式完成匹配;

-

正则表达式

正则表达式(regular expression)描述了一种字符串匹配的模式(pattern),可以用来检查一个串是否含有某种子串、将匹配的子串替换或者从某个串中取出符合某个条件的子串等。

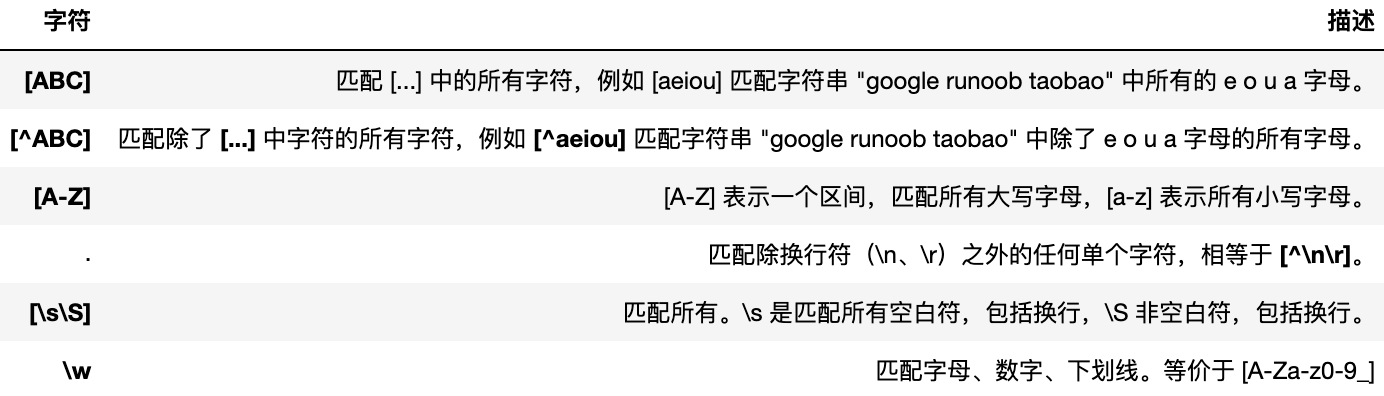

普通字符:大写和小写字母、所有数字、所有标点符号和一些其他符号

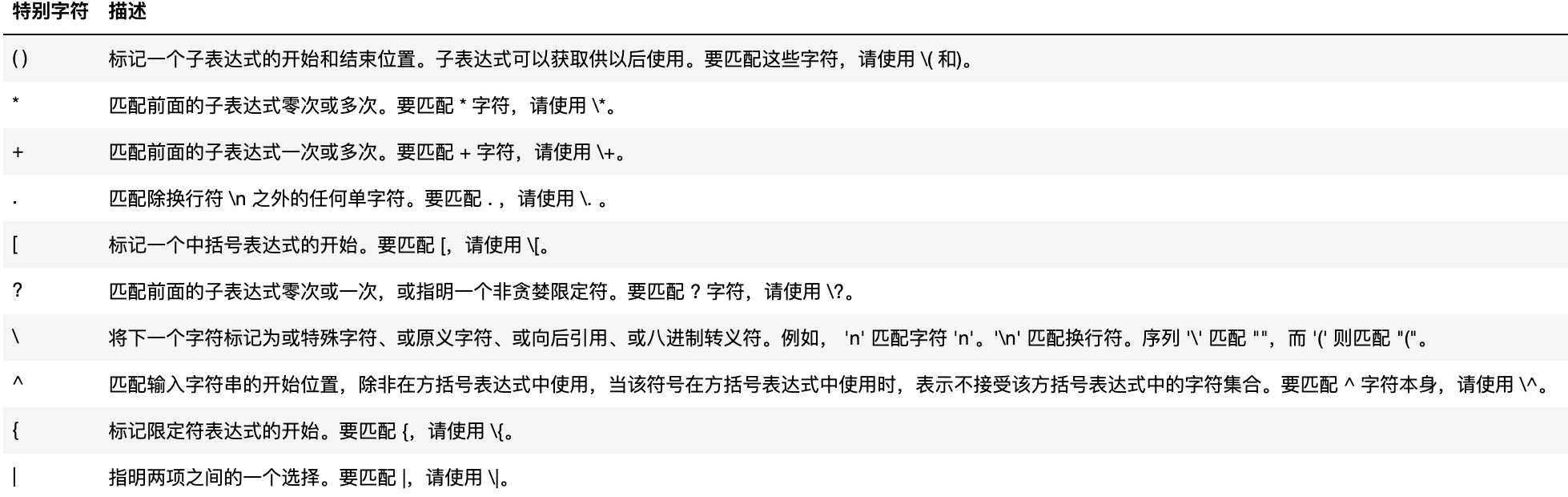

特殊字符:有特殊含义的字符

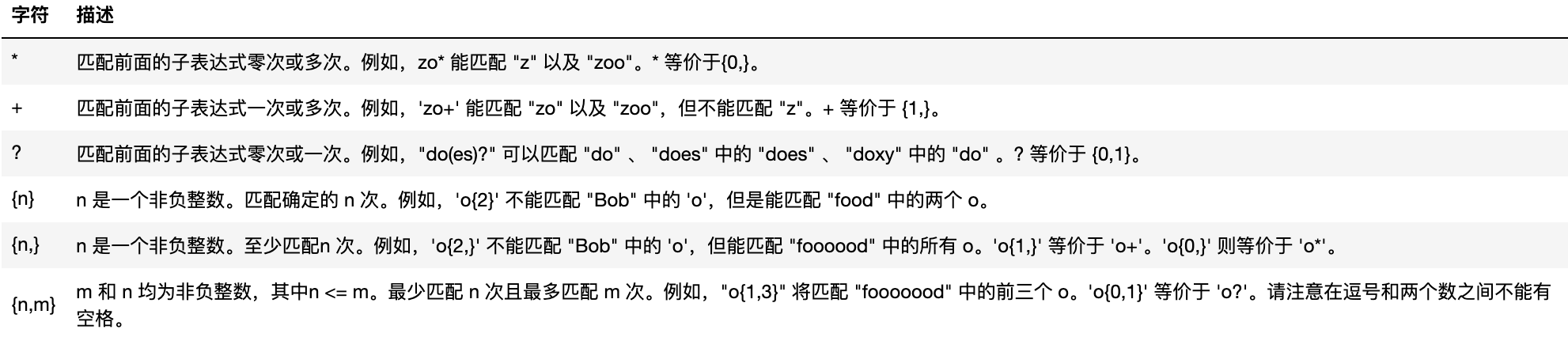

限定符

具体代码实现以及讲解

首先我们来统计论文页数,也就是在

comments字段中抽取pages和figures和个数,首先完成字段读取。# 导入所需的packageimport seaborn as sns #用于画图from bs4 import BeautifulSoup #用于爬取arxiv的数据import re #用于正则表达式,匹配字符串的模式import requests #用于网络连接,发送网络请求,使用域名获取对应信息import json #读取数据,我们的数据为json格式的import pandas as pd #数据处理,数据分析import matplotlib.pyplot as plt #画图工具

```python def readArxivFile(path, columns=[‘id’, ‘submitter’, ‘authors’, ‘title’, ‘comments’, ‘journal-ref’, ‘doi’,

'report-no', 'categories', 'license', 'abstract', 'versions','update_date', 'authors_parsed'], count=None):

‘’’ 定义读取文件的函数

path: 文件路径columns: 需要选择的列count: 读取行数

‘’’

data = [] with open(path, ‘r’) as f:

for idx, line in enumerate(f):if idx == count:breakd = json.loads(line)d = {col : d[col] for col in columns}data.append(d)

data = pd.DataFrame(data) return data

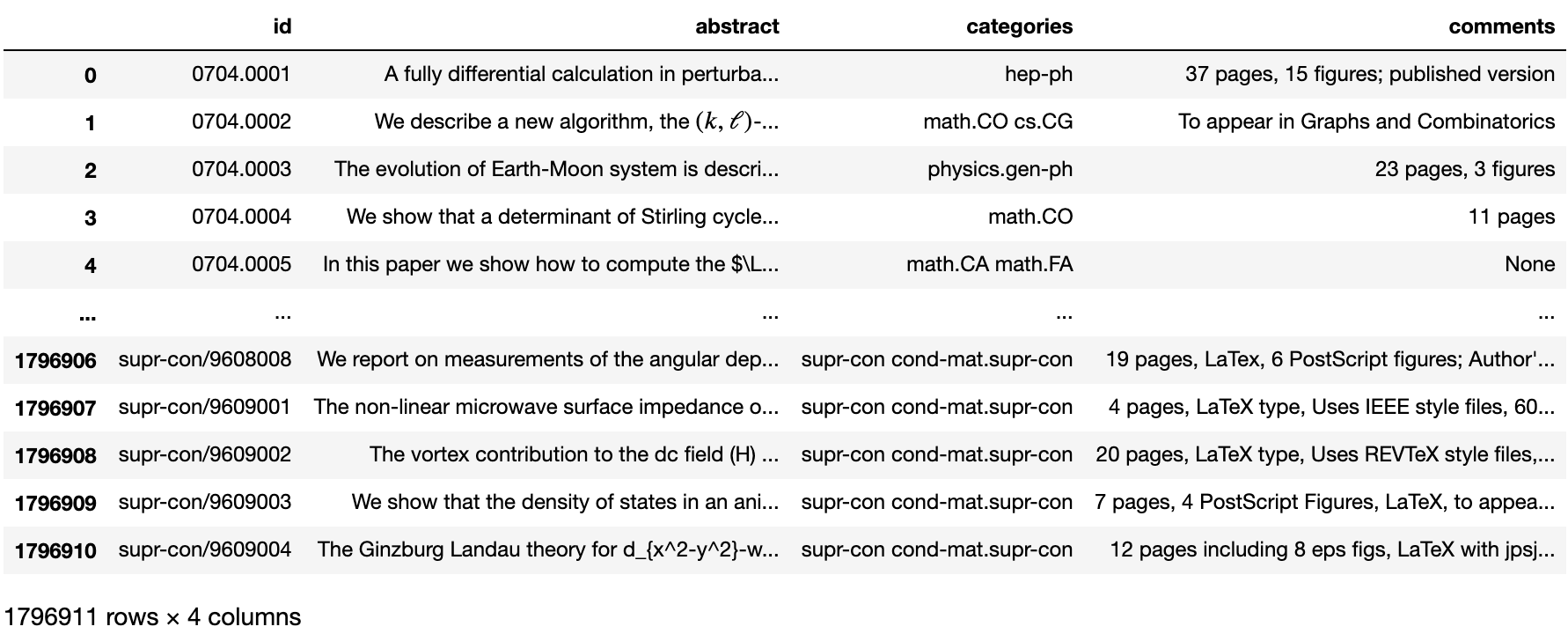

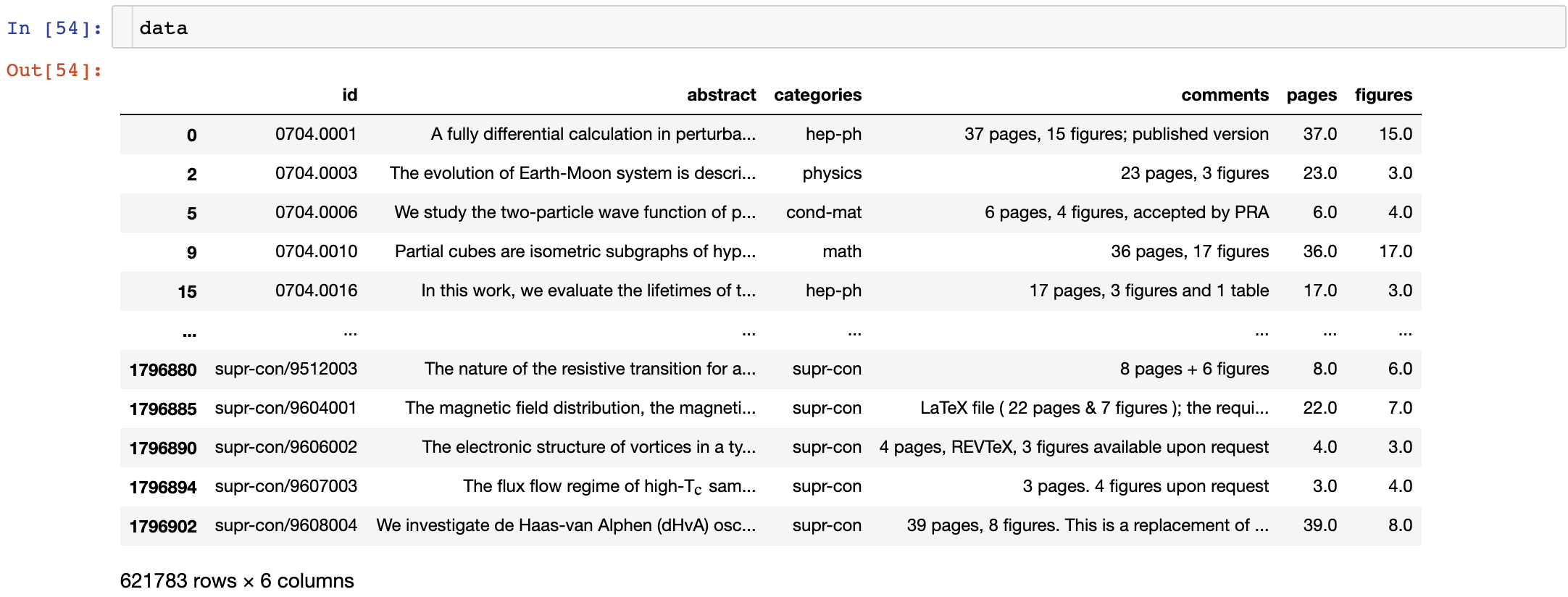

data = readArxivFile(‘arxiv-metadata-oai-snapshot.json’, [‘id’, ‘abstract’, ‘categories’, ‘comments’])

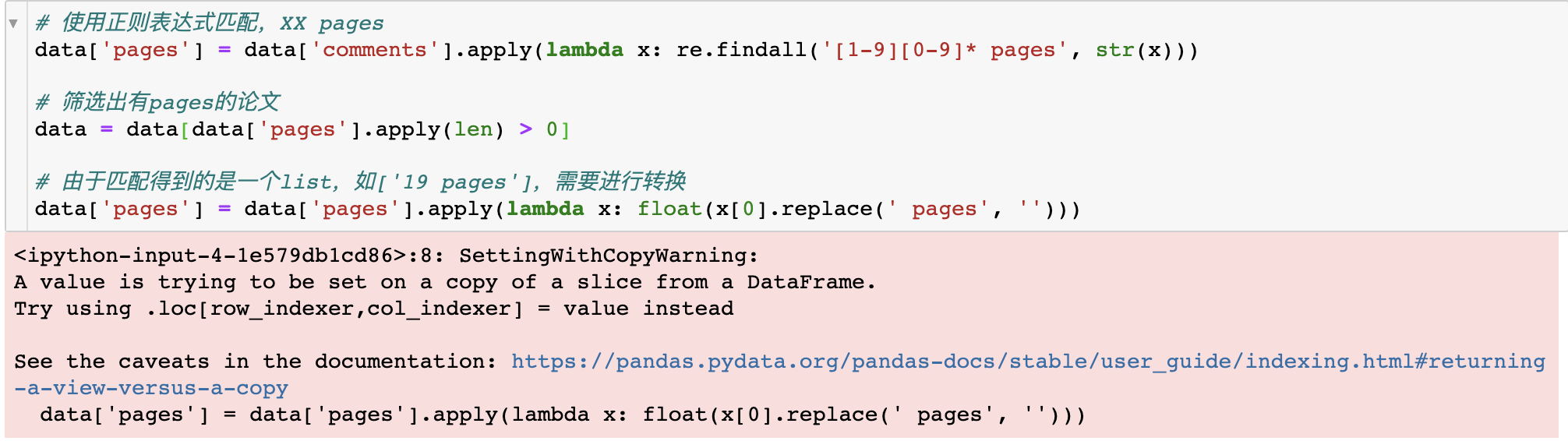

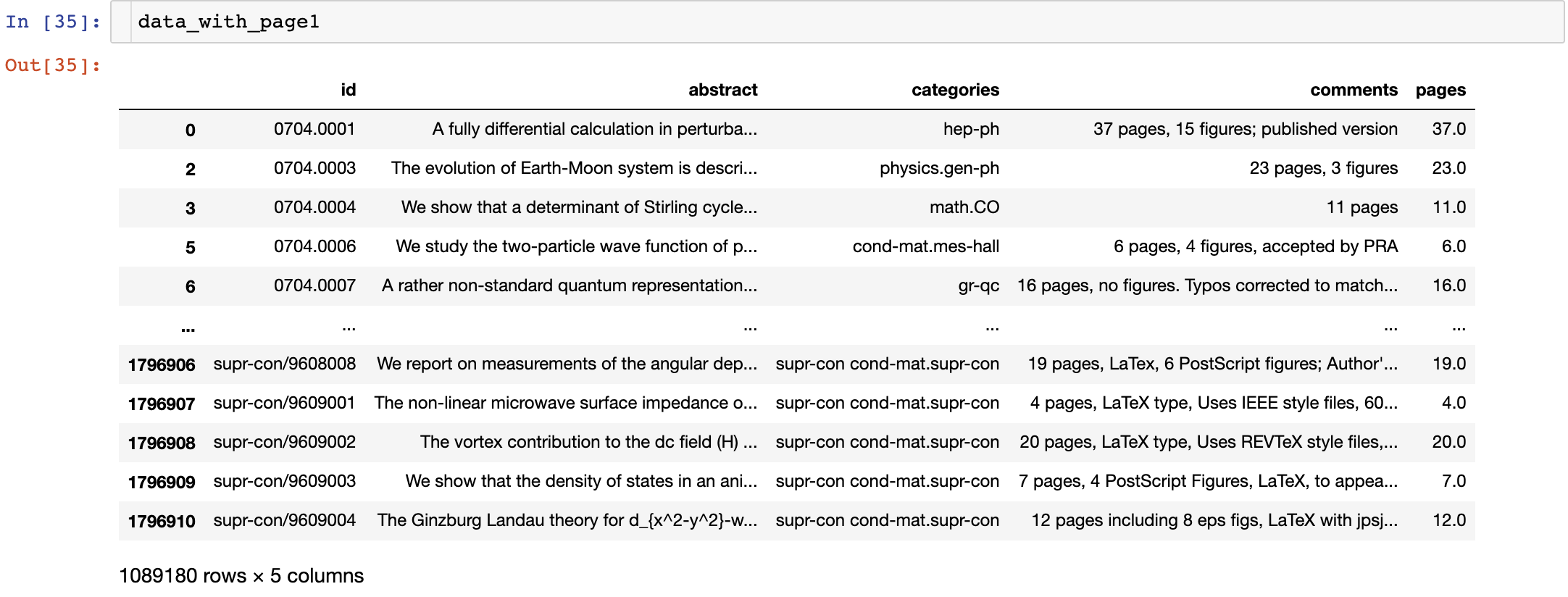

这里是只选了四列添加到了data里,data如下图所示<br /><br />对pages进行抽取:这里给的代码出现了SettingWithCopyWarning<br /><br />这里就是不要对切片设置值,在这里多设置几个变量即可```python# 使用正则表达式匹配,XX pagesdata['pages'] = data['comments'].apply(lambda x: re.findall('[1-9][0-9]* pages', str(x)))# 筛选出有pages的论文# 对每一行使用len函数data_with_page=data[data['pages'].apply(len) > 0]# 这里要创建一个副本data_with_page1=data_with_page.copy()# 由于匹配得到的是一个list,如['19 pages'],需要进行转换data_with_page1['pages']=data_with_page['pages'].apply(lambda x: float(x[0].replace(' pages', '')))

然后这里为了和后面代码匹配将data设置为data_with_page1的副本(这里的data和上面的data是不一样的)

data=data_with_page1.copy()

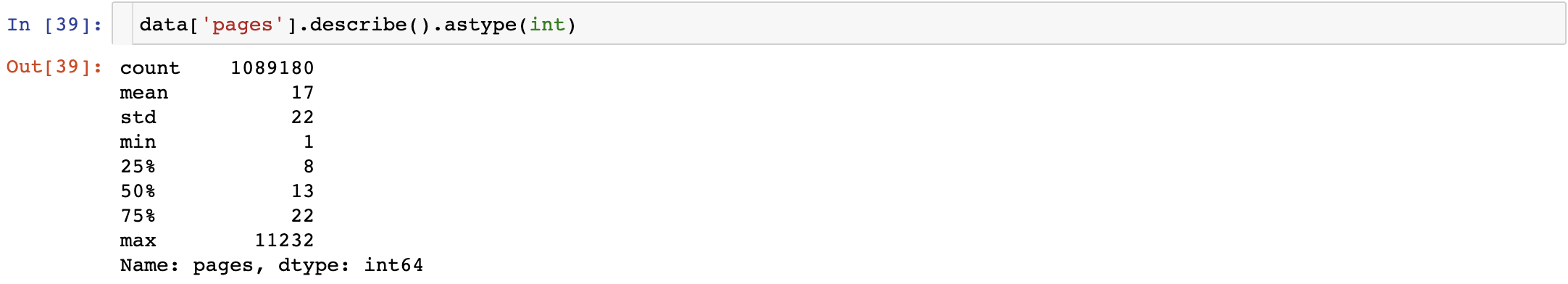

对pages进行统计,统计结果如下:论文平均的页数为17页,75%的论文在22页以内,最长的论文有11232页。

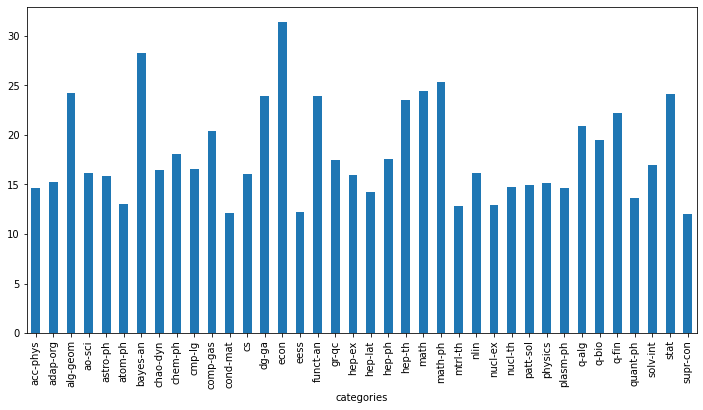

接下来按照分类统计论文页数,选取了论文的第一个类别的主要类别:

# 选择主要类别 先根据' '分开,再根据'.'分开data['categories'] = data['categories'].apply(lambda x: x.split(' ')[0])data['categories'] = data['categories'].apply(lambda x: x.split('.')[0])# 每类论文的平均页数plt.figure(figsize=(12, 6))data.groupby(['categories'])['pages'].mean().plot(kind='bar')

接下来对论文图表个数进行抽取:

data['figures'] = data['comments'].apply(lambda x: re.findall('[1-9][0-9]* figures', str(x)))data1 = data[data['figures'].apply(len) > 0]data=data1.copy() # 这里的data和上面的data也不一样了data['figures'] = data1['figures'].apply(lambda x: float(x[0].replace(' figures', '')))

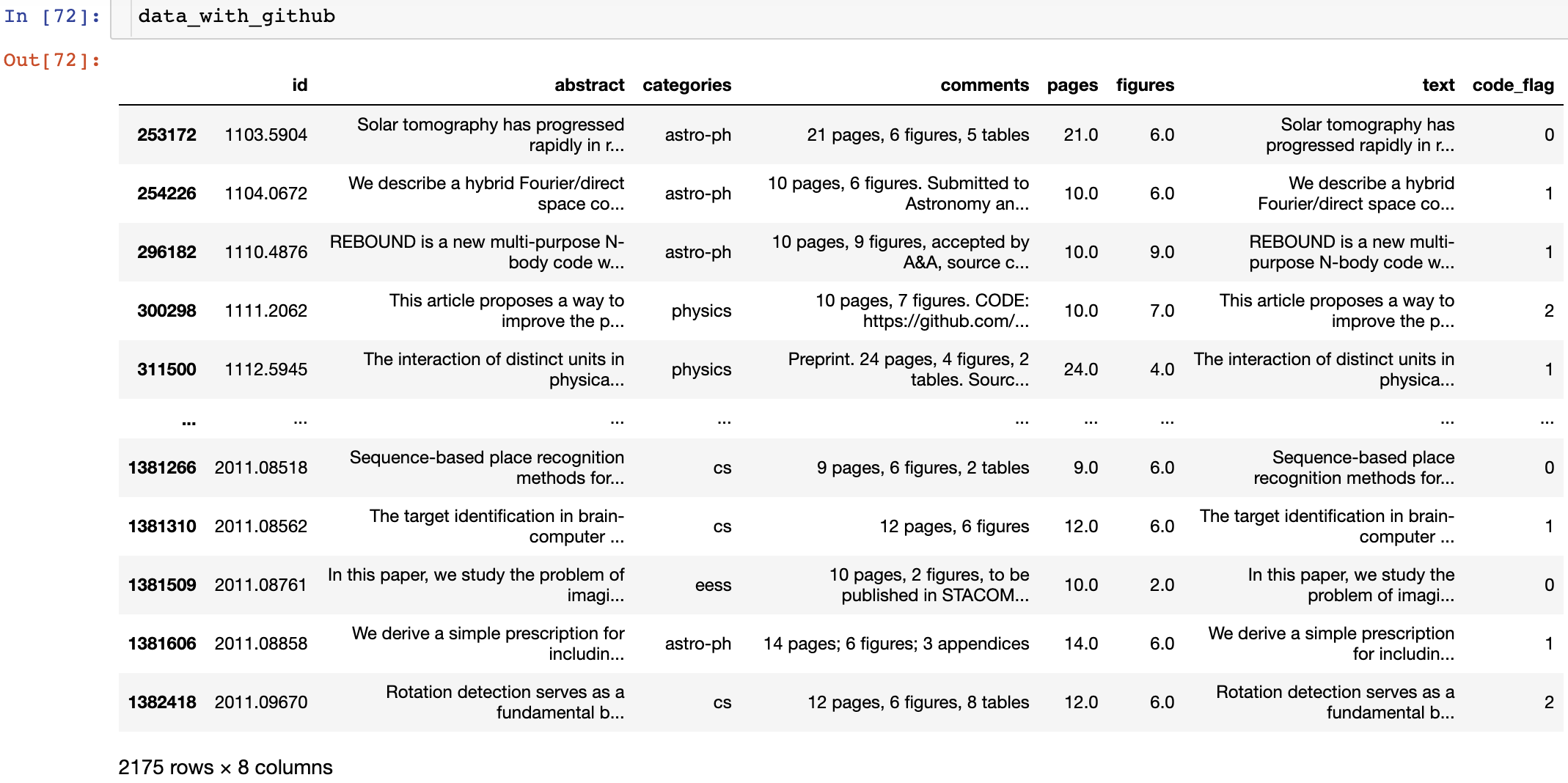

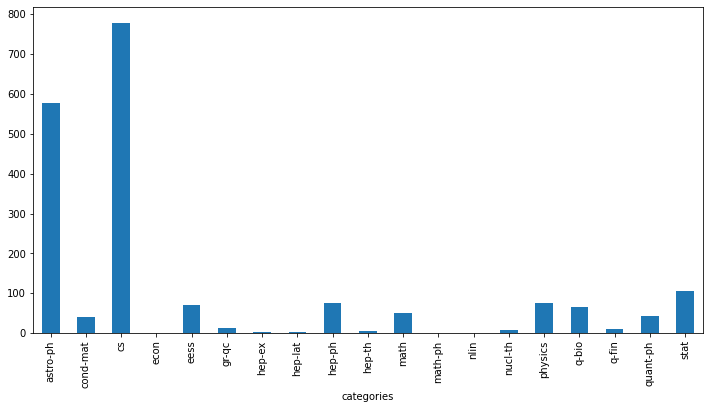

# 筛选包含github的论文(comments和abstract里面是否有github)data_with_code = data[(data.comments.str.contains('github')==True)|(data.abstract.str.contains('github')==True)]data_with_github=data_with_code.copy()# 空值用''填充data_with_github['text'] = data_with_code['abstract'].fillna('') + data_with_code['comments'].fillna('')# 使用正则表达式匹配论文(带有github链接的)pattern = '[a-zA-z]+://github[^\s]*'data_with_github['code_flag'] = data_with_github['text'].str.findall(pattern).apply(len)

# data_with_code_flag = data_with_github[data_with_github['code_flag'] == 1]data_with_code_flag = data_with_github[data_with_github['code_flag'] >= 1]data_with_code_flagplt.figure(figsize=(12, 6))data_with_code_flag.groupby(['categories'])['code_flag'].count().plot(kind='bar')

上面需要是想要找出含有链接的数据,如果comments和abstract里都有链接或者有多个链接,那code_flag就会大于1,这样筛出来的数据就有问题了。所有我把筛选条件改为>=1了