很多人都知道,Java 中的浮点数并不精确,需要用 BigDecimal 进行精确计算,但是,很少有人知道为什么浮点数不精确呢?不精确为什么还要用呢?本文就来展开分析一波;

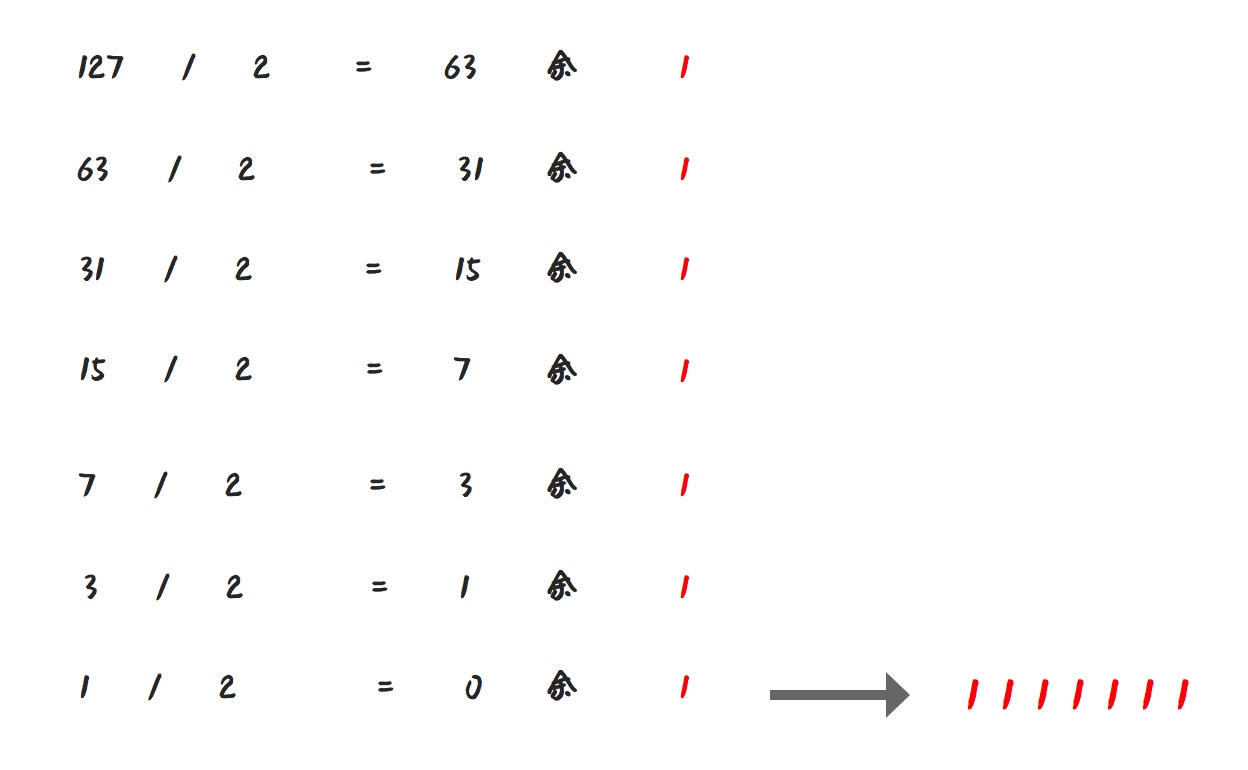

我们知道,计算机的数字的存储和运算都是通过二进制进行的,对于,十进制整数转换为二进制整数采用” 除 2 取余,逆序排列” 法

具体做法是:

- 用 2 整除十进制整数,可以得到一个商和余数;

- 再用 2 去除商,又会得到一个商和余数,如此进行,直到商为小于 1 时为止

- 然后把先得到的余数作为二进制数的低位有效位,后得到的余数作为二进制数的高位有效位,依次排列起来。

如,我们想要把 127 转换成二进制,做法如下:

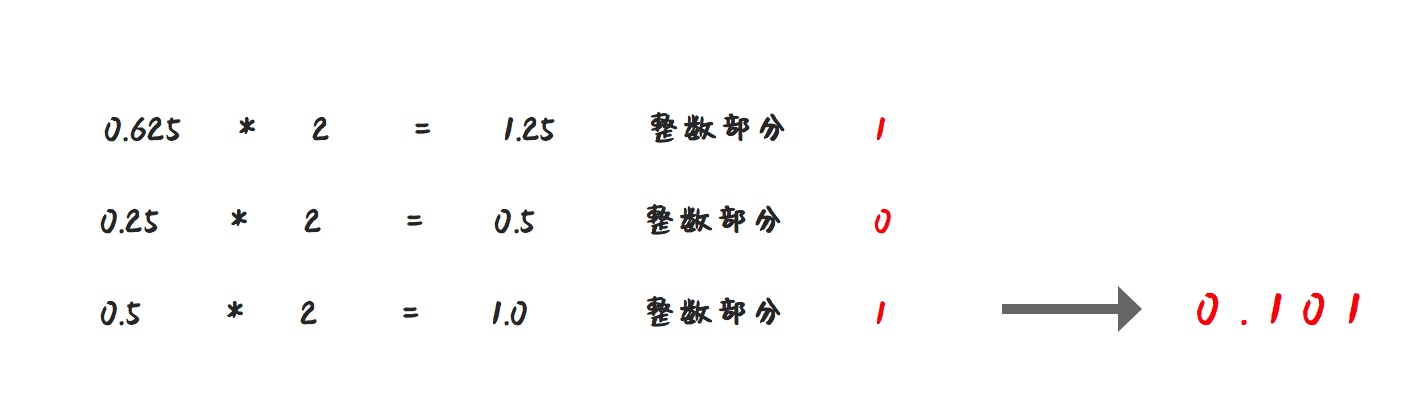

那么,十进制小数转换成二进制小数,又该如何计算呢?

十进制小数转换成二进制小数采用” 乘 2 取整,顺序排列” 法。

具体做法是:

- 用 2 乘十进制小数,可以得到积

- 将积的整数部分取出,再用 2 乘余下的小数部分,又得到一个积

- 再将积的整数部分取出,如此进行,直到积中的小数部分为零,此时 0 或 1 为二进制的最后一位。或者达到所要求的精度为止。

如尝试将 0.625 转成二进制:

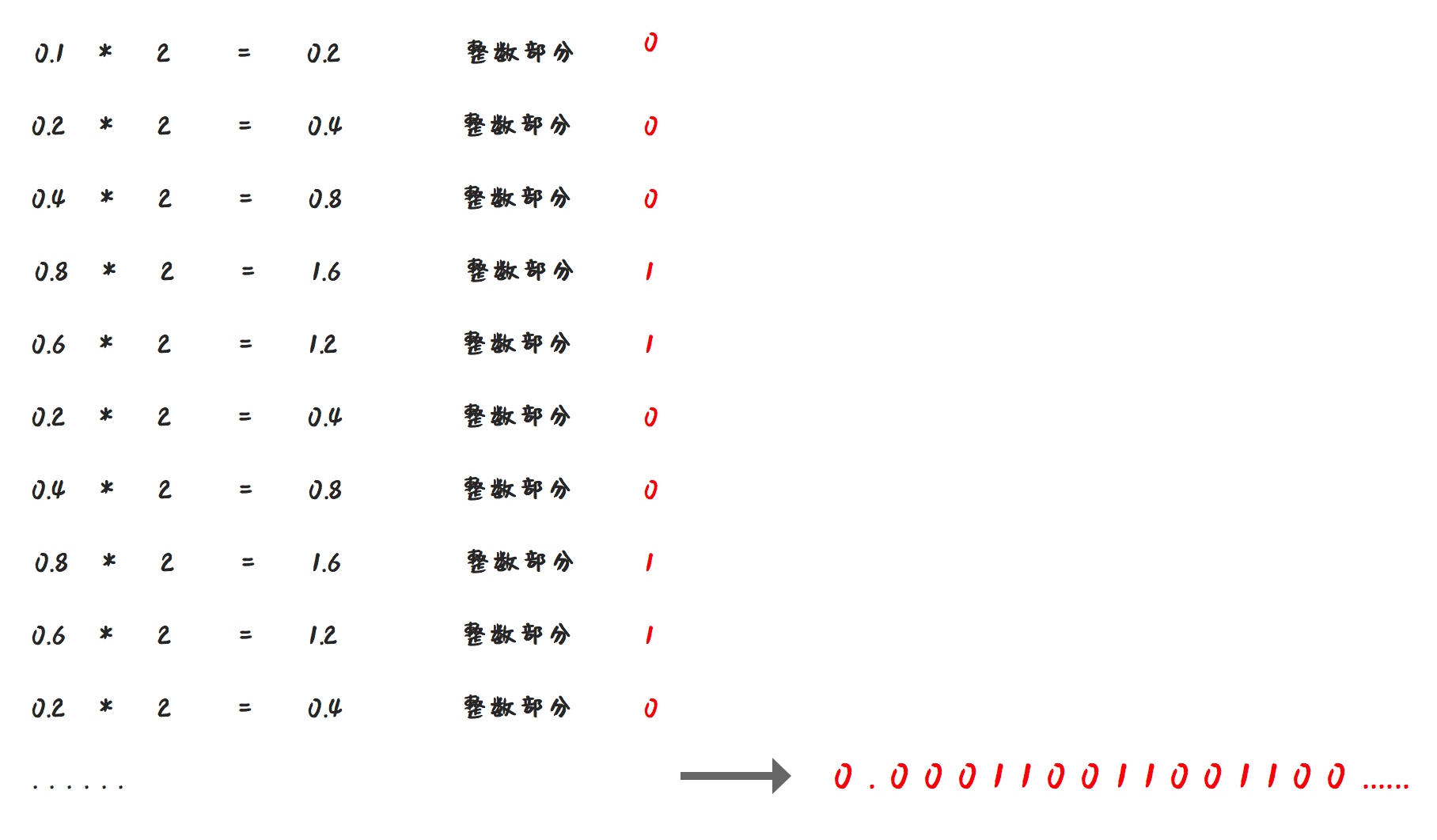

但是 0.625 是一个特列,用同样的算法,请计算下 0.1 对应的二进制是多少:

我们发现,0.1 的二进制表示中出现了无限循环的情况,也就是 (0.1)10 = (0.000110011001100…)2

这种情况,计算机就没办法用二进制精确的表示 0.1 了。

所以,为了解决部分小数无法使用二进制精确表示的问题,于是就有了 IEEE 754 规范。

IEEE 二进制浮点数算术标准(IEEE 754)是 20 世纪 80 年代以来最广泛使用的浮点数运算标准,为许多 CPU 与浮点运算器所采用。

浮点数和小数并不是完全一样的,计算机中小数的表示法,其实有定点和浮点两种。因为在位数相同的情况下,定点数的表示范围要比浮点数小。所以在计算机科学中,使用浮点数来表示实数的近似值。

IEEE 754 规定了四种表示浮点数值的方式:单精确度(32 位)、双精确度(64 位)、延伸单精确度(43 比特以上,很少使用)与延伸双精确度(79 比特以上,通常以 80 位实现)。

其中最常用的就是 32 位单精度浮点数和 64 位双精度浮点数。

单精度浮点数在计算机存储器中占用 4 个字节(32 bits),利用 “浮点”(浮动小数点)的方法,可以表示一个范围很大的数值。

比起单精度浮点数,双精度浮点数 (double) 使用 64 位(8 字节) 来存储一个浮点数。

IEEE 并没有解决小数无法精确表示的问题,只是提出了一种使用近似值表示小数的方式,并且引入了精度的概念。

一个浮点数 a 由两个数 m 和 e 来表示:a = m × b^e。

在任意一个这样的系统中,我们选择一个基数 b(记数系统的基)和精度 p(即使用多少位来存储)。m(即尾数)是形如 ±d.ddd…ddd 的 p 位数(每一位是一个介于 0 到 b-1 之间的整数,包括 0 和 b-1)。

如果 m 的第一位是非 0 整数, m 称作规格化的。有一些描述使用一个单独的符号位 (s 代表 + 或者 -)来表示正负,这样 m 必须是正的。e 是指数。

最后,由于计算机中保存的小数其实是十进制的小数的近似值,并不是准确值,所以,千万不要在代码中使用浮点数来表示金额等重要的指标。

建议使用 BigDecimal 或者 Long(单位为分)来表示金额。

(全文完)

扫描二维码,关注作者微信公众号