官方命令文档

https://hadoop.apache.org/docs/r3.3.0/hadoop-project-dist/hadoop-common/FileSystemShell.html

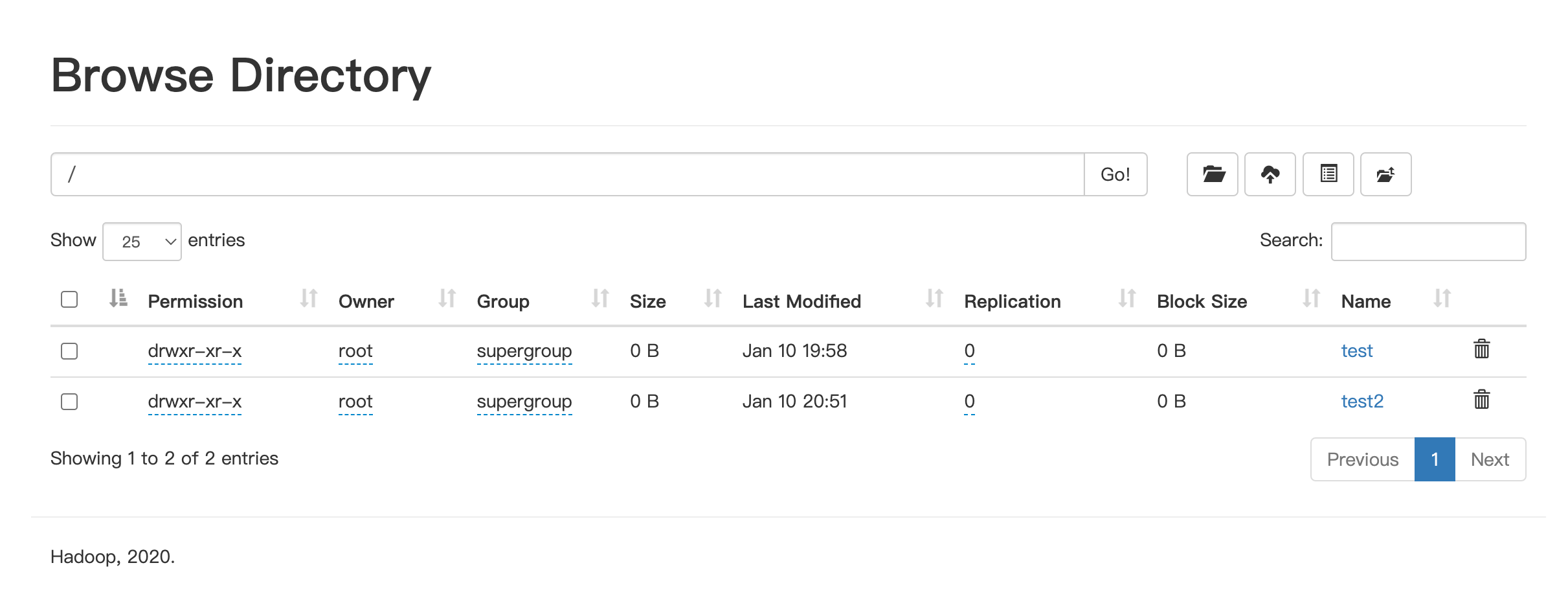

1.HDFS shell命令行解释说明

Hadoop提供了文件系统的shell命令行客户端:

hadoop fs [generic options]

文件系统协议

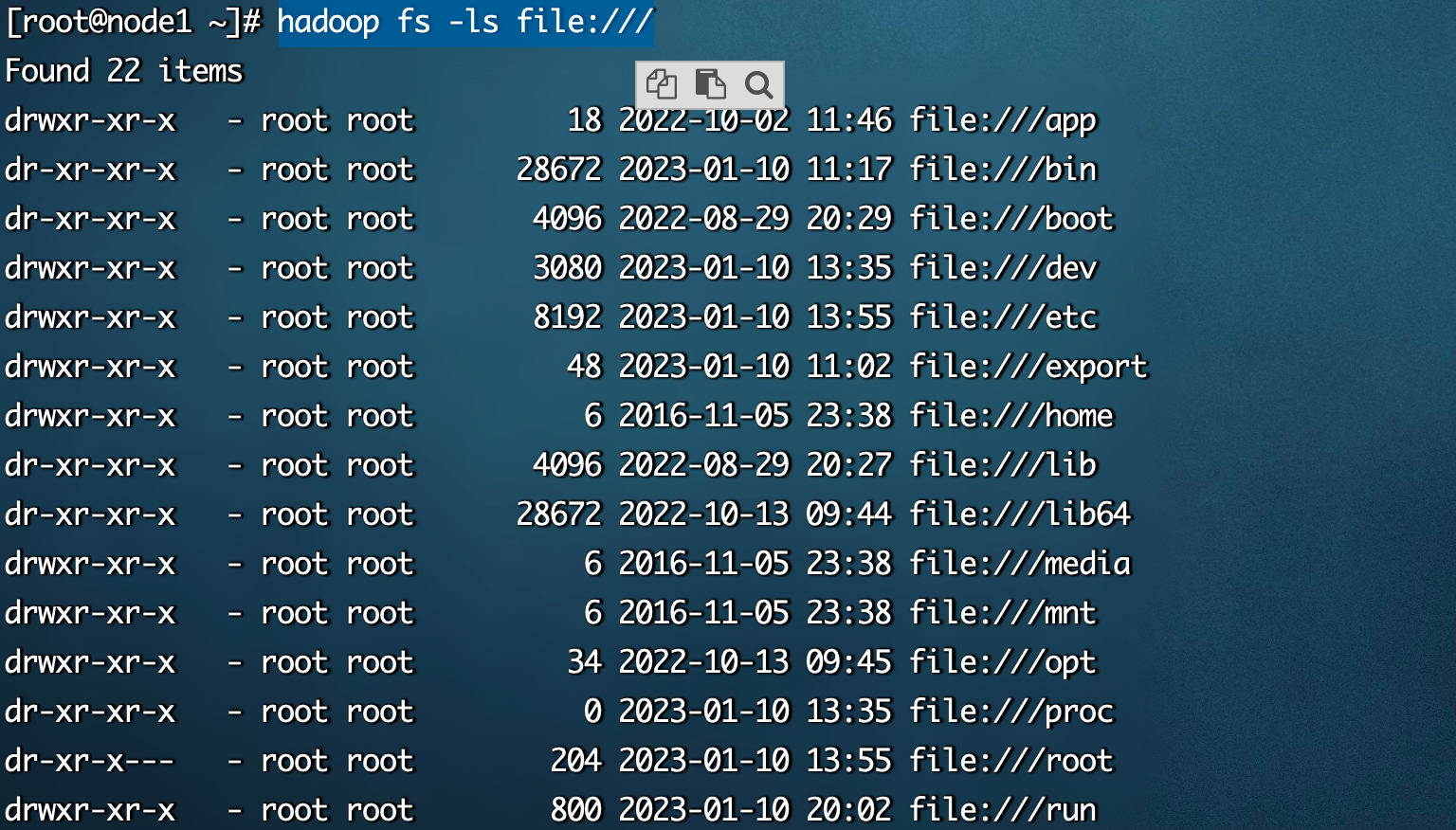

HDFS Shell CLI支持操作多种文件系统,包括本地文件系统(file:///)、分布式文件系统(hdfs://nn:8020)等

具体操作的是什么文件系统取决于命令中文件路径URL中的前缀协议

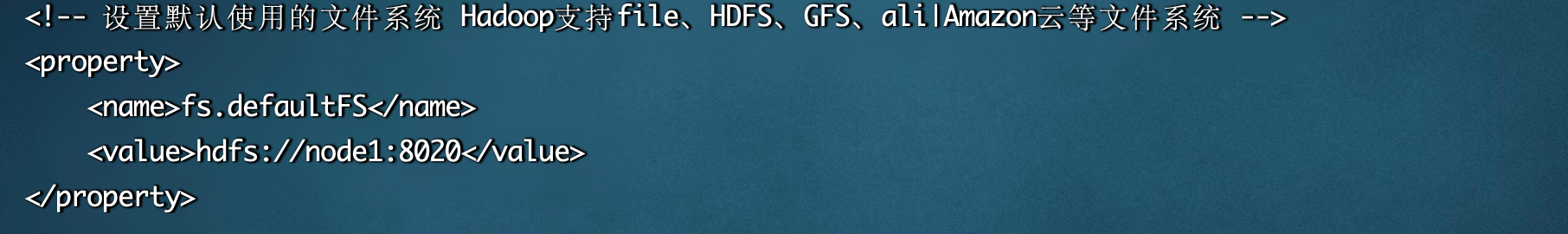

如果没有指定前缀,则将会读取环境变量中的fs.defaultFS属性,以该属性值作为默认文件系统

# 查看的是当前HDFS使用的Linux服务器本地的所有文件 相等于 在Linux执行lshadoop fs -ls file:///

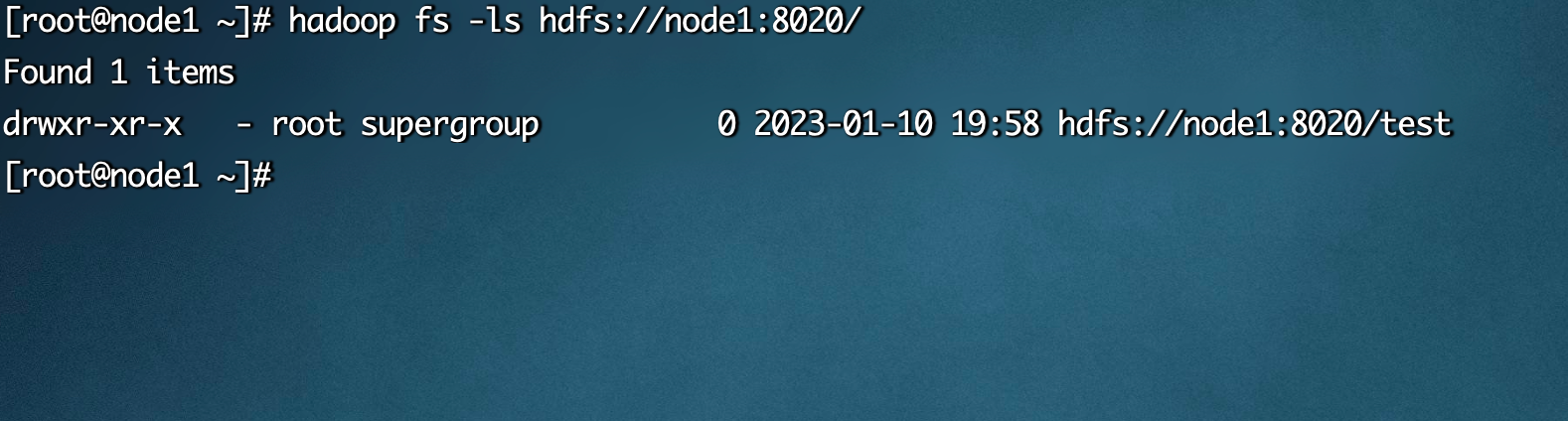

# 查看的是分布式文件系统hadoop fs -ls hdfs://node1:8020/

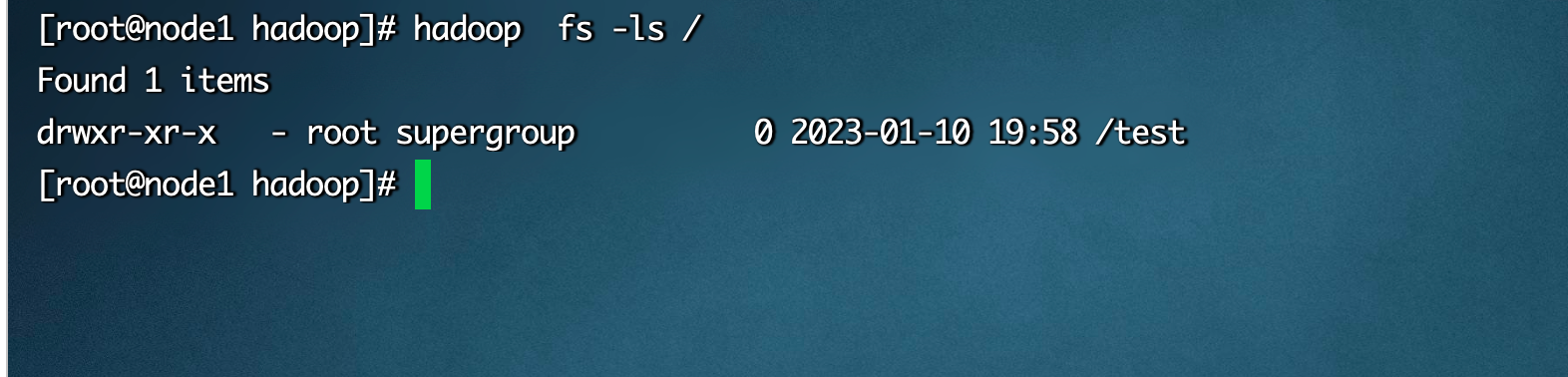

# 如果没有指定前缀,则将会读取环境变量中的fs.defaultFS属性(core-site.xml),以该属性值作为默认文件系统hadoop fs -ls /

命令之间的区别

hadoop dfs 只能操作HDFS文件系统(包括与Local FS间的操作)—不过已经过时

hdfs dfs 只能操作HDFS文件系统相关(包括与Local FS间的操作) —常用

hadoop fs 可操作任意文件系统,不仅仅是hdfs文件系统 —使用范围更广

2.HDFS shell命令行常用操作

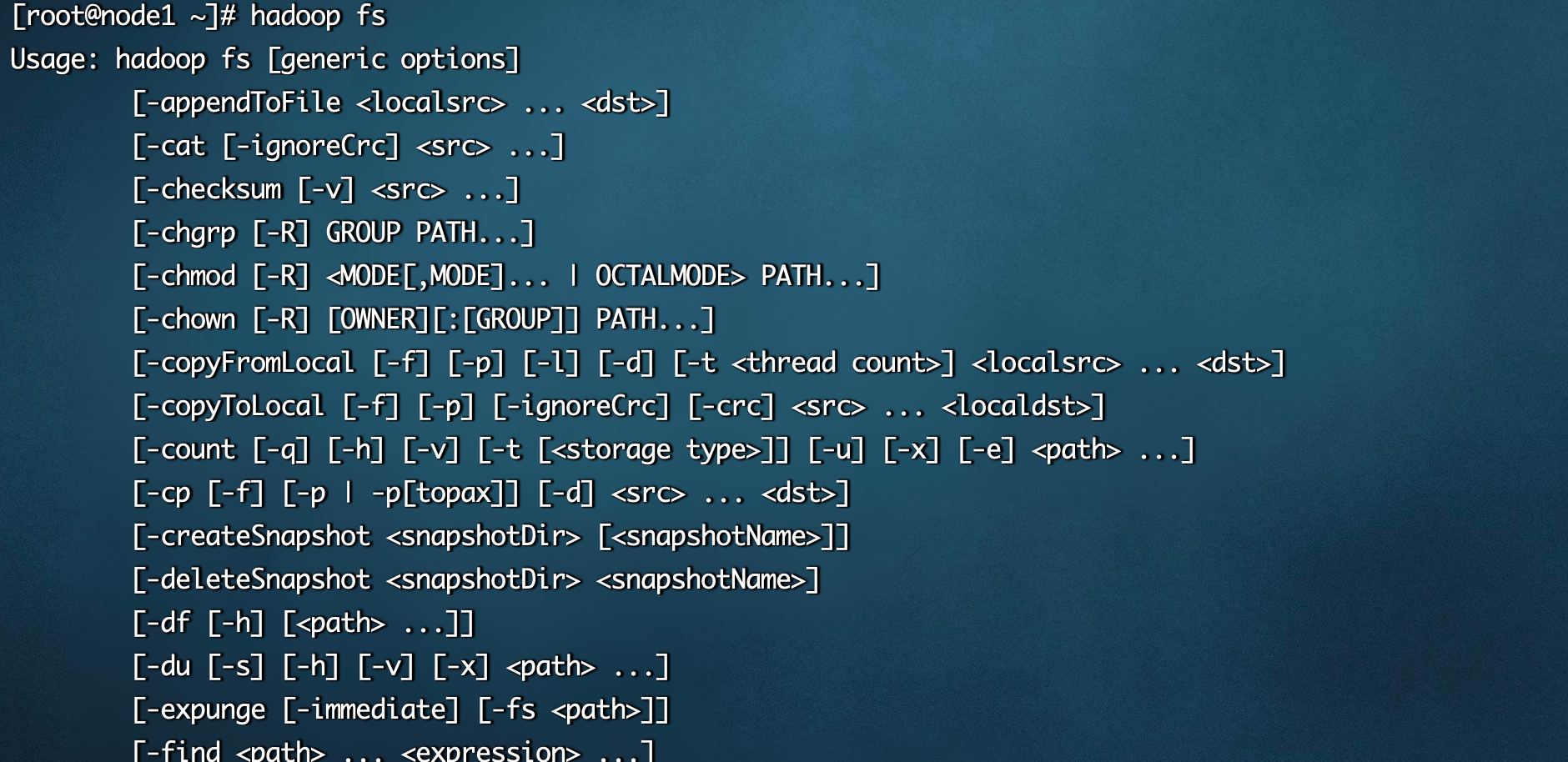

1.查看帮助

hadoop fs -help

2.创建文件夹

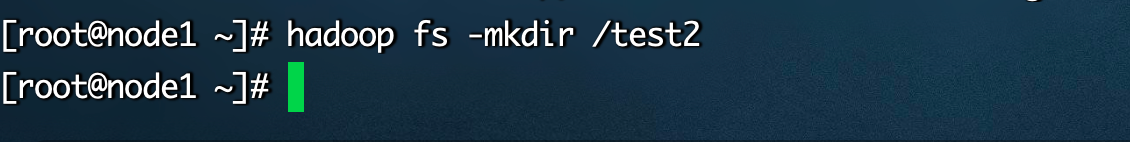

# path 为待创建的目录# -p选项的行为与Unix mkdir -p非常相似,它会沿着路径创建父目录hadoop fs -mkdir [-p] <path> ...

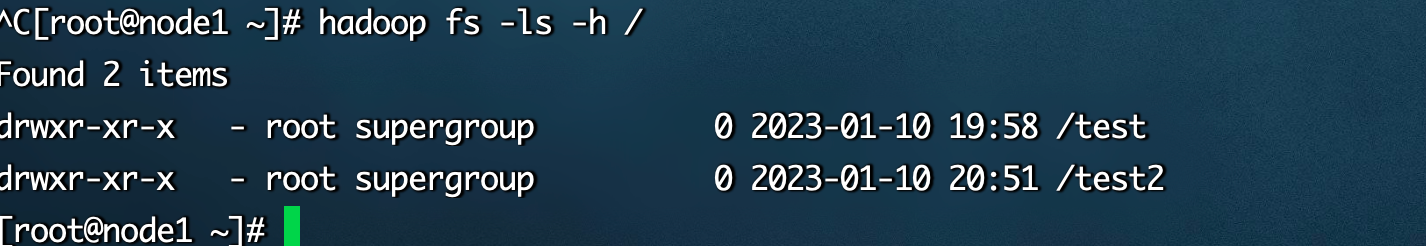

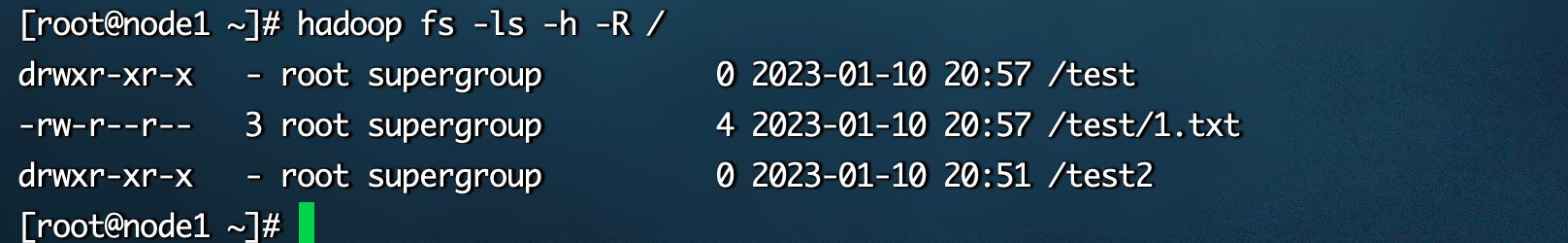

3.查看指定目录下内容

# path 指定目录路径# -h 人性化显示文件size# -R 递归查看指定目录及其子目录hadoop fs -ls [-h] [-R] [<path> ...]

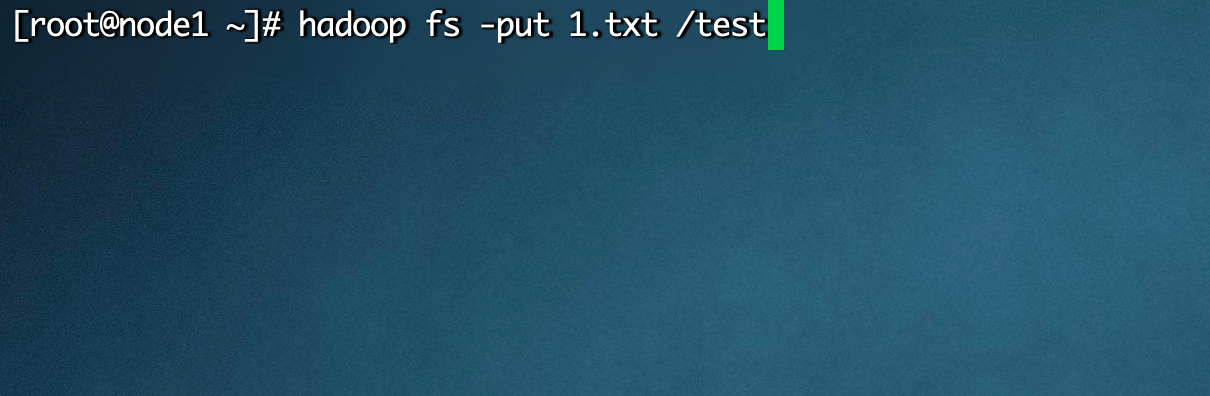

4.上传文件到HDFS指定目录下

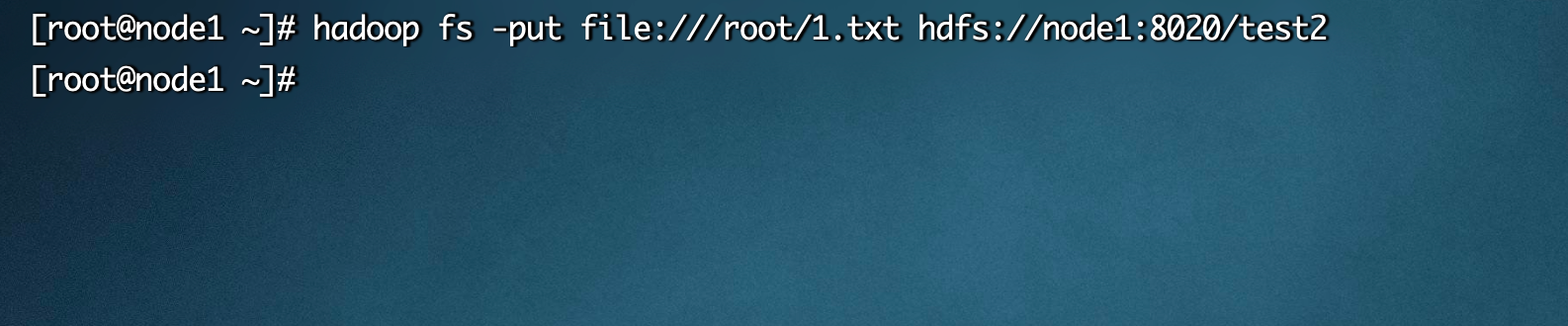

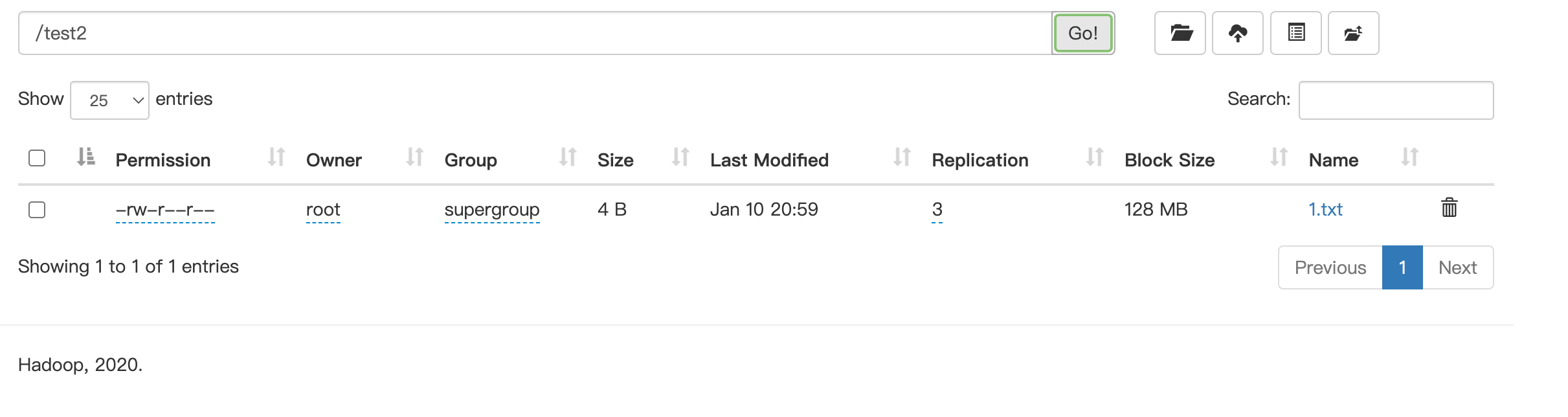

hadoop fs -put [-f] [-p] <localsrc> ... <dst># -f 覆盖目标文件(已存在下)# -p 保留访问和修改时间,所有权和权限# localsrc 本地文件系统(客户端所在机器)# dst 目标文件系统(HDFS)# 例子# hadoop fs -put file:///root/1.txt hdfs://node1:8020/test2# hadoop fs -put 1.txt /test

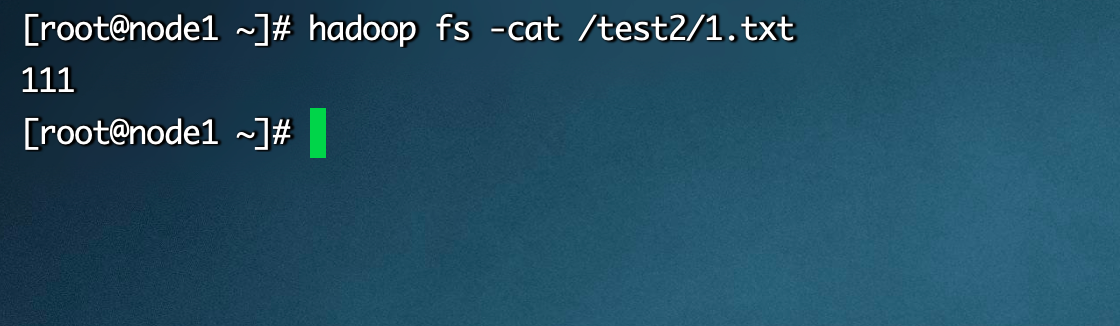

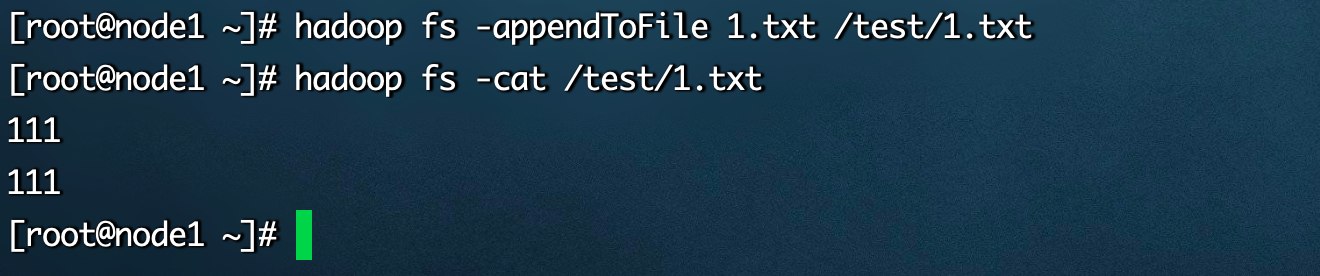

5.查看HDFS文件内容

hadoop fs -cat <src> ...# 读取指定文件全部内容,显示在标准输出控制台# 注意:对于大文件内容读取,慎重

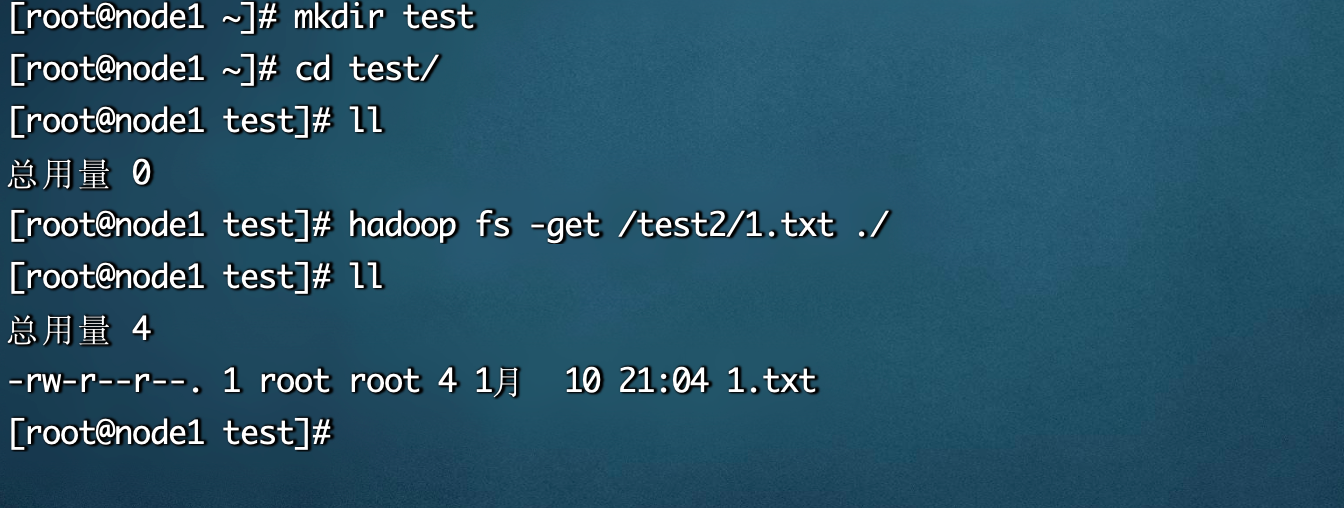

6.下载HDFS文件

hadoop fs -get [-f] [-p] <src> ... <localdst># 下载文件到本地文件系统指定目录, localdst必须是目录# -f 覆盖目标文件(已存在下)# -p 保留访问和修改时间,所有权和权限

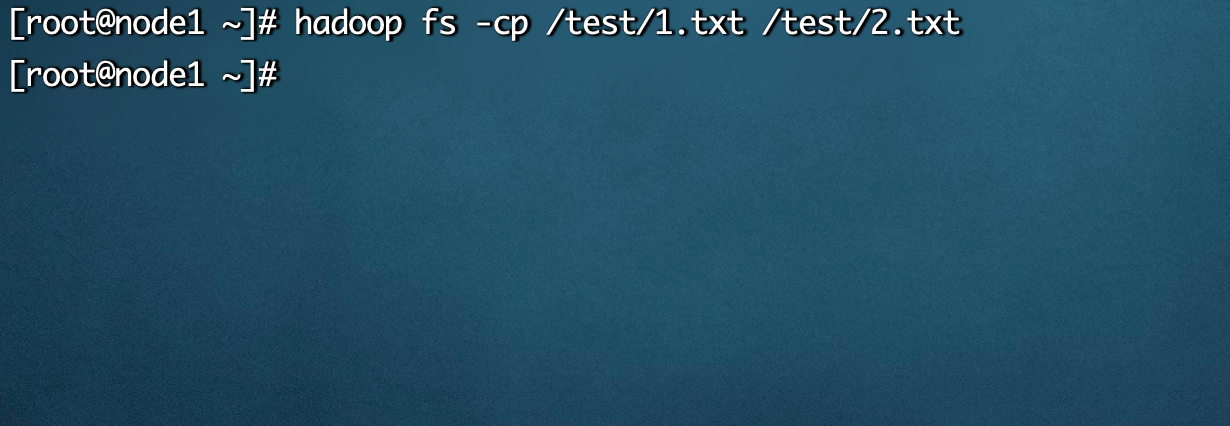

7.拷贝HDFS文件

hadoop fs -cp [-f] <src> ... <dst># -f 覆盖目标文件(已存在下)

8.追加数据到HDFS文件中

hadoop fs -appendToFile <localsrc> ... <dst># 将所有给定本地文件的内容追加到给定dst文件# dst如果文件不存在,将创建该文件# 如果<localSrc>为-,则输入为从标准输入中读取

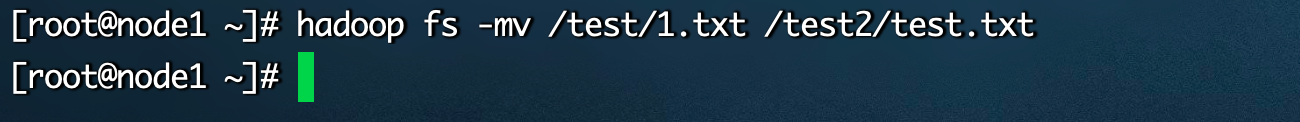

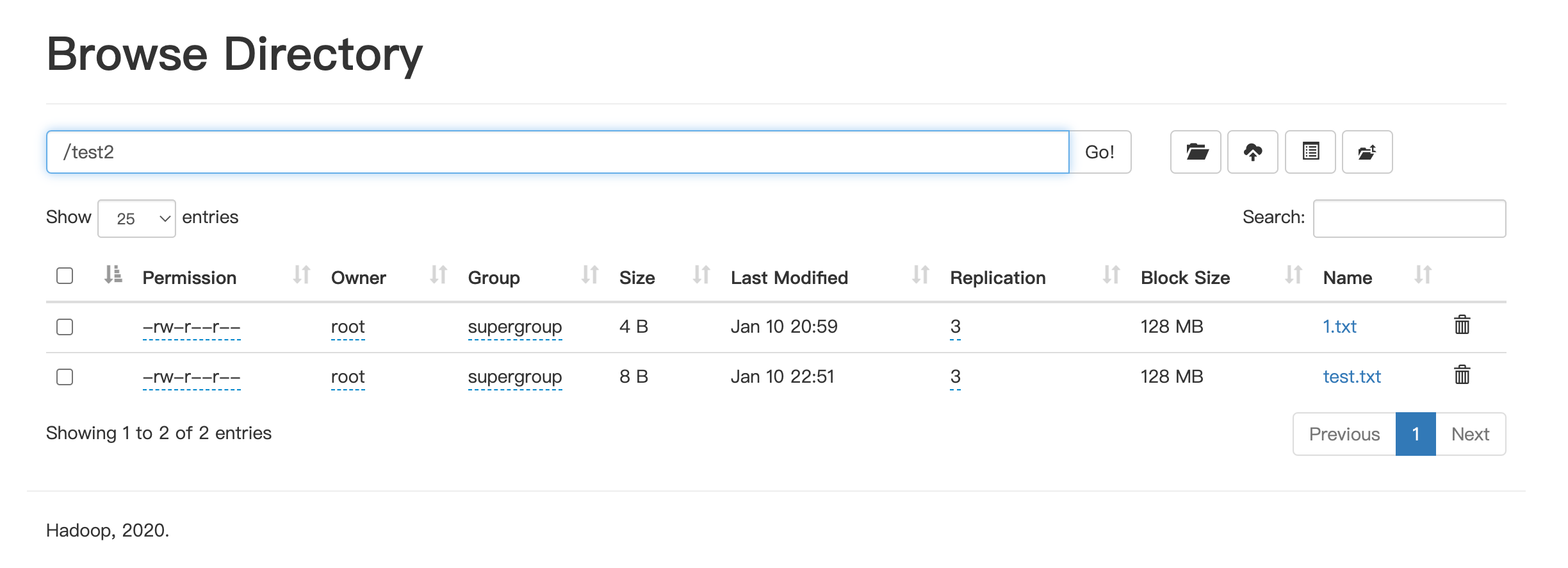

9.数据移动

hadoop fs -mv <src> ... <dst># 移动文件到指定文件夹下# 可以使用该命令移动数据,重命名文件的名称