在读AlexNet文章时,在Abstract中发现有non-saturating neurons一词,于是想知道什么是non-saturating neurons。参考知乎回答:https://www.zhihu.com/question/264163033/answer/277468264

1.含义:

non-saturating neurons = 没有被挤压(到一个特定的区间)处理过的值

saturating neurons = 被挤压(到一个特定的区间)过的值

关键:1.值是否被挤压 2.值有无最大最小限制

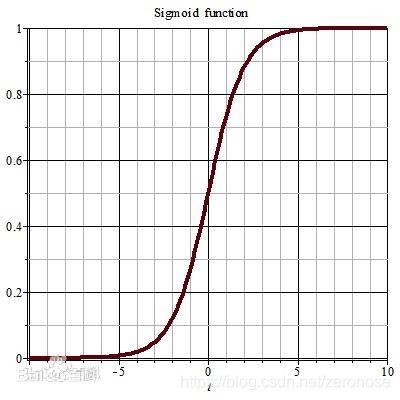

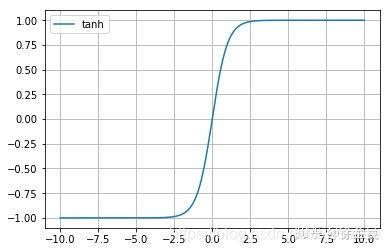

2.输出saturating neurons的activation:

sigmoid: input neurons的值会被挤压到[0,1]的区间

tanh:input neurons的值会被挤压到[-1,1]的区间

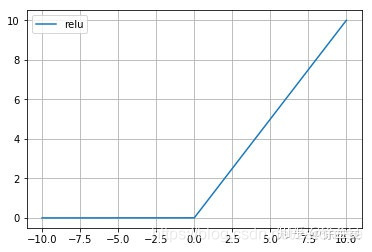

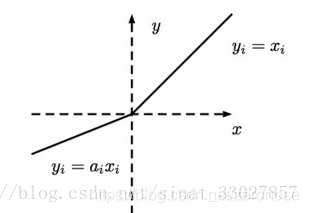

3.输出non-saturating neurons 的activation:

relu:input neurons的值,要么变0, 要么保持原值(无挤压,无最大最小值限制)

leaky_relu:input neurons的值, 要么按照某比例缩小,要么保持原值(无挤压,无最大最小值限制)

4.为什么要用relu这样的能生成non-saturating neurons的non-linear activations, 而不用生成saturating neurons的sigmoid或tanh?

规避vanishing, exploding of gradients 带来的gradient值过大过小,导致训练效率低下。