1.CentOS7镜像下载

http://mirrors.aliyun.com/centos/7.9.2009/isos/x86_64/CentOS-7-x86_64-DVD-2009.iso

阿里云镜像下载速度10m以上了,百度网盘里也有该资源

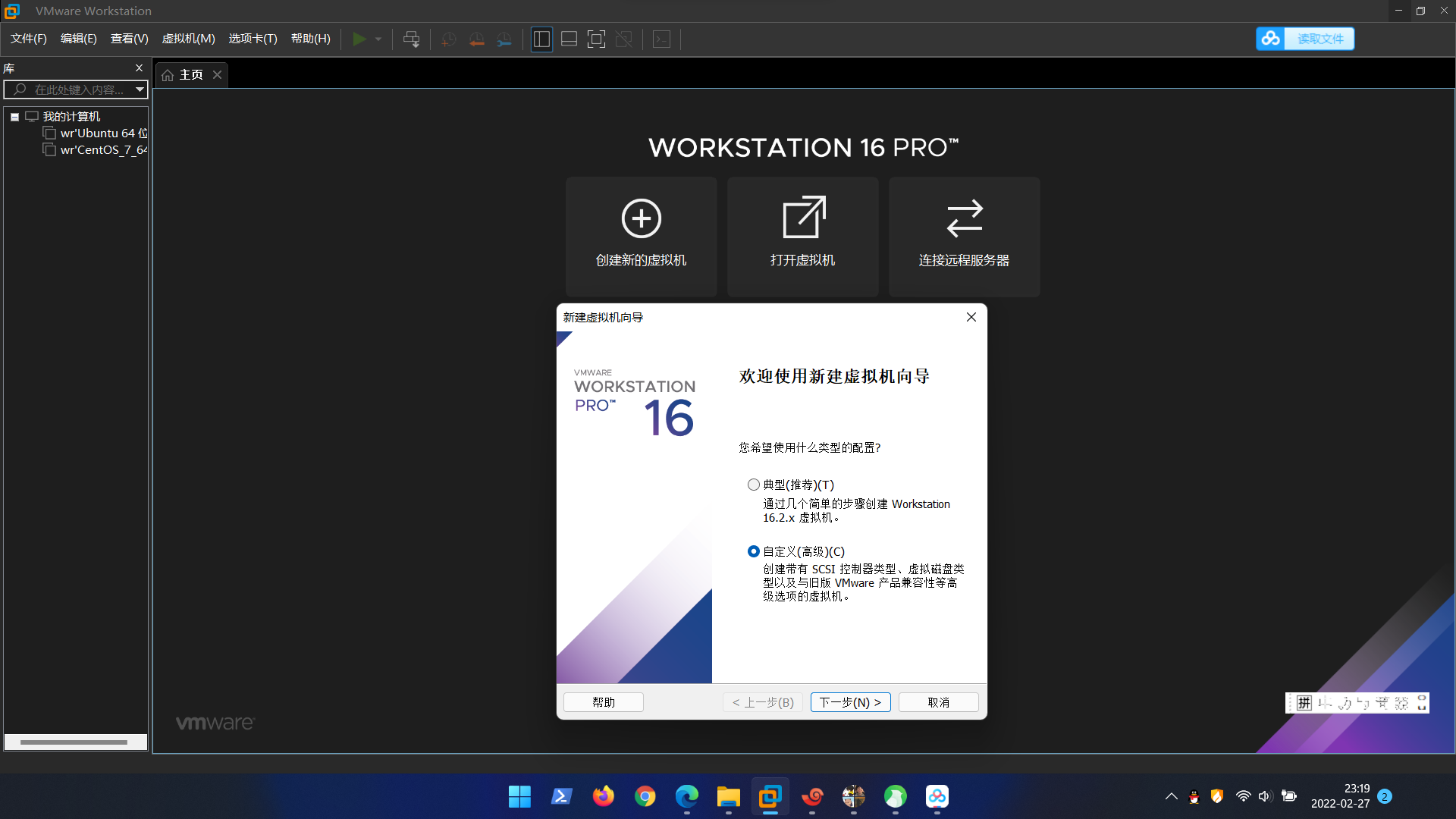

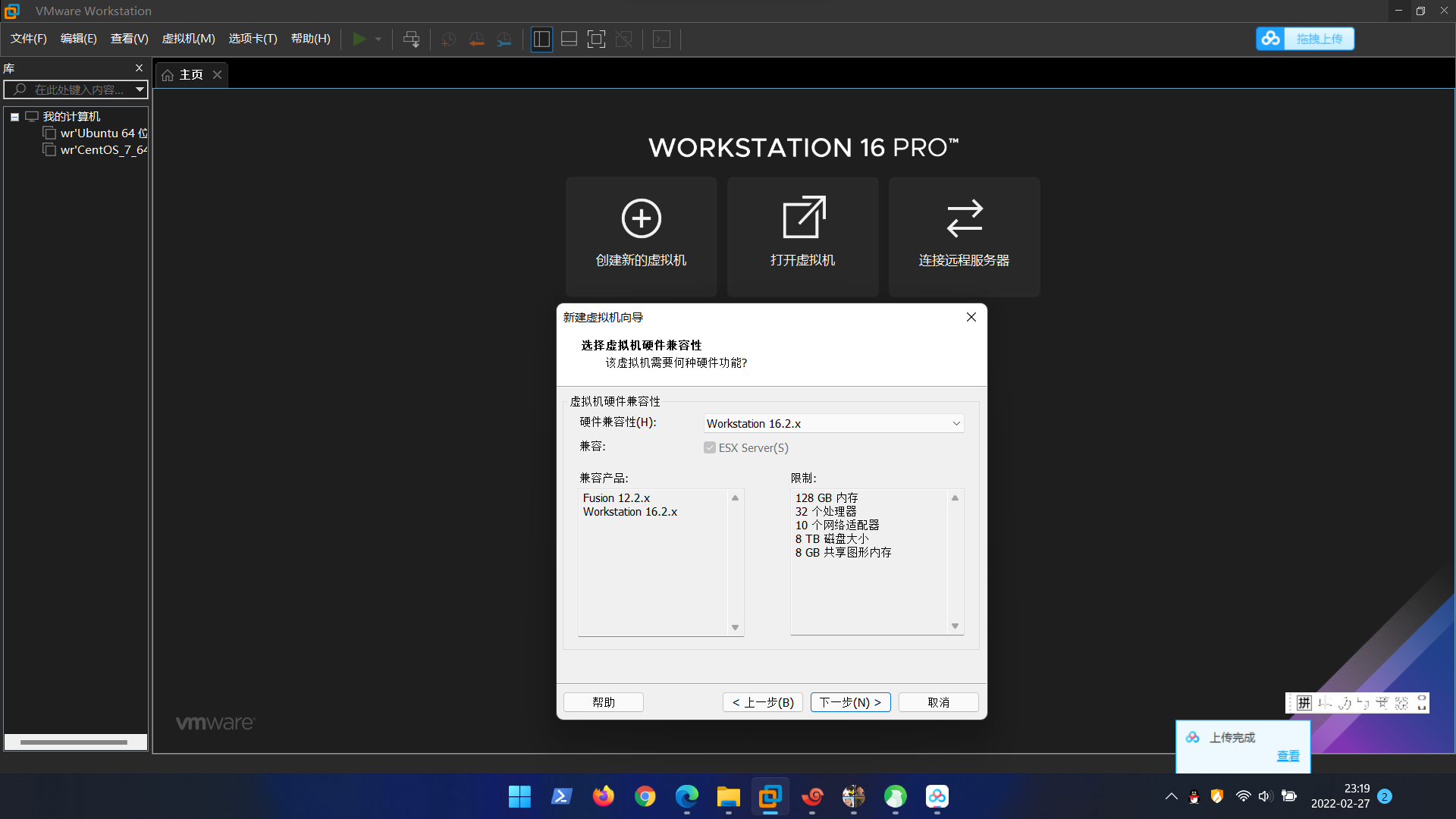

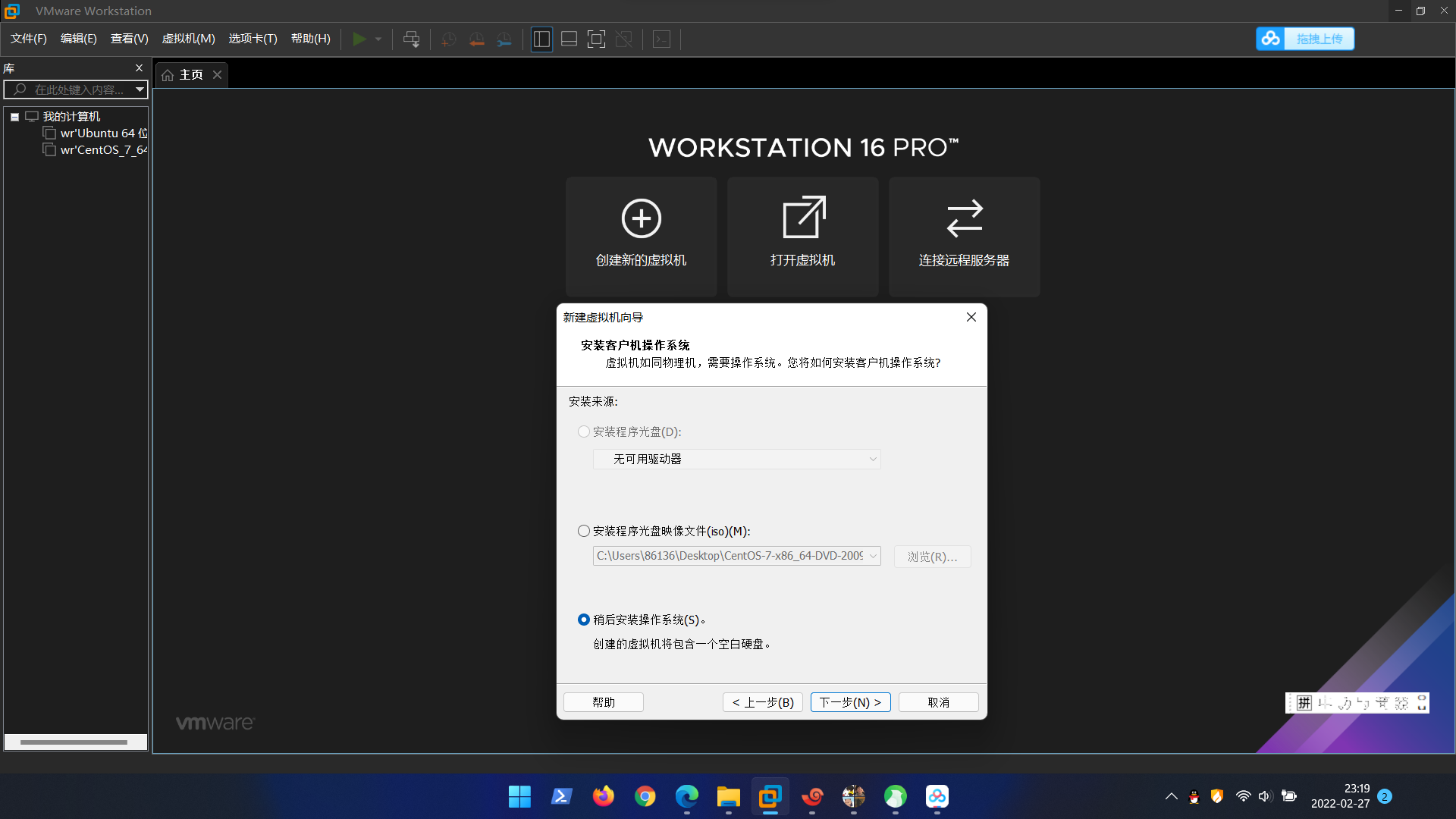

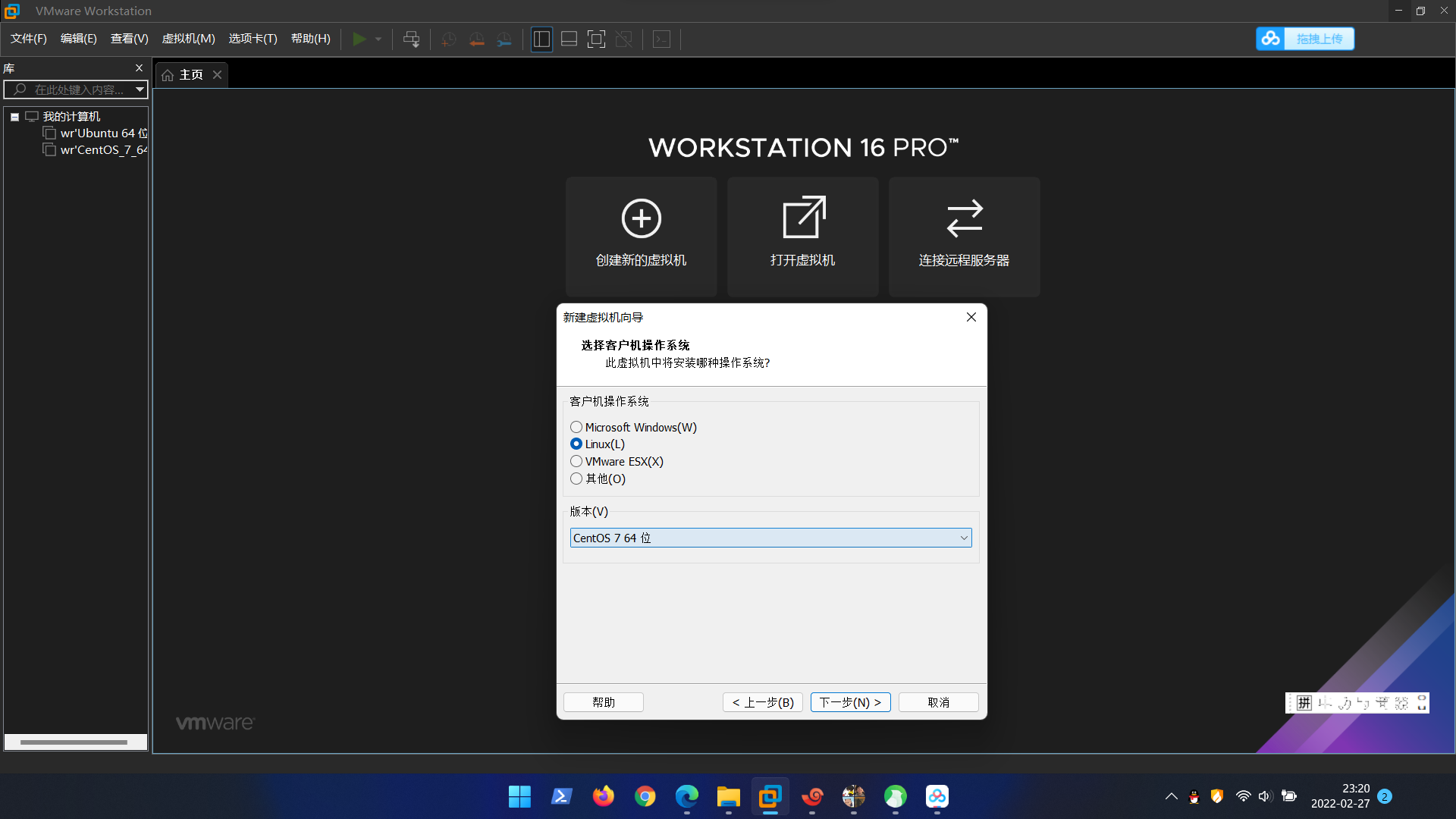

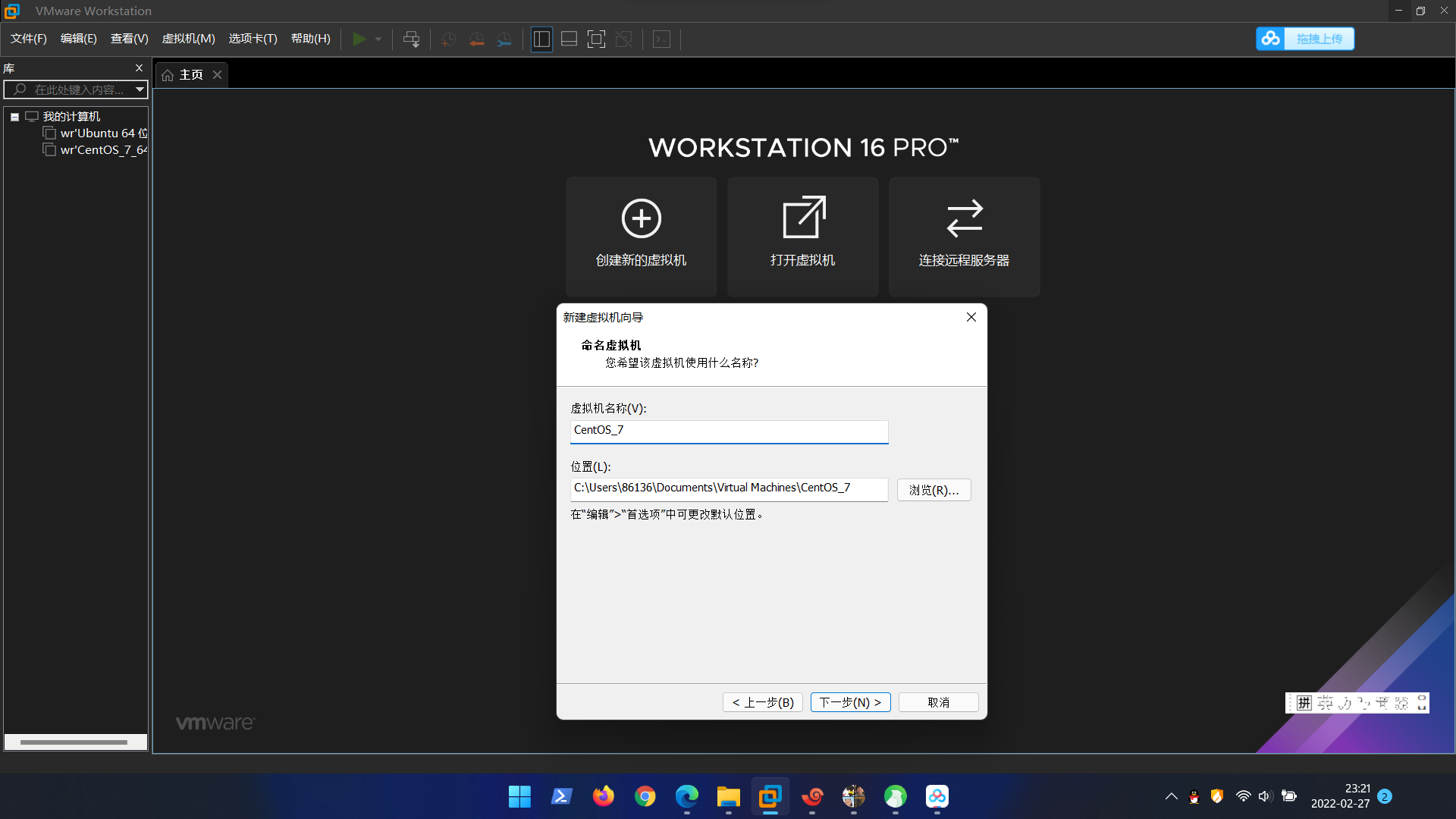

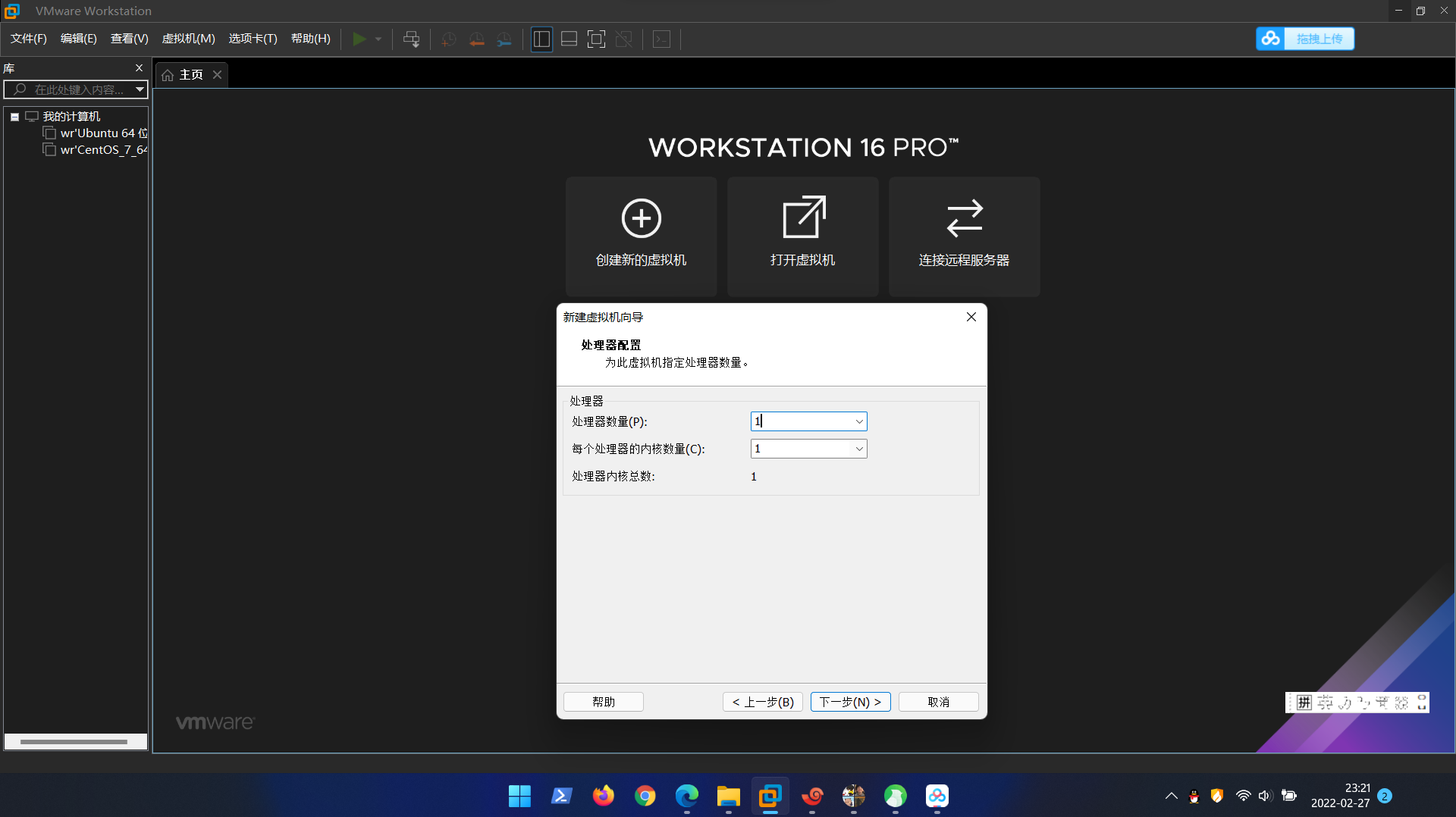

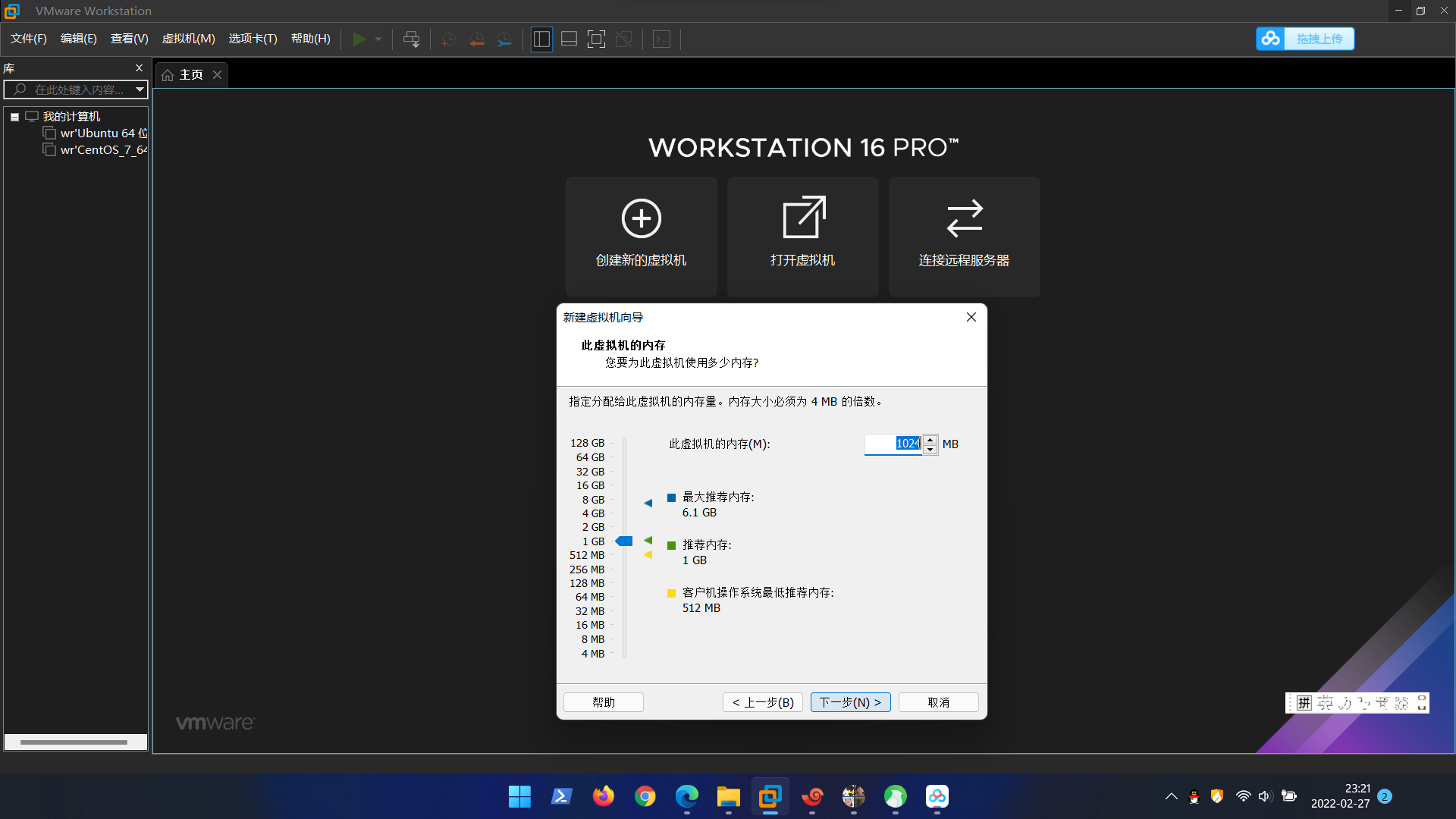

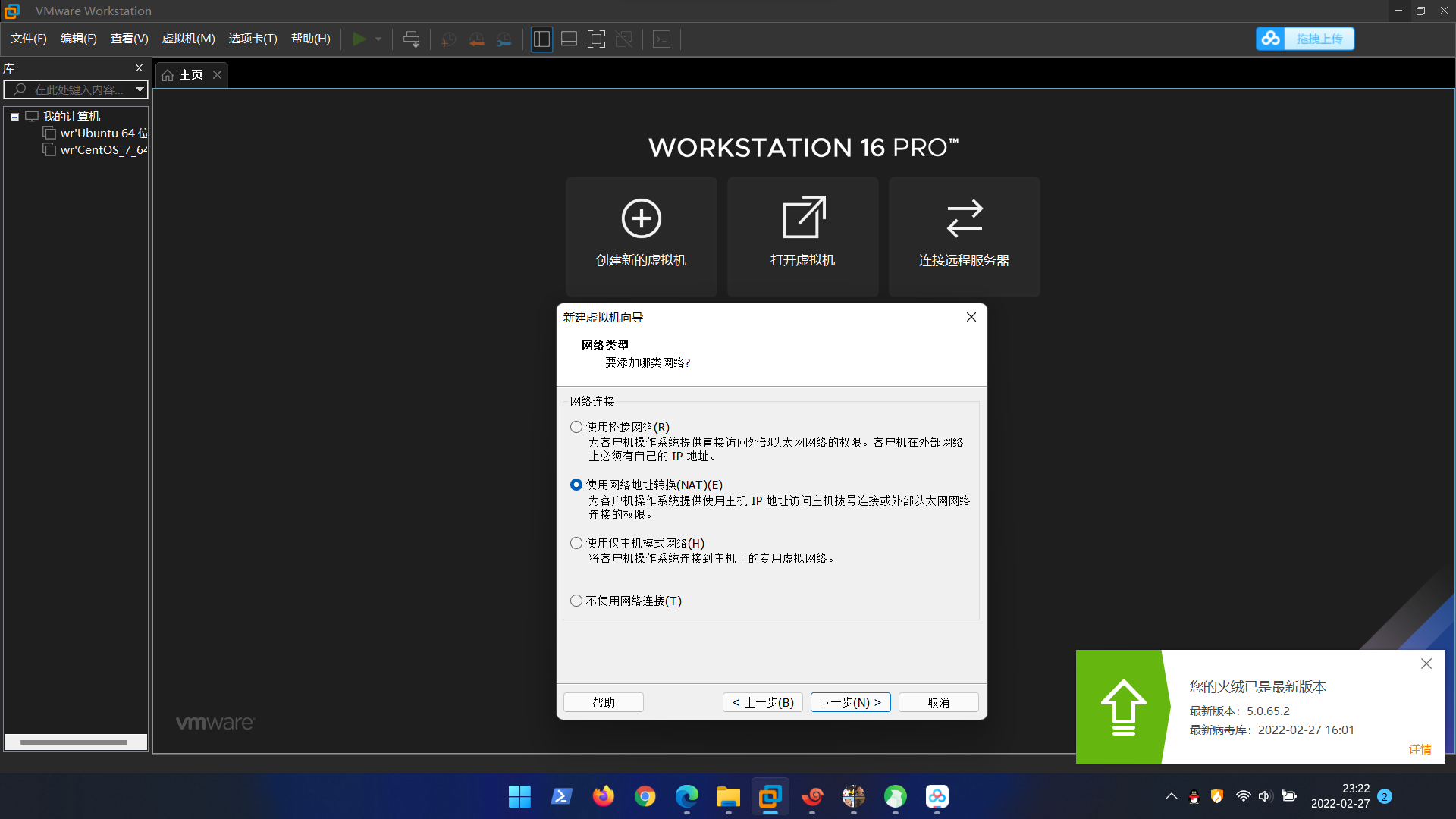

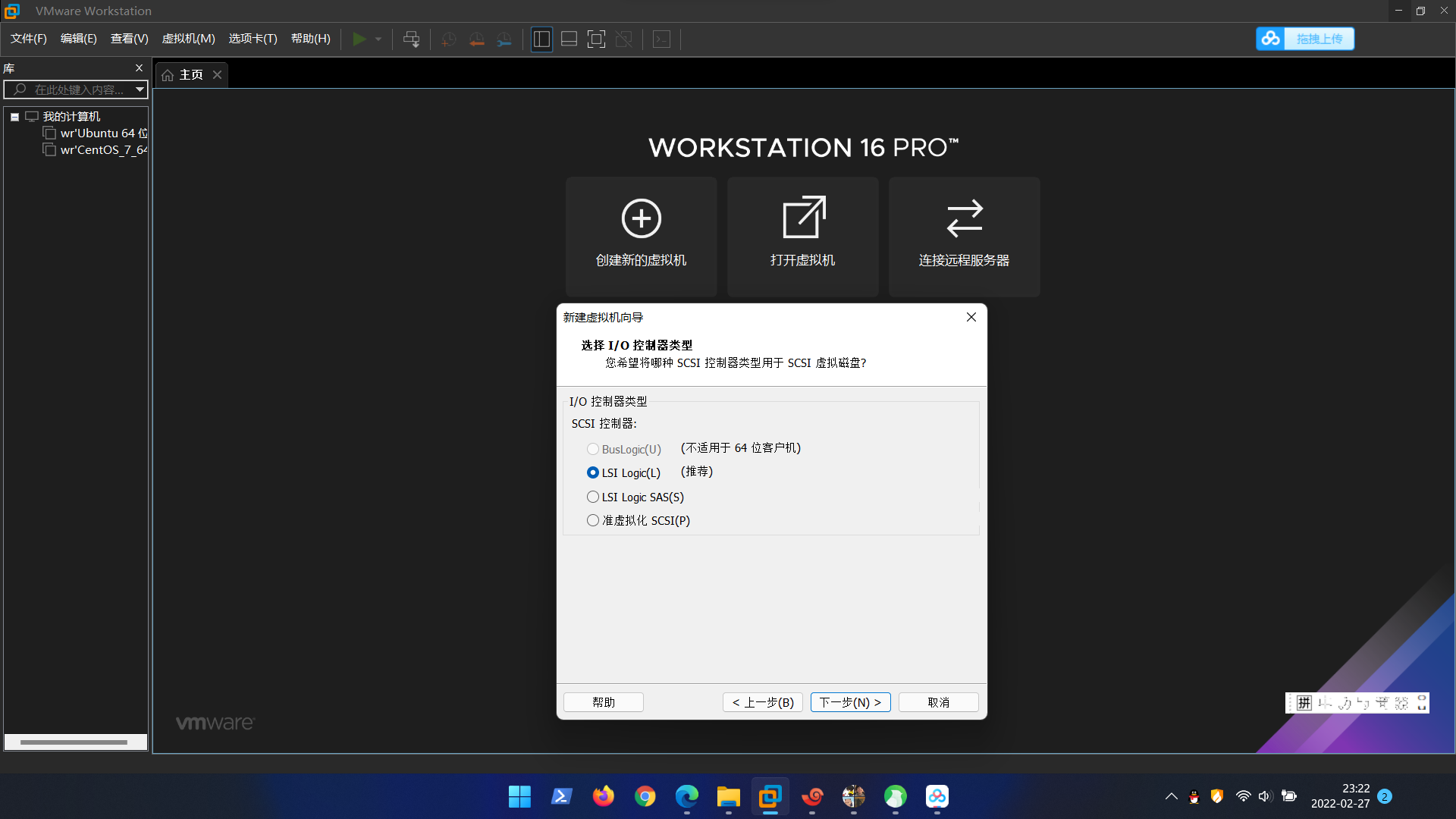

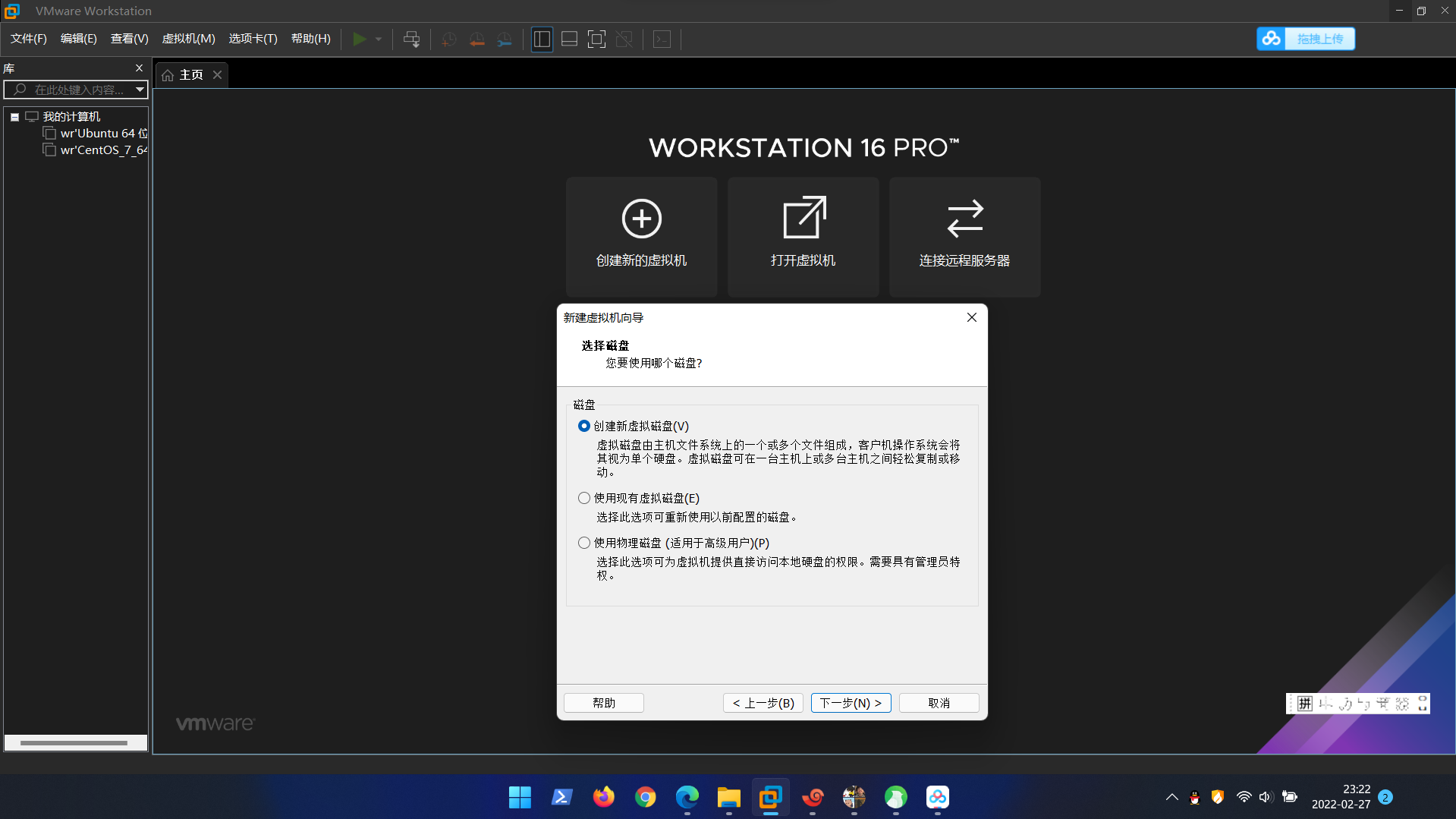

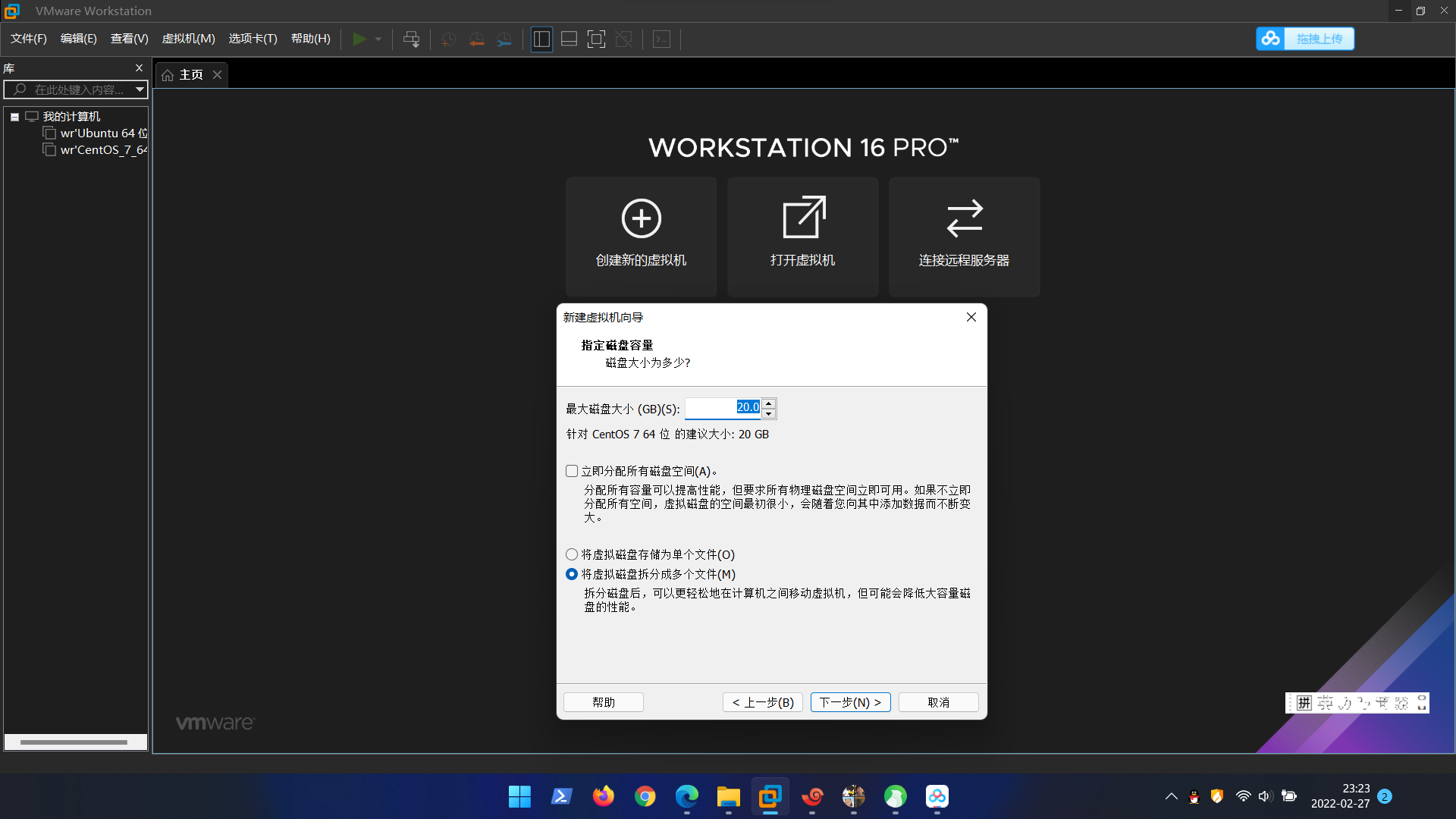

2.创建新的虚拟机

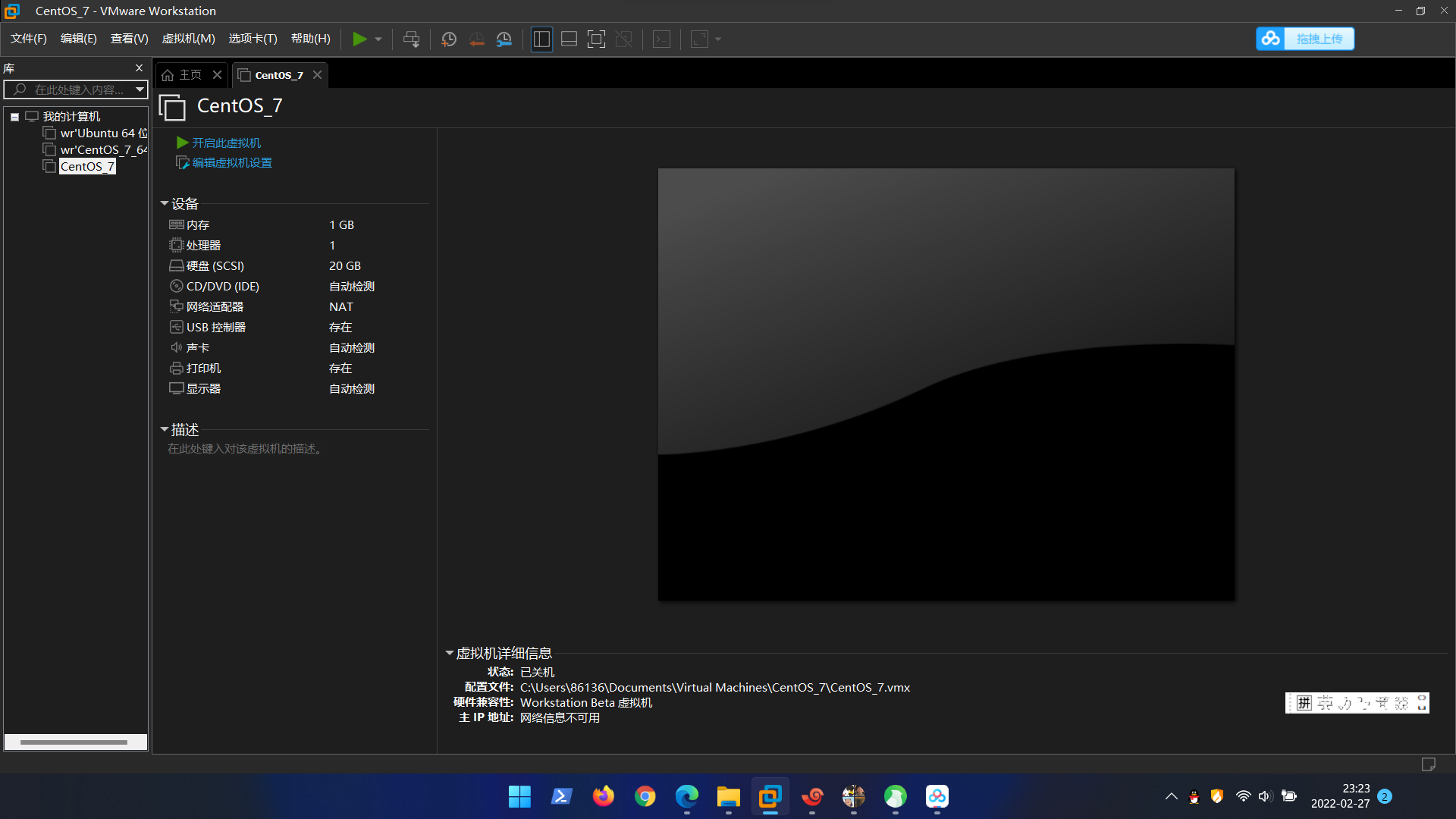

后边全部按照默认走,最后完成如下图

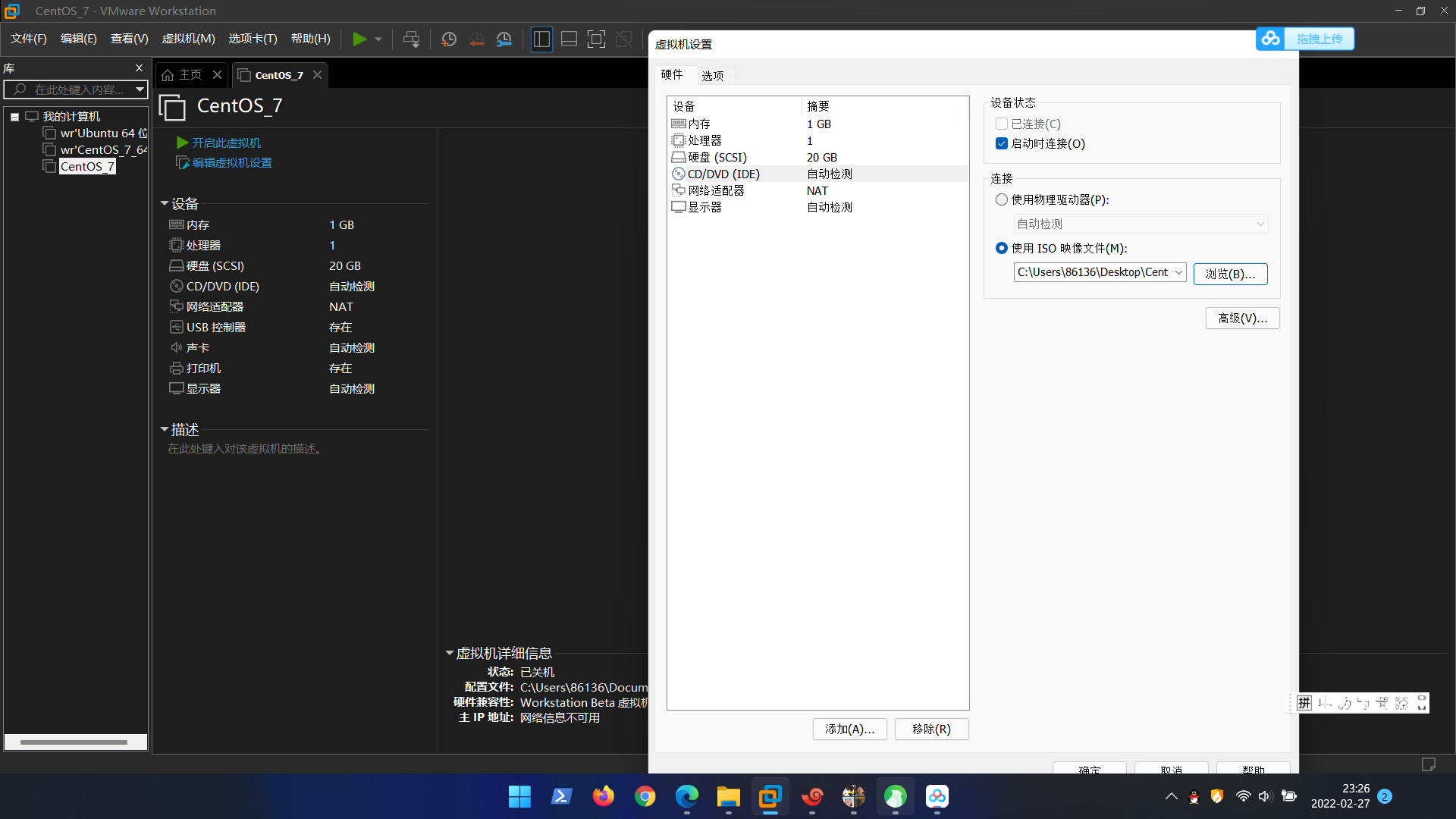

编辑虚拟机设置

1.将USB控制器,声卡,打印机移除,点击CD/DVD然后如下操作,选择对应的CentOS-7-x86_64-DVD-2009文件位置

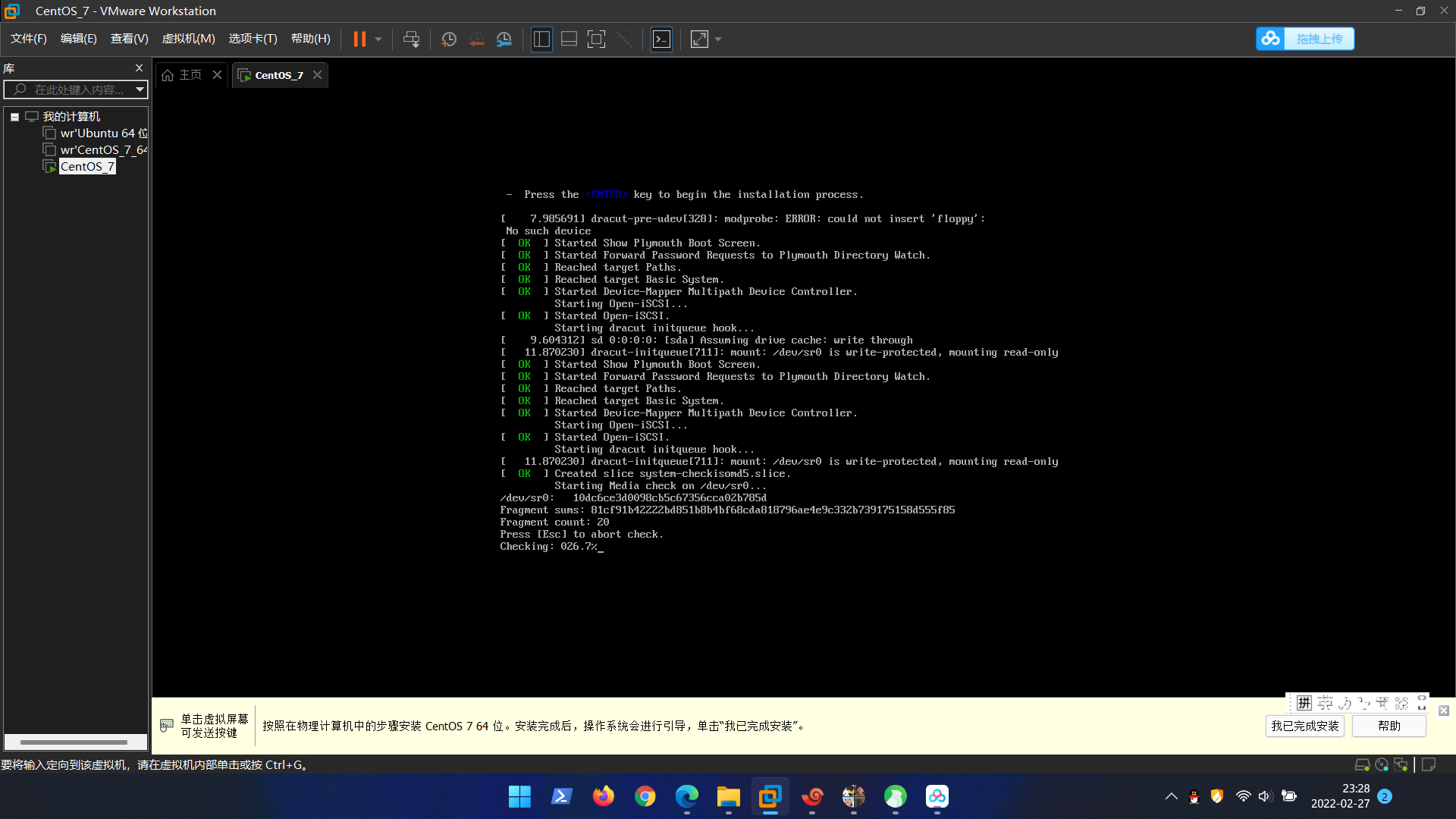

确定后开启此虚拟机

等待开启后点击Eenter开始安装

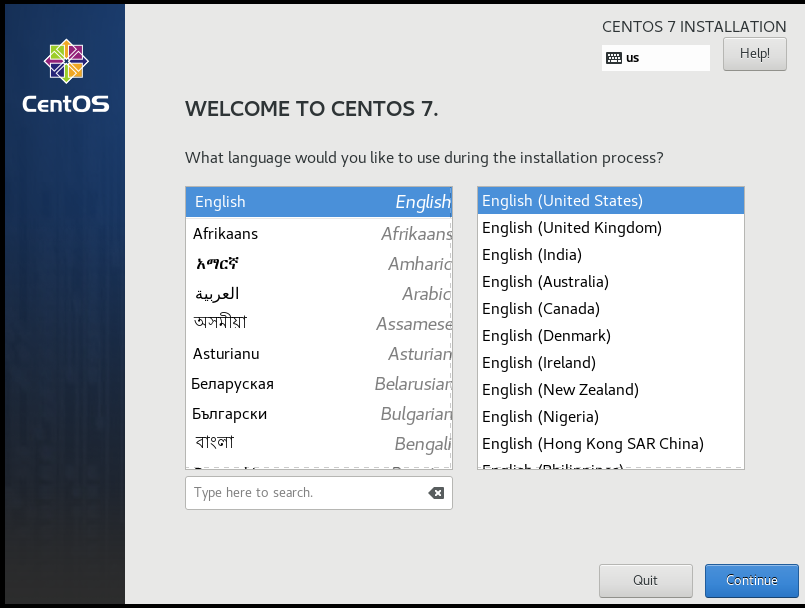

选择如下,点击continue

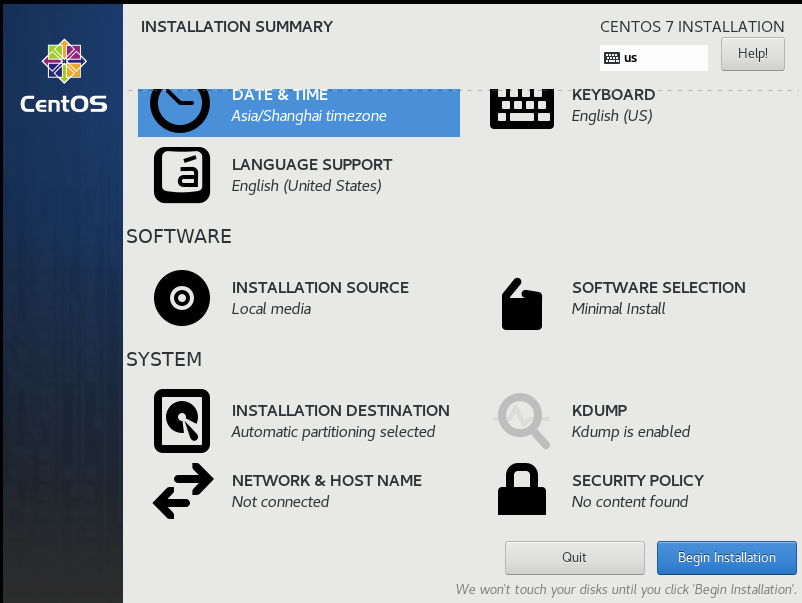

每个选项都点开看一下,和我选择的一致然后点左上角Done保存

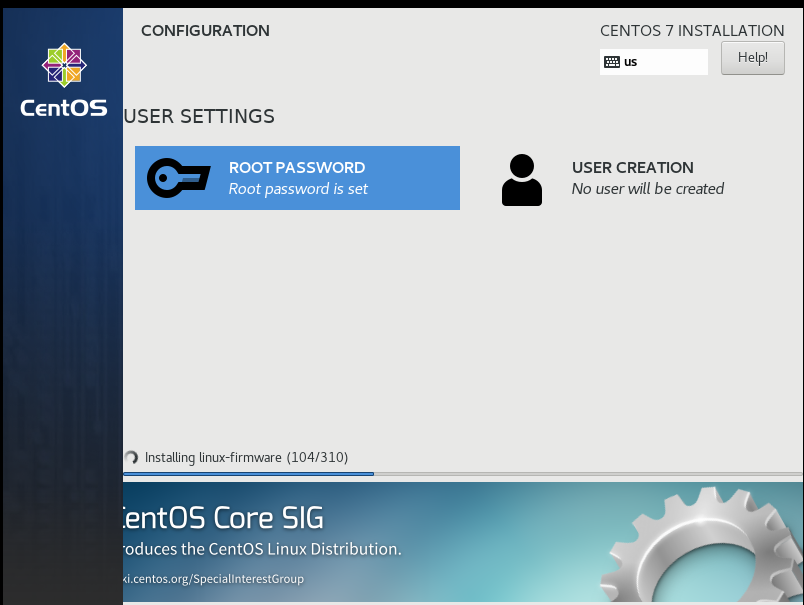

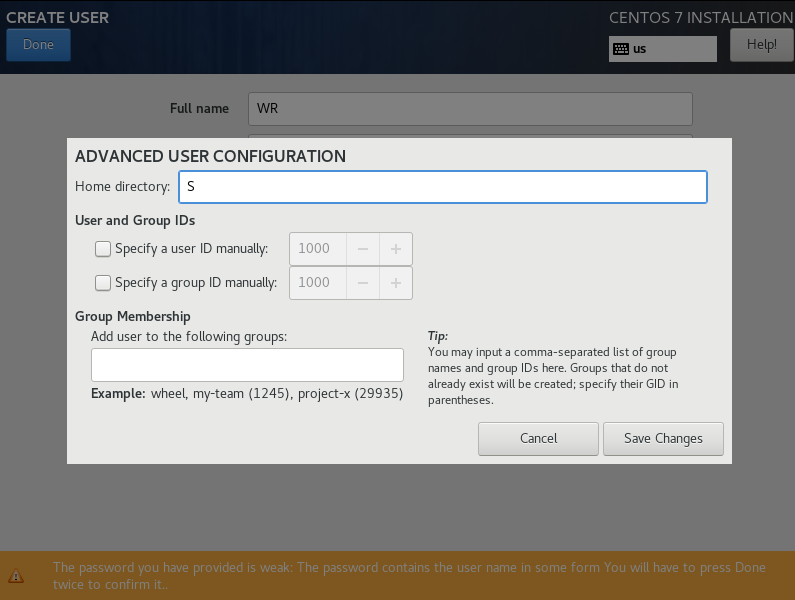

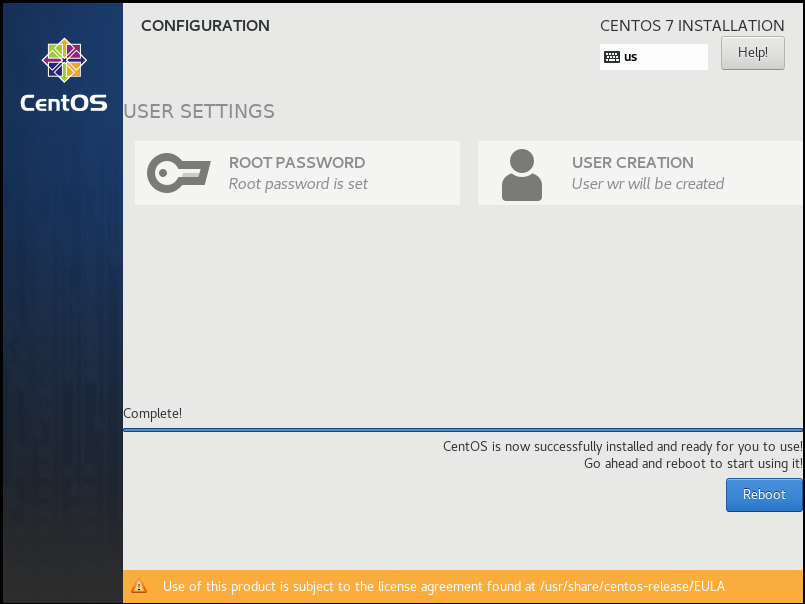

第一个设置一下root权限密码,第二个设置一个初始用户

第二个点击advance后Save Change,保存完等着就好

reboot#重启的意思在命令行中同样可以使用该命令

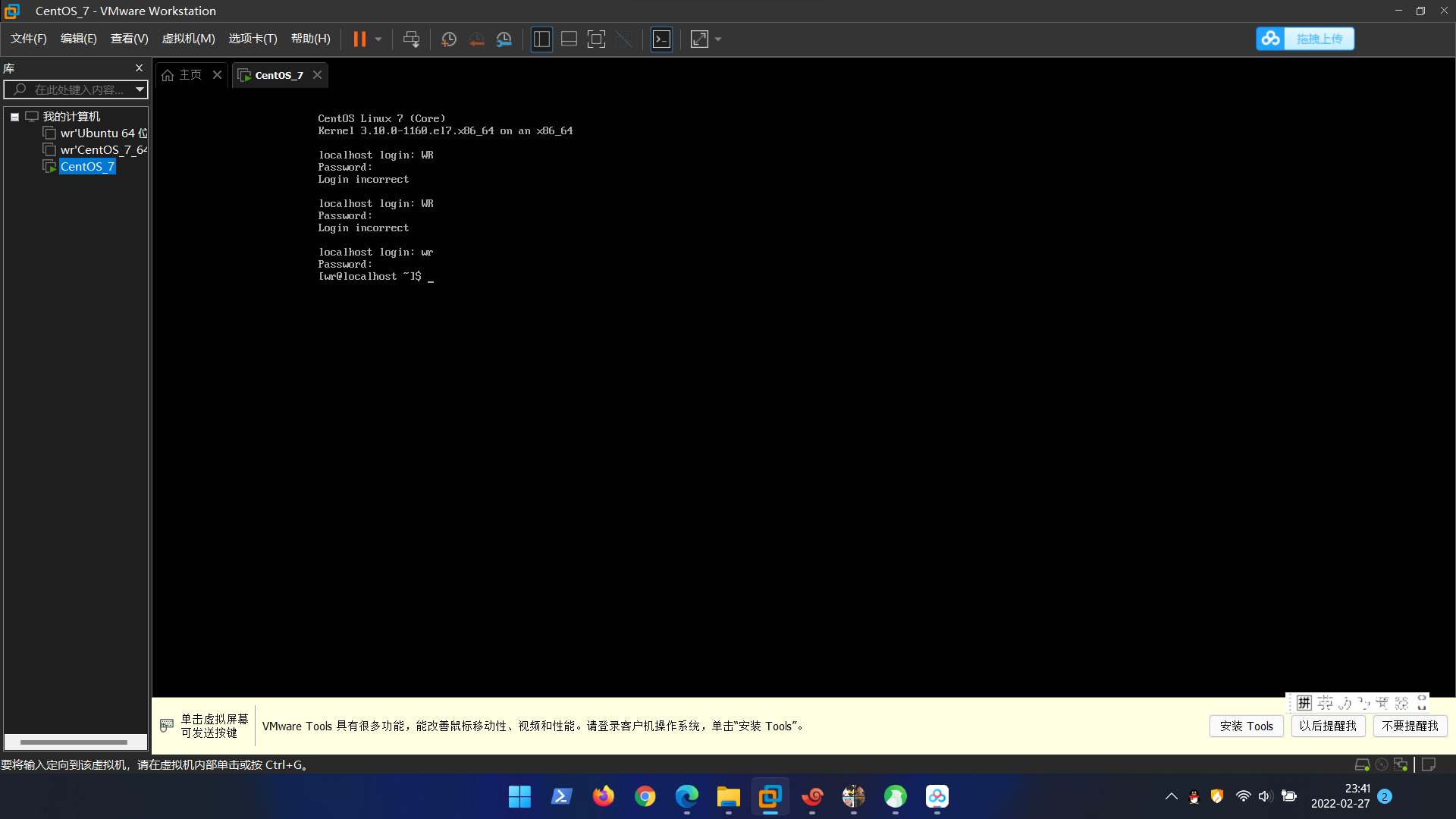

输入刚设置的账号和密码进入系统

3.配置网络环境

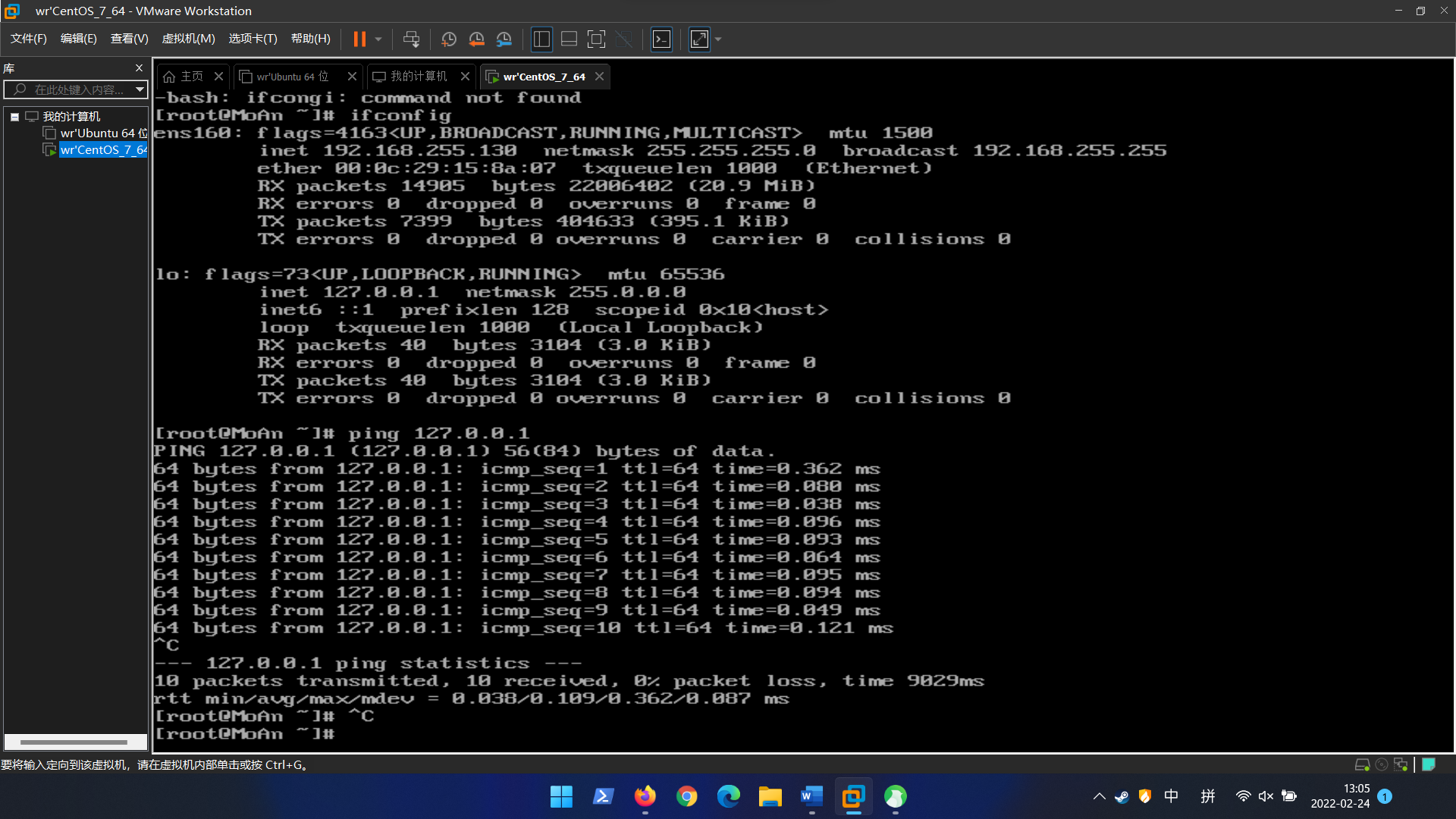

1.ping一下回环地址127.0.0.1

输入代码

ping 127.0.0.1

2.配置静态IP和网关

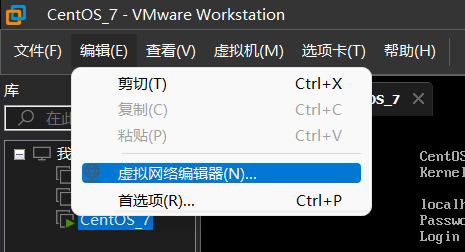

打开VMware,点击编辑 —> 虚拟网络编辑器

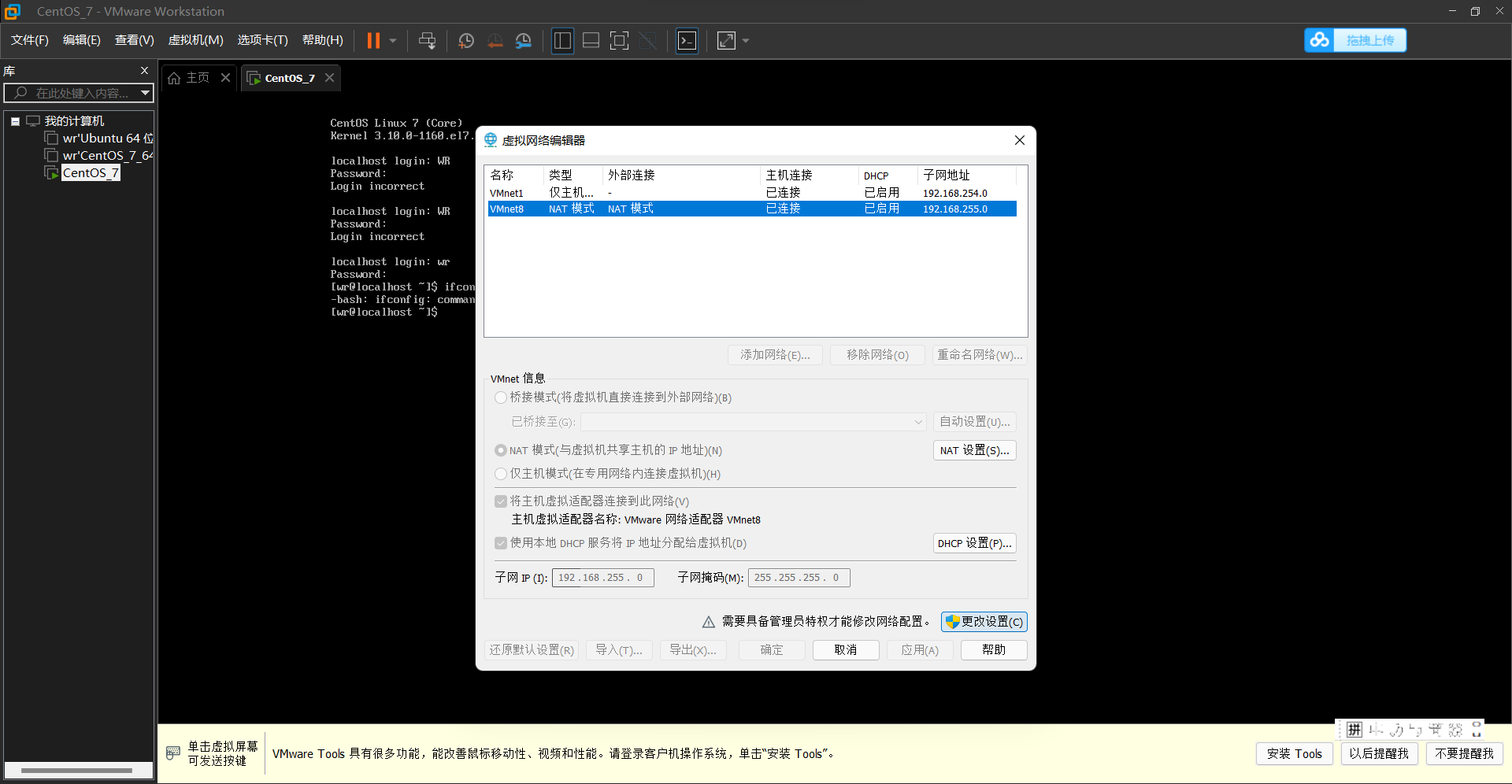

选VMnet8,更改设置。

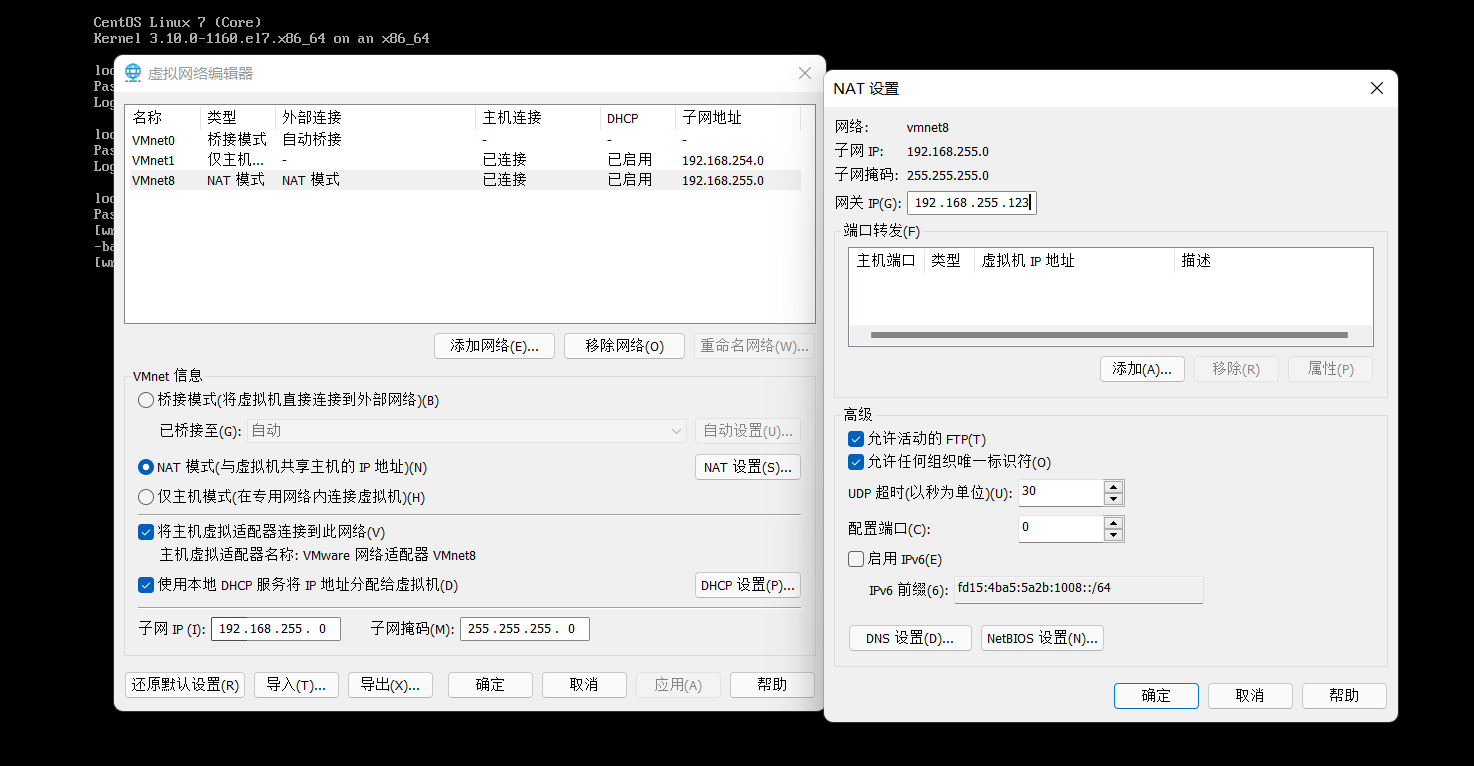

点击VMnet8,和图中选择一样的然后点击NAT设置,设置网关记住我们设置的是192.168.255.123

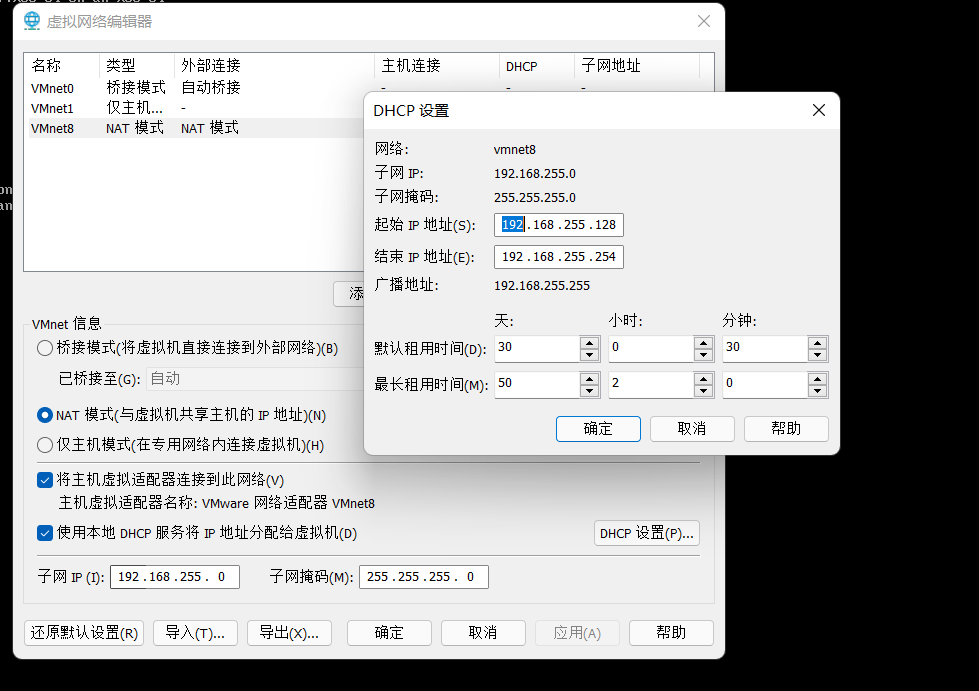

点击确定,再点击DHCP设置,和下图设置一样的

确定,应用,确定就设置完成了

回到虚拟机切换到root用户

su root

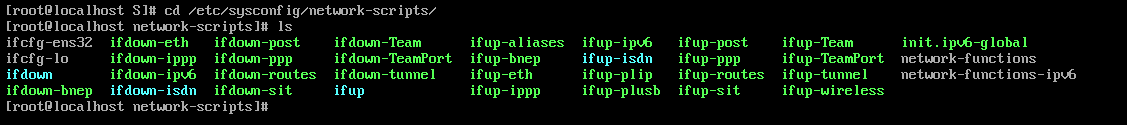

执行切换目录,查看目录下的文件

cd /etc/sysconfig/network-scripts/ls

vi ifcfg-ens32#文件目录中和这个相似或一样的那个,用vi打开它

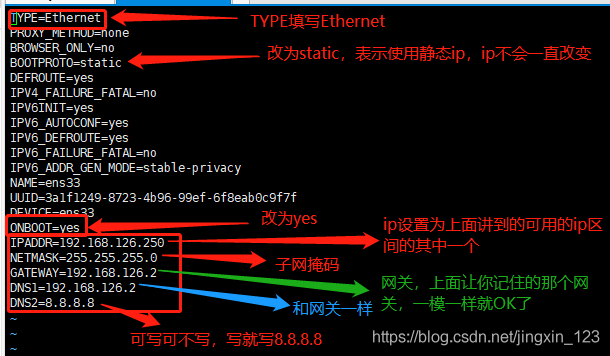

按一下 i键或a键或o键 可以进入编辑模式。

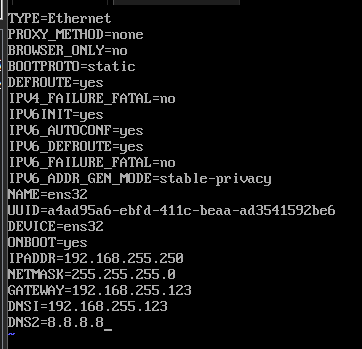

将内容设置为和下面的图标红的地方一样,>>>长方形的内容自己添加上去(TYPE和ONBOOT除外)<<<!!! >>>没标箭头的都不需要动它<<<。。。

咱们的设置完如下所示

写完之后按一下 Esc键 退出编辑模式,然后使用 :wq (冒号加wq) 保存退出。

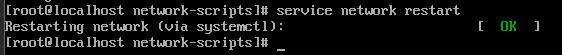

重启网络使用

service network restart

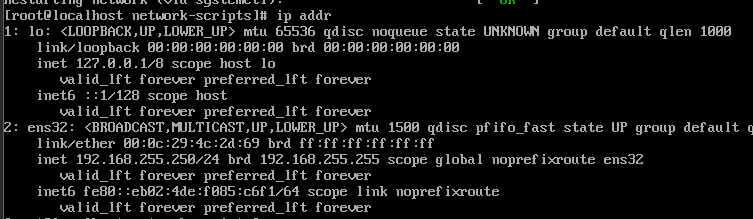

使用ip addr看一下,在ens32中可以看到刚刚设置的IP

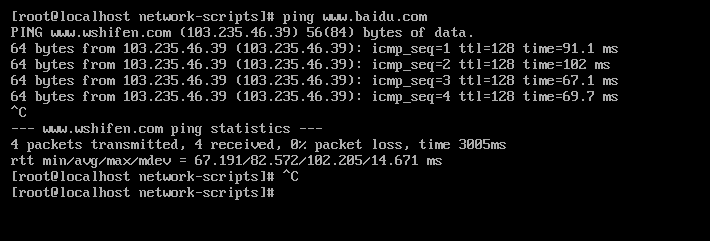

最后ping www.baidu.com看看是否成功,用CTRL+C停止

如图所示就是成功了

3.创建用户和配置防火墙

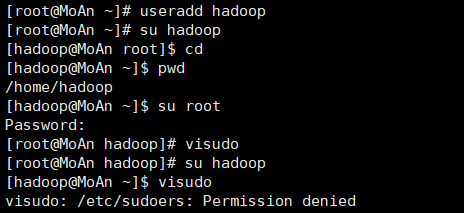

1.创建用户和设置权限

useradd hadooppasswd 你的密码su hadoopcdpwd

groupdel / userdel

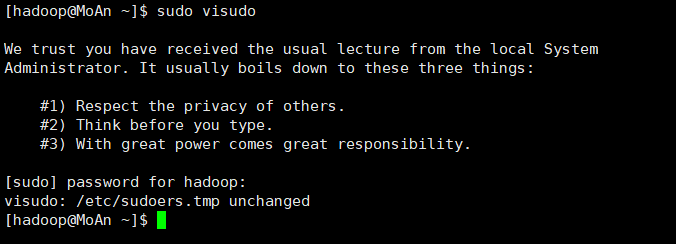

su root#进入root用户

visudo

末尾添加一条

hadoop ALL=(ALL) ALL

sudo visudo

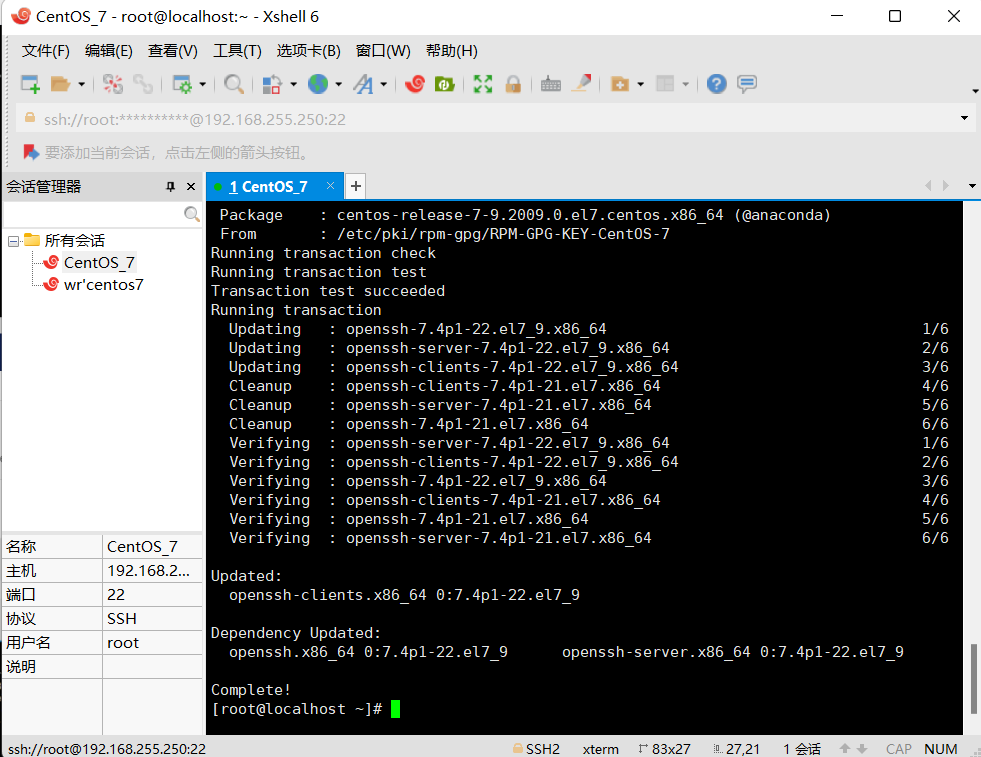

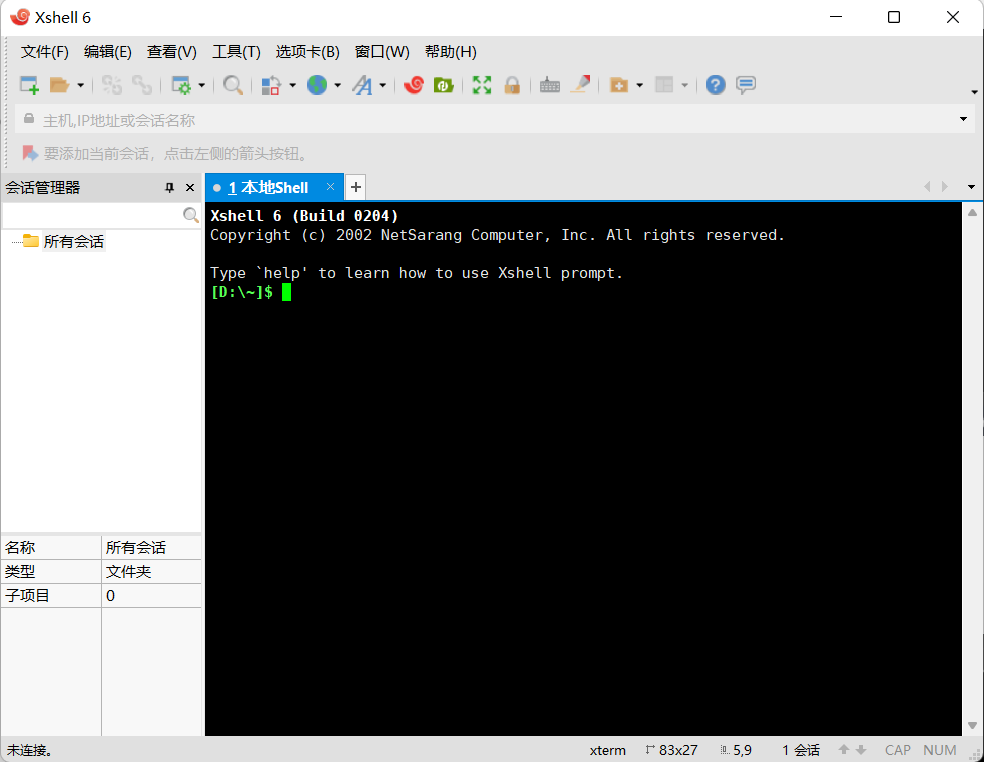

2.安装Xshell

下载链接:https://pc.qq.com/detail/4/detail_2644.html

一路next

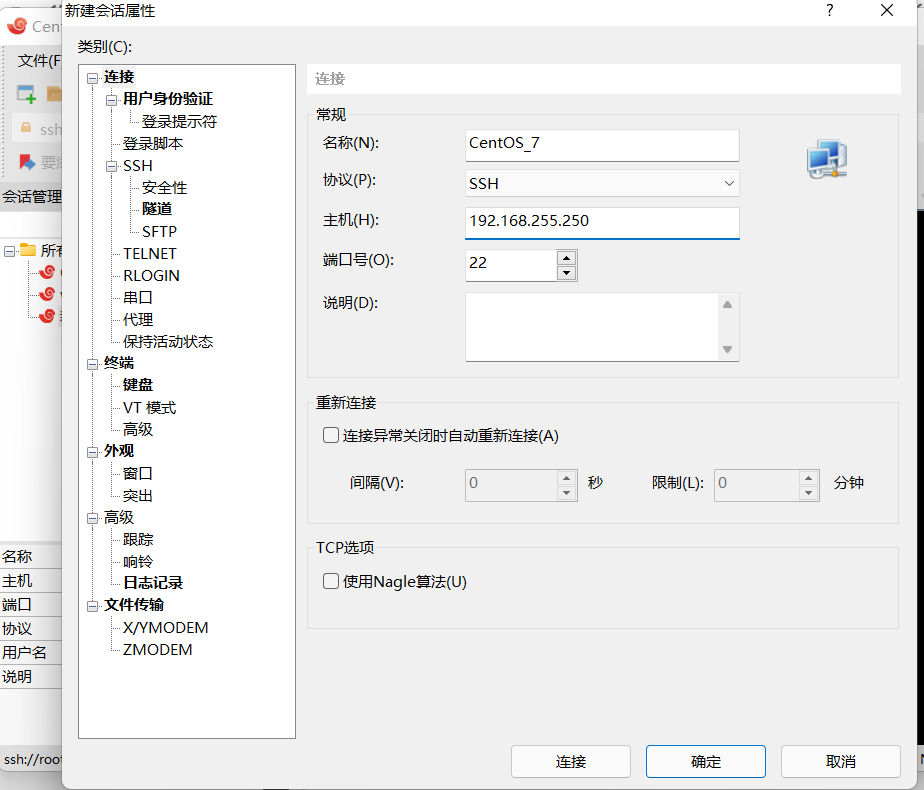

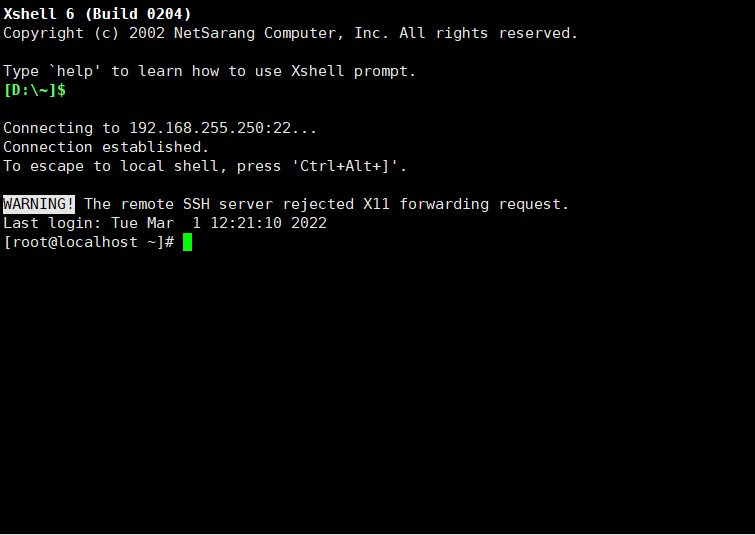

3.创建与虚拟机的连接

文件->新建

名称自定义其它按照照片输入

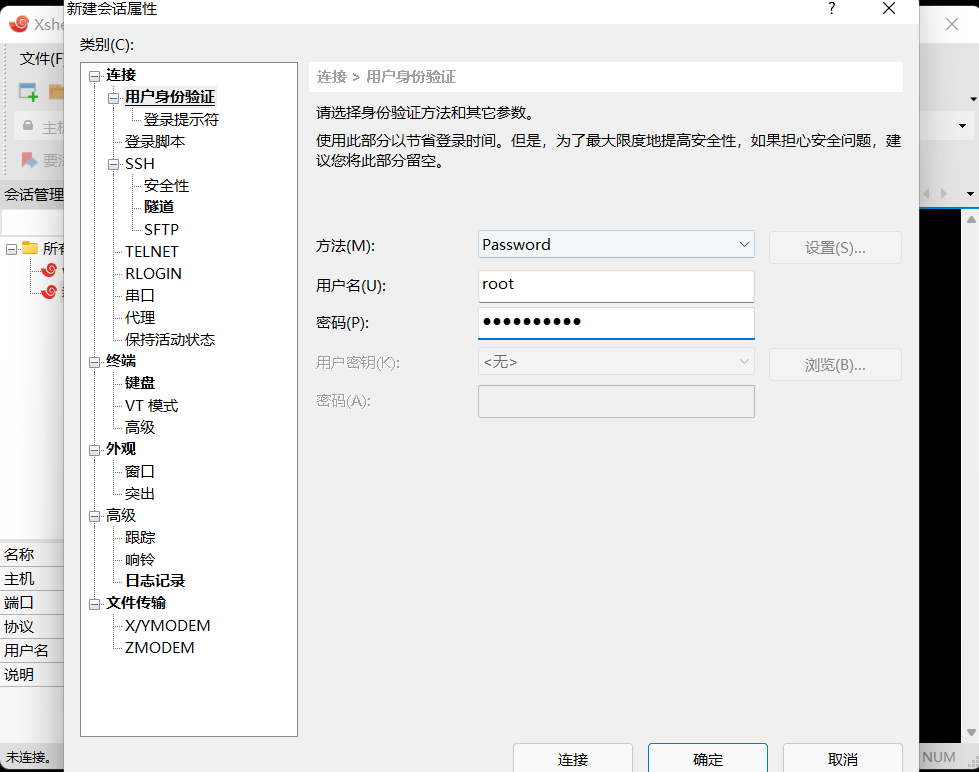

选择用户身份验证,输入root和root用户的密码

成功实现了远程连接的界面

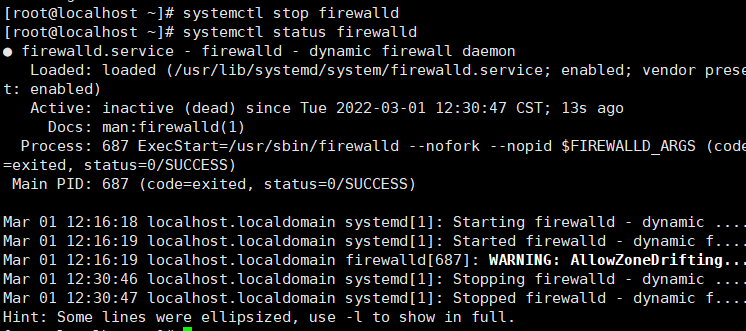

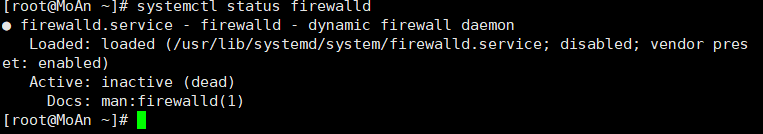

4.关闭防火墙

centos7对应代码应该是

第一步执行:#关闭防火墙

systemctl stop firewalld

查看防火墙的状态对应的是

systemctl status firewalld

这样就是关闭了,前面那个小点为白色,但这是临时关闭的命令。

输入reboot重启电脑,等一会再重新连接。

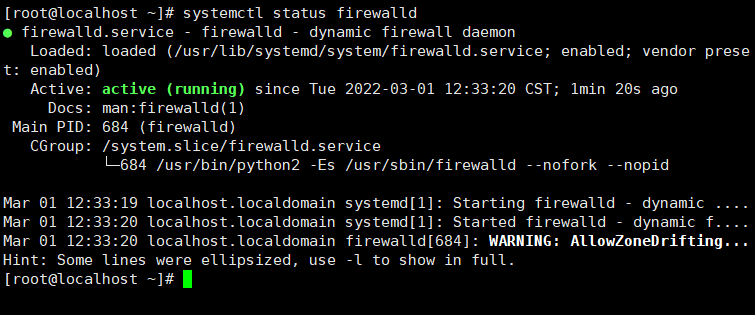

发现防火墙是开启的,我们输入命令

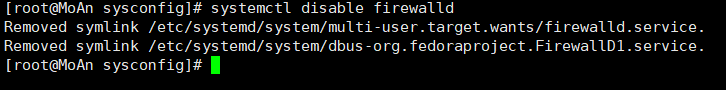

systemctl disable firewalld

重启后生效,输入reboot,再输入systemctl status firewalld 后发现防火墙已经永久关闭。

可参考指令文章:https://www.cnblogs.com/qingmuchuanqi48/articles/15202683.html

4.安装相关服务

yum install net-tools

yum install lrzsz

yum install -y openssh-clients

4.安装hadoop

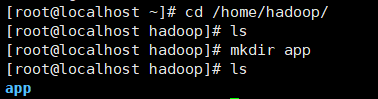

1.在hadoop用户下创建app文件夹

cd /home/hadoop/mkdir app

2.安装JDK

切换到App目录下

cd /home/hadoop/app/

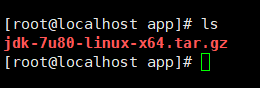

把下载好的jdk上传到系统中,输入rz后选择文件

rz

如图已经上传好了

如图已经上传好了

解压jdk文件

tar zxvf jdk-7u80-linux-x64.tar.gz

删除原安装包

rm jdk-7u80-linux-x64.tar.gz

配置环境变量

vi /etc/profile

在文档末尾插入(i为插入模式)

# set java environmentJAVA_HOME=/home/hadoop/app/jdk1.7.0_80CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarPATH=$JAVA_HOME/bin:$PATHexport JAVA_HOME CLASSPATH PATH

添加完成后ESC+:wq保存退出

执行

source /etc/profile

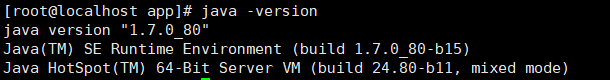

最后看一下JAVA环境有没有安装好

java -version

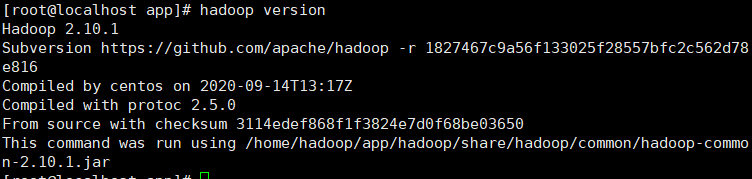

3.安装Hadoop

rz

选择hadoop安装包上传,还是在app目录下

tar zxvf hadoop-2.10.1.tar.gz

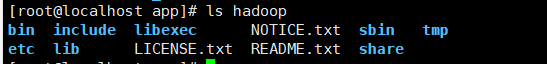

解压完删除原安装包,重命名文件夹好记

rm hadoop-2.10.1.tar.gzmv hadoop-2.10.1 hadoop

配置hadoop环境变量 vi /etc/profile 添加如下配置

# ser hadoop pathexport HADOOP_HOME=/home/hadoop/app/hadoopexport PATH=$PATH:$HADOOP_HOME/bin

所有的文档更改记住保存

重新刷新配置 source /etc/profile

查看版本 hadoop version

创建tmp目录

mkdir hadoop/tmp

创建好了

创建好了

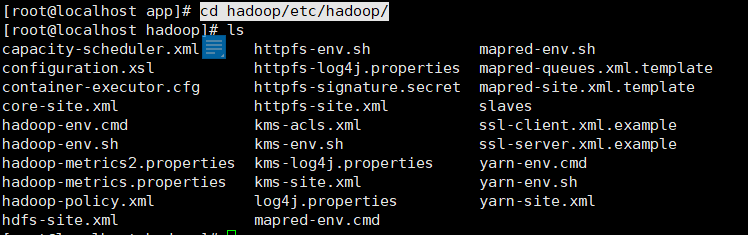

cd hadoop/etc/hadoop/

切换到该目录下,全部是hadoop 的配置文件

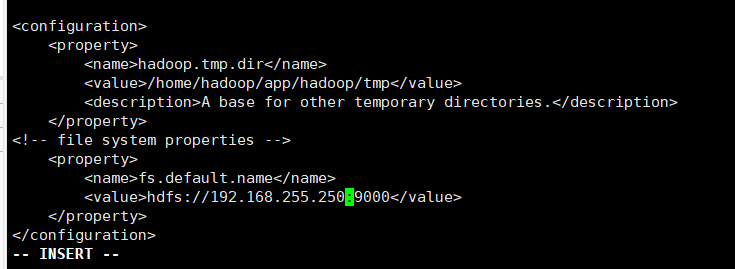

编辑core-site.xml

vi core-site.xml

在

<property><name>hadoop.tmp.dir</name><value>/home/hadoop/app/hadoop/tmp</value><description>A base for other temporary directories.</description></property><!-- file system properties --><property><name>fs.default.name</name><value>hdfs://192.168.255.250:9000</value></property>

ESC+:wq保存退出

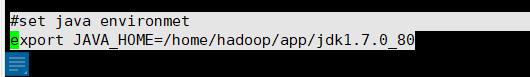

编辑hadoop-env.sh

#set java environmetexport JAVA_HOME=/home/hadoop/app/jdk1.7.0_80

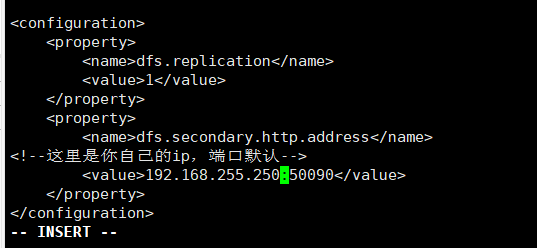

编辑hdfs-site.xml

在

<property><name>dfs.replication</name><value>1</value></property><property><name>dfs.secondary.http.address</name><!--这里是你自己的ip,端口默认--><value>192.168.255.250:50070</value></property>

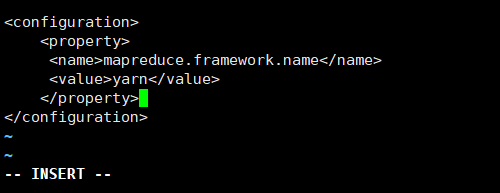

配置mapred-site.xml.template

cp mapred-site.xml.template ./mapred-site.xml

vi mapred-site.xml

在

<property><name>mapreduce.framework.name</name><value>yarn</value></property>

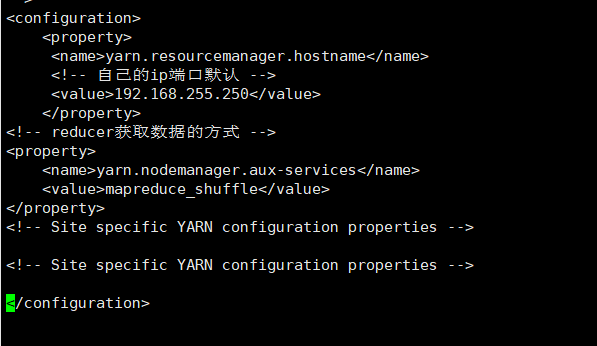

配置yarn-site.xml

vi yarn-site.xml

<property><name>yarn.resourcemanager.hostname</name><!-- 自己的ip端口默认 --><value>192.168.255.123</value></property><!-- reducer获取数据的方式 --><property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property><!-- Site specific YARN configuration properties -->

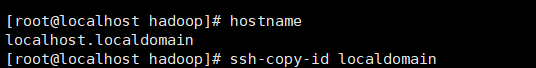

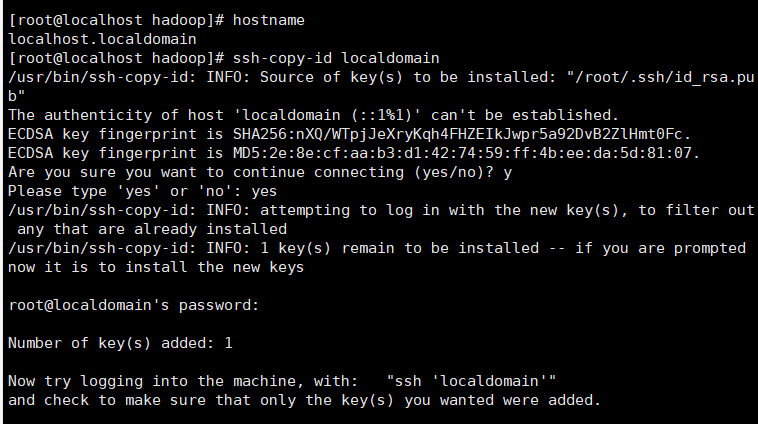

配置一下SSH免密码登录

ssh-keygen -t rsa

弹出东西就按回车知道完成

hostname

ssh-copy-id localdomain

如图就是弄好了

运行hadoop

cd ../../sbin./start-all.sh

接下来就开始运行了,等一等,碰见就输yes

最后

curl 192.168.255.250:50070

看看有没有网站源码输出

再去浏览器输入那个网址看看,192.168.255.250:50070