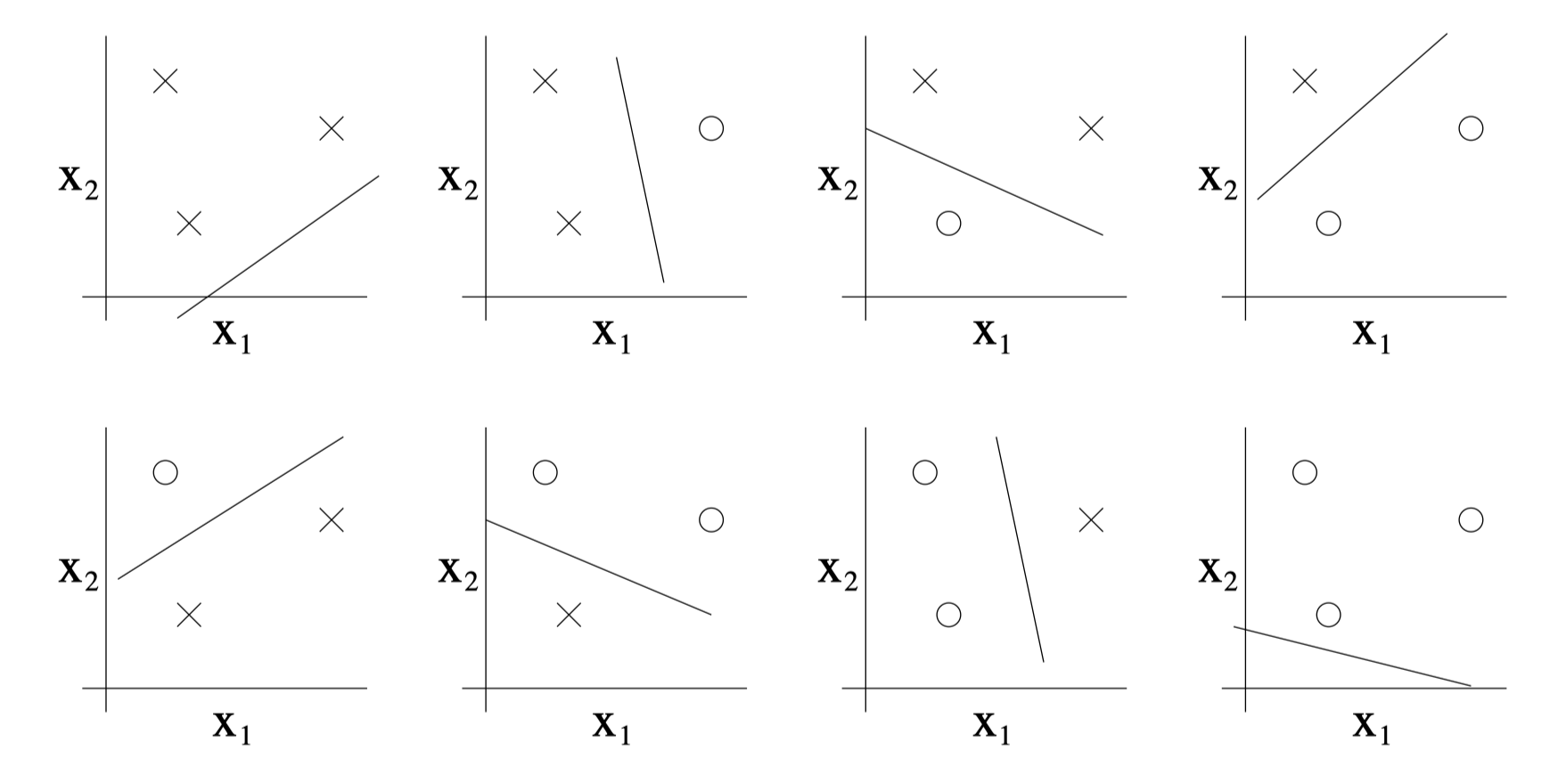

方差与偏差的权衡

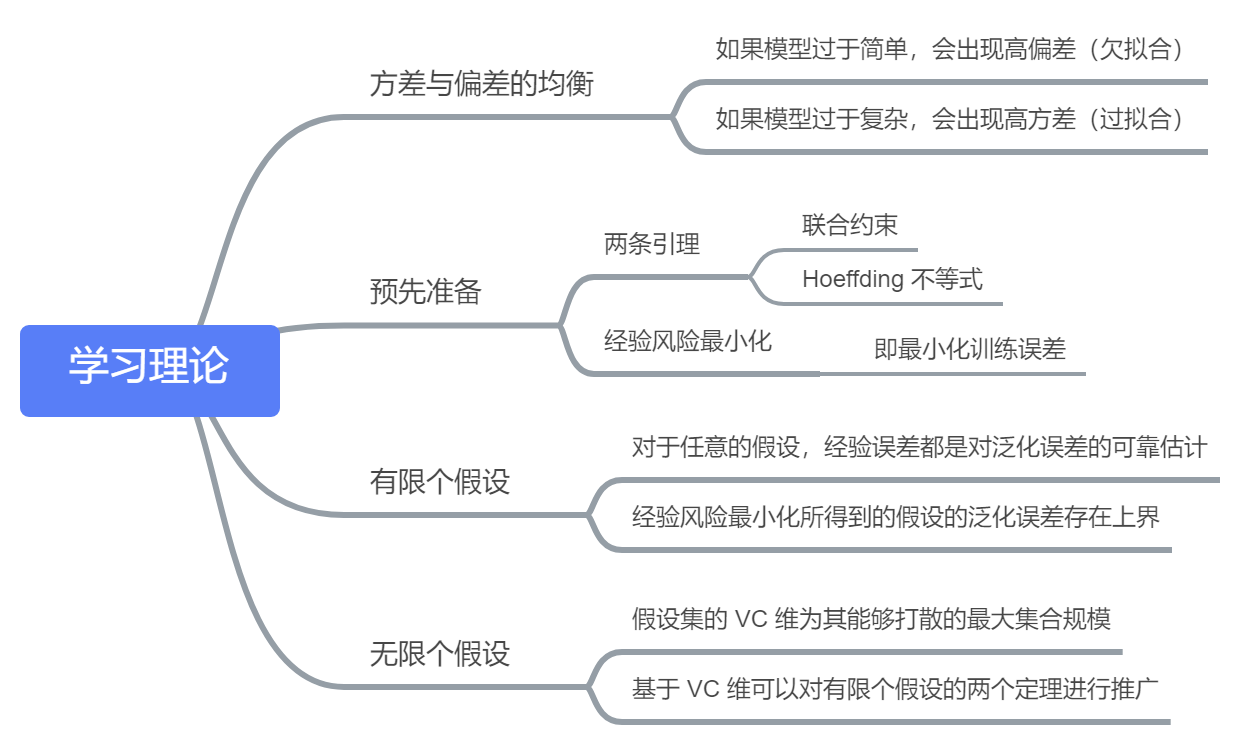

在讨论线性回归的时候,我们尝试用各种不同的模型来拟合训练集,如下图所示:

- 模型可以理解为假设(hypothesis)的集合

可以看到,过于简单或复杂的模型都不能对训练集之外的数据给出合理的预测

- 这表示训练集学习得到的东西并不能被很好地推广到其他数据上

我们用泛化误差(generalization error)来量化这种差异

- 一个假设的泛化误差指不属于训练集的样本的预期误差

上图左边的线性拟合与右边的高次多项式拟合都有非常大的泛化误差,但其反映的问题大不相同

左边的模型得到的假设具有非常大的偏差(bias)

- 偏差较大指的是模型没有捕捉到训练数据的结构特征,即对训练数据欠拟合

右边的模型得到的假设具有非常大的方差(variance)

- 方差较大是指拟合出的模型可能只适合眼下这个小规模的有限训练集,即对训练数据过拟合

我们需要在偏差与方差之间进行权衡:

如果模型过于“简单”,参数非常少,那么可能会有很大的偏差,而方差则很小

如果模型过于“复杂”,有非常多的参数,那么可能会有很大的方差,而偏差则较小

在上图的例子中,用二次函数模型进行拟合得到的效果,要好于其他两种模型

预先准备

先给出两个简单但是有用的引理:

- 联合约束(The union bound)设

是 K 个不同事件(但不一定互相独立),则有:

- 联合约束(The union bound)设

- Hoeffding 不等式(Hoeffding inequality) 设

是

个独立同分布(iid)的随机变量,且其遵循伯努利分布:

,设

为这些随机变量的均值,现在设任意的

为某一固定值,则有:

- 该引理在学习理论中也称为**切尔诺夫约束**(Chernoff bound)- 其表明:如果我们从一个伯努利分布的随机变量中选取平均值  来作为对  的估计值,那么只要  足够大,我们偏移真实值很远的概率就会比较小

基于上述引理,我们就可以证明在学习理论中一些深刻且重要的理论了

为了简化表述,这里以二元分类为例,其中的分类标签为

这里得出的所有结论均可推广至其他问题,包括回归、多元分类等

假设我们有一个给定的训练集

,其样本规模为

,集合中的训练样本

是遵循某概率分布

的独立同分布随机变量

- 对于一个假设

,我们用如下的方法定义训练误差(在学习理论中也称为经验风险或者经验误差):

- 对于一个假设

- 对于某个特定训练样本集合 ,其训练误差记为

- 我们定义泛化误差为:

- 其相当于:对于基于分布  给出的一个新样本  ,假设  对该样本分类错误的概率

- 注意这里假设训练集与检验假设用的数据集服从同一个分布 (这通常被认为是 **PAC** 假设之一)

- 对于线性分类,令

,那么一种合理的拟合参数

的方法是使训练误差最小化:

我们将这个过程称为经验风险最小化(empirical risk minimization)

通过这种方法得到的假设结果就是

ERM 算法是最基础的学习算法,这一节我们主要关注的就是这种算法

- 之前所说的算法如逻辑回归可以看做是对该算法的某种近似

为了更好地研究学习理论,我们可以对上面的问题进行以下抽象:

我们将学习算法所使用的所有假设的集合定义为

(hypothesis class)

- 对于线性分类问题来说:

- 对于线性分类问题来说:

现在可以将 ERM 看作是对函数集合

的最小化,即:

有限个假设的情况

我们先考虑假设集

中的假设个数有限(假定个数为

)的情况

我们会证明下面两个结论:

对于任意的

,

都是对

的可靠估计

的泛化误差

存在上界

对于某个特定的假设

,考虑以下的伯努利随机变量

:

该变量表示

是否进行了错误的分类

对于特定的变量

,

- 我们可以看出,泛化误差

是

的期望值,同时训练误差可以表示为

的均值:

- 根据 Hoeffding 不等式,我们有:

- 这表明,对于特定的假设

,如果

很大,那么训练误差与泛化误差接近的概率将会非常大

但是我们希望证明这一结论对于假设集中所有的假设均成立

为此我们需要定义

为事件

我们已经证明了,对于任意特定的

,

成立

根据联合约束,我们有:

- 等式两边同时用 1 去减,可以得到:

- 因此对于任意的 , 和  相差在  之内的概率至少为

- 该结论被称为**一致收敛**(uniform convergence)

在上述证明中,我们感兴趣的变量有三个:

,

,以及训练误差与泛化误差相差大于

的概率

- 我们可以将其中的任意一个变量用其他两个变量来约束

例如,给定

和某个

,

至少应该取多少,才能保证训练误差与泛化误差相差在

之内的概率至少为

?

- 根据一致收敛的结论,我们有 ,从而得到:

- 这个约束告诉我们为了对结果有所保证我们需要有多大的训练样本量

- 某个算法为了实现一定程度的性能所需要的训练集规模  也被称为该算法的**样本复杂度**(sample complexity)

- 上面的约束还表明为了保证结果,所需的训练集规模只是假设个数  的_对数_

- 类似地,我们可以固定

和

的值,求解

,得到

- 从而对所有的

,有:

利用一致收敛的结果,我们可以证明

的泛化误差

存在上界

- 定义

为假设集

中的最佳假设(使泛化误差最小),则有:

- 定义

- 第一行不等式使用了一致收敛的结论

- 第二行不等式使用了  的定义,即对于所有的 ,都有

- 第三行不等式同样使用了一致收敛的结论

- 我们得到:如果一致收敛发生,那么  的泛化误差最多比假设集  中的最佳假设大

进一步地,将上述结论整合在一起,可以得到如下定理:

- 定理:令

,保持

和

不变,则在至少

的概率下 ,我们有:

- 定理:令

上述定理为我们量化了模型选择中方差与偏差的权衡问题

假设我们有一个假设集

,考虑将它更换为某个更大的假设集

(可以理解为从简单的模型换成复杂的模型)

那么对于上面的定理,第一项

只会减少(因为可选择的假设更多了)

- 这可以理解为通过使用一个更大的假设集,偏差减少了

但是,如果

变大,那么第二项会增加

- 这对应为方差的增加

与之前类似,我们可以得到下述关于样本复杂度的推论:

- 推论:令

,保持

和

不变,那么为了满足

成立的概率至少为

,则有:

- 推论:令

无限个假设的情况

下面考虑假设集中假设个数无限的情况

让我们先通过一个不太精确的论证来获得对于无限假设集的直观印象

假设假设集

中的每一个假设有

个实数参数

由于我们使用计算机来表示实数,而 IEEE 双精度浮点数为 64 个比特位,所以假设集中的每一个假设的参数总共包含

个比特位

- 因此,我们的假设集中最多包含

种不同的假设

- 因此,我们的假设集中最多包含

根据上一节最后的推论,为了满足

成立的概率至少为

,则有:

- 这表明需要的训练集样本的数量最多与模型的参数呈**线性**关系

虽然上述推论不够严谨(建立在对参数计算机化表达的基础之上),但是其结论是基本正确的:如果我们尝试去最小化训练误差,并使得其能够学习到一个较好(泛化误差小)的假设(含有

个参数),那么我们需要

的线性数量级的训练样本数量

上述结论适用于大部分使用 ERM 或其近似的判别学习算法,对于非 ERM 学习算法的理论证明还在研究中

上述论证的另一个不严谨之处在于其依赖于假设集

的参数化

直观来看,这并没有什么影响

对于一个线性分类器,如果将它写作

,那么其参数共有

个

如果将它写作

,那么其参数共有

个

两种情况都可以看做相同的假设集

:一个

维空间的线性分类器集合

为了进行更严谨的论证,给出如下定义:

给定一个点的集合

(与训练集无关),其中

(即每个点维数相同)

对于一个假设集

,我们认为

打散(shatter)了

如果

可以实现

的任意标签化

- 即对于任意的标签集合

,都存在某个

使得

对于所有的

均成立

- 即对于任意的标签集合

我们定义一个假设集

的 VC 维(Vapnik-Chervonenkis dimension)为该假设集能够打散的最大集合规模

如果

可以打散任意大的集合,那么

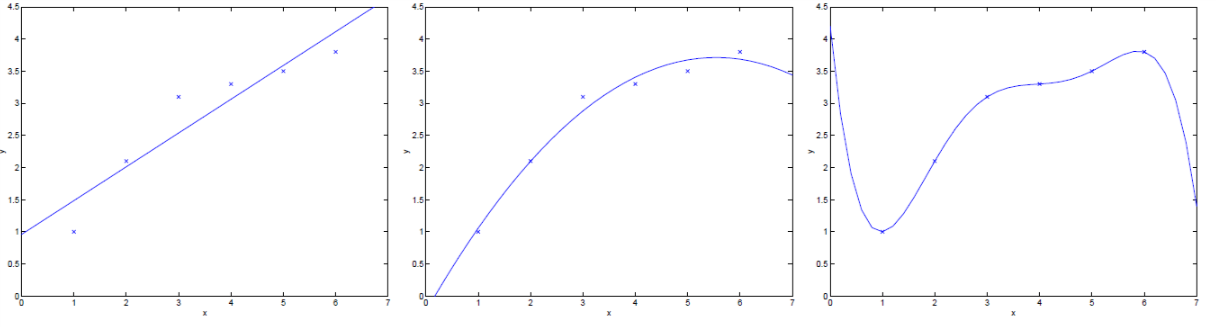

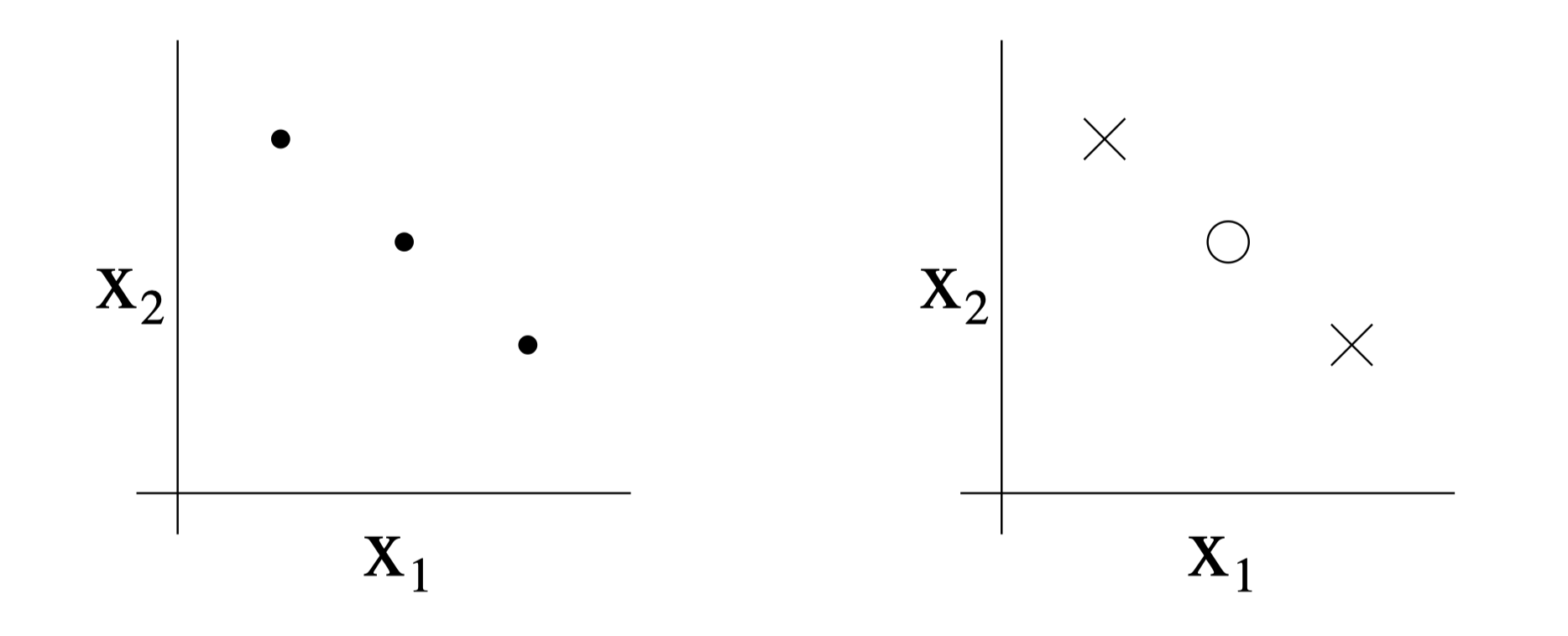

例如,对于下图所示的三个点的集合:

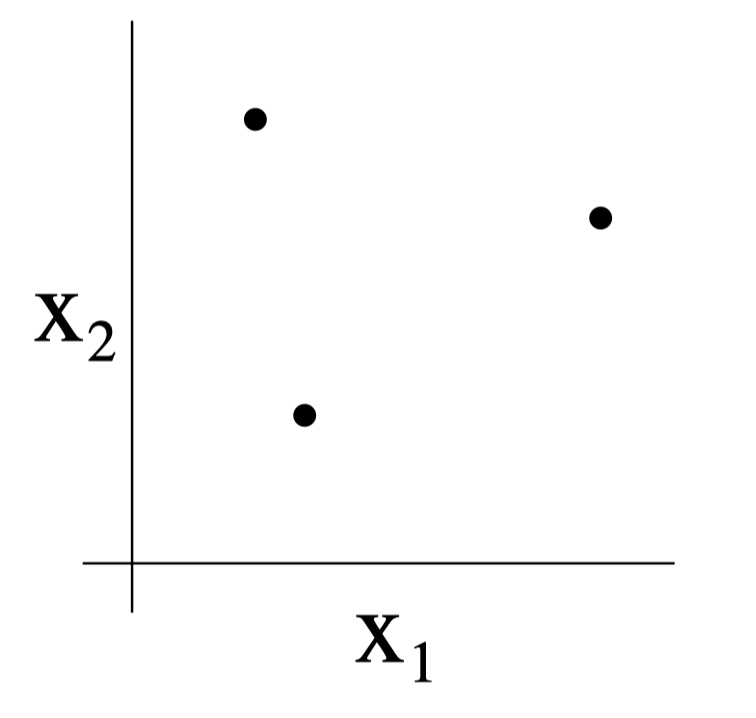

- 可以发现,对于一个二维线性分类器集合 ,它能够打散上面的点集,具体如下图所示:

- 此外,还可以证明该假设集并不能打散任何一个 4 个点的集合,因此其 VC 维为3

- 注意:即便上述假设集的 VC 维的为 3 ,还是可能存在不能被该假设集打散的三点集合。例如下图所示的三点集合,上述线性假设集并不能打散该点集

- 换句话说,在 VC 维的定义下,要保证  至少为 ,只需要证明至少有一个规模为  的点集能够被  打散即可

基于 VC 维,我们可以给出如下定理(学习理论中最重要的定理之一):

- 定理:给定

,设

,那么对于所有的

,都有至少

的概率使得:

- 定理:给定

- 因此,在至少  的概率下,我们还有:

上述定理表明,如果一个假设集的 VC 维有限,那么只要

足够大,就可以保证一致收敛成立,同时可以得到

关于

的上界。与之前类似,我们还可以给出如下推论:

推论:为了满足

对所有

成立的概率至少为

,可以证明

该推论表明,为了使学习效果较好,所需的训练集样本数量与假设集的 VC 维线性相关

而对于大部分的假设集,其 VC 维和参数数量(假定可以合理的参数化)近似线性相关

将上述结论综合起来,我们可以得出:对于一个 ERM 学习算法,其所需的训练样本数量近似与假设集的参数个数线性相关