制作中文词云和制作英文词云的流程大体相同,由2个区别:中文需要分词,中文的显示需要相应的字体支持。

英文单词之间采用空格作为强制分隔符。但是,中文的文本就没有这种空格区隔了。为了做词云,我们首先需要知道中文文本里面都有哪些“词”。

如何用电脑把中文文本正确拆分为一个个的单词呢?这种工作,专业术语叫做分词。

yes-minister-cn.txt

simsun.ttf.zip 下载后需要解压缩后上传

代码

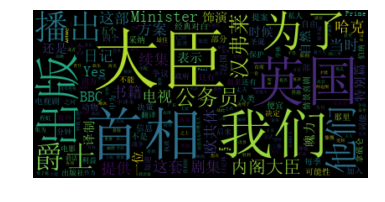

filename = "../dataset/yes-minister-cn.txt"with open(filename) as f:mytext = f.read()import jiebamytext = " ".join(jieba.cut(mytext))from wordcloud import WordCloudwordcloud = WordCloud(font_path="../font/simsun.ttf").generate(mytext)%pylab inlineimport matplotlib.pyplot as pltplt.imshow(wordcloud, interpolation='bilinear')plt.axis("off")

如果没有中文字库,显示的效果是这样的: