有哪些网站用爬虫爬取能得到很有价值的数据? - 知乎

2017年4月5日 星期三

09:16

124 个回答

何明科

创业、互联网、投资 话题的优秀回答者

这个问题蛮适合我这种老爬虫来回答。

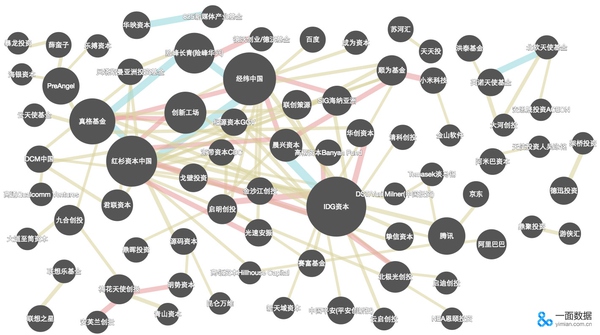

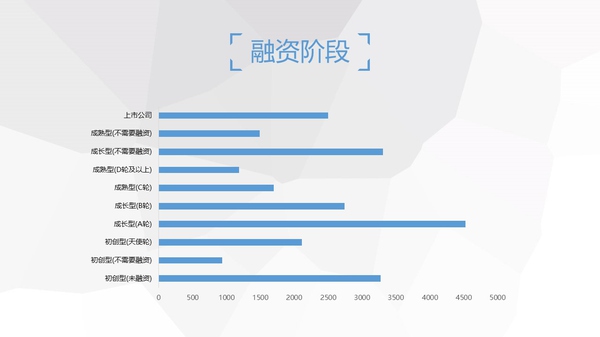

0、IT桔子和36Kr

在专栏文章中(http://zhuanlan.zhihu.com/p/20714713…),抓取IT橘子和36Kr的各公司的投融资数据,试图分析中国各家基金之间的互动关系。

1、知乎

沧海横流,看行业起伏(2015年) - 数据冰山 - 知乎专栏,抓取并汇总所有的答案,方便大家阅读,找出2015年最热门和最衰落的行业

有空的时候,准备写爬虫分析知乎的关系链。

2、汽车之家

大数据画像:宝马车主究竟有多任性? - 数据冰山 - 知乎专栏,利用论坛发言的抓取以及NLP,对各种车型的车主做画像。

3、天猫、京东、淘宝等电商网站

超越咨询顾问的算力,在用户理解和维护:大数据改变管理咨询(三) - 数据冰山 - 知乎专栏,抓取各大电商的评论及销量数据,对各种商品(颗粒度可到款式)沿时间序列的销量以及用户的消费场景进行分析。

甚至还可以根据用户评价做情感分析,实时监控产品在消费者心目中的形象,对新发布的产品及时监控,以便调整策略。

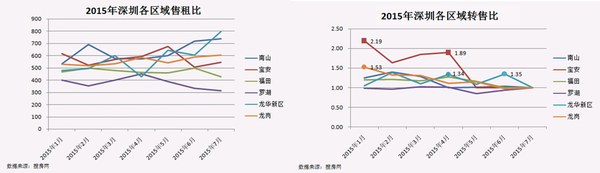

4、58同城的房产、安居客、Q房网、搜房等房产网站

下半年深圳房价将如何发展 - 数据冰山 - 知乎专栏,抓取房产买卖及租售信息,对热热闹闹的房价问题进行分析。

5、大众点评、美团网等餐饮及消费类网站

黄焖鸡米饭是怎么火起来的? - 何明科的回答,抓取各种店面的开业情况以及用户消费和评价,了解周边变化的口味,所谓是“舌尖上的爬虫”。

以及各种变化的口味,比如:啤酒在衰退,重庆小面在崛起。

6、58同城等分类信息网站

花10万买贡茶配方,贵不贵? - 何明科的回答,抓取招商加盟的数据,对定价进行分析,帮助网友解惑。

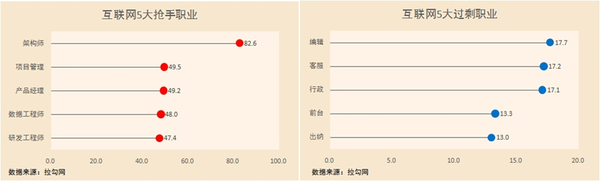

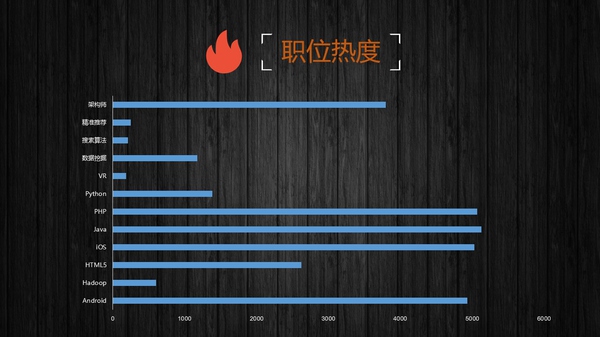

7、拉勾网、中华英才网等招聘网站

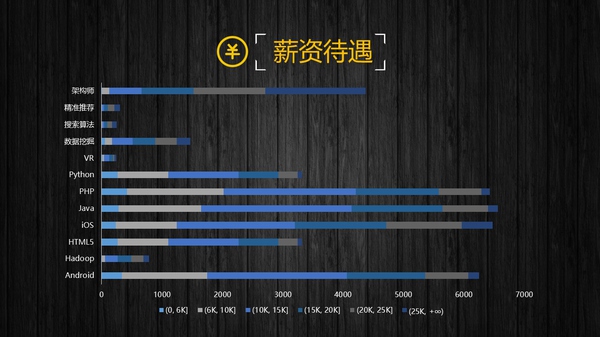

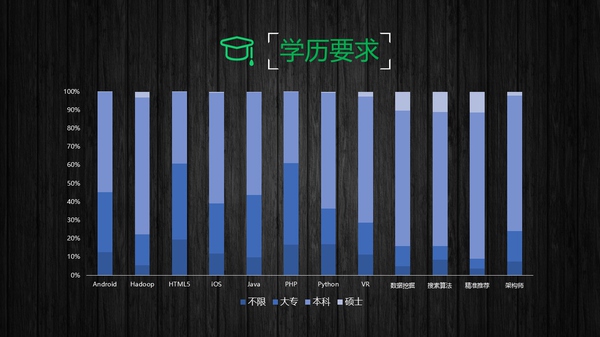

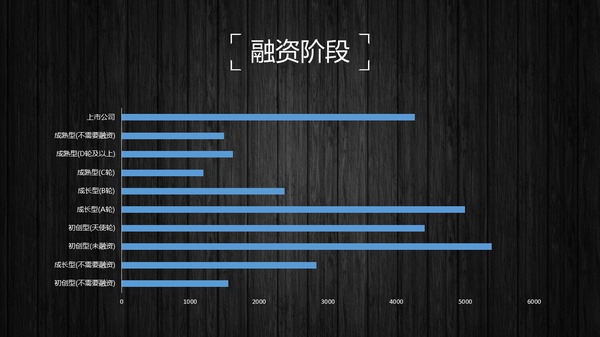

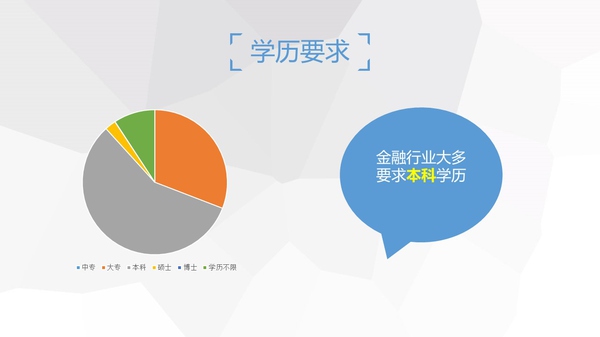

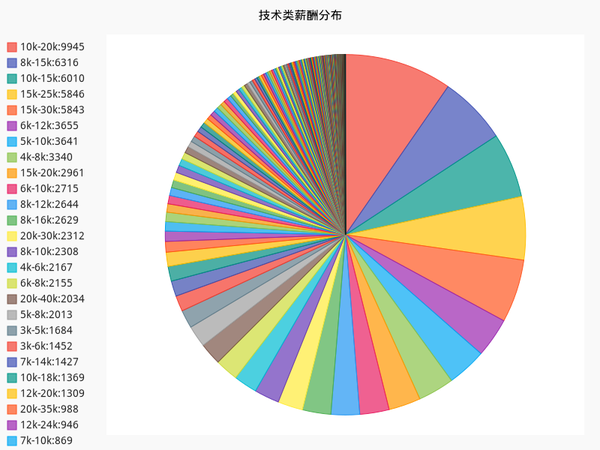

互联网行业哪个职位比较有前途? - 数据冰山 - 知乎专栏,抓取各类职位信息,分析最热门的职位以及薪水。

8、挂号网等医疗信息网站

如何评价挂号网? - 何明科的回答,抓取医生信息并于宏观情况进行交叉对比。

9、应用宝等App市场

你用 Python 做过什么有趣的数据挖掘/分析项目? - 何明科的回答,对各个App的发展情况进行跟踪及预测。(顺便吹一下牛,我们这个榜单很早就发现小红书App的快速增长趋势以及在年轻人中的极佳口碑)

10、携程、去哪儿及12306等交通出行类网站

你用 Python 做过什么有趣的数据挖掘/分析项目? - 何明科的回答,对航班及高铁等信息进行抓取,能从一个侧面反映经济是否正在走入下行通道。

11、雪球等财经类网站

抓取雪球KOL或者高回报用户的行为,找出推荐股票

12、58同城二手车、易车等汽车类网站

一年当中买车的最佳时间为何时? - 何明科的回答和什么品牌或者型号的二手车残值高?更保值?反之,什么类型的贬值较快? - 二手车,找出最佳的买车时间以及最保值的汽车。

13、神州租车、一嗨租车等租车类网站

抓取它们列举出来的租车信息,长期跟踪租车价格及数量等信息

14、各类信托网站

通过抓取信托的数据,了解信托项目的类型及规模

其实还有很多数据,不一一列举了。只要有爱数据的心和能爬的虫子,一切且有可能。顺利安利一下,抓取数据只是很小一部分,我们更擅长的是数据分析挖掘、可视化以及个性化的推荐。

————————————————————

更多文章关注我的专栏:数据冰山 - 知乎专栏

编辑于 2016-04-13

赵澈

给岁月以生命。

马伯庸

、

何明科

等

其实上个月就看到这个问题下有对知乎的数据分析,拿了好多赞。我虽然也想分享我们做的东西,但苦于原材料全是英文,style也比较严肃,调整起来比较烦。终于拖到现在,完成了整个内容的转述,并且加入了一些新的思考。

本项目的源起其实要感谢@苏莉安,当初就是因为看到他在专栏上发的两篇知乎数据分析的文章,觉得知乎非常有分析的价值,于是在一个Course Project里提出了这个题目。正如文中已提到的,这个小项目其实远远没达到令人满意的程度,挖得太浅,实际处理的数据量也很小,我其实是还想继续做下去的。如有任何问题敬请指正,如有知友想要在此基础上继续做点啥的也请让我知道。

本文的简书版链接:

知乎社交网络分析(上):基本统计

知乎社交网络分析(下):关注网络

———————————————————————————上篇-基本统计————————————————————————————

1.0 简介

本文源自我在2015年Social Computing课程中参与的一个小组项目,主要语言为Python。项目的原始材料为英文撰写,内容包括了从爬取知乎数据一直到结果分析的整个过程。在本文中我打算略去数据爬取和数据库I/O的部分,重点在分享一些有趣的结论。分析过程若有不周之处,还望指正。

为保证可读性,本文将分为上下两篇,一篇只涉及数据介绍及基本的统计分析,另一篇是基于用户关注网络和关注话题进行的分析。

如果对这个小项目的全貌感兴趣,甚至想要自己fork过来玩玩,这里是项目的Github传送门。数据的压缩包可以在这里下载(使用请注明来源为本答案页面)。(由于时间精力有限,想要做的远远比已经做了的多,数据量也很不让人满意,如果有童鞋感兴趣咱一起继续啊~)

1.1 数据

(自带吐槽模式开启)

虽说不讲数据爬取,但要说清楚我们所使用的数据到底是啥,还是得简单提一下的。2015年10月,我们使用了本人的知乎账号作为种子,先获得了所有我关注的用户的数据,再获得了这些用户所关注的用户的数据,所以算上种子的话一共是3层的广度遍历(注意其实这个数据可能是存在严重bias的,毕竟seed是一个逗逼,逗逼关注的人呢…咦怎么感觉脖子一凉)。这里的用户数据包括:用户的回答数,用户获得的赞同数、感谢数,用户关注的人和关注用户的人,用户回答过的问题以及每个问题的话题标签。这里给出数据的简要统计信息:

- 数据库文件: 688 MB(SQLite)

- 数据包含:2.6万名用户, 461万条关注连接, 72万个问题

这里是一张数据全貌的图示:

下面将着重介绍我们所做的分析。

1.2 玩的不是同一个知乎:均值、中位数与标准差

要告诉别人我们在知乎上混得怎样,最基础的几个指标是什么呢?一定是关注、回答、赞同、感谢。所以我们首先对用户的关注数(followee)、关注者数(follower,粉丝数)、回答数(answer)、收到赞同数(agree)和收到感谢数(thanks)的平均数、中位数以及标准差进行了计算,结果如下表:

这里其实就有许多有趣的结论了。

首先我们看平均值,哇,平均每个人有三千多粉丝,三千多赞同,再看看可怜的我,306个粉和837个赞,而且他们回答的问题也并不多啊,却有那么多赞和粉丝,还让不让人玩知乎了?再看看中位数,顿时心里好受一些了,原来我混得挺不错嘛,五个指标都是我比较大,真开心(你是不是傻)。

究竟是什么原因造成平均值和中位数差异这么大呢,也许我们能从标准差看出来一些端倪——太大了,粉丝数和赞同数的标准差甚至超过了两万。

这意味着什么呢?我们知道,标准差其实衡量了数据个体之间的离散程度,也可以解释为大部分的数值和其平均值之间的差异。因此这么大的标准差可以说明知乎用户之间的差距可能略大于整个银河系(雾),同时也说明绝大部分用户的数值和平均值有很大的差距,要么大得离谱(比如),要么小得可怜(比如我)。

有人可能会不服气,说标准差严重依赖于数据本身的scale,不能充分说明问题。那么这里使用标准离差率(标准差除以平均值)来算算赞同数,21951.4/3858.4 = 568.9%。我~就~问~你~服~不~服~

以上现象还可以导出一个猜测,那就是知乎用户的这五个指标的值分布,都不大可能是正态分布及其近似。让我们回想正态分布的样子:

(图片来源:https://zh.wikipedia.org/zh-cn/%E6%AD%A3%E6%80%81%E5%88%86%E5%B8%83…)

如果是正态分布,中位数(最中间的值)、众数(最多的值)以及平均值三者至少应该是非常接近的,然而我们这里却是地月距离(怎么一下缩水那么多)。

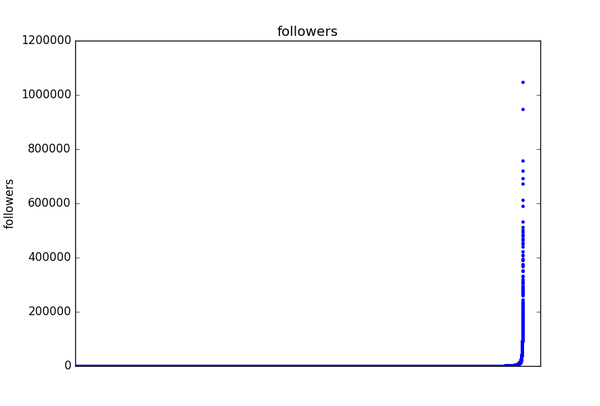

1.3 当雪球滚到最后:长尾和幂律分布

为了进一步验证1.2的猜测,我们绘制了五个指标的分布图(Distribution Graph)。

这里说明一下这五张分布图的含义,横轴表示指标的具体数值,纵轴表示有多少用户具有该指标值。需要注意的是横轴值和纵轴值都取了以10为底的log,这是研究中一种常见的处理办法,能够使图所表达的信息更清晰。以感谢数分布图为例,那个最左上方的点表示在这两万多知乎用户里面,有大于10的三次方也就是1000的人没有获得一个感谢(摸摸大);而最下面那一排点则是说,感谢数是x1,x2,…, xn (反正都不小)的用户,都只有一个人——注意仅这一排点并不能形成什么有效的结论,因为可能感谢数100的只有一个人,101的就有好多人了,这一定程度上大概是因为数据量小,采样不足。但是如果把下面几排点放到一起考虑,也许会更有启发一些。

顺便提一句,其实关注数和粉丝数的分布图分别还有另外一个名字,它们其实是知乎用户关注网络的出度(out-degree)分布图和入度(in-degree)分布图,这点在下篇中还会有所提到。

如果是对这种分布图比较熟悉的童鞋,应该一眼就能看出,这绝壁不是正态分布,而极有可能是幂律(power law)分布(不过因为懒我们并没有做拟合去验证),这种分布在许多有人参与其中的网络中都会出现。此外,仔细比较这五条曲线的整体形状,有没有觉得有两条与另外三条略有不同?一条是关注数,一条是答案数,这两条曲线向外的弯曲程度似乎更明显,也就是说随着横轴值的增大,纵轴值减小的趋势相对较慢,而恰好五个指标里只有这两个是某个用户自己可以控制的,而其他三个指标则是由其他用户形成的群体所控制,这是很奇妙的一点,我觉得其实还有深挖的可能性。

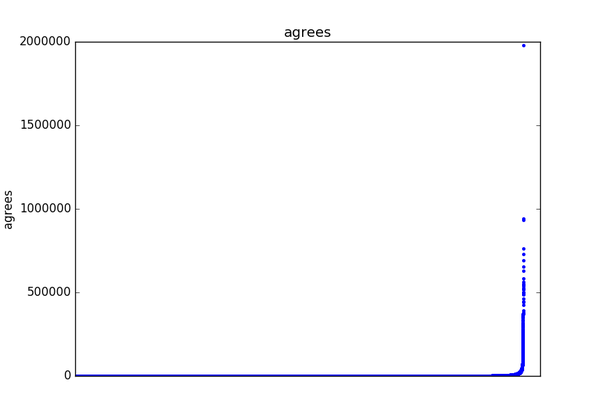

现在让我们以感谢数为例,再画另外一种分布图。横轴表示每个用户的index也就是0,1, 2, 3…,顺序由感谢数大小决定,纵轴则是该用户收到感谢数的具体数值:

看到那个突破天际的点了吗,二十七八万的感谢(其实这个点在前面那张感谢数分布图中也出现了,你还认得仅在几个自然段以外的它吗)!再看看下面那条长长的尾巴,人艰莫拆。再来看一个更夸张的,赞同数:

其他三个指标的图的形状也基本如此。

苏莉安曾使用远大于我们的数据量做了类似的分析,结论是一致的。总结一下就是:大多数人小得可怜,却有极少数人大得可怕,一点也不正(可)态(爱)。前几年不是有本书很火吗,叫做《长尾理论》?所谓长尾,指的就是这样一种现象(附送我对该现象的一些解释:什么是「长尾效应」 ? - 赵澈的回答)

到这里不由得让人提到另外一个东西:马太效应。所谓穷的人越来越穷,富的人越来越富,感觉上其实就是长尾效应的动态解释(最近打算看看有没有相关的文献)。富的人掌握大量资源,因此更可能攫取更多资源,而穷的人则相反;大V因为有名而得到更多关注,同时因此变得更加有名;玩游戏carry从而得到更多钱,有了钱买装备又更可能carry。这是典型的正(滚)反(雪)馈(球)。最后造成的结果,就是长尾现象。

1.4 论如何滚成人生赢家:赞同与关注

这一节可以算是对上一节结论的一个支撑。下面这张图同时包含了用户的赞同数和粉丝数两个指标:

(!密集恐惧症高能预警!)

我想不需要我们再做个回归什么的了,一看就是赤裸裸的正相关啊。这也为我等如何冷启动逆袭成为知乎大V提供了理论支持——要么你就有本事回答出几个赞数突破天际的答案,要么你一开始就很有名,没写啥答案也能吸粉…(说的都是屁话…)

———————————————————————————下篇-关注网络————————————————————————————-

2.0 社交网络是什么?

在上篇所述的基本的统计分析之后,我们已经对知乎用户的赞答谢关四个方面的总体情况有了一些了解。现在,让我们先来考虑这样一个问题:我们平常所说的社交网络或者说社会网络,到底是什么意思?也许你会讲,这还不简单,只要一个事情有多人参与,自然就会具有社交的性质,从而产生社交网络。那么让我们思考思考,维基百科算不算具有社交性质?

维基百科确实有很多人参与编辑词条啊,但是这些人之间有没有更直接的互动呢?假设编辑者们通过QQ、微博之类进行互动,那产生出的社交性质算不算是维基百科本身所具有的社交属性呢?即使维基百科提供评论区之类的功能,可以使编辑者之间直接互动,这些互动仍然是基于某个词条的,只要这个词条没什么大问题了,互动基本上也就随着编辑的停止而停止了。我认为这种临时建立起来的关系,并无法得到一个较为稳定的社交网络。

让我们再来思考一个例子。我们知道,一门科学源自跨越时代的许多人的共同贡献,那么这许多人,能够构成社交网络吗?当然不能。所谓牛顿和爱因斯坦的对话只是一种修辞,一篇已经发出的论文,如何能引用一篇未来的论文?但是当我们考虑到同一时代的同一学科,情况就有所不同,学者之间确实存在着各种交流合作的可能,因此我们可以认为学术领域的共同作者关系(Co-authorship)形成的网络其实是带有社交性质的。

从以上粗略的思考中我们或许可以总结形成社交网络的几个条件:多主体的直接互动、互动的长期性、互动的近同时性。

现在让我们重新回到知乎上面来。赞同、感谢、回答、关注,哪一种用户行为最满足以上三个条件?回答是基于问题的,知乎的产品设计并不突出是谁提出了某个问题,并且一个问题可以被不同的人进行编辑(类似维基百科的权限设计),也就是说回答者一般不大在意是谁提出了问题,所以回答连互动都称不上;赞同、感谢以及我们之前没有提到的评论,相对来说互动得稍微直接一点,但是鼠标一点了事,不具有长期性;只有关注关系,同时满足了三个条件。这里可能会有一个疑问,关注也只是鼠标那么一点,这能算长期的吗?不要忘记知乎的时间线(Timeline)机制,这使得关注者有更大的概率看到被关注者的活动并与之进行互动,并且只要关注不取消,这种对时间线的影响就是长期的。

到此,我们可以认为,如果想要对知乎从社交网络的角度上进行分析,首先就可以考虑知乎用户之间的关注关系。接下来开始介绍我们对此进行的具体分析。

2.1 分析对象和分析方法

首先来了解一些网络的基本知识:

一个网络可以被表示为一种图(graph),其中包含点(vertex / node)与边(edge / link)两种基本要素。边可以具有方向性,也就是说对于一个点来说,可以有外连边(out-link)和内连边(in-link)两种边。如果边是具有方向性的,那么这种图称为有向图(directed graph),反之称为无向图(undirected graph)。图反映了点与点之间的某种相关关系,这种关系由边表现。

回到知乎上,我们知道关注和被关注实际上是一件事情的两个角度。A关注了B,等价于B被A关注。在我们所爬取的数据中(见1.1中的数据全貌图),我们知道这2.6万用户中的每个人都关注了哪些人。也就是说,我们知道了2.6万用户点的所有外连边。从另一个角度想,我们其实也知道在这2.6万用户之间谁关注了谁(蓝圈以内的部分),加上他们关注了其他什么人(蓝圈以外的部分)。因此我们只能分析这2.6万用户(红色实心圆),因为我们并不知道其他的人(红色空心圆)的所有连接,这是由我们的广度优先爬取机制所导致的,不爬完知乎整站,不会有真正完整的数据(那些没人关注的账号应该可以忽略)。

此外,即使剔除了蓝圈以外的部分,涉及的连边数仍然具有很大的量级,计算量会是一个问题,所以在这个项目中,我们仅仅选取了这2.6万用户的两个有趣的子集进行分析:获得赞同数大于1万的用户(共1895人)、获得赞同数大于5万的用户(共375人)。方便起见,我们将他们分别命名为Net10k和Net50k,其实可以说就是两个不同级别的知乎大V群体了。

接下来讲讲分析方法。一个网络图,别看里面只有点和边两种东西,其实可以包含复杂到极点的各种现象与性质。网络分析,或者进一步说复杂网络领域之中,存在大量人们为了描述网络的现象而定义的概念、以及为了量化网络的特征而设计的指标。后文将要涉及的分析建立在其中最基本的一些概念和指标上,如果对它们逐个详细介绍,那么本文篇幅会大大加长,而且会多出不少数学公式,这不符合我对本文的写作预期。因此我打算尽量从直觉(intuition)上来解释它们分别表达了什么的含义,即使给出定义也不求严格(数学公式才可带来最清晰严格的定义),重点仍在对分析的思考。此外,由于我们所讨论的知乎关注网络是有向图,后面所有的指标和算法都只讨论有向图的。当然,如果读者已有一定的基础,可以直接跳过相关的段落。

2.2 抱团的大V们:网络总体特征

一直以来知乎就给人一种印象,那就是大V们喜欢抱团。你关注我、我关注他、他又关注你,形成了紧密的圈子。那么我们怎样来量化这种特征?

假设有A、B、C三个用户组成的关注网络,其中唯一的边是A->B,那么你觉得这个网络是否紧密?我们可以这样想,三个人之间最多可以有6条边,那么我们可以用1除以6来表示这个网络的紧密程度。如果6条边都存在,那么紧密程度是1,都不存在则为0。这就是所谓图的密度(density)。Net10k和Net50k的密度分别是0.064和0.195,到这我们可以猜测,获得赞同更多的大V之间,关注关系也更为紧密。

接下来我们从另一个角度考虑这个猜测,先补充几个定义:

- 点的度(degree):与一个点通过边相连的其他点的数量和,被称为这个点的度。有向图中一个点存在出度和入度两个度,一个只看它能到达哪个点,一个只看哪些点能到达它。对于知乎的关注关系而言,我们很容易就能看到出度就是你关注的人数,入度就是关注你的人数;

- 点与点之间的路径(path):假如从点A出发,经过一条或更多条边,到达了点B,那么我们称这些边按顺序相连形成了一条A与B之间的路径。两点间的路径数量一定是大于等于0的。假设每条边的长度相等,那么包含边数最少的路径,便是所谓最短路径(shortest path),最短路径的长度一般被认为是两点之间的距离(distance);

- 图的平均最短路径长度(average shortest path length):对于一个网络而言,将所有点两两之间的最短路径长度进行算术平均,得到的就是所谓平均最短路径,可以用来衡量网络中点之间的平均距离。传说中的六度分隔(Six Degree Seperation),其实指的就是一个网络的平均最短路径长度为6(这里大家可以想想边、度和路径三者间的联系);

- 点的偏心率(eccentricity):对于图中的任意一点P,算出它与其他各个点的最短路径长度(距离),其中最大的距离称作点P的偏心率。

- 图的半径(radius)与直径(diameter):图的半径、直径分别是图中最小的、最大的点偏心率。注意图的直径不必然是半径的两倍。

- 图的强连通子图(strongly connected subgraph):设想一个网络图G的一个子图G’(意味着G’中的点和边都只能从G中挑),其中每一个点都能通过某条路径到达另一个点,则我们说G’具备强连通性,而且是G的一个强连通子图。这里注意,单独一个点我们也认为是强连通子图,虽然单个点并没有值得研究的;

- 图的强连通分量(strongly connected component):G的一个极大的强连通子图G’’(意味着再往G’’加任何G中剩下的点,都会破坏其强连通性)被称为G的一个强连通分量。这里需要注意,极大并不代表很大;

字好多看烦了吧,终于可以上图啦,下面分别是Net10k和Net50k的强连通分量示意图:

其中每一个红色圆圈都代表一个强连通分量,每条线(其实是很抽象的箭头orz)代表一条路径。光看这个我们还不清楚情况,我们来看二者对应的一些指标数据:

总结一下我们知道了什么:

- 基本上Net10k和Net50k这两个图就是强连通的,别说抱团了,这已经根本就是挤成一坨(好吧,一个圈子)。

- 除了一个巨大的圈子,群体里就剩几个特立独行的高冷大V(都是只包含一个点的强连通分量),他们受到了其他大V的关注,但却没有任何回粉。在网络中,这种点也被称为悬挂点(dangling nodes);

现在我们重点分析两个最大的强连通分量,连通倒是连通,但是如果A要经过100个人才能到B,那估计光凭关注关系,他们是没有缘分了。将Net10k和Net50k的最大强连通分量分别命名为Net10k-C和Net50k-C,以下是两者对应的指标数据:

如果你就是Net50k-C中的一个大V,还不认识其中的另一个大V?没关系,你关注的关注的关注…总会有他,所以你们总有机会看到彼此。强连通保证了总会有一条路径,平均最短路径向你保证平均来讲这条路径很短,只有2左右。直径和半径则告诉你在最坏情况下(你们碰巧是整个圈子里相距最远的两位),这条面基道路的长度在2到5(4)之间。What a small world,喜鹊们(雾)如是说。

再来对比Net10k-C和Net50k-C的平均最短路径长度和直径,后者都比前者要小,从另一个角度说明后者的关注圈子更紧密。而且注意一点,这些大V是来自各个不同的专业领域,但都紧抱在一起,这也是很有趣的现象,有进一步分析的价值。

2.3 给大V排个位:网络连接分析

上节侧重于对知乎大V关注网络的整体进行分析,这固然很有趣;但或许更有趣的是这个整体之中的每个个体,同样是赞同数很高的大V,他们彼此之间是否能一较高下呢?他们在关注这种社交行为上是否具有差异,如何衡量这种差异?这是本节涉及的问题。

让我们先来设想一个简单的关注网络,其中只有A、B、C三个人。A关注了B,B关注了A,A、B同时关注了C,而C谁也不关注,如下图所示:

那么你觉得光凭关注关系来看,A,B,C谁更“牛”?从直觉上来说当然是C,因为C在三人之中得到了最多的关注。但是否只要粉丝更多就能说明更“牛”呢?下面我们在这个网络的基础上,来考虑几种很有趣的情况:

- 多了10个自己粉丝数为0的用户,同时关注A

- 多了10个用户,他们彼此全部互相关注,除此之外都没有其他粉丝

- 多了10个自己粉丝数为1的用户,同时关注A,并且每个人还分别关注了10000个其他用户

那我们能说1里的A,或者2里的10个用户比C更牛吗?前两种情况明显不合道理,可以说是较为典型的作弊行为。作弊利用了单纯粉丝数排序的漏洞:没有考虑到每个关注连接的质量差异。第三种情况算是一种正常现象,但是你会觉得,这些用户一个是只有1个粉丝,几乎等于0,另一个是他们关注了那么多用户,那么他们关注A,真是因为A很重要吗?

既然发现了漏洞,那么假如不考虑赞同数等其他因素,我们是否有可能通过关注网络本身来予以解决呢?从直觉上来说,我们可以想到的是,用粉丝自己的粉丝的质量来衡量这个粉丝的质量,但粉丝的粉丝的质量又需要粉丝的粉丝的粉丝的质量来衡量…那么到底最后是个什么情况?到这里我们看到了日常语言结构所能承载的思维深度之浅薄,当一个问题到达这个复杂度,语言已然苍白无力,不得不将它托付给数学。

PageRank算法(其与Google的关系我就不赘述了)就是一个数学上非常优美的答案,不仅考虑到前述的连接质量问题,还解决了所有特殊情况——无论关注网络是什么样子的,都保证能得到一个满意的用户重要程度排序。

下面是我们对Net10k和Net50k分别计算PageRank值,注意这里只考虑大V们内部的连接,此外圈子里所有大V的PageRank值相加等于1。最后得到排名前五的知乎大V用户如下:

这些便是站在知乎大V巅峰的大V们了,是否觉得有一定道理呢?注意比较Net10k和Net50k前五用户的PageRank值,前者比后者小,这主要是因为总和为1的PageRank资源被更多的大V们分掉了。

下面让我们再考虑一点,所谓的“重要”,其实要看我们的目的是什么。假如我们是要看更多的好答案或者想要找人出书约稿,那么直接找到好答案的答主就好,而这些答主往往吸引了最多的关注,所以我们仅仅需要知道谁受到的关注最强(比如下图中的C)。

但是光是通过关注,我们会漏掉那些暂时没有得到太强关注的好答主(可能是刚刚加入知乎的大V潜力股),然而我们又不可能自己去一个一个挖掘这些好答主,如何是好?简单,假如你能找到几个类似牵线人的用户(比如下图中的D)你相信只要是他们关注的用户,质量都不会差,都合你口味,事情就简单了。你只需要不时看看他们都关注了谁,就能发现更大的世界。这其实也算是一种用户推荐系统的可行思路,这里就不展开了。

HITS算法便能做到只使用关注网络,通过权威度(Authority)和枢纽度(Hub)为我们分别挑出好的答主,和好的牵线人。

上面的基于直觉的分析是否说得通呢?让我们看看Net10k和Net50k的权威度和枢纽度前五名:

Auth(好答主)方面,我相信大家应该能认同这样的结果名单。值得一提的是在两个大V群体之中,@张佳玮(顺便提一下,张佳玮张公子就是上篇中那个在各条曲线中高高在上的闪亮极点)和@梁边妖调换了位置,很有趣。另外在Net50k中,@采铜 老师一跃进入前五,@马伯庸 马亲王(祥瑞御免)上升一名,黄继新则掉了出去。这些现象或许反映了不同大V群体的一种喜好倾向的差异。

Hub(牵线人)方面,说实话我个人只认识@徐湘楠一个人,其中还有一位目前处于账号停用状态,这里便不做过多分析。只有一点比较有趣,作为大V,粉丝数很大很正常,然而这些用户关注的人数也算是很多的,好几个甚至达到了几千,不可不谓之具有某种交际花属性。另外提一下,Net10k Hub的第五名,叫干脆面的用户,我已经无法知道是谁了,原来的用户ID是wang-wang-wang-08-18,现在改掉了,总觉得跟徐湘楠(ID:miaomiaomiao)之间存在着某种联系…

综合来看,HITS和PageRank有不少相同的用户入榜,这是为什么呢?我给一个直觉上我认为对的解释,其实PageRank的值是Hub值和Authority值的一种叠加(其实感觉更像是乘的关系)后的结果,这样Hub或Auth中的一种很强,另一种也不弱时,PageRank便相应比较高,这样两种算法得到部分相同的结果便很正常了。@黄继新是一个典型的例子,他的Auth值和Hub值在Net10k和Net50k中虽然都不是最高,但都排到前20名,而他的PageRank则是第一。既有内容,又能充当渠道。

2.4 不均衡中的均衡:Closeness和Betweenness中心度

到此先让我们总结一下,如果要衡量一个用户在关注网络中的“重要程度”,我们可以利用这几种指标:

- 该用户的粉丝数,即入度(In-degree)

- 该用户的PageRank值

- 该用户的HITS值

它们在网络分析中也可被归为同一类指标:点的中心度(Centrality)。但我们发现,其实三种指标所表达的“重要”,其含义是不完全一样的,同一个网络,同一个节点,可能不同的中心度排名会有不小的差距。接下来请允许我介绍本项目中涉及到的最后两种点的中心度:

- 点的近性中心度(Closeness Centrality):一个点的近性中心度较高,说明该点到网络中其他各点的距离总体来说较近,反之则较远。假如一个物流仓库网络需要选某个仓库作为核心中转站,需要它到其他仓库的距离总体来说最近,那么一种方法就是找到近性中心度最高的那个仓库。

- 点的介性中心度(Betweenness Centrality):一个点的介性中心度较高,说明其他点之间的最短路径很多甚至全部都必须经过它中转。假如这个点消失了,那么其他点之间的交流会变得困难,甚至可能断开(因为原来的最短路径断开了)。因此假如要hack一个网络的话,对哪个结点下手你懂的。从另一个角度想,这些点简直就像是等在丝绸之路上必经关口的强盗。不留下买路钱?让你无路可走,生意就别做了。

这两种中心度我目前并未找到很公认的中文翻译,姑且自己翻译了。另外同PageRank和HITS一样,由于指标的计算稍显复杂,这里就不详细叙述了。但是我们都使用的是网络分析库Networkx中的算法实现,对详细算法有兴趣的读者可自行查阅其文档。

本项目中我们分别计算了Net10k和Net10k的近性中心度和介性中心度,并画出了分布图。由于我们当时考虑欠周,算出的近性中心度是基于外连接而不是内连接的,我认为意义不大(你总是可以让自己关注更多人,从而得到更大的近性中心度),所以本文决定略过。下面主要说一下介性中心度,其于Net10k和Net50k的分布图分别如下:

我们又得到了两条长长的尾巴。图中横坐标表示每一个特定的大V,纵坐标是大V相应的介性中心度。长长的尾巴表明大部分大V的介性中心度接近0,即使长尾以外有少数几个人远超其他人,但介性中心度的值依然很小。这说明什么?说明这些大V即使退出知乎,也几乎不会影响其他大V之间建立关注关系。没了你,我还有许多其他最短路径到达另外一个大V。这进一步说明什么?说明大V的关注网络是如此健壮,健壮到即使失去许多结点,对整个圈子的连通几乎毫无影响。

再横向比较一下Net50k和Net10k,可以看到这种随着圈子增大,幂律变得更强,除了少数点,大部分的人介性中心度都更趋近于0,人数的增加进一步稀释了大多数人的“独特性”,直觉上我相信继续扩大这个圈子,到Net5k、Net1k甚至知乎全体用户,这种健壮性只会越来越强,虽然人与人相比存在指数级的差异,但对整个网络本身而言,每个人几乎同等重要,也同等不重要。这或许可以称之为知乎关注网络所具有的一种不均衡中的均衡吧。

2.5 大V都在关注什么:热门话题分析

最后,我们尝试了一种获得知乎上热门话题的办法(本项目中唯一涉及内容的分析),先取得Net10k和Net50k的支配集(Dominant set,这里由于我认为实际上不用这个子集结果也不会有显著区别,所以就不解释这个概念了),然后统计集合中所有用户的回答所对应的问题标签,最后对各个话题标签按出现次数排序。以下分别是二者的前20名:

Top 20 from Net10k:

调查类问题 3792, 生活 3096, 历史 1713, 恋爱 1464, 心理学 1432

电影 1419, 人际交往 1404, 社会 1332, 互联网 1214, 情感 1197

政治 1028, 两性关系 994, 教育 897, 中国 823, 人生 815

游戏 805, 文学 772, 知乎 772, 法律 750, 音乐 738

爱情 699, 文化 659,创业 628, 大学 621, 程序员 619

心理 617, 你如何评价 X 609, 女性 604, 编程 585, X 是种怎样的体验 582

Top 20 from Net50k:

生活 1435, 调查类问题 1365, 政治 1285, 历史 1204, 电影 1084

健康 996, 社会 984, 医学 941, 恋爱 717, 中国 695

两性关系 688, 英语 678, 人际交往 640, 心理学 634, 互联网 595

法律 587, 微软(Microsoft) 555, 美国 552, 健身 538, 编程 511

我个人认为大V们回答的问题所对应的话题,能够从一定程度上反映了知乎这个平台总体的话题领域热门程度。另外,我觉得排在最前的一些热门话题也在一定程度上解释了为什么不同领域的大V会抱团,因为不论处于什么专业领域,人们对于生活、历史、电影等人文和泛娱乐话题总是会感兴趣的,一旦都感兴趣,又都有不错的见解和分享,自然更容易惺惺相惜。

到此,本文终于可以画上句号了,欢迎交流、讨论与点赞(最后一个才是你发自内心的呐喊吧喂)。在此还要感谢和我一起参与本项目的其他三个小伙伴,四个人一起才得以在短短时间内做到这种程度(项目report里有我们的详细分工)。感谢@egrcc的zhihu-python,帮我们省去了一部分爬虫编写的时间。

最后再重复一遍,如果有想要和我一起,在这些工作的基础上继续做一些有趣的分析的童鞋,请一定联系我!

编辑于 2016-05-14

秦渊

专栏 https://zhuanlan.zhihu.com/crawler…

野合菌

等

========== 2016-04-22 更新 ==========

补几张长尾图。

粉丝数:

赞同数:

感谢数:

回答数:

知道这是谁的知乎了吧╰( ̄▽ ̄)╭

========== 以下为原答案 ==========

最近在抓知乎的数据,就简单来分析一下吧。

抓取了知乎24W+的用户详细信息,以及他们之间的关注关系204W+(没抓完)。

数据量不算大,但是,这些样本用户应该算是比较高质量的用户了。(此处质量指的是活跃度,关注度等指标,而非道德层面上的质量)。

之所以这么说,还是有些依据的,看下面分析:

可以看到:

- 回答数大于100的用户有16429个

- 回答数大于1,000的用户有549个

- 回答数大于5,000的用户有17个

- 赞同数大于5,000的用户有8099个

- 赞同数大于10,000的用户有4163个

- 赞同数大于50,000的用户有632个

- 赞同数大于100,000的用户有252个

- 关注数大于1,000的用户有10757个

- 关注数大于5,000的用户有3278个

- 关注数大于10,000的用户有1888个

整个数据抓取的过程是,以 @芈十四为种子用户,依次抓取各用户关注的人信息(是用户所关注的人,而不是用户的粉丝)。因为许多大V动辄十数万粉丝,然而这些粉丝大多是不活跃用户,对最终数据分析的意义不大。

下面进入一个分析的过程。可以进行许多维度的分析。例如:

性别分布:

地域分布:

学校分布:

专业分布:

公司分布:

由于数据没有做后期的处理,因此上面的统计只能体现一个大概的分布。比如地域分布中,帝都和北京,魔都和上海,其实是一个地方;学校分布中,五道口,五角场之类的叫法也没有与其所代表的学校合并统计。

然后,我比较感兴趣的是那些只关注了一个人的用户。统计如下:

可以看到,在这24W+的样本用户中:

- 只关注了一个人的有6205个

- 只关注了一个人,且粉丝数大于100的,有699个

- 只关注了一个人,且粉丝数大于1,000的,有161个

- 只关注了一个人,且粉丝数大于5,000的,有46个

- 只关注了一个人,且粉丝数大于10,000的,有26个

通常来说,一个用户如果只关注了一个人,那么很有可能这个人对他来说有着非比寻常的意义。但是要考虑到有些用户是新用户或者不活跃用户,那么他可能只是懒得关注人。所以,接下来的分析,选取只关注了一个人,且粉丝数大于1000的用户,一共161个。

那么,被这161个人所关注的人,是不是也只关注了一个人,并且他们两个人之间是互相关注的呢?对这161个用户进行分析,筛选出符合以下条件的用户组:

- 两个人之间互相关注,且都是只关注了对方一个人

- 其中至少一个人在这161个用户样本中

一共筛选出以下10组用户。姑且称之为“完美默契用户”(或者“完美情侣”?抱歉我暂时没想到更好的词o(╯□╰)o):

- @Jo Jo 和 @Peng Bo

- @天璇真人 和 @天枢真人

- @野合菌 和 @野合菌的女朋友

- @Zongyuan Wang 和 @siyu

- @Arthur C 和 @Mingke Luo

- @暴脾气的李淑女 和 @苏破蛮

- @薇薇安 和 @Vivianstyle123

- @郑亚旗 和 @NinaRicciJj

- @崔冕 和 @RobinChia

- @CIH Hacker 和 @Joseph Ku

最后,你们都是彼此的唯一,祝福你们O(∩_∩)O~

——————————

鉴于有人反映太虐狗,就再加上个公益项目。在这24W+个样本用户中,查询那些关注了500+然而自己却只有一个粉丝的用户(由于我的抓取策略,粉丝数为0的用户不会被我抓取到):

(由于数据是前几天抓取的,可能与最新的数据有少许出入,但是影响不大。)

他们分别是(知乎的@ 太难用,有些就不@ 了,直接放个人主页):

- @关山月

- @鸡莫洛托夫

- @莫筱木

- 小聪

- @hill1357

- @你说

- @梅西小贝

- qiyuan zhu

- 啊啦啦

- 李梦

- 难得做梦

我想他们一定很孤独,请大家多多关注他们,给他们温暖。谢谢~

——————————

鉴于评论里有求源码的,是用Node.js写的,爬虫基于GitHub - syaning/zhihu-api: Unofficial API for zhihu

上面的项目对获取知乎数据的过程进行了封装,但是只提供了基础的数据接口,因此如果你要构建爬虫的话,需要在此基础上实现自己的抓取逻辑。

至于我自己的爬虫代码,因为时间仓促,写的比较烂,稳定性什么的都有待完善,就不拿出来丢人现眼了。

=============== 2016-04-07 17:00更新 ===============

如果是对上面提到的那些指标进行可视化,无非是一些柱状图、条形图、饼图等,没什么意思。下面是对用户网络的可视化,使用Gephi来分析的。

首选选取粉丝数大于10,000的用户,一共1,888个用户,关注关系182,284条(可能不完整)。

很丑吧o(╯□╰)o 可以看到周围的点和线。中间黑乎乎的一大片,其实是密密麻麻的点和线,还在动态调整位置。这已经是我等了好久之后的布局。

然后选择粉丝数大于1,000的用户,一共10,757个,关注关系713,855条(只是抓取到的部分关注关系,还有很大一部分没有抓取到)。

这已经是我等了好久好久,电脑都能煎蛋之后的布局了,中间的点和线还在动态调整位置。我已经不想等了。刚开始的时候特么的就是个黑乎乎的球啊(抱歉我没有设置颜色参数)!

那么,这24W用户样本的整体网络结构是什么样的呢?别问我,我也不想知道,电脑已经卡死了/(ㄒoㄒ)/

PS:Gephi新手,自己瞎搞的。如果有熟悉Gephi的,欢迎指教~

编辑于 2016-04-22

最爱麦丽素

不忘初心~充实就好~

何明科

等

有时候有了数据就想分析一下,跟大家分享一下我的实验。

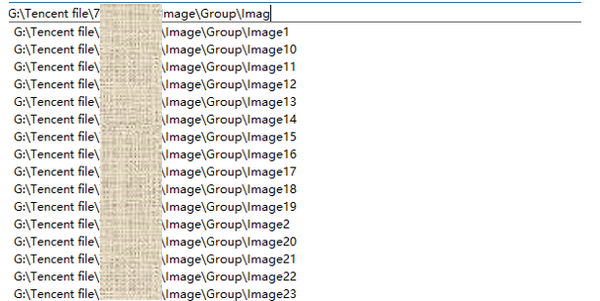

这是我去年十一回来遍开始计划的实验,重装系统之后将QQ存储文件的文件夹放到了我的备份盘里, QQ会把你的聊天记录和图片分开存储,而且群组和好友也是分开存放在两个文件夹里的,好友G:\Tencent file\

随着图片越来越多,QQ会把近期缓存的图片整理到一个新的文件夹里去,每到4000张图的时候就整理一次。我加了90多个QQ群,一半以上是千人群,6个月之后我的文件夹就变成了这个样子。

缓存了将近7个G的图片,一共十万五千张。

这次不讨论聚合和图片分类的问题,我们简单的统计一下直接从图片文件所携带的信息。这些图片一共有三种主要的格式, JPEG,PNG,GIF,通常就是,照片,截图,表情包

比例如下:

除了简单的类型统计呢,我们还可以根据图片的创建时间来统计信息,当然在登录QQ的一开始,也会因为大量的接受图片而导致一个时间序列上图片数量出现极值。

时间序列尺度在周,分钟,和天的变化情况就显而易见了。

哦,周末人们在网上竟然比平时少活跃了一半,可能是活跃的人少了,也可能是活跃的时间少了,但是我认为,大家在家睡到12点的可能性更大一点,谁叫我加的都是工科群,23333.

在看每天的数据,天哪,竟然到了1点多才算全睡觉,本宝宝突然觉得好心塞,这个行业是怎么了。然后第二天6点多陆续起床,12点又开始去吃饭去了。等等等等,图上都显示的清清楚楚。

再看一年中的数据,唔~,好像周期性很强烈, 一到周末大家就睡觉了嘛?哎,二月五号左右我们在干吗?怎么那么低?原来是在过年,大家都在家里浪着呢。怎么有两天是0?好吧,我在往返的火车上,好心塞。

等等,如果PNG代表截图,那可能表示大家在讨论问题。如果GIF多一些,可能表示大家在斗图水群啊!我好像找到了你们不工作偷懒的秘密!让我们来分别看一下三种图片的动态变化。

看到了吧,过年的时候大家拍了好多照片分享到群里!

那么周的呢?

左侧是总数,右侧是百分比,大家在周末,更少讨论工作,也很少斗图,竟然都出去玩拍照片去了!让我很是诧异,只有我一个人会自然醒么?

对了我们还有图片的宽高信息:

加了对数之后的分布情况,呃,貌似看不出什么,那直接用散点吧

几点线若隐若现的样子,连起来看看好了

这下知道那些线是什么了,是手机屏幕大小和电脑屏幕大小。斜线就是屏幕的长宽比啦。也很容易看出那些屏幕占了市场的主流。那1:1的?有这种屏幕??应该是截图的时候截的图长宽比在1左右浮动吧,看到条线也是最粗的。

顺便看了一下那些图是最常用的。腾讯为了减少图片在网络流上的浪费,对于md5一样的图片,他们在聊天记录里的名字是一样的!值得一提的是,一张gif动图的第一帧如果和某个静态的jpge图片一样的话,那么他们的名字也是一样的,基于这个原理,统计了一下29个文件夹下出现次数最多的图片前三名,竟然是这个:

果然还是表情包,最容易反应大家当时的心情么23333,帧数最多的是~,你们是有多无聊。

贪吃蛇

对了,本宝宝滤了一套表情包出来,哈哈哈

好了,就这样,这次不讨论过多的模式识别和监督学习之类的东西,希望大家也能在想不到的地方得到想不到的结果,希望能对各位有所启发。看完后希望你们也能给个这样的表情。

再分享一篇之前的建模

假如现代的 1 万人穿越到智人时代,大约多久能重建现代文明? - 最爱麦丽素的回答

欢迎各类奇葩怪咖加微信FavorMylikes,嘻

编辑于 2016-09-20

LucasX

技术/设计/读书/摄影/杰伦粉

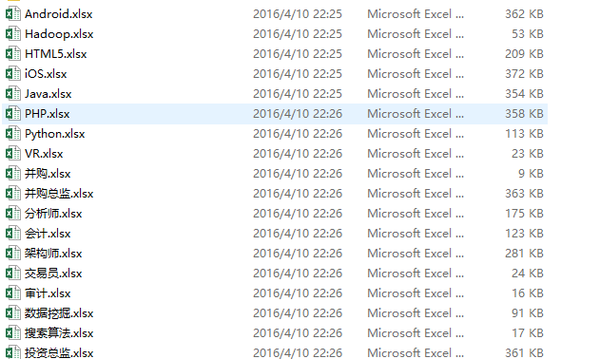

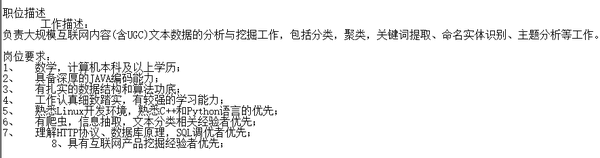

前阵子在自学Python,可是平常用不到的话语法什么的就好容易忘啊,一个劲的print又没多大成就感,于是了解了requests、bs4、openpyxl…这些python库,对拉勾网上面的职位信息进行爬取。

这是部分感兴趣的职位…..

//更新说明:parameter为传参,此处仅获取了自己比较感兴趣的部分职位信息,若有需要其他职业数据,可自行抓包分析(kd的值),添加到该xml文件中,源代码已分享,见答案末尾。

这是爬下来的数据…

这是生成的Excel…

前方是数据分析报告,多图预警!!

————————————————————————————-start————————————————————————————-

https://www.zhihu.com/people/xu-lu-47-52… (二维码自动识别)

————————————————————————————-end————————————————————————————-

—————————————————————————- 职位印象 ———————————————————————————-

对于每一个职位而言,如何能迅速了解其背景呢?

这就是在V1.3版本中加入的 职位印象 功能了…

简单来说呢,就是在抓取每一个职位职位数据,对其进行一系列的分析,分词、统计词频,生成排名前20的热度词…

这是拉勾网的职位要求…

下面以[数据挖掘]岗位为例进行试验…

[这是抓取的所有详情页数据]

[这是分析结果]

[职位印象]

数据挖掘:

果断地,在综合了所有“数据挖掘”岗位招聘要求数据之后,经过分析,数据挖掘算法、海量、模型、建模、数据等是常被提及的热度词。

推荐系统:

作为算法岗,数据、算法、数据挖掘、个性化理所应当是热门词汇。

Android:

移动开发则更偏向经验、架构、项目、设计模式。

其他的分析就不一一赘述了,分析过程类似,详情见github。 ^^

评论中有小伙伴要源代码的,在此分享出来,没有系统学习过python,代码组织什么的可能不太好,了解下实现流程就好啦。

[PPT分析报告原文件下载]

微云文件

微云在线预览格式被打乱,请下载后阅读!

[希望热爱技术与设计的小伙伴多多交流哈 o^^o]

[这是github地址]

GitHub - EclipseXuLu/LagouJob

注:感谢大家的关注,这份代码是当时刚学习Python的时候写的,代码组织都还很乱。BTW,目前,由于拉勾网后台API发生了变动,所以代码可能无法正常运行。硕士期间比较忙,一直也没能继续更新,有空的话会重写release 2.0版本的。

如果想学习爬虫、数据分析相关的东西,可以参考下我的另一篇文章:

世纪佳缘用户画像-Part1 - 知乎专栏

编辑于 2017-03-04

林骏翔

忙于追求更好的人生。

2015.11.14

更新神器:

1.下面提到的Quandl网站有一个他们自己的Python库,叫Quandl,可惜也是收费的。

pip install Quandl

2.TuShare -财经数据接口包 国内好心人做的开源财经数据接口(觉得好的可以捐助一下)。这里几乎可以获取到A股的所有信息了,还包括一些经济数据。重点是他不仅免费,还提供了一个Python库tushare。

pip install tushare

import tushare as ts

这样一来你便可以通过这个库方便地获取大量A股信息了。

——————————————以下为原答案——————————————

一大波数据来袭!

题主问了有什么网站,能用来做什么。我给出几个API网站吧,做APP用的可能比较多,不过也可以用在日常生活中。

一、生活服务

1.手机话费充值。手机话费充值数据服务

2.天气查询。天气查询数据服务

3.快递查询。快递查询服务数据服务

4.健康食谱。健康食谱数据服务

5.查医院。医院大全数据服务

6.水电煤缴费。水电煤缴费数据服务

7.电影大全。电影大全数据服务

8.谜语、歇后语、脑筋急转弯。猜一猜数据服务

9.音乐搜索。音乐搜索接口数据服务

10.健康知识。健康知识数据服务

11.百度糯米、团购等信息。糯米开放api数据服务

12.彩票开奖。彩票开奖查询数据服务

以上接口都来自网站:

APIX_国内领先的云数据服务平台_API接口服务平台

细心 的人会发现,这些功能简直是遍地都是啊,支付宝、微信什么的一大堆,哪用那么麻烦!

是的,但我相信这些可能为一些不太了解相关信息的人提供了帮助。不过,虽然这些功能很多APP都有,如果自己有空闲时间又懂得编程,不喜欢别人的UI设计,自己做一做也是挺好玩的。比如:

生活枯燥了,把这些谜语歇后语等根据个人喜好定时推送到自己的手机,放松身心;

把一些健康小知识在空闲时间推送给自己,提醒自己;

……

国内类似的网站还有:

API数据接口_开发者数据定制

API Store_为开发者提供最全面的API服务

API数据接口_免费数据调用-91查|91cha.com

除此之外还有一些门户网站提供了一些API接口,比如豆瓣、新浪、百度等等。

二、金融数据

1.股票

①新浪财经

最多人用的就是新浪财经了,因为它是免费的,并且使用起来也不难。以下是网上找的教程:

获取历史和实时股票数据接口

②东方财富网

网站提供了大量信息,也是基本面投资者的好去处。可以查看财务指标或者根据财务指标选股(如净资产收益率):选股器 _ 数据中心。这些都是很好的投资参考,当然还有其它功能有对应的API,可以自己分析一下。

③中财网

http://data.cfi.cn/cfidata.aspx…提供各种产品的数据

(国内很多功能类似网站,如和讯、网易财经、雪球等等,具体的我没有一一试验就不放上来了,各位可以自己去试试,下同。)

2.大宗商品

①黄金头条——用资讯帮你赚钱!炒黄金,看黄金头条!黄金价格

这里提供了各种大宗商品的行情,也可以分析获取。包括技术分析方面。

②当然还有外国网站:Investing.com

3.美股等综合类(其实新浪财经和东方财富等也算是国内综合的了,就不一一列举了)

①Wind资讯。很多机构用的都是这里的数据,当然普通个人是拿不到的,不过如果你是财经院校的学生,他们会提供免费的数据。详见官网。

②Market Data Feed and API

外国网站,提供了大量数据,付费。有试用期。

③Quandl Financial and Economic Data

同上。部分免费。

④96 Stocks APIs: Bloomberg, NASDAQ and E*TRADE

外国网站整合的96个股票API合集,可以看看。

⑤雅虎财经

http://www.finance.yahoo.com/

https://hk.finance.yahoo.com/

香港版

三、其它

撇去上面的API不说,如果单单爬取网页上的内容下来,那就太多可以爬的了。如:

1.爬取网站上的图片。包括贴吧、知乎、Tumblr、轮子哥、XXX(你懂的)。

2.爬取影评、电影资讯、图书等等。比如豆瓣电影。轻轻松松掌握好书好电影。

3.爬取社交网络。比如新浪微博,Twitter。(Twitter提供了API,可以提交关键字等信息爬取搜索结果中的每一条内容。)爬完可以对整个社交网络群体做个分析,情绪、作息、区域……

4.一些网站有你喜欢的文章或者帖子,但是他们没有APP或者是APP做得不友好,你可以直接爬取页面信息推送到手机上。

5.做一个微信公众号。有了上面那么多数据,还怕公众号没东西?生活服务、选股器、行情分析、文章推送等等等。

……

其它想到再更。

编辑于 2015-11-14

路人甲

喜欢用 『 数据 』讲故事 / 同学,你想学习编程吗?

回顾2016年,我用爬虫做了很多事情。

1、微信好友的爬虫,了解一下你的好友全国分布,男女比例,听起来似乎是一个不错的想法,当然你还可以识别一下你的好友有多少人是用自己照片作为头像的,详细的内容可以点击这里:Python对微信好友进行简单统计分析

2、拉勾网的数据那么多的招聘信息有用吗?当然有用,你想了解一下你所在城市的各种主流语言(Java、PHP、JavaScript、Python、C++)的薪资水平吗?这或许对你的学习决策是一个很大的帮助:

3、豆瓣的图书、电影信息有用吗?当然有,你想了解一下哪位小说作家的作品质量最高吗?是否想了解豆瓣上最热门的书记都有哪些,有没有你错过的好书籍呢?豆瓣的电影评论有水军吗?

4、美团和大众点评的数据有用吗?有呀,你真的了解周黑鸭和绝味吗?你知道在哪些城市周黑鸭比绝味火,哪些城市绝味比周黑鸭火呢?如果你都不知道,你就不算是鸭脖控!你所不知道的周黑鸭和绝味鸭脖 - 知乎专栏

5、伯乐在线的文章数据有用吗?有啊,作为技术人员如何写一篇受欢迎的技术文章,作为一名Python初学者如何快速找到Python全面的学习资料,一个爬虫就够了:抓取1400篇Python文章后的故事(内附高质量Python文章推荐)

6、腾讯NBA的用户评论数据有用吗?你用会员看一场NBA,我用爬虫也能看完一场精彩的NBA:用弹幕看一场NBA(公牛 - 老鹰),甚至我还能看到很多你看不到的东西,不信你点进链接看一看。

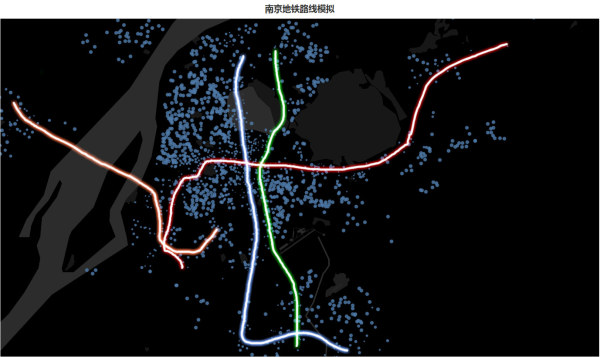

7、链家网的数据有用吗?当然有啦,我能快速地找到我想租的房子,当然我还有一项特殊的技能,我还能用这些数据画出城市的地铁交通路线,是否很想知道如何做:如何拿链家网的租房数据做些有意思的事情?

8、知乎的数据如何用呢?如何判断一场知乎live的质量,如何发现知乎中有趣的东西,知乎中最厉害的粉丝最多的都有哪些人?你想知道吗?

更多好玩的事情在等你:知乎专栏

发布于 2017-02-12

gaga salamer

https://easyeasyoversea.com

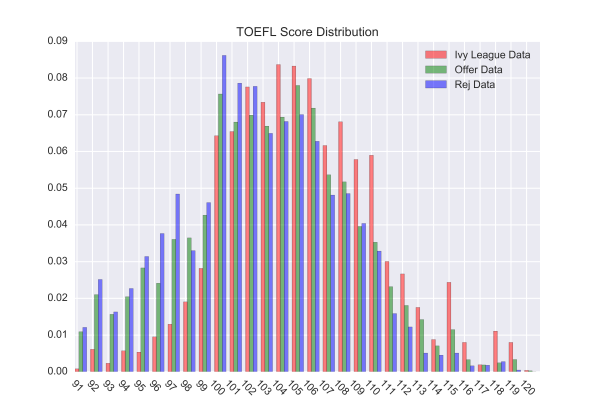

可以爬取留学论坛并分析呀

详情看这篇专栏:

EasyEasyOversea北美留学数据报告书 - 知乎专栏

我爬取了一些留学论坛的数据,并做了分析:

这是托福总分的成绩分布图,我们专门把录取与被拒的数据分开做了统计,同时把申 请常春藤学校(Harvard, Yale, Cornell, Columbia, Princeton, Brown, Dartmouth, Upenn) 的同学的托福成绩单独做了统计对比。从图上看出,托福 100-106 分是分数集中区, 托福越低,被拒的概率越高,低托福逆袭常春藤的例子也比较少…托福越高,被录取 的概率也相对更高。托福在 102 分及以下时,被拒的人几乎都比录取的人多,但托福 大于 102 分时,录取的人几乎都被被拒的人多。而想申请藤校的同学也可以看出,托 福大于 102 时,藤校申请者的托福分数远高于平均水平。从数据上看,申请藤校的同 学托福过 104 就已经高于其他申请者的平均水平了。

接下来我们来分析托福单科分数。这是托福听力分数的分布图,我们特地把 Econ/MFE, 法学与常春藤申请者的托福听力分数做了单独分析。经济金融类专业的同 学托福听力最多的竟然是…竟然是…满分!在高分段(27-30)也是常春藤申请同学保 持领先。听力大于 26 分就比很多人更有优势了。

而托福的阅读水平,经济金融类的同学也是遥遥领先,满分 30 分依旧成为了众数。而 中国申请者托福阅读水平不得不说真的是高,大量集中在(28-30)范围内。中国学生 的英语阅读看了不是大问题…毕竟是做完形填空长大的…

藤校申请者还是都是高分狂魔呢…

我们来看中国学生最头疼的托福口语成绩分布。刚开始看到这图的时候吓一跳,以为 用了假的数据。然后在网上翻看托福口语评分标准我才发现,原来托福口语评分标准 里,就没有 21 分与 25 分这两个分数。(source: http://toefl.koolearn.com/20131230/784726.html…)

在确认了数据的有效性后,我们发现(22-23)是大部分申请者的众数,口语平均水平 确实需要加强。不过 Econ/MFE 的同学口语成绩众数是 24 分,因此口语成绩的进步空 间还是很大。也看得出常春藤申请者的口语水平十分强势,高分段大有人在。一般口 语大于 22 分录取就具有优势了,Offer 数也会比 Reject 数多。口语大于 23 分就比很多 人领先了。

写作分数相对比较分散,集中在(24-28)之间。Econ/MFE 类的同学们受我一膜,众 数在 28 分。Ivy League 在高分段也是保持领先。写作大于 26 分就是一个不错的成绩 了。所以写作也是中国学生考托的刷分大坎,一定要过啊。

我们对 GRE 总分也进行了分析,把常春藤大学的申请成绩单独做了分析,并把 Offer 与 Reject 的 GRE 总分进行了对比。GRE 的众数是 320…这次意外的是无论是 Offer 还 是 Reject 还是 Ivy League,众数都是 320。高分段(329-340)的规律是:常春藤>Offer > Reject。而申请成绩只要大于 322 分就已经大于平均水平了。

我们甚至还用这些数据做了应用

详情请看:

简单海外 | EasyEasyOversea

编辑于 2017-03-17

范儿

梦想最美

如果想了解投资数据,IT桔子绝对是一个很好的选择。和朋友一起合作了这个小项目,利用python爬取IT桔子上的投资公司数据,包含第一层的投资公司名称,投资公司介绍,投资次数,投资领域,及第二层的投资组合等字段。先上个临时域名Data Visualization,数据挂在了这个上面,感兴趣的朋友可以去玩一下。感谢远在伦敦的 @温颖提供爬虫支持,感谢@piupiu(他知乎是个空号,直接放他的个人网站了http://www.wuyue54.com)和我一起把这个项目做完。整个项目从0-1进行设计,纯手写,涉及html、angularjs、d3.js等语言,数据获取为python。

数据截止至2016.4.23,共获取投资公司2063个。

1. 先利用D3.js做了一个拓扑图草图,把所有的投资机构关系理顺,投资次数越多代表该机构的气泡半径越大,具有共同投资关系的投资公司之间会存在连线,共同投资次数越多连线越宽。很明显的国内投资机构和国外投资机构自然分成两个聚类。

2. 之后增加了筛选,按照投资次数多少来筛选投资机构

3. 增加了点击气泡查看被投资公司列表,为增加交互性添加了网页端的slider,可以直接滑动筛选投资次数大于一定数值的投资机构,界面颜色第一次做了统一调整。

4. 增加line chart和bar chart查看全部投资机构或者各投资机构的投资趋势变化及在各轮次的投资次数变化。同时决定把这个项目做到用户友好,调整了整个颜色风格,并添加简单文案。

因为三个人在不同的国家,时间比较碎片化,目前line chart还存在一些小bug,不过不影响整体使用,之后会继续完善。临时域名http://www.benranfan.com/,感兴趣的朋友可以去随便玩一下。如果有任何问题请随时指出,欢迎探讨,转载请注明原作者及出处。

-------------------------------------------

发现和之前 @何明科的答案基金恩怨情仇考(I) - 数据冰山 - 知乎专栏有一些类似,看出来我们的项目里分析各投资机构关系的部分还有很多不足,还是要继续努力学习实践。

编辑于 2016-05-17

司马扶妖

当鸽子不再象征和平 我终于被提醒 广场上喂食的是秃鹰

###

###

最近准备找工作,就想把拉勾网 的数据抓取了下来看看。

趁着五一有假有时间,写了这个爬虫把所有技术类的招聘信息爬了下来,闲着折腾一下。

#########

####答完准备发布才发现此页面已经有人回答过类似的爬取拉勾的数据的答案了,不过也回答一下吧。

#########

用的是scrapy,总共约十万条数据(103167条数据),数据更新至4月30号。

如果有时间再把其他的数据都抓取下来。

分析结果页面:Crawllagou by ScarecrowFu

github:GitHub - ScarecrowFu/crawllagou

代码大致解释:爬下拉勾网数据进行分析—傅sir的个人主页|Alan_fu’s Blog|程序设计

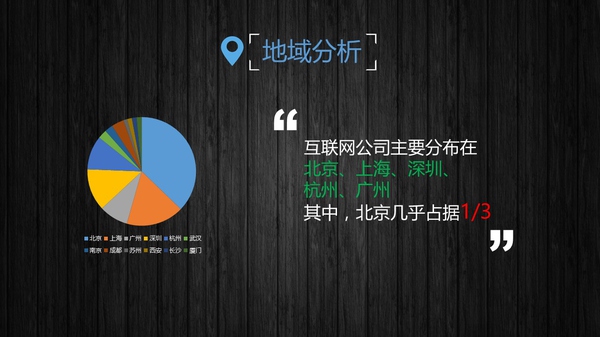

从结果来看,北京的需求量真的很大,几乎是排在第二的上海的两倍。同时也吸引了相应行业的人聚集,人的聚集又相应带动公司的聚集,两者相互影响使得北京成了互联网的主力军。广州的互联网行业比起北上深需求量低了不少。

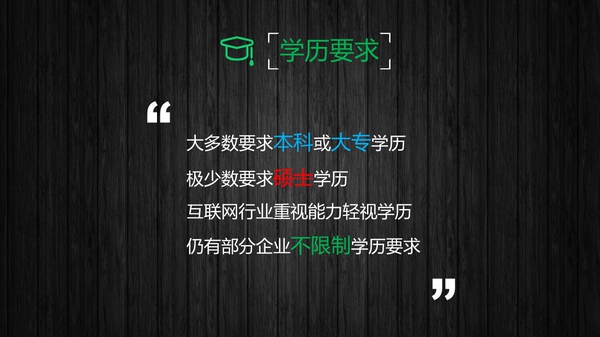

需求最大的是本科以上,其次是大专。学历对于这行虽然不是决定性因素,但要入门还是必须的。

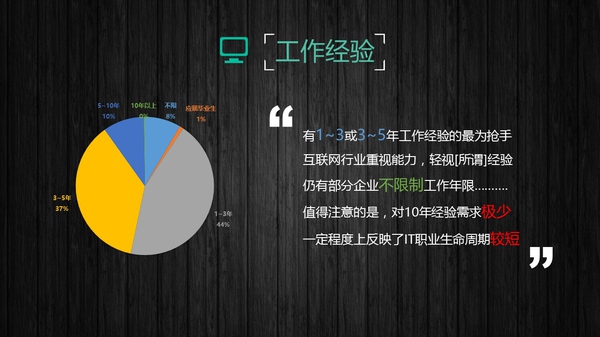

对经验要求,1-3年的占了大数,个人认为一来是这个阶段的人跳槽最多,二来是目前创业公司较多,两者造就这个比例。

阿里巴巴,这个不用说了。 良诺科贸不太清楚,位置在北京。而联想利泰则是联想集团成员企业,其前身是成立于1996年的联想集团研发部软件开发团队。

职位描述中,“团队”这个词出现的比重最大,我们的工作中离不开团队。与技能有关的依次是设计,测试,数据库,java,linux等等。

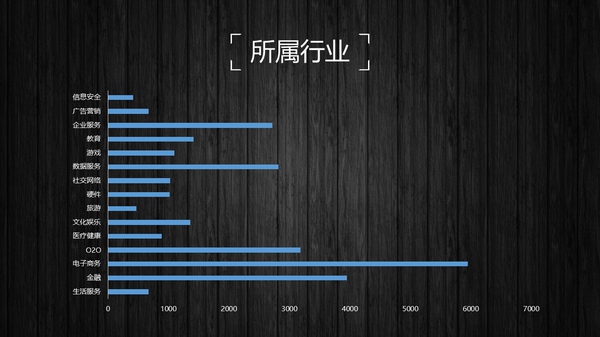

行业领域情况,移动互联网真的很火。。。

PHP是最好的语言??既然比java还多出20个?其实很多人都应该会python,可能是工作上作为主要开发语言的需求量不大,导致python的职位数量是倒数。

看情况北京的公司规模比其他城市都要大,总体来看,创业公司还是居多。

技术类工作薪酬普遍都比较高,这里没有做一个区间分析,有兴趣的可以分析一下,以后有时间我在重新做一做。

职位诱惑中,五险一金被提到的次数最多,这应该是标配才对,不是诱惑。。。

因为我在广州,所以把广州对python的经验要求和薪酬比例分析出来看看。

编辑于 2016-05-04

xlzd

Python 话题的优秀回答者

3月27日更新:

前几天注册了一个新的域名:http://zhihu.photo,里面是知乎一些热门钓鱼贴的图片集,刚刚部署上去,这几天会正式开始抓取。另爬虫和Web端代码已开源,地址:https://github.com/xlzd/。

———————————————————————————

简单讲点我爬过的数据(包括但不限于):

- 知乎的100多万用户(一个知乎重度用户眼中的知乎)

- 图片网站(Page 1 of Desktop Wallpaper)并做了微博带美图自动报时(xlz-d的微博_微博)

- 一个菜谱网站的菜谱并计划做成手机APP(暂时搁置)

- 58/赶集/豆瓣的租房信息并主动推送优质房源到邮箱(前段时间准备租房)

- 妹子图/成人糗百/**的图片(妹子图 - 清纯美女,可爱美女,美女图片,糗百成人版::糗事百科 成人版 成年 糗友都懂得!,**)

- 轮子哥 @vczh的关注列表的美女的所有爆照(通过face plus plus的API识别头像并通过Python的库简单识别暴露面积)

- 工作中的爬取内容不便过多透露

关于爬虫,练手的话建议向需要登录的、比较封闭的社区爬取数据,或者向一个超大量数据源分布式抓取,要考虑服务器压力和反爬虫机制,分布式爬虫机器间的通信以及失败条目的重新抓取但不重复抓取已抓取数据等,可以使用一些成熟的Message Queue或者纯手撸。

到最后希望你能够达到的水平是,只要浏览器可以浏览的内容,都能够用爬虫抓取(在时间开销/内存开销/存储开销都吃的消的情况下)。

(由于知乎~哔~的霸王条例,某1<<10网站用**代替。)

编辑于 2016-03-27

小耸

一枚在二线城市的轻文艺程序猿

2016年2月19日 update: 新增对雇主的统计

2016年4月27日 update: 知乎登陆帐号添加了验证码机制,原来的代码无法完成登陆。

=========原回答==========

入坑知乎三年有余,数月前灵光闪现,做个网页爬虫,专爬知乎下的精华回答,作统计分析。

以下,即是此项目的分析结果,希望能从另一个角度呈现出不一样的知乎。

代码

“talk is cheap, show me the code!” --屁话少说,放码过来。心急的朋友可以直接戳链接看源码,用的是Python3:

GitHub - SmileXie/zhihu_crawler

算法简述

1.爬虫算法

以根话题的话题树为启始,按广度优先遍历各子话题。话题的遍历深度为3。解析各话题下的精华回答。

2.收集数量

目前收集的信息共计50539个精华回答。

3.分析内容

- 精华回答的点赞数,答案长度等;

- 答题用户的id,点赞数,地区,性别,学历,学校,专业等;

统计结果

1.匿名答主

50539篇精华回答中,有3308篇的回答者选择了匿名发布答案。

2.答主性别

男15740,女5749.是否从一个侧面印证了知乎上程序员占了很大的比例.

3.答主受教育情况

按答主的所在(毕业)学校统计,TOP10的学校是:

可以看出,中国的顶尖高校对知乎的精华回答贡献颇多。

按答主所在的专业统计,TOP10专业是:

果然是程序猿的天堂。(上面的数据,我针对“计算机”和“金融”的数据做了处理,把“计算机”“计算机科学”“计算机科学与技术”合并为“计算机”,把“金融”和“金融学”合并为“金融”)

4.雇主

精华回答答主的雇主统计,互联网行业占了大多数。

5.精华回答的赞同数

按精华回答所获得的赞同数落在的区间,做统计

可见,大多数精华回答获得的赞同数是处于0~4999范围内的。

目前统计到的最高票回答是这篇:《哪些素质很重要,却是读书学不来的》中肥肥猫的回答,共获得了91433个赞同。

6.回答字数

如果按以下标准将精华回答按字数分类:

0~99:短篇

100~999:中篇

1000~9999:长篇

10000以上:超长篇

那么,精华回答的字数分布如下:

看来各位答主对没少在知乎上码字。长篇的数量甚至超越了短篇和中篇。

目前收集到的最长字数回答是:《人究竟能抠到什么程度》中郭永年的回答,答主扬扬洒洒写了98904字,敢情是在知乎上写小说了啊。

后记

作为一个对Python和C都有使用的程序员,在开发的过程中不断地领略着这两种语言的巨大差异。

Python把对开发者友好做到了极致,牺牲了性能。

C把性能做到了极致,牺牲了对开发者的友好。

这个项目只用了500行Python,如果换作500行C,估计只能完成上述功能的1/10吧。

最后再贴一遍源码:

GitHub - SmileXie/zhihu_crawler

编辑于 2016-04-27

微觉

做爬虫吃数据拉图表 http://jiashidata.com/vh/

题主的方向不就在自己的需求里么。

既然要转数据分析方向,那就去爬各大招聘网站的数据分析岗阿。

然后进行数据清洗,语义处理,进而得到数据分析岗的用工趋势,地域分布,薪酬水平,主要要求的技能点。

然后写个分析文章发布,名利双收,说不定就有企业主动就来找你了。

发布于 2015-10-12

weijiaw

数据/产品// http://www.weijiaw.cn

好久的问题了,尝试回答下,希望对题主有用~

一、总结题主问题及现有回答

从题主的问题中来看,似乎题主对于python爬虫的编写已经没问题了,在此就不赘述了。从问题来看,题主的问题主要分为两个方面:第一,抓取到数据之后如何进行分析;第二,“哪些网站的数据抓取下来能获得有分析价值的数据”,即从哪里能获取到有价值的数据。

从现有的回答来看(截止2016年1月1日晚;新年晚上回答。。太拼了。。),包括排名第一 @林骏翔 和排名第二 @xlzd在内的排名较高的答案大多数都在回答第二个方面的问题,从哪里获取有价值的数据。 我曾经抓取新浪微博;百度贴吧;百度的检索结果及相关字段等,就不详细展开了。

我就主要结合自己的经历分享一下第一个方面的问题吧。

二、爬虫抓到的数据的分析方式设想

第一,在分析数据之前我们总是带有某些特殊的目的、需求和预期想要得到的结论的。这往往是一个实际的问题,可能是商业性的,当然也可能是学术性的。举个栗子,我们都知道,百度贴吧中总是存在各种各样的信息,有一些是水军,有一些是有用的等等。我的需求是,我想要写一个爬虫获取某贴吧里每天所有的帖子及其评论,但是希望过滤到垃圾信息(这样可以大大提高我的阅读效率,逛过吧的应该知道,某些吧里一堆水军)。于是,爬虫就是我首先要写的程序了。爬虫写好了,问题来了。问题是,每天24:00我抓完数据之后要怎么过滤掉垃圾信息及水军信息呢? 这是需要一种能力的,我觉得这是题主想要获得的能力。就是将商业性或者学术性的问题转化成一个可用数据分析解决的问题这是数据分析的一种能力。我觉得这需要三个方面的能力:1、领域知识,就是你对要分析的问题的领域的熟悉程度;2、数据挖掘、分析算法的了解程度,对于常用的分类、聚类、回归、关联等算法了解一些把;还有一些统计的方法;3、sense。这个就比较玄乎了,一眼看出问题是什么。。可能跟前两个方面存在共线性,但不得不承认,有些人确实存在特殊的天赋。。。

在此不展开说了。比如,在这个栗子里,我们可以采用分类的方式来解决问题,算法那就是一些分类算法了,SVM、KNN、Decision Tree等等。训练一个二值分类器,垃圾与非垃圾。

第二,抓取到的数据不可能涵盖到我们想要知道的所有方面,而且数据的清洁性也不见得能达到所有字段都可以用于分析的程度。还是举个栗子,小明想研究abcde,5个问题。但是,观察数据之后,小明发现数据只能支持他要分析的abc,3个问题(sign。。);但是在观察数据的过程中,小明又得到了启发,f问题也可以分析。于是,最终,小明分析的可能是abcf,4个问题。

所以,数据分析也是一个trade-off的问题。我们抓取到得数据和要进行的分析之间的trade-off。

trade-off的过程就是这样,产生预期→收集、处理、观察数据→部分预期满足、部分预期受挫、数据启发产生新的预期→开始进行分析;甚至在分析的过程中,还会发现前面预期的不合理性,或者收到了进一步的启发,这些都是有可能的。

==============================我是分割线=================================

最后来一个大栗子。抓取了新浪微博的数据,其实前后抓取了两次,keyword分别是“iphone”和“京东白条”。 两次分析的思路类似,抓取的字段类似,两个放在一起说啦,以“京东白条”为例来描述。

(因为是我大三的课程作业,所以不涉及版权和保密性问题,我就随便扯扯了,不对的地方请大家指教)

分析的主题:《基于新浪微博的京东白条发展建议》(这不像那个垃圾分类那个问题,不是一个很主题很集中的问题,但是好在无论得到什么样的规律,只要可信,都可以作为一条建议出现在结论里233333333。。。)

一、数据来源:新浪微博。

二、抓取策略:在新浪微博搜索框进行检索,获取检索结果。

三、开发环境:python3

四、数据维度及特征:

1. 关于微博博文。(正文、点赞数、转发数、评论数、发布设备、发表日期、博主主页url)

2. 关于博主。(历史博客书、粉丝数、关注数、性别、生日,地区、描述)

五、大家停下来,想想你们认为可以做的统计与分析的维度有哪些???

六、我当时做的统计与分析。

1. 基本统计学:每天微博有多少的趋势图(解析趋势,还原到历史事件);性别分布;地区分布(省份级别的分析,与GDP密切相关,但存在异常省份,可进一步分析为何这些省份对于京东白条的关注有异常,为进一步的营销和白条策略做参考);累计分布(总点赞数、总转发数、总评论数排名前20%,1%的博主占总博主的人数)

2. 情感分析。 对微博正文切词,然后进行情感判别。 我想了两个思路,第一个基于切词、情感词典和极性词的情感判别;第二个是基于机器学习的(与垃圾分类类似,进行情感分类;可以训练个分类器试试)。当时实现了第一个,判别了每条微博正文的情感value。然后与性别、省份做了交叉分析。。。比较性别和省份上对于京东白条情感值的差别。我认为,这个对于营销和产品设计是有意义的。发现特定群体对于某些产品的特定情感情况。 然后为进一步的营销或者产品设计作参考把。

3. 回归分析,以微博的点赞数、转发数、评论数为因变量(营销效果);以博主粉丝数、微博数、关注数、情感值和性别为自变量。做回归。主要是想得到营销方面的结论,大家都知道,微博营销各种存在,水军、大V等等。那么如果京东白条要找水军,应该找怎样的水军呢?

结论:低调的又富有正能量的男神;

低调是说发的微博比较少的人,营销效果好一些;男生好于女生;情感值高的微博好于情感值低得微博;粉丝多的优于粉丝少的。 这四条是统计学上显著的结论。

细节不赘述了。 希望对题主有所启发~

有写的不好的地方,请大家多多指教。

编辑于 2016-01-02

小灰灰

Python,CSharp,PHP。

整理了一些教程可以加群了直接下载,Python QQ群: 202497449

【已经升级为2000人群,群友大多是Python,爬虫相关人员,共享了很多资料。】

赞的比较多,放一些完整的代码出来,可以跑起来玩玩,看着爬虫运行还是蛮有趣的。

爬:apptool,应用工具,app排名查询,app排名优化,app排名,应用市场排名

update(2016.3.5)到服务器了,陌陌的排名趋势:

陌陌

知乎的

知乎

最近一周排名跟踪。(2016.3.1)

增加了可视化的排名变化(2016.2.27)

知乎的排名变化

爬内容,爬图片,各种爬。

从几千条,目前已经爬了几百万条了,后面做做数据可视化。

看着爬虫运行的感觉很有趣,不停地,一条一条往前翻。

数据量最大的爬虫,快四百万条数据了。计划是开发一个APP排名,跟踪和查询的application。后面还想做更加细致的跟踪,比如说排名发生变化的时候,下载量有什么变化,评论量有什么变化,如此等等。这才能勉强算是有点用的爬虫,而不仅仅是简单的download数据。

编辑于 2016-06-24

terry luck

写有意思的程序

给爸爸爬取雪球网中某个组合,查看股票持仓情况,一旦持仓变化,则发送邮件到指定的邮箱,luckterry7/stCrawler · GitHub

爬取豆瓣电影,最新的和评分大于7的电影爬取出来,周末慢慢看。luckterry7/doubanMovieCrawler · GitHub

编辑于 2015-11-16

伪红学家

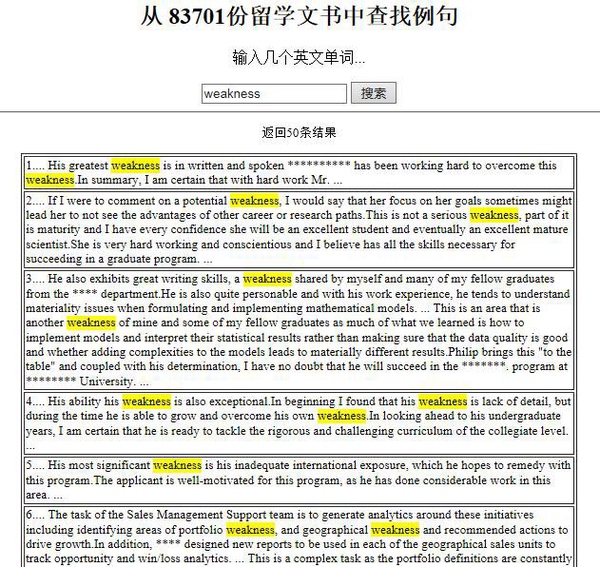

从某处爬到的某美国著名高校170000+份研究生申请文件。

因为显而易见的原因,我不能公布它的具体来源……(所以请不要问我,绝对不回答)

但是获取这些文件(或者从各种各样的pdf里提取文字)真的只是这件事的一小部分,重要的都在如何分析这些数据。比如遇到的第一个问题就是没有标注,也就是我们完全不知道这些申请者的录取结果如何,这样不能直接训练一个分类器。当然,某些系的网站上会有PhD学生的名单,那么如果我们想知道怎样的学生被录取,实际遇到的是一个半监督学习当中的不完全先验信息聚类问题。

这和我毕业论文大概处理的是相同的情况,虽然用的肯定不是这样来路不明的数据。因为毕业论文还没写完,暂时没有对这些文件处理。

我们也可以换个思路,做一些其他量的统计或者回归。例如,考虑学生GPA的分布,与学校的世界排名等的关系,那么至少可以为其他申请者提供一种参考:“申请该学校的有86.75%都比你优秀哦!”

不过之前,我做了一个很简单的“留学文书例句搜索”(现在已下线,这里有介绍:快速创建一个例句搜索工具的思路)。比如你想知道一般推荐信里对于申请者的弱点是怎么说的,那可以搜索含有weakness的文本,然后就知道其实大家都是换着花样在夸自己嘛。

最后,放几张图片,是我在随手翻这些文件时找到的亮点。

(我们最专业)

(这个学生被坑惨了啊)

(虽然大家都是自己写的推荐信,你们也不能太高调嘛)

(这是pdf属性里的文件标题,如果直接从word转换或打印,可能就会显示出文件名)

编辑于 2016-09-16

Xiaotong

No.

路过,大学期间爬过很多有趣的有用的有意义的网站。在这里顺便做个总结交个朋友

1.教务网站(涉及模拟登录)

很多高校在入学时的教务系统登录密码是一样的,而且50%的学生到大四都不改:)(123456)

当年写的第一个爬虫,用的php,因为php的curl库做模拟登录简单暴力,代码很简单,创建递归模拟登录,解析成绩页面。(南理工的同学应该还记得当初风格极简的教务系统,没有验证码,没有浏览器拦截,cookie不加密)。

硬盘里存着懒得改密码同学的姓名学号成绩在当时是一种可怕的成就感:|

2.小游戏网站

在CSTO上接了一个爬小游戏的单子,细聊后了解到他们在做针对低龄青少年的游戏网站(类似4399)。

也是从那个时候才知道原来小游戏网站的swf文件都是赤裸裸的对外开放,仍然记得交付的时候对方的表情,哦,原来这个网站的文件都是不加密的啊,那挺简单的。最后不得不悻悻地给钱走人。

由于对方站点”当时”没有做相关声明与技术拦截,原则上讲通过手动方式能够获取的文件都不算违法。

爬取京东,亚马逊商城的数据违法吗? - 互联网

3.亚文化与小清新网站

在做饥饿(StarvingTime)的时候调研过相关小众网站,这些网站都是土豪外包,法律条款基本没有,而且有些现在已经挺火了。大家没事可以爬爬,数据存下来总没有坏处。

VICE 中国 | 全球青年文化之声:世界在下沉,我们在狂欢

公路商店_为你不着边际的企图心

ChokStick 骚货

豆瓣东西

4.微信公众号

无意间发现饥饿公众号的文章出现在林子聪头像旁边,好奇微信有做加密怎么会被爬,民间高手也太强了。后来调研了一下,原来是搜狗将微信的接口买了下来造福大众。

如何利用爬虫爬微信公众号的内容? - 移动互联网

5.股票数据

前年暑假做神经网络,需要大量的个股数据用来训练,于是爬了A股1997-2014的所有数据。当时雅虎,新浪等都有api,先使用雅虎,资料太旧不成功。大家可以试试。

雅虎股票接口

新浪没有历史数据接口。

新浪实时股票数据接口http://hq.sinajs.cn/list=code

google的中国股票数据当时也调用的新浪接口,所以最终方案就是爬新浪页面,当时新浪财经的UI有展示历史数据,现在依然存在。

西宁特钢(sh600117)历史成交明细(对于个股也可以直接用同花顺等软件下载。)

6.音乐网站

落网 - 独立音乐推荐

硬盘里有它六千多首歌,一辈子都够听了

—————————————————————————-安利线————————————————————————

自己写的可配置爬虫

基于python3.4,有了异步访问后爬虫的效率简直了。

什么是可配置爬虫?

可以设置爬取深广度,爬取规则(正则直接写在xml里),爬取对象,爬取站点,爬取模式(主要是静态。动态爬取还在测试)

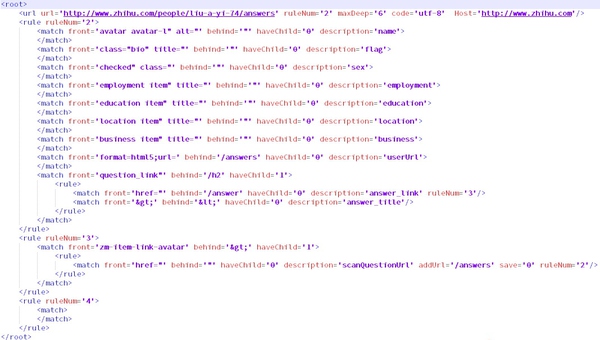

如图是一个从某用户开始深度爬取知乎的 config DEMO,稍微改几个字段就可以爬取别的站点,使用起来非常方便。

代码松耦合。数据存储用的是MongoDB,所以使用的话需要先安装mongodb,支持分布式,配合django+nginx开发系统工程效率可观。

可配置爬虫Python

发布于 2016-02-26

叛逆者

计算机图形学、C++ 话题的优秀回答者

我的爬虫在内部网上爬到过未来2年内所有的产品代号和发布时间。真就有那么不开眼的什么都敢共享。

发布于 2016-03-05

alex

现实很现实,有时候,现实不现实。

我出个题目吧,楼上的都不靠谱,

1.抓取淘宝网中卖家等级小于四心的卖鞋的江苏地区的卖家帐号;

2.抓取诚信通超过三年的卖饰品的卖家帐号;

3.抓取天猫商城中新开用户且卖水晶的苏州账户。

这些都是及其有用的价值,能写出来,甚至可以卖个几十万,我只能帮到这了。

发布于 2015-10-07

已使用 Microsoft OneNote 2016 创建。