当地时间 4 月 12 日,微软宣布开源DeepSpeed-Chat,帮助用户轻松训练类ChatGPT等大语言模型,人人都有望拥有专属ChatGPT。

OpenAI 之前明确表示拒绝开源 GPT-4,也收获了无数“OpenAI 并不 open”的吐槽。而 AI 开源社区已推出 LLaMa、Vicuna、Alpaca等多个模型,帮助开发者开发类 ChatGPT 模型。

即便如此,现有解决方案下训练数千亿参数的最先进类 ChatGPT 模型依旧困难,主要瓶颈便在于缺乏RLHF训练普及——而微软本次开源的 DeepSpeed-Chat,便补齐了最后这一块“短板”,帮助在模型训练中加入完整 RLHF 流程的系统框架。

仅需一个脚本,便可以完成 RLHF 训练的全部三个阶段,类 ChatGPT 大语言模型生成唾手可得,堪称“傻瓜式操作”。

这还不是 DeepSpeed-Chat 唯一的优势,微软提供了中、英、日三语文档,作出了详细介绍。总体来说,其核心功能与性能包括:

1. 简化类 ChatGPT 模型训练、强化推理体验。

2. DeepSpeed-RLHF 模块复刻了 InstructGPT 论文中的训练模式。同时,DeepSpeed 将训练引擎与推理引擎共同整合到了一个统一混合引擎用于 RLHF 训练。

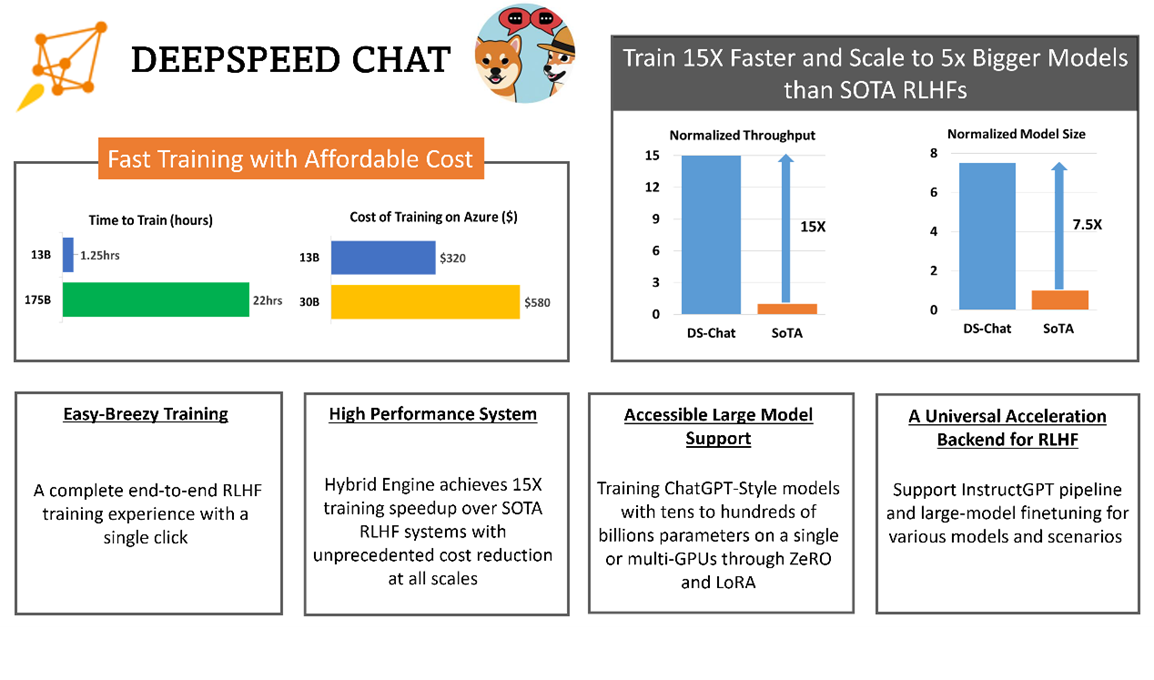

3. 高效性和经济性:可将训练速度提升15倍以上,并大幅度降低成本。例如,DeepSpeed-HE 若在 Azure 云上训练一个 OPT-30B 模型,仅需 18 小时、花费不到 300 美元。

4. 卓越的扩展性:可支持训练数千亿参数模型,并在多节点多 GPU 系统上扩展性突出,只需 1.25 小时就可完成训练一个 130 亿参数模型。

5. 实现RLHF训练普及化:仅凭单个 GPU,DeepSpeed-HE 就能支持训练超过 130 亿参数的模型。因此无法使用多GPU系统的数据科学家和研究者,不仅能创建轻量级 RLHF 模型,还能创建大型且功能强大的模型。

此外,与 Colossal-AI、HuggingFace 等其他 RLHF 系统相比,DeepSpeed-RLHF 在系统性能和模型可扩展性方面表现出色:

就吞吐量而言,DeepSpeed 在单个 GPU 上的 RLHF 训练中实现 10 倍以上改进;多 GPU 设置中,则比 Colossal-AI 快 6-19 倍,比 HuggingFace DDP 快 1.4-10.5 倍。

就模型可扩展性而言,Colossal-AI 可在单个 GPU 上运行最大 1.3B 的模型,在单个 A100 40G 节点上运行 6.7B 的模型,而在相同的硬件上,DeepSpeed-HE 可分别运行 6.5B 和 50B 模型,实现高达 7.5 倍提升。

因此,凭借超过一个数量级的更高吞吐量,DeepSpeed-RLHF比Colossal-AI、HuggingFace,可在相同时间预算下训练更大的 actor 模型,或以 1/10 的成本训练类似大小的模型。