CVPR 引用量最高的10篇论文!何恺明ResNet登顶,YOLO占据两席! - Amusi的文章 - 知乎 https://zhuanlan.zhihu.com/p/165097702

前言

前不久,谷歌发布了2020年的学术指标(Scholar Metrics)榜单,CVPR 位列AI领域排名第一的大会!

这个排名是依据过去五年发表研究的数据(覆盖2015-2019年发表的文章),并包括截止2020年6月在谷歌学术中被索引的所有文章的引用量。

众所周知,CV领域的三大顶会就是:CVPR、ICCV和ECCV。本文就来盘点CVPR 2015-2019年引用量最高的10篇论文。根据此数据,一方面能看出这段深度学习黄金时期的研究热点,另一方面查漏补缺,看看这些必看的Top级论文是不是都掌握了。

注1:2015年之前的论文不在统计范围内

注2:引用量是根据谷歌给出的数据,会有波动,但影响不大

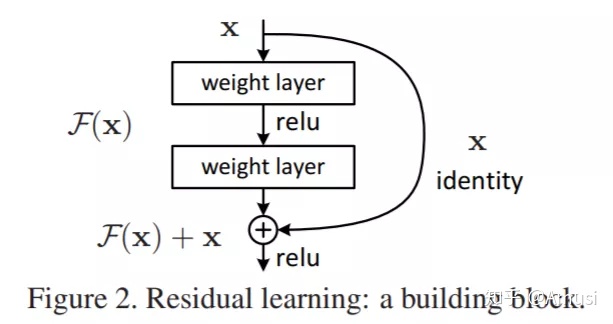

第一名:ResNet

Deep Residual Learning for Image Recognition

作者单位:微软亚洲研究院(MSRA)作者团队:Kaiming He(何恺明), Xiangyu Zhang, Shaoqing Ren, Jian Sun引用量:49301论文链接(收录于CVPR 2016):> https://openaccess.thecvf.com/content_cvpr_2016/html/He_Deep_Residual_Learning_CVPR_2016_paper.html

ResNet 一出,谁与争锋?

当年直接拿下 ILSVRC 2015 的第一名

现如今2020年,依旧作为各大CV任务的backbone,比如ResNet-50、ResNet-101。入坑卷积神经网络,必学paper之一!如下图,大家应该都很熟悉吧

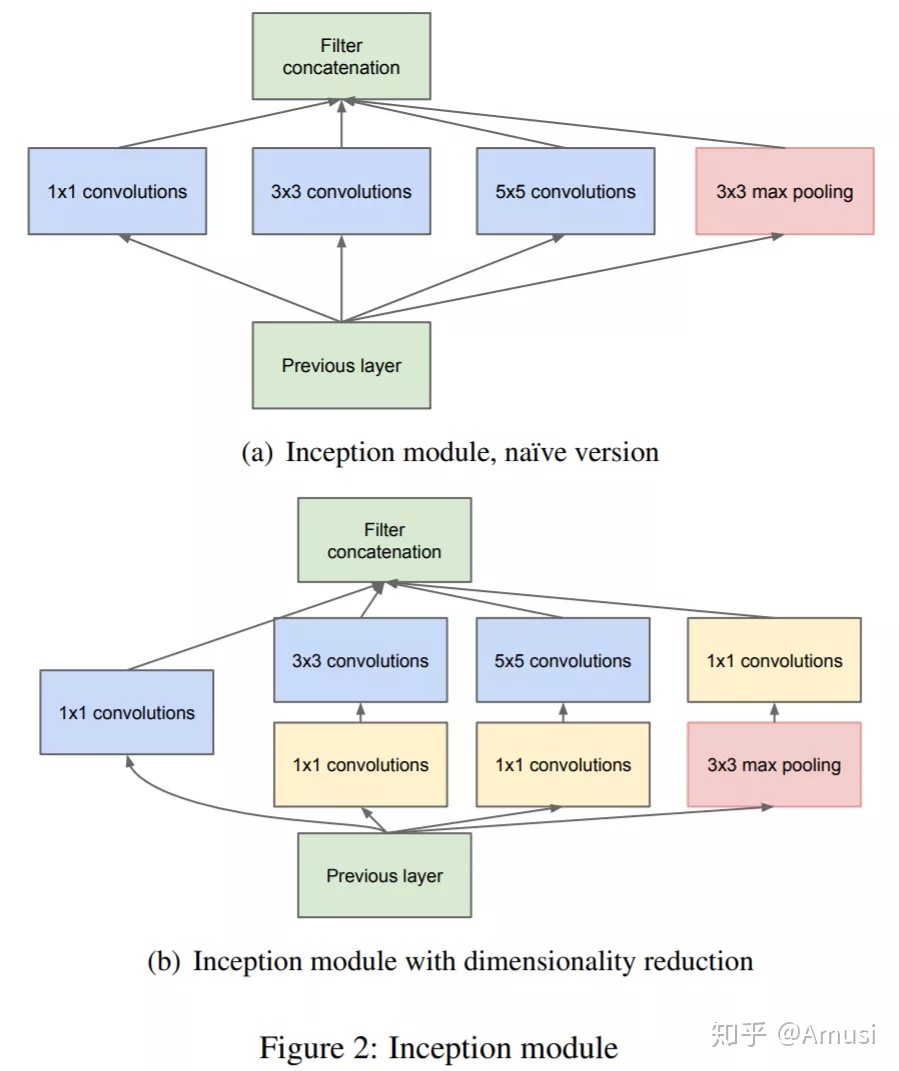

第二名:Inception(GoogLeNet)

Going Deeper with Convolutions

作者单位:谷歌,北卡,密歇根州立大学,Magic Leap作者团队:Christian Szegedy , Wei Liu , Yangqing Jia等引用量:22434论文链接(收录于CVPR 2015):> https://www.cv-foundation.org/openaccess/content_cvpr_2015/html/Szegedy_Going_Deeper_With_2015_CVPR_paper.html

GoogLeNet,其实也就是Inception系列的第一代网络,当年直接拿下 ILSVRC 2014 的第一名,VGG 则拿下第二名。

其中采用1x1卷积,亮点十足!截止2020年,1x1卷积也还在被各大网络广泛应用,来减少参数和计算量。

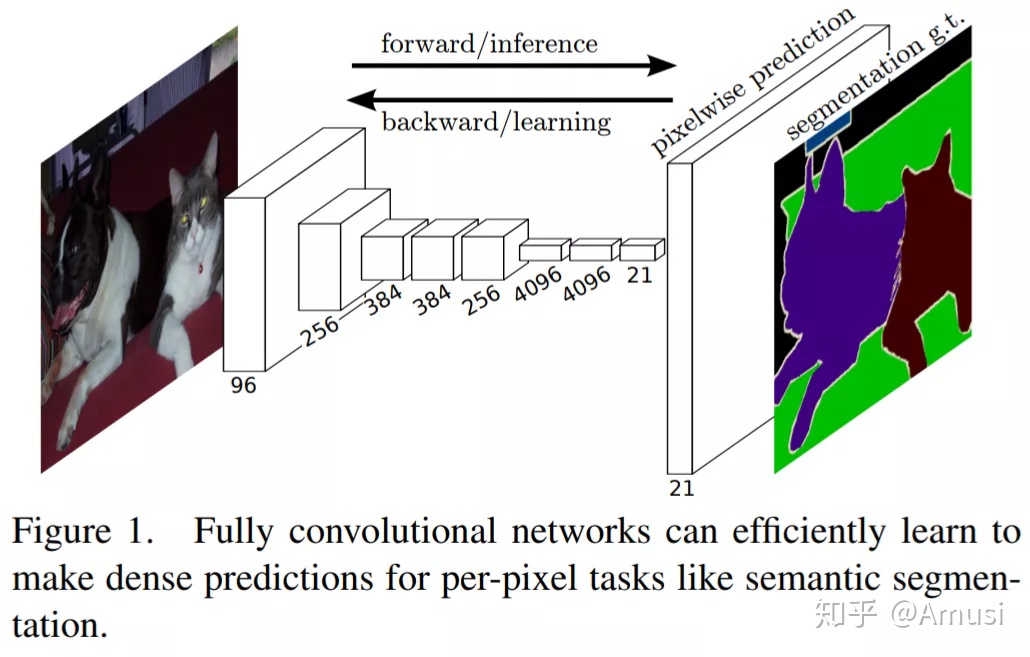

第三名:FCN

Fully Convolutional Networks for Semantic Segmentation

作者单位:UC Berkeley作者团队:Jonathan Long, Evan Shelhamer, Trevor Darrell引用量:16664论文链接(收录于CVPR 2015):> https://www.cv-foundation.org/openaccess/content_cvpr_2015/html/Long_Fully_Convolutional_Networks_2015_CVPR_paper.html

FCN 可以称之为真正意义上基于深度学习的图像分割开山之作,不含全连接层(fc)的全卷积网络。同年的图像分割论文,应该只有U-Net可以与之媲美。

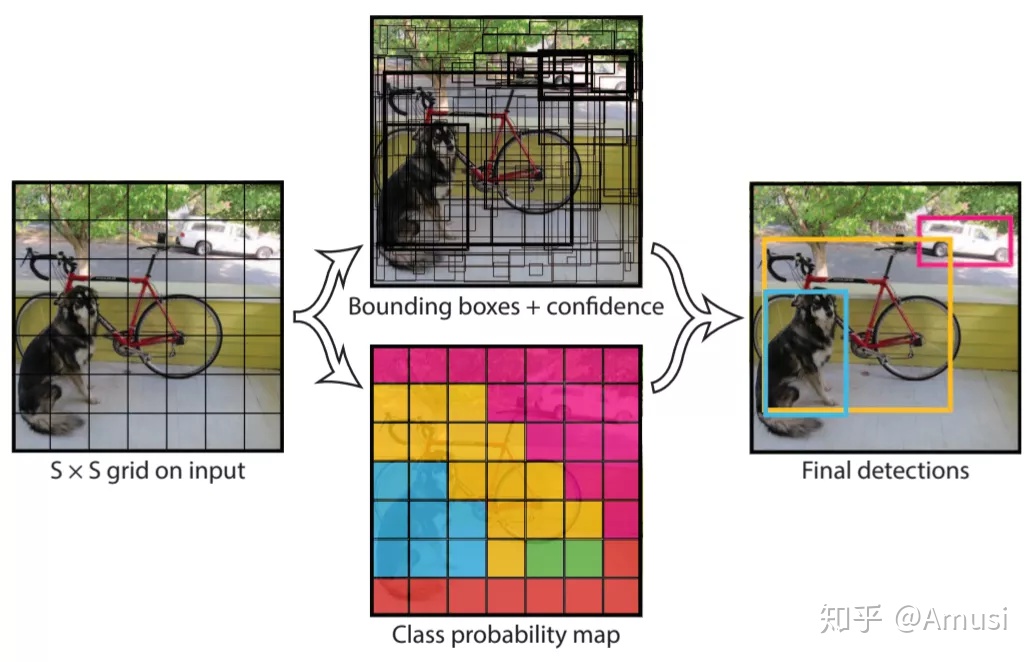

第四名:YOLO

You Only Look Once: Unified, Real-Time Object Detection

作者单位:华盛顿大学, Allen Institute for AI, FAIR作者团队:Joseph Redmon, Santosh Divvala, Ross Girshick, Ali Farhadi;引用量:9772论文链接(收录于CVPR 2016):> https://www.cv-foundation.org/openaccess/content_cvpr_2016/html/Redmon_You_Only_Look_CVPR_2016_paper.html

YOLO系列开山之作!

当初YOLO(You Only Look Once)这个命名风格也被不少网络借鉴

截止2020年,还有一作认可的YOLOv4发布。YOLO可以称为目标检测领域中更新最频繁,也是力度最大的”IP”。

第五名:DenseNet

Densely Connected Convolutional Networks

作者单位:康奈尔大学, 清华大学, FAIR作者团队:Gao Huang, Zhuang Liu等引用量:9733论文链接(收录于CVPR 2017):> https://openaccess.thecvf.com/content_cvpr_2017/html/Huang_Densely_Connected_Convolutional_CVPR_2017_paper.html

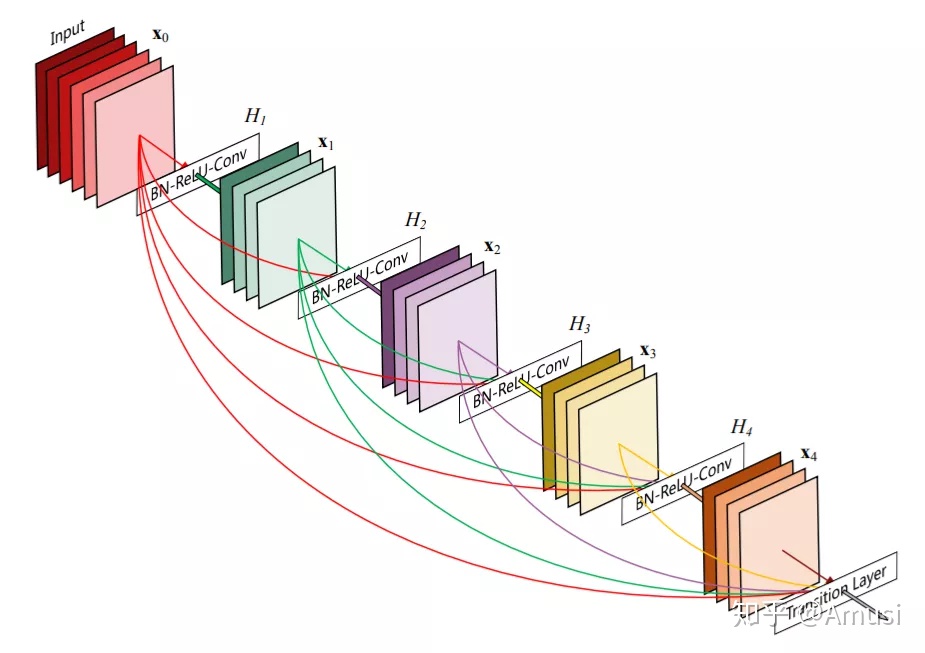

DenseNet 如下图所示,很明显基本思路与ResNet一致,但是它建立的是前面所有层与后面层的密集连接(dense connection)

第六名:Inception v3

Rethinking the Inception Architecture for Computer Vision

作者单位:谷歌, 伦敦大学学院作者团队:Christian Szegedy, Vincent Vanhoucke, Sergey Ioffe等引用量:8499论文链接(收录于CVPR 2016):> https://www.cv-foundation.org/openaccess/content_cvpr_2016/html/Szegedy_Rethinking_the_Inception_CVPR_2016_paper.html

Inceptionv3 中的设计原则特别多,直接在 Inception V2 的基础上将 Top-5的错误率降低至 3.58%。

第七名:pix2pix

Image-to-Image Translation with Conditional Adversarial Networks

作者单位:UC Berkeley作者团队:Phillip Isola, Jun-Yan Zhu, Tinghui Zhou等引用量:5624论文链接(收录于CVPR 2017):> https://openaccess.thecvf.com/content_cvpr_2017/html/Isola_Image-To-Image_Translation_With_CVPR_2017_paper.html

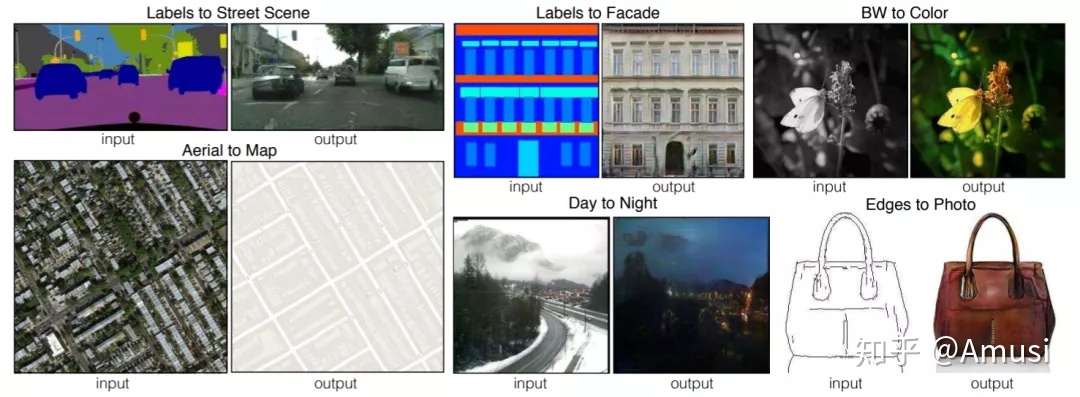

pix2pix 是将GAN成功应用于有监督的图像到图像 translation的经典论文,比如将语义分割图转换为真实街景图,灰色图转换为彩色图,白天转换为黑夜……

GAN的可玩性相当高,目前各大顶会上GAN相关的论文也是层出不穷

第八名:FaceNet

FaceNet: A Unified Embedding for Face Recognition and Clustering

作者单位:谷歌作者团队:Florian Schroff, Dmitry Kalenichenko, James Philbin等引用量:5405论文链接(收录于CVPR 2015):> https://www.cv-foundation.org/openaccess/content_cvpr_2015/html/Schroff_FaceNet_A_Unified_2015_CVPR_paper.html

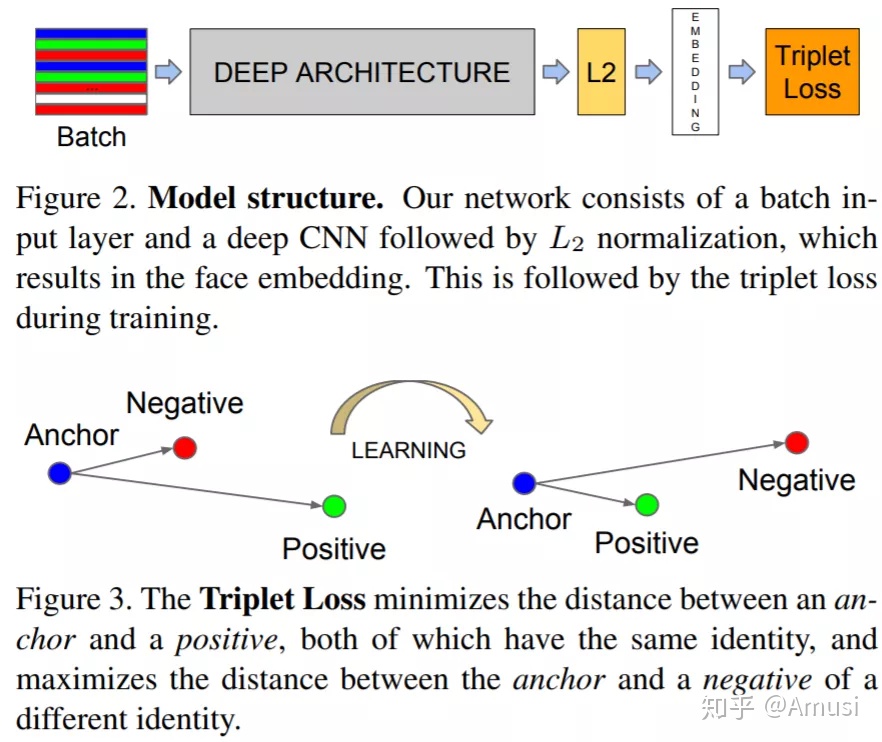

鼎鼎大名的 Triplet Loss就出自FaceNet,可很好地学到人脸的embedding。

第九名:YOLOv2

YOLO9000: Better, Faster, Stronger

作者单位:华盛顿大学, Allen Institute for AI, XNOR.ai作者团队:Joseph Redmon, Ali Farhadi等引用量:4960论文链接(收录于CVPR 2017):> https://openaccess.thecvf.com/content_cvpr_2017/html/Redmon_YOLO9000_Better_Faster_CVPR_2017_paper.html

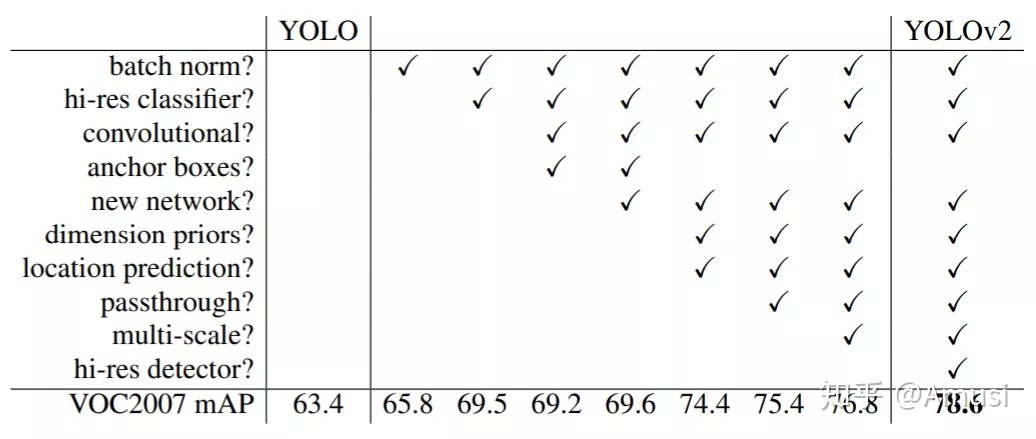

YOLO v2在v1的基础上改进非常之多(这个已然成为YOLO系列的特质,像YOLOv3和YOLOv4,tricks和实验都是相当多),性能也有极大提升,如下图所示: The path from YOLO to YOLOv2

The path from YOLO to YOLOv2

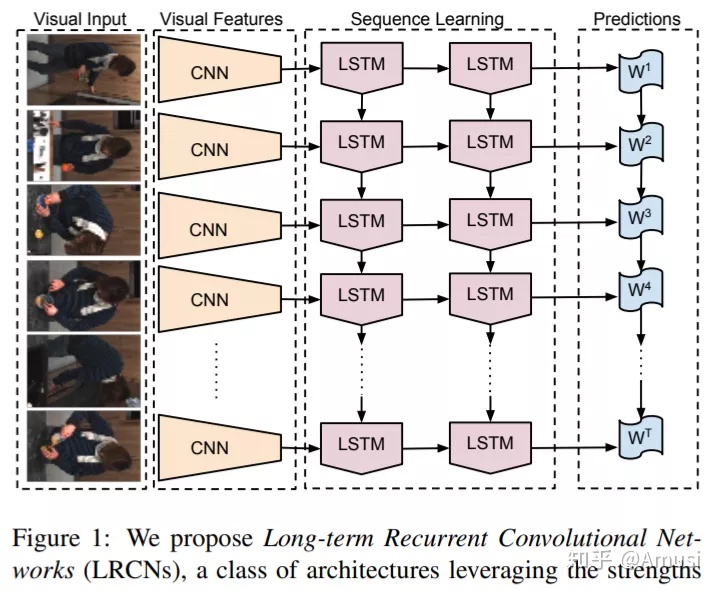

第十名:LRCNs

Long-Term Recurrent Convolutional Networks for Visual Recognition and Description

作者单位:UT Austin, UMass Lowell, UC Berkeley作者团队:Jeffrey Donahue, Lisa Anne Hendricks等引用量:3924论文链接(收录于CVPR 2015):> https://openaccess.thecvf.com/content_cvpr_2015/html/Donahue_Long-Term_Recurrent_Convolutional_2015_CVPR_paper.html

LRCNs 将CNN 和 LSTM结合起来,可很好地应用于视频行为识别,图像描述生成等任务。

侃侃

- 上述10篇论文,大多都是图像分类(backbone)、目标检测和分割这三大基础CV任务方向。

2. 何恺明等人的ResNet引用量遥遥领先;

3. 谷歌、UC Berkeley均有三篇论文入围;

4. Joseph Redmon和Christian Szegedy 均有两篇入围前10的一作作者,前者是YOLO系列作者,后者是Inception系列作者。

5. 除了前10名之外,值得提一下:FPN位列第11名,SENet位列第15名下载

上述10篇论文已打包好,资源链接如下: 链接:> https://pan.baidu.com/s/1qCjgHPWWj9cy4STytApl5w提取码:x34z 推荐大家关注计算机视觉论文速递知乎专栏和CVer微信公众号,可以快速了解到最新优质的CV论文。推荐阅读

300+篇CVPR 2020代码开源的论文,全在这里了!

OpenCV4.4刚刚发布!支持YOLOv4、EfficientDet检测模型,SIFT移至主库!

目标检测四大开源神器Detectron2/mmDetection/darknet/SimpleDet

超越YOLOv4!PP-YOLO:更快更好的目标检测网络

ECCV 2020 放榜!一文看尽10篇论文的开源项目(检测/GAN/SR等方向)

有人手写实现李航《统计学习方法》书中全部算法

大神没交棒,但YOLOv5来了!

大神接棒,YOLOv4来了!

YOLOv4-Tiny来了!371 FPS!

ResNet最强改进版来了!ResNeSt:Split-Attention Networks

周志华教授:如何做研究与写论文