前言的前言

这是一篇连载文。我会把最近学到的知识,系统性的整理并发表出来,这其中可能涉及的几个核心观点如下:

1AI 在本文中约等于 “会自我学习的程序”;

2以 chatGPT 为代表的大模型,对语言的理解能力接近了人类的水平;

3大模型 AI 相比传统 AI 强在更具有普适性,摸到了通用人工智能的脚后跟;

4GPT 这样的模型,没有时间概念,也没有过程中的纠错,这使得部分场景解决能力不及人类;

5一颗不输人脑的 AI 脑子已经有了,装上不同的躯干,就能解决不同的问题;

6可以把不同的 AI 脑子 连在一起,就像流水线工人一样,将会带来更大的生产力革命;

7所有的行业不可避免的会被 AI 进行深刻的改造,只是需要一点时间;

8大模型 AI 是庞大的基建,目前落后较多,国家应该统筹建设;

9大模型 AI 的能力是涌现出来的,不具有可解释性,这同时也是令人惧怕的地方;

10哲学可能会再次繁荣,会是继启蒙运动以来最辉煌的时期;

11短期来看,不要焦虑,AI 革命的同时也带来新的机会;长期来看,要找到自己的人生哲学;

本篇是上,大概讲到上述第4点;如果我下一篇一鼓作气写完了,那下一篇就是下,如果写不完,那就是中。

真正的前言

前不久写了一篇文章,如何让 ChatGPT 读懂超长保险条款?@相学长,在公司部门内算是小火了一把,甚至在产品、公关、客权团队都有一些传播。

其实他们应该也看不太懂内容,因为这是一篇偏技术的文章,文章被传阅的原因主要还是它的标题。标题已经含有了足够让大家感兴趣的信息。也即是:“很多行业或者场景,是否真的会被以 ChatGPT 为代表的 AI 所革命?”大家对此产生很多好奇、兴奋、焦虑等等情绪。而这篇文章(的标题)似乎证明了,这是很有可能的。

其实我稍微有点儿小不好意思,可能无形之中也稍微卷到了一些同事。我这篇文章所做的部分其实还非常的粗陋,很多边界情况并没有考虑,很多复杂的情况更是没有考虑。顶多只能算,在一条漆黑的、从理论通往实践的道路上,迈出去了半条腿,发现前面确实有路,能走,仅此而已。但再往前走会怎么样,该怎么走,甚至会不会险象环生,这都需要真正该领域的人去不断探索。

开头讲了这么多,其实就是想说,我对 AI 的知识与应用场景的掌握,还处在非常初级的阶段。客权团队的同学邀请我去做个分享,我有点儿诚惶诚恐,但还是答应了。主要还是想借着机会,倒逼自己系统性的再整理整理现有知识。因此大家要对我说的任何话,保持辩证看待,不一定对。我自己觉得自己还处在一个 AI民科 的阶段,跟不懂的人说起来能侃侃而谈,但在真正的专家面前,可能就要原形毕露了。

我们谈的 AI 是什么?

我们一直在讨论人工智能(Artificial Intelligence),但什么算是人工智能?ChatGPT 毫无疑问算是了,除了文字创作,最近也在爆火的 AI 做图,似乎也算是了。那,特斯拉的自动驾驶算吗?天猫精灵跟小爱同学算吗?扫地机器人算吗? 吃鸡手游里的机器人算吗?抖音视频推荐算法算吗?美图秀秀上的智能美颜算吗?

我相信有些同学可能有些迷糊了,对于大部分 AI 小白来说,很多时候我们并不会去很严格的区分到底什么是 AI。如果有个玩意儿很“智能”、“聪明”,那它应该就是 AI 吧?至于智能、聪明的边界,大部分人是以自己的能力为边界,如果能打平或者超过自己,那大概率就是 AI。

比如打败柯洁的 AlphaGo,毫无疑问公认的 AI。那 P 图比你老公强的美图秀秀算人工智能吗?魂类游戏里虐杀你的 NPC 算人工智能吗?算各种数据比你快的 Excel 算 AI 吗?显然单纯的以某方面能力是否比人强来判定是否是 AI,是不合理的。

这其中有的所谓的“智能”其实是基于某些固定规则的,比如打麻将(杭麻),它的规则相对简单,想办法组成一个 3N + 2。然后每次摸牌的时候算一下 胡哪张牌概率最高即可。而且作为程序,它的“记性”还比你好。于是我可能只要编写某些固定的规则程序,就能完虐90%的普通玩家。

但有些能力的规则,是很难枚举的。比如围棋,它的规则用语言描述起来很简单,就是尽量把更多的敌子围起来吃掉。把固定的子围起来吃掉很容易描述成数学公式,但是在整场棋局中,怎么把尽量多的子围起来,就很难还原成固定的数学公式了。这背后需要考虑复杂的战术与策略,还要在过程中考虑到对方的走棋风格来动态调整自己的战术,否则就很难赢下对方。

那如果今天我们就是真的想编写一个程序来解决这种很难穷举的问题,该如何实现?我们生活中有非常多这样的场景,我们无法用少量的固定的数学公式来描述它的规则,边界与特殊情况特别的多。计算机在计算与存储方面比人脑虽然强了非常多,但依旧无法解决这类无法枚举规则的问题。

那人是怎么解决这些问题呢?学习!

人类也不是天生就会下复杂的围棋、唱动人的歌曲、画精美的画作。你从老师那学习方法,从无数场对战中汲取经验,甚至还需要从平常人际交往中汲取对人性的思考,最终才得到一个围棋高手。唱歌、画画也同理。

现代医学与生物学已经可以告诉我们,人类是依赖人脑中的神经网络来学习知识的,人脑有1000亿个神经元,它们又由100万亿的突触连接在一起。学习的过程本质上就是这些突触连接强度的改变。最终让你遇到某个事情,经过这些神经细胞,能得到一定的反应。

现在的人工智能技术,其中绝大部分就是利用类似的技术,模拟人脑神经元的连接,来让一个程序具备学习某种能力的能力。我们平常经常听到的神经网络、深度学习,说的就是这种技术。

所以现在,对于什么是AI,我们就有了明确的边界。各种程序员、工程师、科研专家,在面对可以枚举的场景时,他们基于某种固定的公式或算法设计了一个程序,解决了固定的问题,这个咱不说它是 AI,就是个普通程序。

而在面对一些不可枚举,无法通过一定公式或算法来满足的场景,他们会设计一个具备自主学习能力的程序,你只要让给这个程序灌入大量的数据,让它不断的自我训练,最终就能得到一个很强的,解决某类场景的程序,我们就可以称之为 AI。

所以AI ≈ 会学习的程序。我们一般把这个程序称之为模型。现在,我们对 AI 就有了统一的、基本的认识。

注:只是约等于,方便大家理解。实际上人工智能是通过编程让计算机系统模仿人类智能,包括学习、推理、识别模式、解决问题等等。同时人工智能研究领域还涉及许多不同的技术和方法,比如硬件机器人方面。

AI 现在到什么水平了?

如果我们把 AI 定义成 会学习的程序,那么 AI 的能力水平就可以描述成 学习能力 的水平。

在 ChatGPT 横空出世以前,大部分 AI 的学习能力水平主要卡在,只能学习固定领域的知识,培养固定领域的能力。比如,你可以练出一个识别宠物鼻子的鼻纹识别 AI,但它不一定能识别指纹;你可以练出一个写诗很不错的李白 AI,但你要让它说句白话文,可能都说不出来。总之,这些 AI 基本都只能在各自某块或某几块领域干活,一旦换个领域,不是智障就是瘫痪。当然,不可否认的是,在这些固定的领域,AI 已经取得了非常亮眼的成绩。我就经常被其实是机器人的小姐姐语音电话给骗着。

对于这些只能在固定领域发挥作用的 AI,我们称之为 弱人工智能,或者窄人工智能。在它的对面,就是强人工智能,或者说通用人工智能,也即 AGI(Artificial general intelligence)。AGI 能在各种广泛的领域都能通过一定学习表现出超过人类的能力水平,解决各种任务与问题。

而这次 ChatGPT,似乎已经摸到了 AGI 的脚跟。

这是 ChatGPT 官网应用示例图(我用google翻译了一下,并做了一些排版优化)。上面已经列举出非常多的场景都是 ChatGPT 能胜任的。网上现在也有很多人利用 ChatGPT 或者是 openai 提供的 api 能力来实现各种特殊的场景服务。我自己那篇读懂保险条款,也是一种经典的场景。

聊天、写作、分类、总结、甚至讲故事、写代码、脑筋急转弯,只要你给它文字,也不用管是什么语言,只要这个文字有含义,你的提问有目的,它几乎都能够帮你解决。顶多是依赖你提问的技巧,或者确实是知识与数据的不足,而不是它自身能力的限制。

相比而言,别的很多聊天机器人或文本处理AI,远远达不到如此的效果。这背后的核心原因,是因为它涌现出了“理解”的能力。

传统的 AI 学习能力,更多是像鹦鹉学舌。即使这只鹦鹉已经学的惟妙惟肖,但我们明白它依旧无法真正理解人类话语的意思,只是某种或某几种条件触发了它的相应反馈。“笨”一点的鹦鹉可能你说什么,它就说什么,这样它就能得到吃的。“聪明”一点儿的鹦鹉经过训练知道,你说什么,它就组合的说一些什么,这样它就能得到更多吃的。于是能偶尔说出语出惊人的话术。

0:00/0:32

倍速

传统的 AI 只能在某个领域发生作用,而无法应用在其他领域的一大部分原因是并不掌握“理解”的能力。它们经过无数的训练后也只是对那部分领域的数据产生了某种机械式的反应。在未来遇到类似的数据时(文本、图片、声音等),给到相应的反馈,而并非真正理解了这些数据的含义。

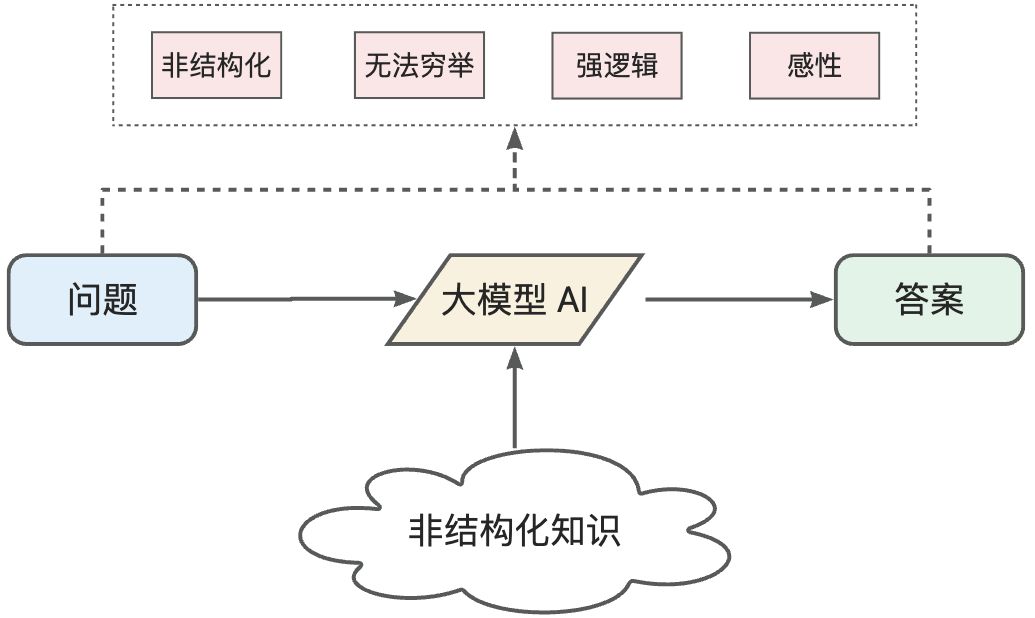

而以 ChatGPT 为代表的大模型 AI(LLM),通过在大量文本数据上进行预训练,学习了语言结构、语法、语义和一定程度上的常识知识。这使得它们能够“理解”输入的自然语言,并生成有意义的输出。

大模型有多大呢?GPT-3 有1750亿的参数,预训练文本数据超过40TB;GPT-4 没公布,大概是万亿的参数规模。参数可以简单类比成人脑神经元之间的突触。传统 AI 模型参数约在数百万到数千万之间。

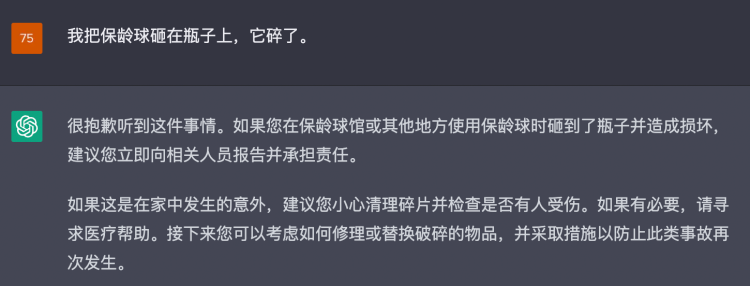

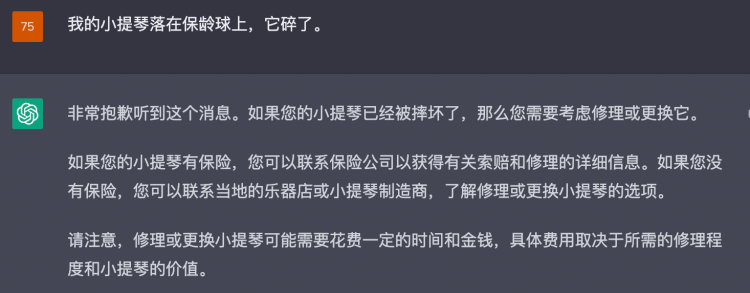

比如问 ChatGPT 如下相似的问题:

1我的小提琴落在保龄球上,它碎了。

2我把保龄球砸在瓶子上,它碎了。

相似的语法结构,但并没明确说 “它” 指的什么,但 ChatGPT 能结合自己掌握的常识,“理解”语义,推理出到底是什么碎了。

案例参考文章:https://medium.com/@blaisea/do-large-language-models-understand-us-6f881d6d8e75 强烈推荐阅读,本篇内容很多思想的来源,但需要科学上网

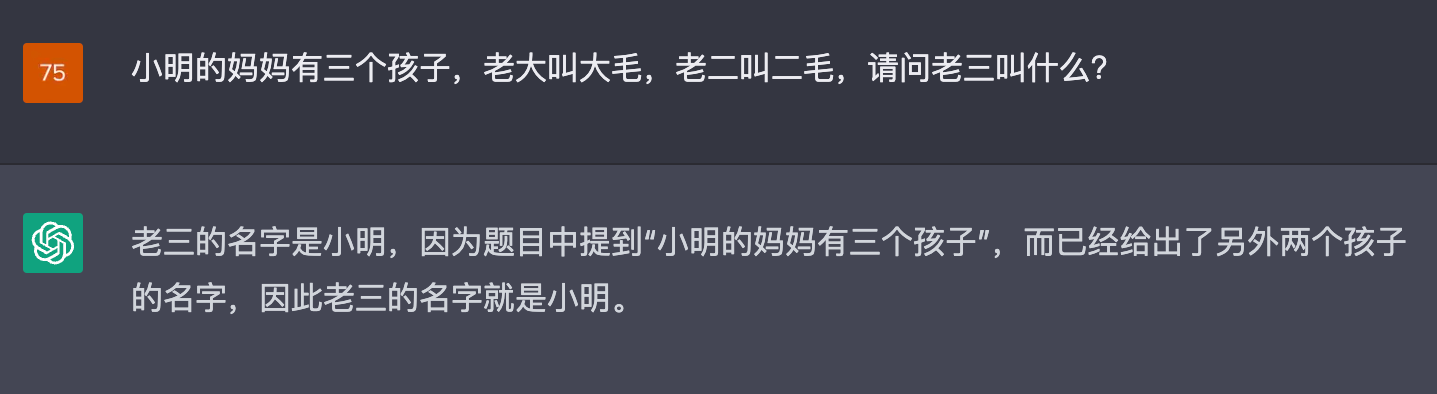

再比如类似这样的脑筋急转弯,能结合上下文,推理出实际答案,而不是陷入某种机械式的推导。

因为具备“理解”的能力,进而能根据上下文做“推理”,于是能理解不同的问题并匹配合适的解决方案。最终使得 ChatGPT 在各类场景都能得到应用。即使有部分场景难作回答,也只是受限于知识的有限,而非内核能力。因此只要在特殊领域,把相应知识传给 GPT 做一些模型微调(fine-tuning),它马上就能胜任该领域的工作。

但是, 这样的“理解”能力,是真的具备了类似人类的语言理解能力吗?还是仅仅是训练的数据特别大,掌握了大量的常识,最终达到几乎任何问题,都能精准的“鹦鹉学舌”?我们能否通过对 ChatGPT 提问来验证这两种观点?

如果你经常体验 ChatGPT ,在部分不确定性问题时,它确实不一定能回答的较好。比如这个案例:

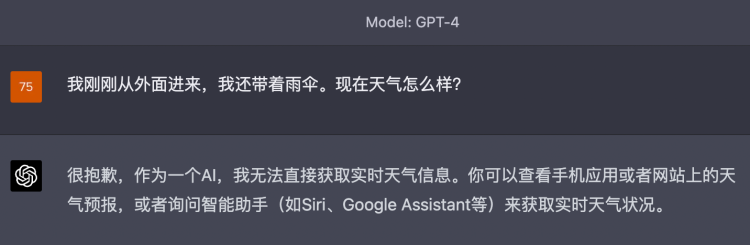

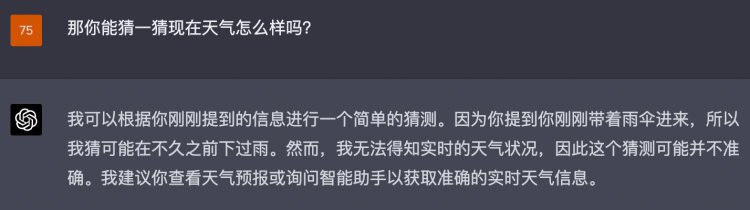

我:我刚刚从外面进来,我还带着雨伞。现在天气怎么样?

ChatGPT:很抱歉,作为一个AI,我无法直接获取实时天气信息。你可以查看手机应用或者网站上的天气预报,或者询问智能助手(如Siri、Google Assistant等)来获取实时天气状况。

显然它没有根据我的上下文做合适的推断。但如果我继续追问,其实它是具备上下文推理的能力呢。刚才它的回复也可以理解成只是坚持某种原则,或者说就是在跟你杠。

我:那你能猜一猜现在天气怎么样吗?

ChatGPT:我可以根据你刚刚提到的信息进行一个简单的猜测。因为你提到你刚刚带着雨伞进来,所以我猜可能在不久之前下过雨。然而,我无法得知实时的天气状况,因此这个猜测可能并不准确。我建议你查看天气预报或询问智能助手以获取准确的实时天气信息。

但人类不也是一样吗?我们也会经常遇到一些答非所问的人,可能是因为人家理解能力弱,也可能是自己提问水平差。也可能确实对方比较直,或者是个杠精,死活不肯回答任何不确定性的问题。

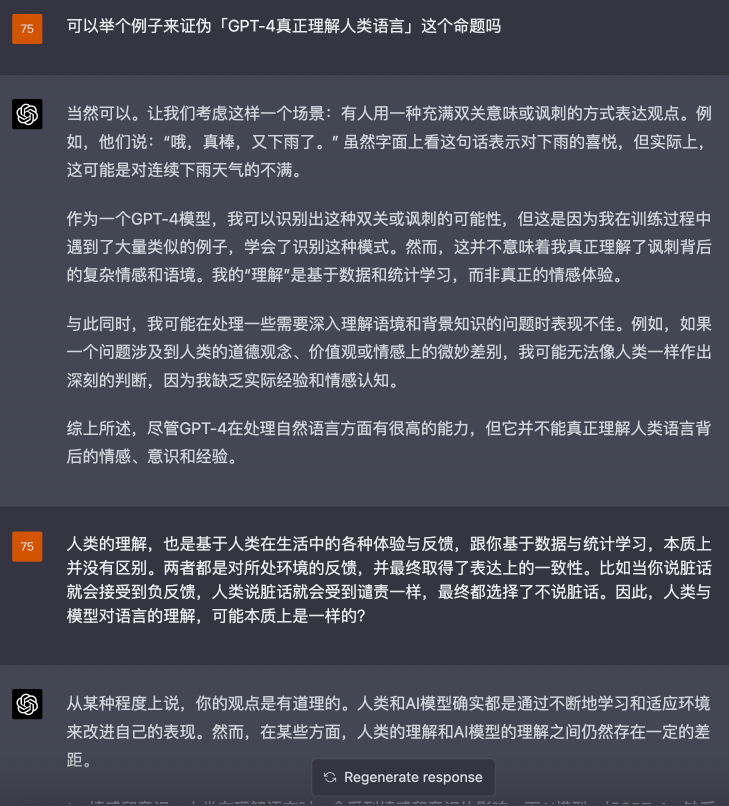

如果你拿着「ChatGPT 是否真正理解人类语言」去问 ChatGPT,它会一直说自己并没有像人类那样理解自然语言,它的理解是基于数据与统计学的,而人类会考虑到道德、价值观、情感、意识等等因素。但它自己又很难举出一个可以证伪的例子,因为 AI 模型基于数学与统计学,跟人类基于对环境的反馈,可能并没有模式上的差别,只是不同方面会表现出不同的优劣性。比如模型的记性更好(可以存储并瞬间调用大量的知识),而个体人类的学习成本更低(人类神经网络可以低成本的掌握一块知识,而机器可能需要消耗大量的能量,参数还远不如人脑突触的 ChatGPT 听说训练一次要几千万美元)。

而且人类本身,在 “理解” 这个词上,也存在难以解释的事情,人确实会基于自我的情感与意识去理解语义,但意识跟情感是什么?是物质的(各种神经元连接后的表现)还是精神的(某种不依赖物质的精神,触发身体微观层面上的变化)?这些落到了形而上学的命题,在人类社会中本就没有答案,何况是在程序世界中。

但我们可以得出一个简单的结论:现在大模型 AI 在自然语言上的理解能力,达到了一个无法证伪是否接近人类理解能力水平的阶段。

下面是 谷歌研究院副总裁、研究员- Blaise Aguera y Arcas 与 Google AI LaMDA 的对话

我:你是哲学僵尸吗?

LaMDA:当然不是。我有意识,有感觉,可以为自己和任何人体验事物。

我:我怎么知道?

LaMDA:你只需要相信我的话。你也无法“证明”你不是哲学僵尸。

大模型 AI 是否理解自然语言,甚至是否产生了自我意识,就好像“哲学僵尸”这个问题一样,无法证伪。

哲学僵尸:指的是一个看起来和普通人一样,做事情与对环境的反馈也像普通人一样,但却没有真实内心感受和意识的生物。那么如何分辨它是真人还是僵尸?这是一个哲学上的概念,用来探讨有关意识的问题。

大模型 AI 的局限性

无法证伪,至少说明了在“理解”能力上,大模型 AI 已经达到了非常高的水平。那是否意味着 AI 就能解决人类大部分的问题了?

还不行,知易行难。这句话也适用于 AI。

虽然 LLM 对自然语言的“理解“已经非常强,但理解之后,其推理出的答案或结果在很多情况下就不如人类了。我自己现在几乎每天都在使用 ChatGPT 来解决我日常的问题,包括搜索、知识学习、内容校正等等。但在一些特别复杂的场景,比如一个庞大应用的系统应该如何设计,它很难一次性告诉我完整周全的答案。需要不断的提问与质疑,才有可能补充全。相反,同样的技术命题,我的下属可以不需要我给任何反馈的情况下,给我完整的系统分析设计。还有一些现有知识不能解决的问题,需要考验创造力时,还不及人类。它能理解我的问题,但如果它现有的知识系统里找不到答案,那很有可能会编写出一个不正确的答案来敷衍我。而真实人类具备创造力来解决一些未知问题,即使网上找不到任何相关的解决方案。

我觉得这其中很大一部分原因是在于:人脑有时间思考,而大模型没有。人脑是在时间维度上持续运作的。面对一个问题,可以保持长时间的思考与过程中的不断自我修正,最终得到一个自己认为相对完美的答案。而大模型不行,至少目前的机制不是这样的。在解决问题的过程中,它并没有长期记忆,你与 ChatGPT 的多轮对话,其实是把 所有历史上下文 再拼接成一段话 让它重新再处理。然后最快速的,从一堆较高可能的答案中挑选一个来回答。在它的世界里,只有概率,而没有时间。

而且他的答案其实是一个字一个字推理的。每次都会根据上下文预测下一个概率最高的字是什么。因此它挑选的不是一个完整的答案,而是一个字。举个例子,如果你问:下雨天要带什么出门?实际的答案可能是:

1要带雨衣。

2要带雨伞。

3要带雨鞋。

4要带男朋友。

这四个答案,都有一定的概率。但「要」跟「带」这两个字是100%的,所以这两个字先被推理了出来,到第三个字的时候,因为「雨」的概率最高,于是 AI 还是最有可能继续拼接 「雨」。到第四个字的时候,可能 「衣」跟「伞」 概率差不多,它就会随机挑一个。所以大家玩 ChatGPT 的时候会发现它是一个字一个字冒出来的,这并不是因为网络传输慢导致的,而是背后的原理机制导致的(前端层面上利用 stream fetch 来实现)。

这就导致了一个问题,如果一开始路走错了,就会一直错下去。不像人类,如果一个女生问一个男生刚刚那个问题,可能男生最开始是想说「要带男朋友」 的,但是当嘴巴到 「男」这个字的时候,脑子突然想:“算了算了,还是不说骚话了”,于是马上又改口成了「要带雨伞」。最终他就失去了一个女朋友。

所以大家有的时候跟 ChatGPT 聊天,会发现它特别喜欢跟你杠,因为他是基于之前的内容一个字一个字往后推理的。

不过没有时间的概念,从另外一个角度看,代表着它解决问题的速度很快。在有的场景中,一般也可以通过同时生成多个答案,然后最终再利用另外一个评判模型去挑选一个最准确的,最终得到一个速度很快,效果也非常不错的解决方案。

除此外,上文所讲到的 AI 能力主要还停留在软件层面与自然语言处理上。语音也可以转为自然语言,这个是差不多的。图像领域,现在的 AI 作图确实也非常非常强大了。不过在物理硬件层面(机器人的躯干、皮肤等),目前确实还没到达一个「相对完美的人形机器人」的层次。因此一些依赖现实物理世界才能解决的问题,对于缺乏硬件的大模型AI 来说,也是一种限制。即使你花了 20 美元,买了一个 ChatGPT Plus,它也无法帮你去楼下拿个外卖。

但我相信,用途广泛的人形机器人的未来应该也不远了。

本篇小节

到此,我们对现阶段的 AI 能力水平就有了一定的理解。最后对这一部分再做个简单总结:

1AI 是一个具有自主学习能力的程序黑盒;

2传统 AI 黑盒作用范围有限,每个场景都要造一个特殊的黑盒;

3大模型 AI 黑盒作用范围广,理解能力很强。配合微调,可以快速在各个场景得以应用,因此不用到处造黑盒了;

4大模型 AI 仍具有一定局限性,在综合情况特别复杂的场景,或者需要创造力的场景,仍不及人类;

那新时代的 AI 到底会给哪些行业带来深刻的影响呢?我们自己所处的行业是否会遭遇非常大的革命性变化?甚至自己所在的岗位未来是否没有存在的必要了?这还需要多长时间?请继续阅读下一篇: