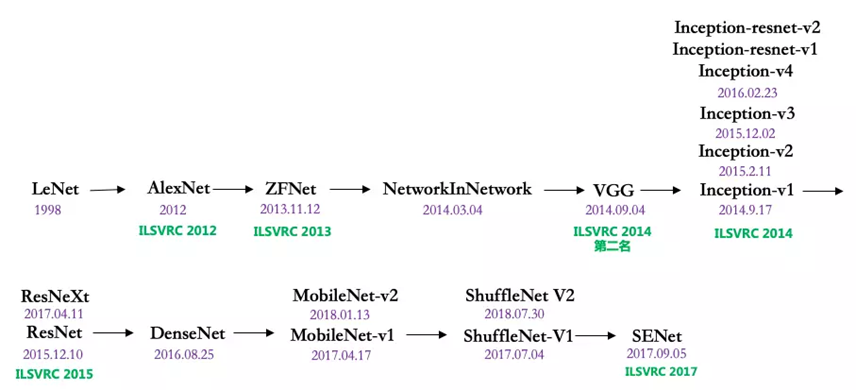

【經典算法必讀】圖片分類

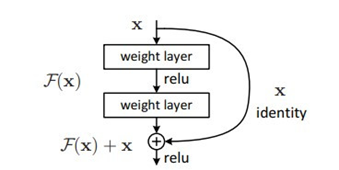

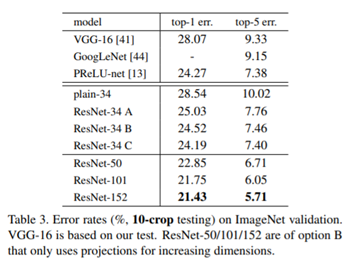

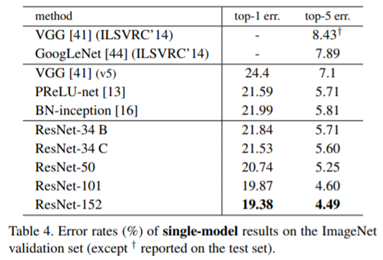

ResNet

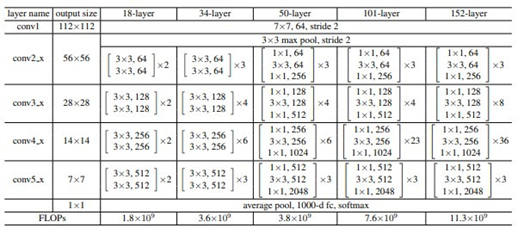

架構圖:(左)

特性:利用恆等映射,增加網路層數,但訓練誤差不增加。

核心理念:殘差塊使用bottleneck形式(右),將一個3x3卷積核拆分成一組(1x1,3x3,1x1)卷積核,可減少模型參數使用量。

優點:

1.ResNet在VGG的基礎上,新增直連通路(skip connection),不會新增任何參數,

但是可以解決梯度消失的問題

2.直連通路與卷積層進行元素點(element-wise)相加,而非直接連接。

3.這使某一層模型只需要學習輸入與輸出之間的殘差(residual),大幅度降低了模型學習的難度。

ResNet保障了深度神經網路的可訓練性,並且在深度模型上也可以避免使用過多參數量。

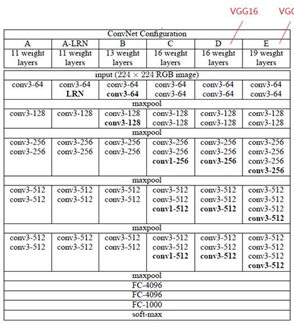

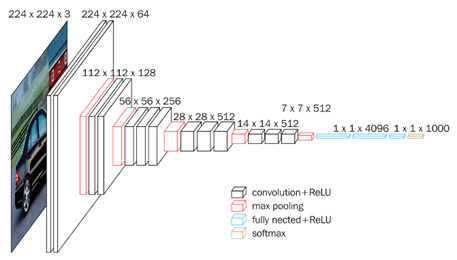

VGGNet

架構圖:

特性:使用小卷積核,增加非線性映射,能夠很好減少參數。

核心理念:保证具有相同感知野的条件下,提升了网络的深度,在一定程度上提升了神经网络的效果。

優點:

1. VGGNet的结构非常简洁,整个网络都使用了同样大小的卷积核尺寸(3x3)和最大池化尺寸(2x2)。

2. 几个小滤波器(3x3)卷积层的组合比一个大滤波器(5x5或7x7)卷积层好:

3. 验证了通过不断加深网络结构可以提升性能。

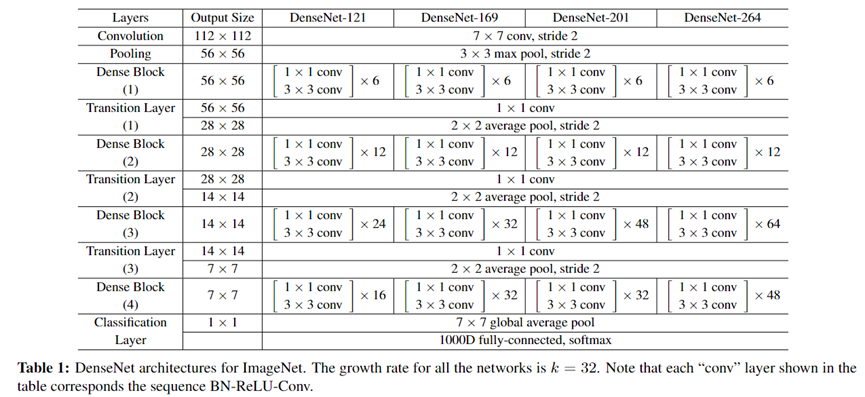

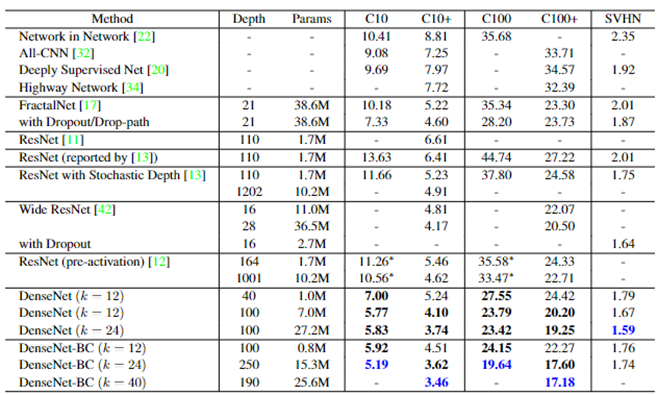

DenseNet

核心理念:DenseNet采用的是一种更密集的连接方式,是一个密集卷积神经网络,以前向传播方式,将每一层与其余层密集连接。这样做的目的是可以确保各层之间的信息流动达到最大,将所有层(特征图大小匹配)直接连接在一起

【Densely Connected Convolutional Networks】

SENet

【Squeeze-and-Excitation Networks】

SE block并不是一个完整的网络结构,而是一个子结构,可以嵌入到其他分类或检测模型中。

核心思想:通过网络根据 loss 去学习特征权重,使得有效的 feature map 权重大,无效或效果小的 feature map 权重小的方式训练模型达到更好的结果。