虚拟机:VirtualBox

- virtaulbox host-only的IP地址:192.168.137.1

- 所用系统:CentOS7

- 真实web服务器(RS1):192.168.137.5

- 真实web服务器(RS2):192.168.137.6

- Master负载均衡服务器:192.168.137.101

- backup负载均衡服务器:192.168.137.102

- 系统对外虚拟IP:192.168.137.100

二、RS的配置过程

两台RS所用Web服务器均为nginx

2.1 静态IP设置

(1)编辑配置文件

$ vim /etc/sysconfig/network-scripts/ifcfg-enp0s3

我这里叫enp0s3,也可能是其他名字,只是一个网卡代号而已

需要修改如下内容

BOOTPROTO=static(使用静态IP)

ONBOOT=yes(开机启动)

需要新增如下内容

IPADDR=192.168.137.5

NETMASK=255.255.255.0

GATEWAY=192.168.137.1

DNS1=192.168.137.1

(2)重启网络服务

$ service network restart

2.2 nginx的安装与部署

(1)下载nginx的安装包,我用的是nginx-1.10.1,放在/opt目录

(2)安装必备工具

$ yum -y install gcc gcc-c++ autoconf automake

$ yum -y install zlib zlib-devel openssl openssl-devel pcre-devel

说明:

pcre: 用来作地址重写的功能。

zlib:nginx 的gzip模块,传输数据打包,省流量(但消耗资源)。

openssl:提供ssl加密协议。

(3)安装nginx

$ cd /opt

$ tar -zxvf nginx-1.10.1.tar.gz

$cd nginx-1.10.1

$ ./configure –prefix=/usr/local/nginx

$ make

$ make install

(4)修改nginx默认访问页面内容

$ vim /usr/local/nginx/html/index.html

把内容修改为RS1,为了方便一会测试负载均衡时,能清晰看到是哪台服务器

(5)开放80端口

$ /sbin/iptables -I INPUT -p tcp –dport 80 -j ACCEPT

现在,访问192.168.137.5就可以看到显示RS1了,同理设置RS2

三、负载均衡服务器配置

CentOS7已经集成了LVS的核心,所以只需要安装LVS的管理工具就可以了

(1)安装ipvsadm

$ yum -y install ipvsadm

(2)设置ipv4转发

$ sysctl -w net.ipv4.ip_forward=1

(3)关闭防火墙

iptables -F

(4)设置ipvsadm

$ ipvsadm -A -t 192.168.137.101:80 -s rr

$ ipvsadm -a -t 192.168.137.101:80 -r 192.168.137.5 -m

$ ipvsadm -a -t 192.168.137.101:80 -r 192.168.137.6 -m

$ ipvsadm -S

-A 添加虚拟服务

-a 添加一个真是的主机到虚拟服务

-S 保存

-s 选择调度方法

rr 轮训调度

-m 网络地址转换NAT

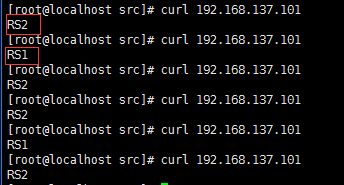

(5)测试

curl 192.168.137.101

三、Keepalived的安装配置过程

两台负载均衡服务器上均需要安装、配置Keepalived

3.1 安装Keepalived

$ yum -y install keepalived

3.2 配置Keepalived

$ vim /etc/keepalived/keepalived.conf

配置信息如下

! Configuration File for keepalived

global_defs {

notification_email {

acassen@firewall.loc #设置报警邮件地址,可以设置多个,每行一个。

failover@firewall.loc #需开启本机的sendmail服务

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc #设置邮件的发送地址

smtp_server 127.0.0.1 #设置smtp server地址

smtp_connect_timeout 30 #设置连接smtp server的超时时间

router_id LVS_DEVEL #表示运行keepalived服务器的一个标识。发邮件时显示在邮件主题的信息

}

vrrp_instance VI_1 {

state MASTER #指定keepalived的角色,MASTER表示此主机是主服务器,BACKUP表示此主机是备用服务器

interface enp0s3 #指定HA监测网络的接口

virtual_router_id 51 #虚拟路由标识,这个标识是一个数字,同一个vrrp实例使用唯一的标识。即同一vrrp_instance下,MASTER和BACKUP必须是一致的

priority 100 #定义优先级,数字越大,优先级越高,在同一个vrrp_instance下,MASTER的优先级必须大于BACKUP的优先级

advert_int 1 #设定MASTER与BACKUP负载均衡器之间同步检查的时间间隔,单位是秒

authentication { #设置验证类型和密码

auth_type PASS #设置验证类型,主要有PASS和AH两种

auth_pass 1111 #设置验证密码,在同一个vrrp_instance下,MASTER与BACKUP必须使用相同的密码才能正常通信

}

virtual_ipaddress { #设置虚拟IP地址,可以设置多个虚拟IP地址,每行一个

192.168.137.100

}

}

virtual_server 192.168.137.100 80 { #设置虚拟服务器,需要指定虚拟IP地址和服务端口,IP与端口之间用空格隔开

delay_loop 6 #设置运行情况检查时间,单位是秒

lb_algo rr #设置负载调度算法,这里设置为rr,即轮询算法

lb_kind DR #设置LVS实现负载均衡的机制,有NAT、TUN、DR三个模式可选

nat_mask 255.255.255.0

persistence_timeout 0 #会话保持时间,单位是秒。这个选项对动态网页是非常有用的,为集群系统中的session共享提供了一个很好的解决方案。

#有了这个会话保持功能,用户的请求会被一直分发到某个服务节点,直到超过这个会话的保持时间。

#需要注意的是,这个会话保持时间是最大无响应超时时间,也就是说,用户在操作动态页面时,如果50秒内没有执行任何操作

#那么接下来的操作会被分发到另外的节点,但是如果用户一直在操作动态页面,则不受50秒的时间限制

protocol TCP #指定转发协议类型,有TCP和UDP两种

real_server 192.168.137.5 80 { #配置服务节点1,需要指定real server的真实IP地址和端口,IP与端口之间用空格隔开

weight 1 #配置服务节点的权值,权值大小用数字表示,数字越大,权值越高,设置权值大小可以为不同性能的服务器

#分配不同的负载,可以为性能高的服务器设置较高的权值,而为性能较低的服务器设置相对较低的权值,这样才能合理地利用和分配系统资源

TCP_CHECK { #realserver的状态检测设置部分,单位是秒

connect_timeout 3 #表示3秒无响应超时

nb_get_retry 3 #表示重试次数

delay_before_retry 3 #表示重试间隔

connect_port 8066

}

}

real_server 192.168.137.6 80 {

weight 1

TCP_CHECK {

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

connect_port 8066

}

}

}

要注意的地方:

- interface enp0s3:这里的enp0s3是我的网卡名称,想要查看自己网卡名称的话,在/etc/sysconfig/network-scripts/ifcfg-e(敲下TAB)

- persistence_timeout 0:指的是在一定的时间内来自同一IP的连接将会被转发到同一realserver中。而不是严格意义上的轮询。默认为50s,因此在测试负载均衡是否可以正常轮询时,最好先把值设置为0,方便查看

- TCP_CHECK { :注意TCK_CHECK和 {之间有一个空格,忘记打这个空格的话,可能会出现后面用ipvsadm查看时,某个RS查看不到

另外一个台备用服务器上Keepavlied的配置类似,只是把MASTER改为backup,把priority设置为比MASTER低

3.3 两台RS上为lo:0绑定VIP地址、抑制ARP广播

在两台RS上编写以下脚本文件realserver.sh

!/bin/bash

#description: Config realserver

VIP=192.168.137.100

/etc/rc.d/init.d/functions

case “$1” in

start)

/sbin/ifconfig lo:0 $VIP netmask 255.255.255.255 broadcast $VIP

/sbin/route add -host $VIP dev lo:0

echo “1” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “1” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “2” >/proc/sys/net/ipv4/conf/all/arp_announce

sysctl -p >/dev/null 2>&1

echo “RealServer Start OK”

;;

stop)

/sbin/ifconfig lo:0 down

/sbin/route del $VIP >/dev/null 2>&1

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/lo/arp_announce

echo “0” >/proc/sys/net/ipv4/conf/all/arp_ignore

echo “0” >/proc/sys/net/ipv4/conf/all/arp_announce

echo “RealServer Stoped”

;;

*)

echo “Usage: $0 {start|stop}”

exit 1

esac

exit 0

在两台RS上分别执行脚本

$ sh realserver.sh start

3.4 启用Keepavlied

$ service keepalived start

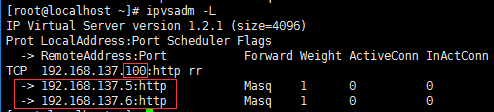

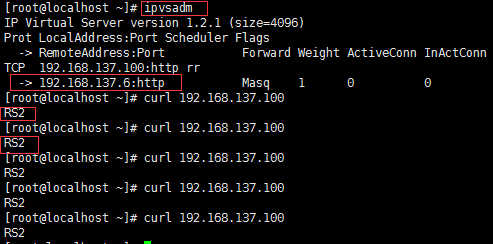

之后通过ipvsadm -L命令可以查看VIP是否已经成功映射到两台RS,如果发现有问题,

可以通过/var/log/message查看错误原因

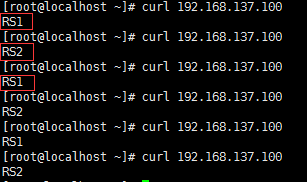

接下来就可以测试可用性了

3.4.1 测试负载均衡

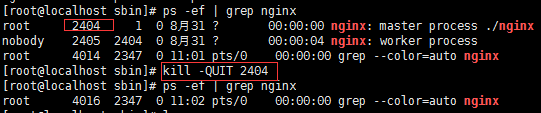

3.4.2测试keepalived的监控检测

停掉RS1的nginx,然后在MASTER负载均衡服务器上可以到看VIP映射关系中已经剔除了192.168.137.5

(1)停掉RS1的nginx

(2)查看VIP映射关系

四、nginx+lua部署——————————- ——————————- ——————————- ——————————- ——————————- ——————————- ——————————- ——————————- ——————————- ——————————- ——————————-

(1)部署openresty

OpenResty (也称为 ngx_openresty)是一个全功能的 Web 应用服务器。它打包了标准的 Nginx 核心,很多的常用的第三方模块,以及它们的大多数依赖项。http://openresty.org/cn/index.html

mkdir -p /usr/servers

cd /usr/servers/

yum install -y readline-devel pcre-devel openssl-devel gcc

wget http://openresty.org/download/ngx_openresty-1.7.7.2.tar.gz

tar -xzvf ngx_openresty-1.7.7.2.tar.gz

cd /usr/servers/ngx_openresty-1.7.7.2/

cd bundle/LuaJIT-2.1-20150120/

make clean && make && make install

ln -sf luajit-2.1.0-alpha /usr/local/bin/luajit

cd bundle

wget https://github.com/FRiCKLE/ngx_cache_purge/archive/2.3.tar.gz

tar -xvf 2.3.tar.gz

cd bundle

wget https://github.com/yaoweibin/nginx_upstream_check_module/archive/v0.3.0.tar.gz

tar -xvf v0.3.0.tar.gz

cd /usr/servers/ngx_openresty-1.7.7.2

./configure —prefix=/usr/servers —with-http_realip_module —with-pcre —with-luajit —add-module=./bundle/ngx_cache_purge-2.3/ —add-module=./bundle/nginx_upstream_check_module-0.3.0/ -j2

make && make install

cd /usr/servers/

ll

/usr/servers/luajit

/usr/servers/lualib

/usr/servers/nginx

/usr/servers/nginx/sbin/nginx -V

启动nginx: /usr/servers/nginx/sbin/nginx

(2)nginx+lua开发的hello world

vi /usr/servers/nginx/conf/nginx.conf

在http部分添加:

lua_package_path “/usr/servers/lualib/?.lua;;”;

lua_package_cpath “/usr/servers/lualib/?.so;;”;

/usr/servers/nginx/conf下,创建一个lua.conf

server {

listen 80;

servername ;

}

在nginx.conf的http部分添加:

include lua.conf;

验证配置是否正确:

/usr/servers/nginx/sbin/nginx -t

在lua.conf的server部分添加:

location /lua {

default_type ‘text/html’;

content_by_lua ‘ngx.say(“hello world”)’;

}

/usr/servers/nginx/sbin/nginx -t

重新nginx加载配置

/usr/servers/nginx/sbin/nginx -s reload

访问http: http://192.168.31.187/lua

vi /usr/servers/nginx/conf/lua/test.lua

ngx.say(“hello world”);

修改lua.conf

location /lua {

default_type ‘text/html’;

content_by_lua_file conf/lua/test.lua;

}

查看异常日志

tail -f /usr/servers/nginx/logs/error.log

(3)工程化的nginx+lua项目结构

项目工程结构

hello

hello.conf

lua

hello.lua

lualib

.lua

.so

放在/usr/hello目录下

/usr/servers/nginx/conf/nginx.conf

worker_processes 2;

error_log logs/error.log;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type text/html;

lua_package_path “/usr/hello/lualib/?.lua;;”;

lua_package_cpath “/usr/hello/lualib/?.so;;”;

include /usr/hello/hello.conf;

}

/usr/hello/hello.conf

server {

listen 80;

servername ;

location /lua {

default_type ‘text/html’;

lua_code_cache off;

content_by_lua_file /usr/example/lua/test.lua;

}

}