k8s最基本的硬件要求

CPU: 双核

Mem: 2G

3台dockerhost

时间必须同步

docker要先下载好

一.环境准备

分别将3台虚拟机命名,设置好对应IP,并将其写入域名解析/etc/hosts中,关闭防火墙,iptables,禁用selinux。还有要做到,时间必须一致。全部禁用swap

1.给三台docker命名

hostnamectl set-hostname masterhostnamectl set-hostname node1hostnamectl set-hostname node2

2.关闭防火墙及禁用selinux(三台)

systemctl stop firewalld systemctl disable firewalldvim /etc/selinux/configSELINUX=disabled或者setenforce 0sed -i 's/^SELINUX=.*/SELINUX=disabled/' /etc/selinux/config

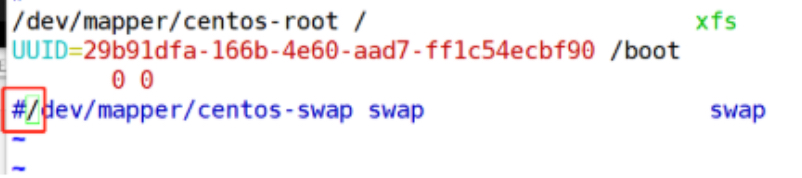

3.禁用swap(三台)

swapoff -a//临时禁用swapvim /etc/fstab

4.添加域名解析(三台)

echo 192.168.128.220 master >> /etc/hostsecho 192.168.128.221 node1 >> /etc/hostsecho 192.168.128.222 node2 >> /etc/hosts

5.做免密登陆(三台)

ssh-keygen -t rsa

复制密钥到其他主机

ssh-copy-id node1ssh-copy-id node2

把域名解析复制到其他主机

scp /etc/hosts node1:/etc

scp /etc/hosts node2:/etc

6. 打开路由转发和iptables桥接功能(三台)

vim /etc/sysctl.d/k8s.conf//开启iptables桥接功能net.bridge.bridge-nf-call-iptables = 1net.bridge.bridge-nf-call-ip6tables = 1echo net.ipv4.ip_forward = 1 >> /etc/sysctl.conf//**打开路由转发------------------------------------------------sysctl -p /etc/sysctl.d/k8s.confsysctl -p如果上面执行失败执行这个modprobe br_netfilter

把路由转发和iptables桥接复制到其他主机

[root@master ~]# scp /etc/sysctl.d/k8s.conf node1:/etc/sysctl.d/[root@master ~]# scp /etc/sysctl.d/k8s.conf node2:/etc/sysctl.d/[root@master ~]# scp /etc/sysctl.conf node2:/etc/[root@master ~]# scp /etc/sysctl.conf node1:/etc/

记得node01和node02也要执行以下命令

sysctl -p /etc/sysctl.d/k8s.confsysctl -p

二.master节点安装部署k8s

1.指定yum安装kubernetes的yum源(三台)

cat <<EOF > /etc/yum.repos.d/kubernetes.repo[kubernetes]name=Kubernetesbaseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/enabled=1gpgcheck=1repo_gpgcheck=1gpgkey=https://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg https://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpgEOF

下载完成之后,查看一下仓库是否可用

yum repolist

出现kubernetes就成功

创建本地缓存(三台)

yum makecache fast

2.各节点安装所需安装包

1).master下载

yum -y install kubeadm-1.15.0-0 kubelet-1.15.0-0 kubectl-1.15.0-0

2).node01和node02下载

yum -y install kubeadm-1.15.0-0 kubelet-1.15.0-0

3).三台主机把 kubelet加入开机自启

systemctl enable kubelet

3.master导入,之前准备好的镜像

或者从docker镜像站下载镜像

docker pull k8s.gcr.io/kube-apiserver:v1.15.1docker pull k8s.gcr.io/kube-controller-manager:v1.15.1docker pull k8s.gcr.io/kube-scheduler:v1.15.1docker pull k8s.gcr.io/kube-proxy:v1.15.1docker pull k8s.gcr.io/pause:3.1docker pull k8s.gcr.io/etcd:3.3.10docker pull coredns/coredns:1.3.1

三.初始化Kubernetes集群

1.执行初始化命令

kubeadm init --kubernetes-version=v1.15.0 --pod-network-cidr=10.244.0.0/16 --service-cidr=10.96.0.0/12 --ignore-preflight-errors=Swap

如果以上的命令报错,找出问题后先重置一下(下面的命令),然后再执行以上命令

kubeadm reset

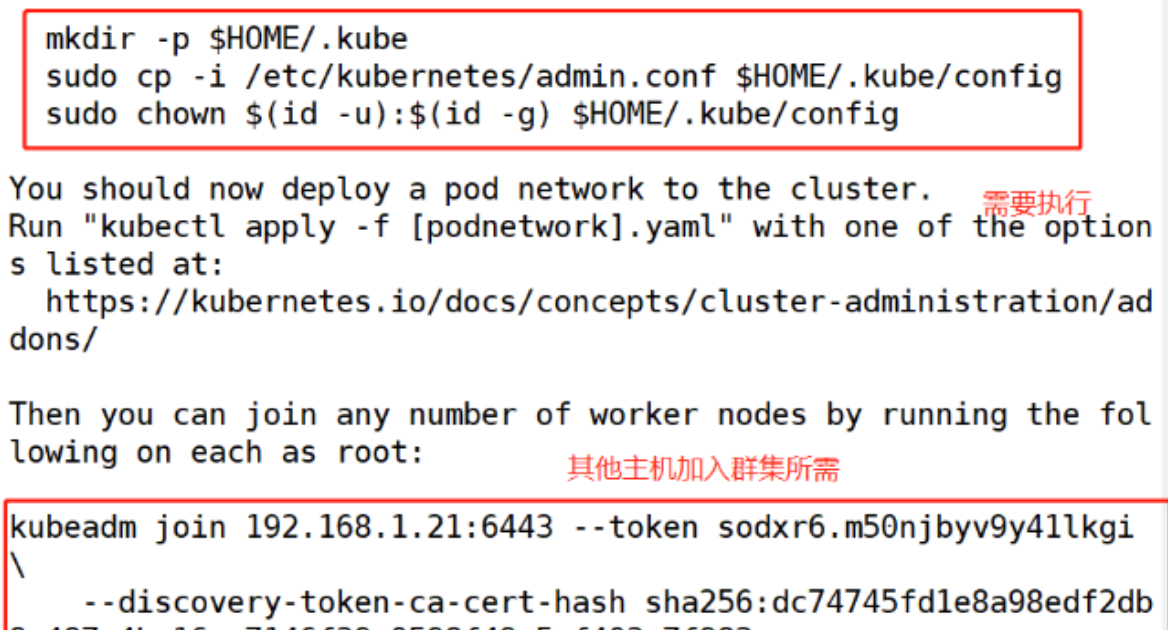

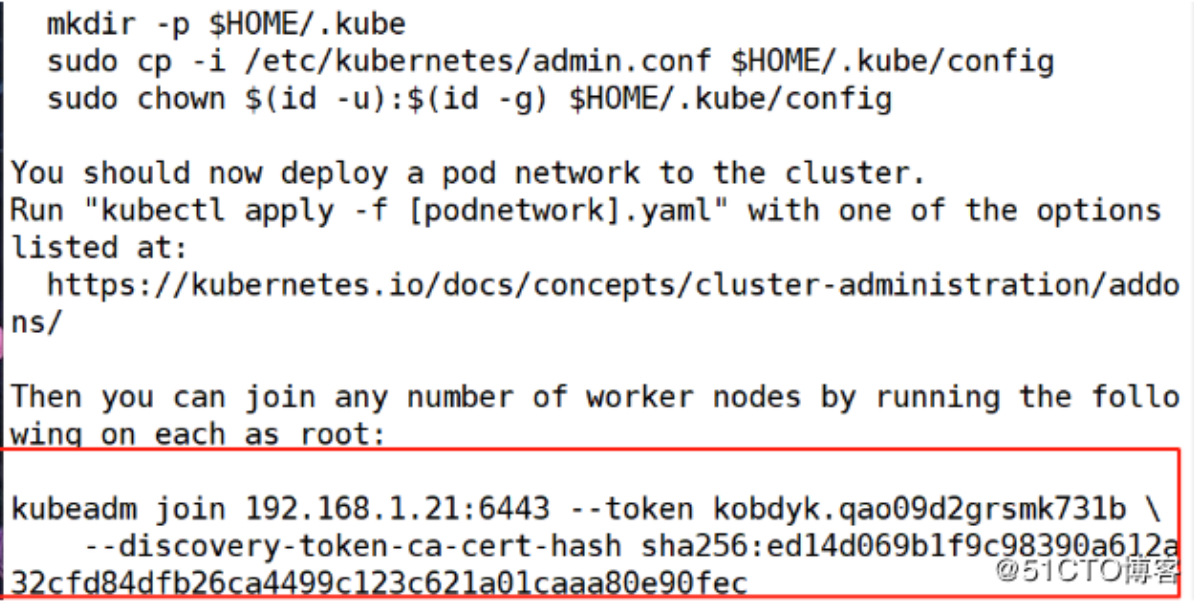

- 按照提示执行命令

- 稍后让node节点加入master

kubectl get node //查看当前节点信息

目前master的状态是未就绪(NotReady),之所以是这种状态是因为还缺少一个附件flannel,没有网络各Pod是无法通信的

可以通过检查组件的健康状态

kubectl get cs

2.添加网络组件(flannel)

1)组件flannel可以通过https://github.com/coreos/flannel中获取

kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

以上只是方式之一,在网络状况良好的情况下建议使用上述方法(调用远端文件执行一下),若网速较差,建议使用以下方法:

2)下载文件,使用kubectl执行

wget https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml#将github官网指定的.yml配置文件下载到本地ls | grep flannel.yml#确定下载到了当前目录 kube-flannel.ymlkubectl apply -f kube-flannel.yml#指定下载的.yml文件执行相应命令

上述方法,二选一进行配置即可

看到很多东西被创建是还不够的,还需要查看flannel是否处于正常启动并运行的状态,才算正在的部署完成

kubectl get pods --all-namespaces//查看所有的名称空间的pod(可以看到flannel网络运行正常)

查看当前节点信息

kubectl get node //查看当前节点信息(已经准备好了)

四. node两台节点,导入镜像并加入群集

1.使用docker pull下载镜像

quay.io/coreos/flannel:v0.15.0(跟随master)k8s.gcr.io/pause:3.1k8s.gcr.io/kube-proxy:v1.15.0

2.node01和node02加入群集

这时使用的命令是初始化群集之后生成的令牌(只有24小时的时效)

3.加入群集之后查看一下

kubectl get node

五.优化部分

已经安装完毕!!!!

以下属于操作优化

1.设置table键的默认间距;

vim .vimrcset tabstop=2

2.设置kubectl命令自动补全

yum -y install bash-completionsource /usr/share/bash-completion/bash_completionsource <(kubectl completion bash)echo "source <(kubectl completion bash)" >> ~/.bashrc

3.确认k8s群集没有问题,并设置为开机自启

master主机操作如下:

kubectl get pod -n kube-system#查看pod资源,类似于docker中的容器,确保返回的信息都是running#“-n kube-system”:是k8s的名称空间

master和node节点上都需要进行以下操作,以便设置为开机自启:

systemctl enable kubeletsystemctl enable docker

设置为开机自启后,k8s群集的配置基本完成了,现在可以重启一下这三台服务器,如果重启后,执行下面的命令,状态都还是running,则表示绝对没有问题了。

kubectl get pod -n kube-system #重启后验证状态是否