概述

Redis作为基于键值对的NoSQL数据库,具有高性能、丰富的数据结构、持久化、高可用、分布式等特性,同时Redis本身非常稳定,已经得到业界的广泛认可和使用。

在Redis中,集群的解决方案有三种

- 主从复制

- 哨兵机制

- Cluster

Redis Cluster是Redis的分布式解决方案,在 3.0 版本正式推出。

集群方案的对比

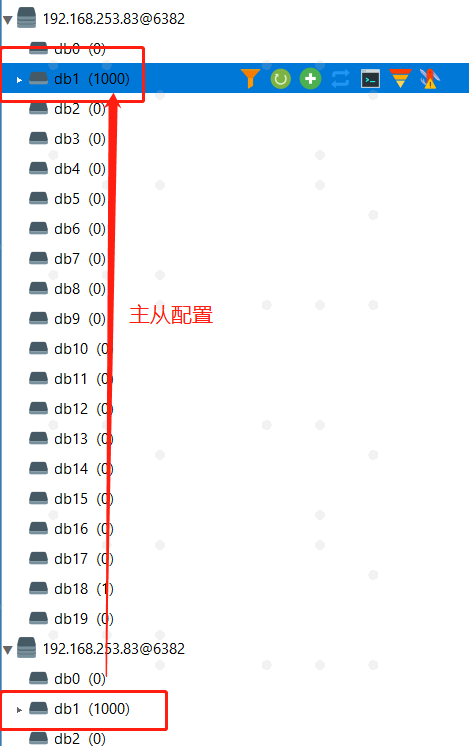

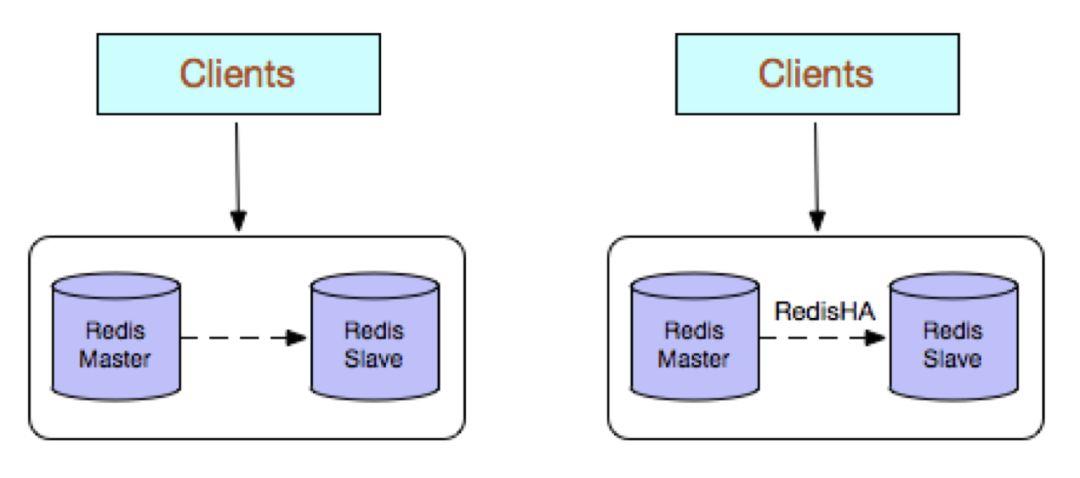

1. 主从复制

同Mysql主从复制的原因一样,Redis虽然读取写入的速度都特别快,但是也会产生读压力特别大的情况。为了分担读压力,Redis支持主从复制,读写分离。一个Master可以有多个Slaves。

主节点配置

port 6382repl-diskless-sync yesrepl-diskless-sync-delay 0databases 2000maxmemory 2gbdir "../Temp"appendonly nodbfilename "master-6382.rdb"save ""

从节点配置

port 6383

slaveof 127.0.0.1 6382

repl-diskless-sync yes

repl-diskless-sync-delay 0

databases 2000

maxmemory 2gb

appendonly no

dir "../Temp"

dbfilename "replica-6383.rdb"

save ""

优点

- 数据备份

-

缺点

不能自动故障恢复,RedisHA系统(需要开发)

-

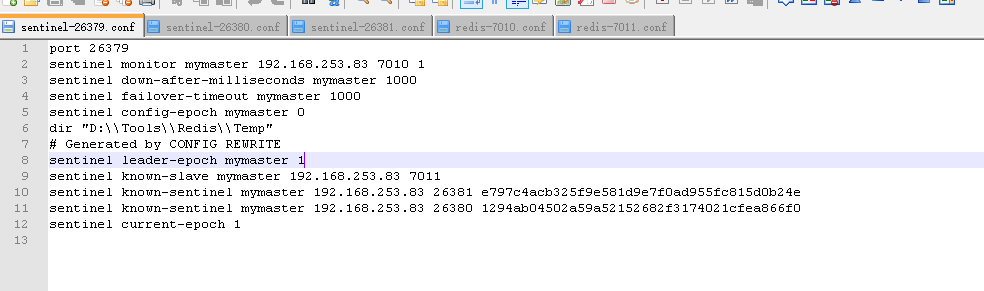

2. 哨兵机制

Redis Sentinel是社区版本推出的原生高可用解决方案,其部署架构主要包括两部分:Redis Sentinel集群和Redis数据集群。

其中Redis Sentinel集群是由若干Sentinel节点组成的分布式集群,可以实现故障发现、故障自动转移、配置中心和客户端通知。Redis Sentinel的节点数量要满足2n+1(n>=1)的奇数个。

Sentinel.zipport 26379 sentinel monitor mymaster 192.168.253.83 7010 1 sentinel down-after-milliseconds mymaster 1000 sentinel failover-timeout mymaster 1000 sentinel config-epoch mymaster 0 dir "D:\\Tools\\Redis\\Temp" # Generated by CONFIG REWRITE sentinel leader-epoch mymaster 1 sentinel known-slave mymaster 192.168.253.83 7011 sentinel known-sentinel mymaster 192.168.253.83 26381 e797c4acb325f9e581d9e7f0ad955fc815d0b24e sentinel known-sentinel mymaster 192.168.253.83 26380 1294ab04502a59a52152682f3174021cfea866f0 sentinel current-epoch 1优点

-

缺点

Redis 数据节点中 slave 节点作为备份节点不提供服务

-

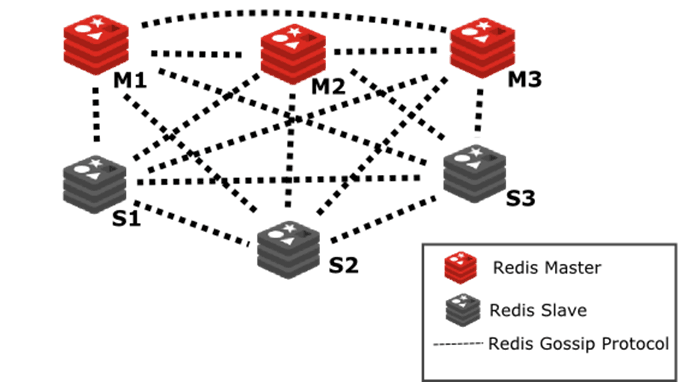

3. Redis-Cluster

Redis Cluster是社区版推出的Redis分布式集群解决方案,主要解决Redis分布式方面的需求,比如,当遇到单机内存,并发和流量等瓶颈的时候,Redis Cluster能起到很好的负载均衡的目的。

Redis Cluster着眼于提高并发量。

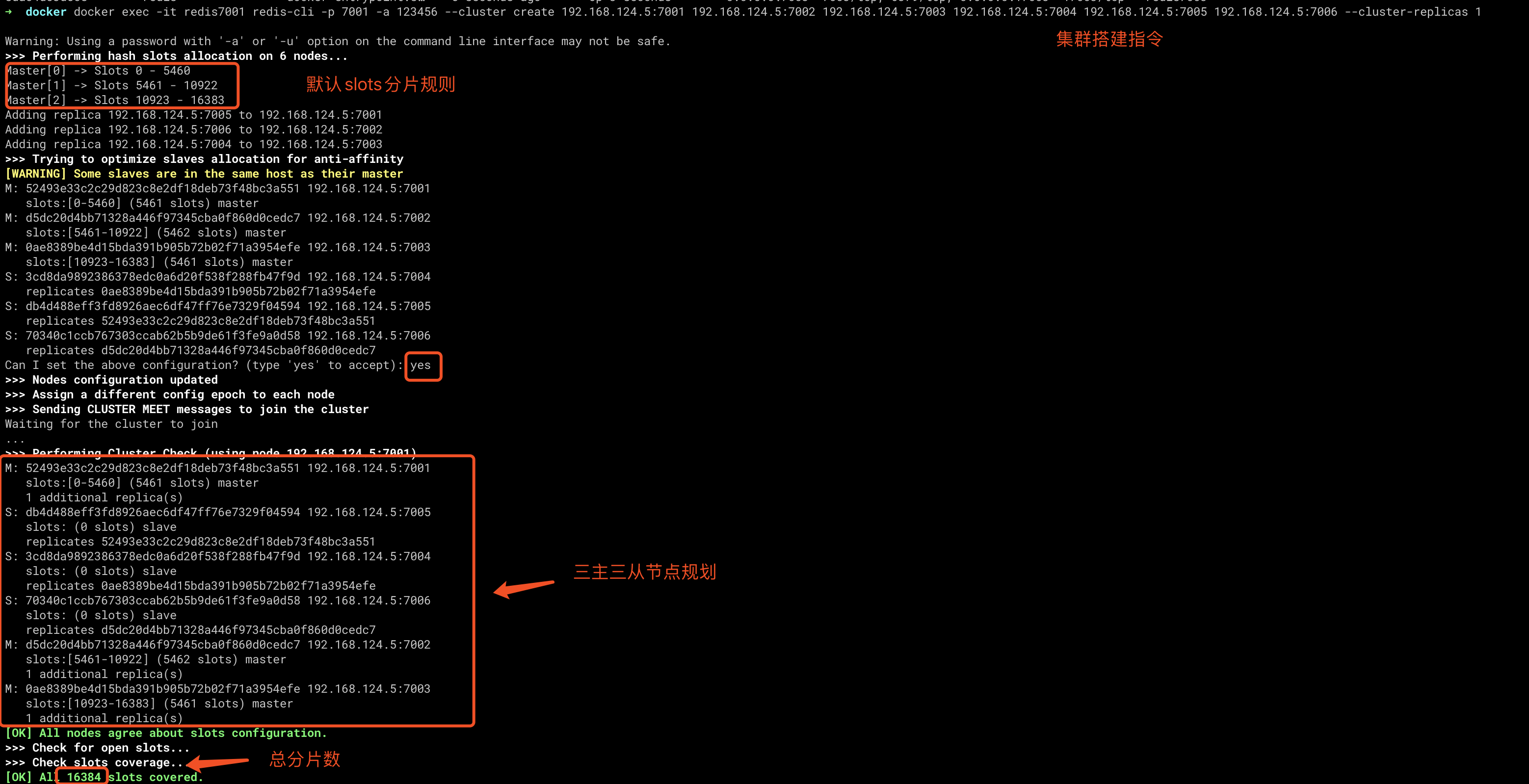

群集至少需要3主3从,且每个实例使用不同的配置文件。

在redis-cluster架构中,redis-master节点一般用于接收读写,而redis-slave节点则一般只用于备份, 其与对应的master拥有相同的slot集合,若某个redis-master意外失效,则再将其对应的slave进行升级为临时redis-master。

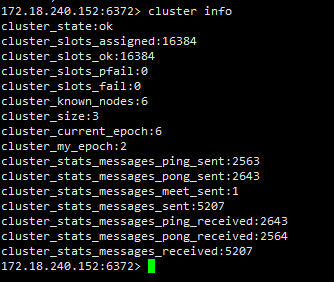

在redis的官方文档中,对redis-cluster架构上,有这样的说明:在cluster架构下,默认的,一般redis-master用于接收读写,而redis-slave则用于备份,当有请求是在向slave发起时,会直接重定向到对应key所在的master来处理。 但如果不介意读取的是redis-cluster中有可能过期的数据并且对写请求不感兴趣时,则亦可通过readonly命令,将slave设置成可读,然后通过slave获取相关的key,达到读写分离。具体可以参阅redis官方文档等相关内容

优点

解决分布式负载均衡的问题。具体解决方案是分片/虚拟槽slot。

- 可实现动态扩容

-

缺点

为了性能提升,客户端需要缓存路由表信息

- Slave在集群中充当“冷备”,不能缓解读压力

网络规划

这里没有搭建虚拟机环境,全部在本地部署。本机的ip为 192.168.124.5

| ip | port |

|---|---|

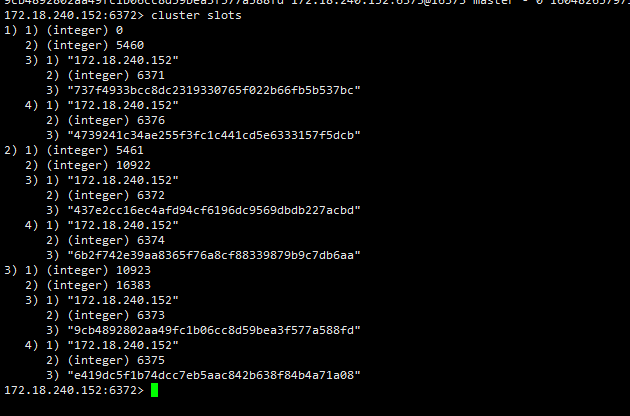

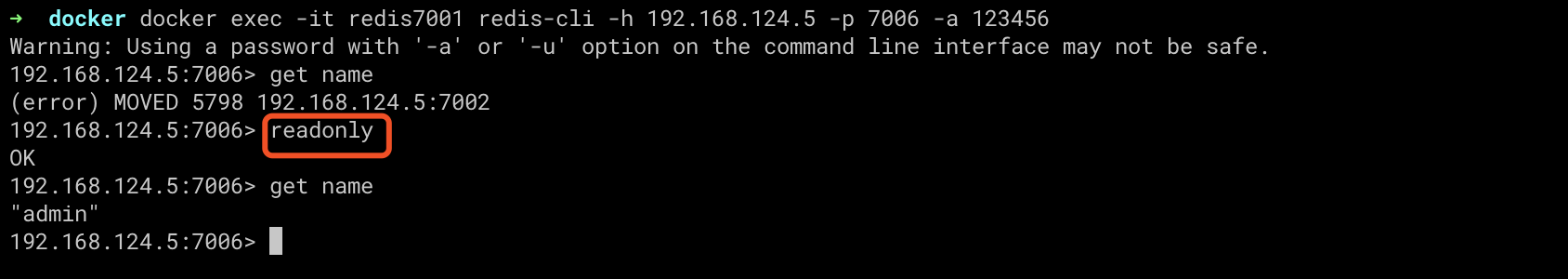

| 172.18.240.152 | 6371 |

| 172.18.240.152 | 6372 |

| 172.18.240.152 | 6373 |

| 172.18.240.152 | 6374 |

| 172.18.240.152 | 6375 |

| 172.18.240.152 | 6376 |

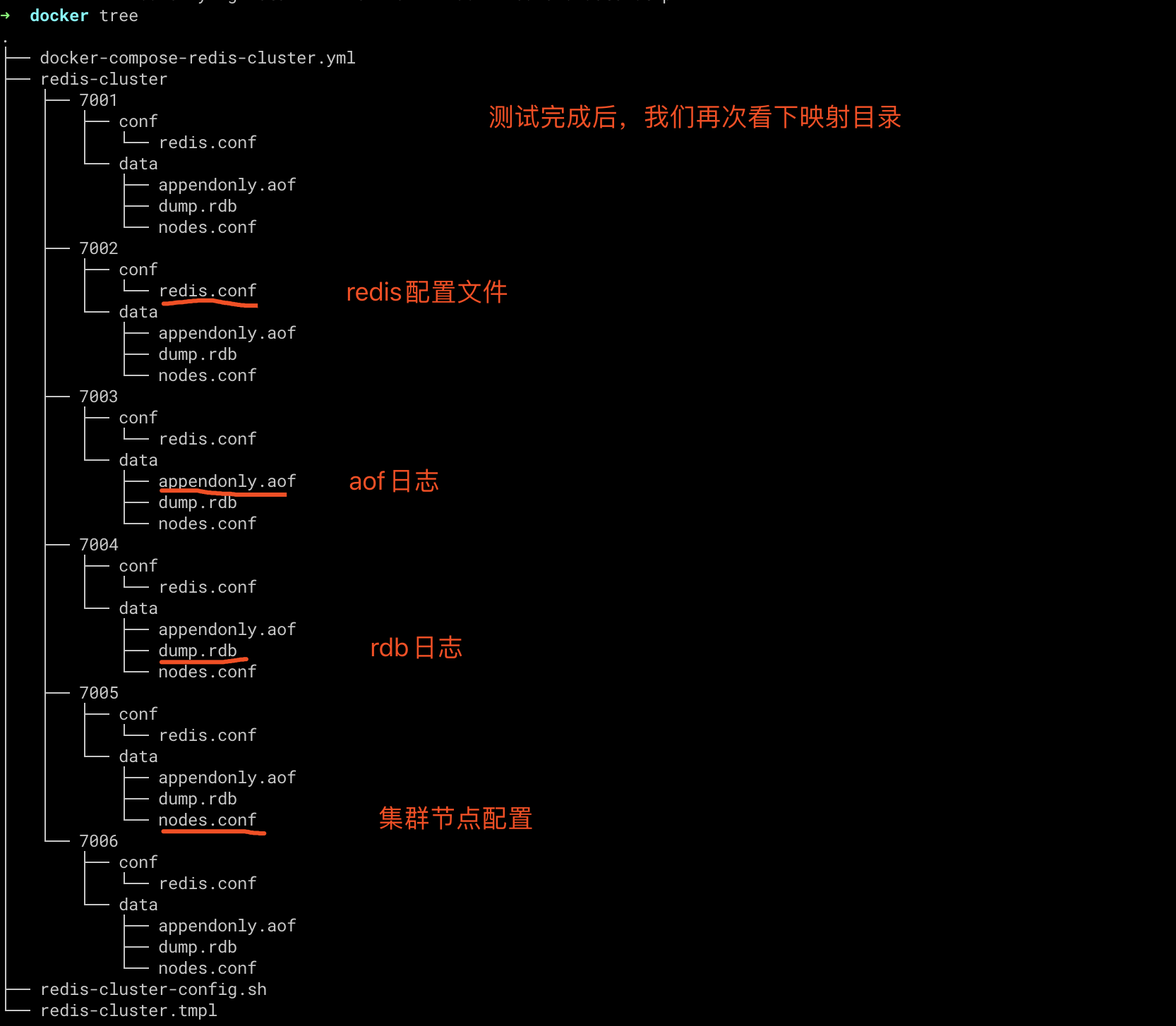

Redis配置文件

在docker环境中,配置文件映射宿主机的时候,(宿主机)必须有配置文件。附件在这里。大家可以根据自己的需求定制配置文件。

下边是我的配置文件 redis-cluster.tmpl

# redis端口

port ${PORT}

# 关闭保护模式

protected-mode no

# 开启集群

cluster-enabled yes

# 集群节点配置

cluster-config-file nodes.conf

# 超时

cluster-node-timeout 5000

# 集群节点IP host模式为宿主机IP

cluster-announce-ip 192.168.124.5

# 集群节点端口 7001 - 7006

cluster-announce-port ${PORT}

cluster-announce-bus-port 1${PORT}

# 开启 appendonly 备份模式

appendonly yes

# 每秒钟备份

appendfsync everysec

# 对aof文件进行压缩时,是否执行同步操作

no-appendfsync-on-rewrite no

# 当目前aof文件大小超过上一次重写时的aof文件大小的100%时会再次进行重写

auto-aof-rewrite-percentage 100

# 重写前AOF文件的大小最小值 默认 64mb

auto-aof-rewrite-min-size 64mb

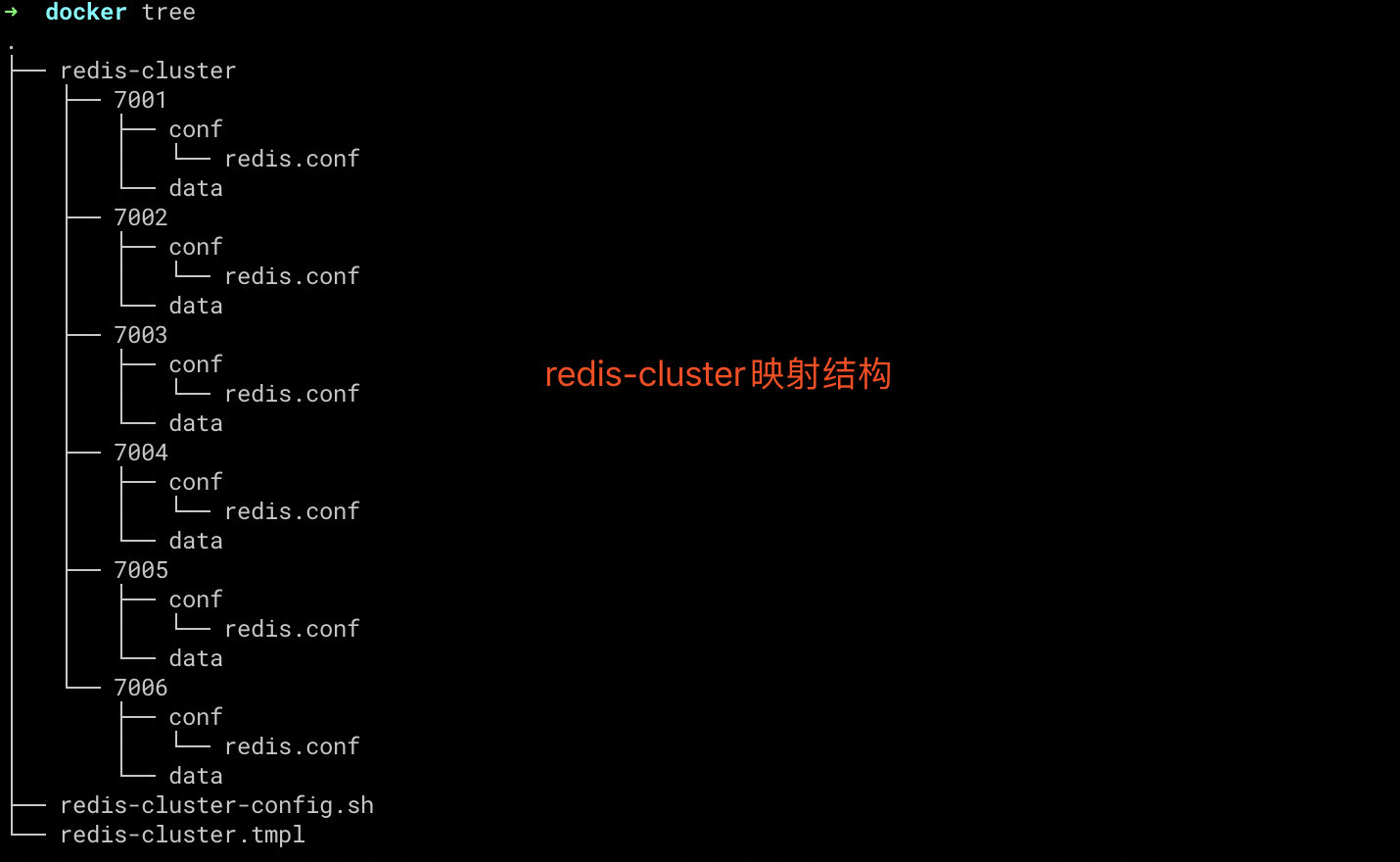

由于节点IP相同,只有端口上的差别,现在通过脚本 redis-cluster-config.sh 批量生成配置文件

for port in `seq 7001 7006`; do \

mkdir -p ./redis-cluster/${port}/conf \

&& PORT=${port} envsubst < ./redis-cluster.tmpl > ./redis-cluster/${port}/conf/redis.conf \

&& mkdir -p ./redis-cluster/${port}/data; \

done

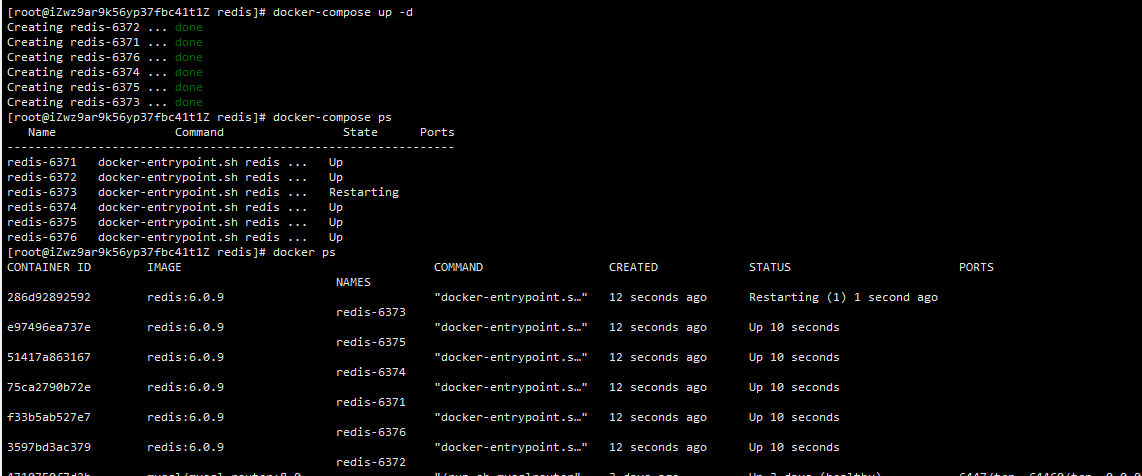

Docker环境搭建

这里还是通过docker-compose进行测试环境的docker编排。

# 描述 Compose 文件的版本信息

version: "3.8"

# 定义服务,可以多个

services:

redis-6371: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6371 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6371.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6371:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6371:6371"

- "16371:16371"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

redis-6372: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6372 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6372.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6372:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6372:6372"

- "16372:16372"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

redis-6373: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6373 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6373.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6373:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6373:6373"

- "16373:16373"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

redis-6374: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6374 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6374.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6374:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6374:6374"

- "16374:16374"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

redis-6375: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6375 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6375.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6375:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6375:6375"

- "16375:16375"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

redis-6376: # 服务名称

image: redis:6.0.9 # 创建容器时所需的镜像

container_name: redis-6376 # 容器名称

restart: always # 容器总是重新启动

network_mode: "host" # host 网络模式

volumes: # 数据卷,目录挂载

- /home/docker/redis/config/redis6376.conf:/usr/local/etc/redis/redis.conf

- /home/docker/redis/data/6376:/data

command: redis-server /usr/local/etc/redis/redis.conf # 覆盖容器启动后默认执行的命令

ports:

- "6376:6376"

- "16376:16376"

environment:

# 设置时区为上海,否则时间会有问题

- TZ=Asia/Shanghai

启动结果如图

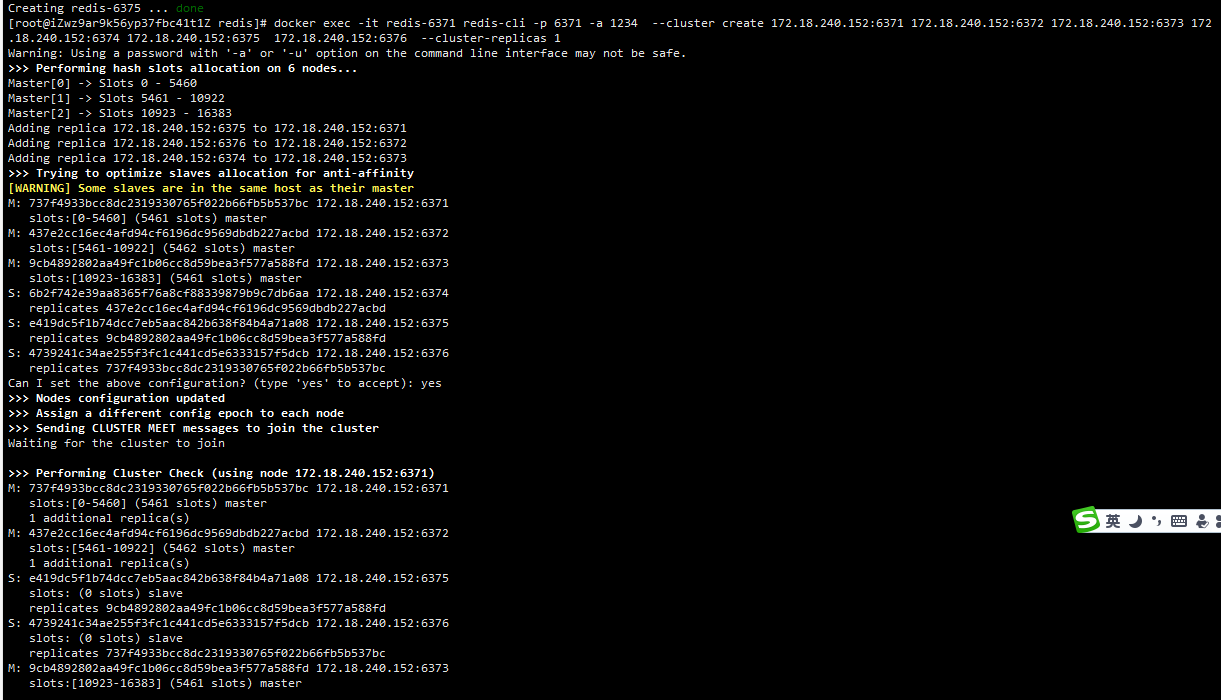

集群配置

redis集群官方提供了配置脚本,4.x和5.x略有不同,具体可参见集群配置

下边是我自己的环境

docker exec -it redis-6371 redis-cli -p 6371 -a 123456 --cluster create 172.18.240.152:6371 172.18.240.152:6372 172.18.240.152:6373 172.18.240.152:6374 172.18.240.152:6375 172.18.240.152:6376 --cluster-replicas 1

集群测试

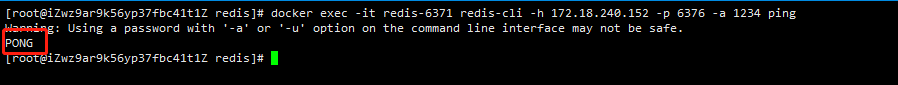

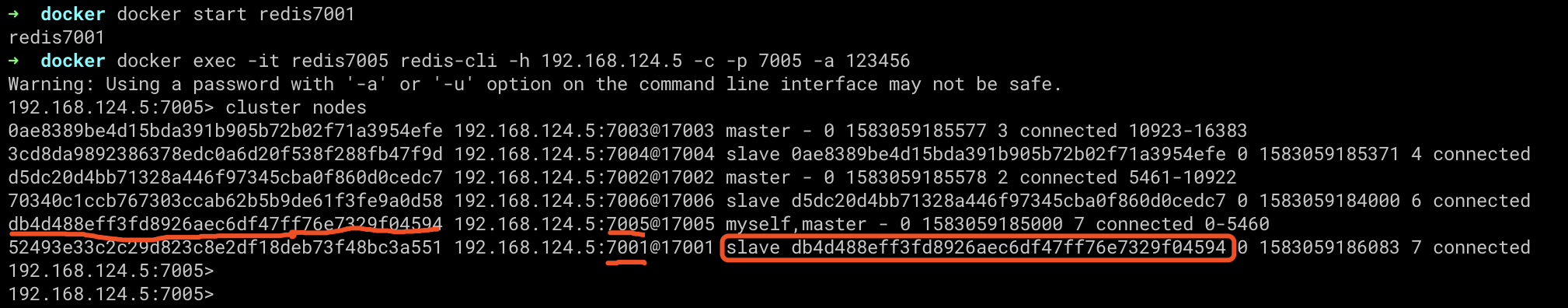

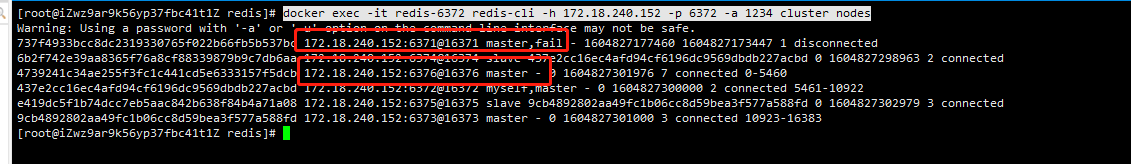

1. 查看集群通信是否正常

redis7001主节点对它的副本节点redis7005进行ping操作。

-h host -p port -a pwd

➜ docker docker exec -it redis7001 redis-cli -h 192.168.124.5 -p 7005 -a 123456 ping

Warning: Using a password with '-a' or '-u' option on the command line interface may not be safe.

PONG

docker exec -it redis-6371 redis-cli -h 172.18.240.152 -p 6376 -a 123456 ping

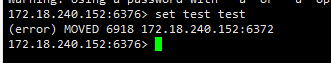

2. 测试简单存储

redis7001主节点客户端操作redis7003主节点

➜ docker exec -it redis7001 redis-cli -h 192.168.124.5 -p 7003 -a 123456

Warning: Using a password with '-a' or '-u' option on the command line interface may not be safe.

192.168.124.5:7003> set name admin

(error) MOVED 5798 192.168.124.5:7002

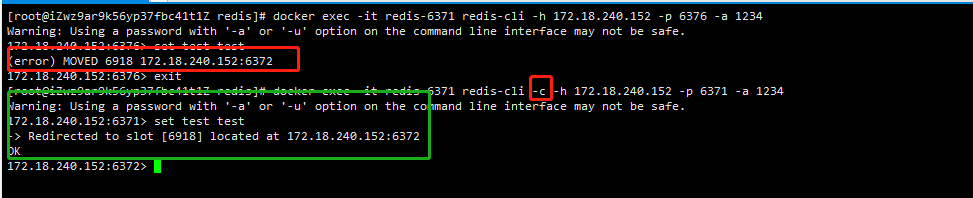

由于Redis Cluster会根据key进行hash运算,然后将key分散到不同slots,name的hash运算结果在redis7002节点上的slots中。所以我们操作redis7003写操作会自动路由到7002。然而error提示无法路由?没关系,差一个 -c 参数而已。

docker exec -it redis-6371 redis-cli -h 172.18.240.152 -p 6376 -a 123456

172.18.240.152:6376> set test test

(error) MOVED 6918 172.18.240.152:6372

再次运行查看结果如下:

➜ docker docker exec -it redis7001 redis-cli -h 192.168.124.5 -p 7003 -a 123456 -c

Warning: Using a password with '-a' or '-u' option on the command line interface may not be safe.

192.168.124.5:7003> set name admin

-> Redirected to slot [5798] located at 192.168.124.5:7002

OK

192.168.124.5:7002> get name

"admin"

192.168.124.5:7002>

docker exec -it redis-6371 redis-cli -c -h 172.18.240.152 -p 6371 -a 123456

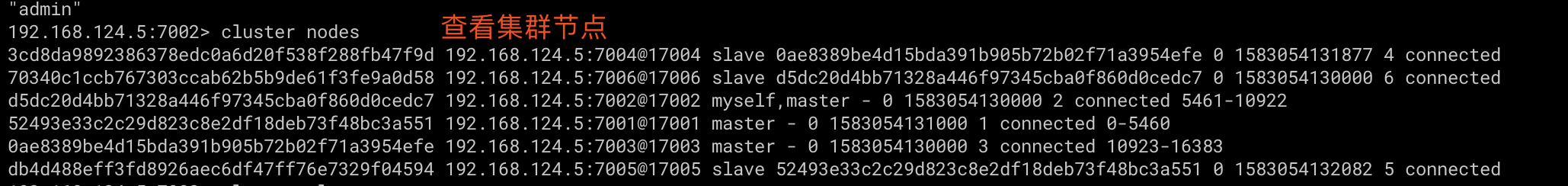

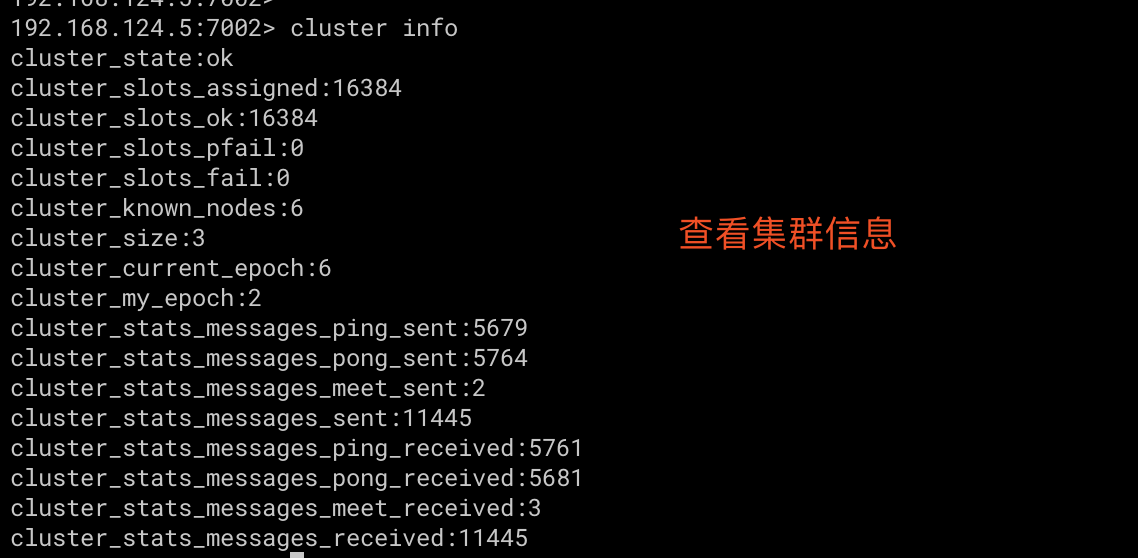

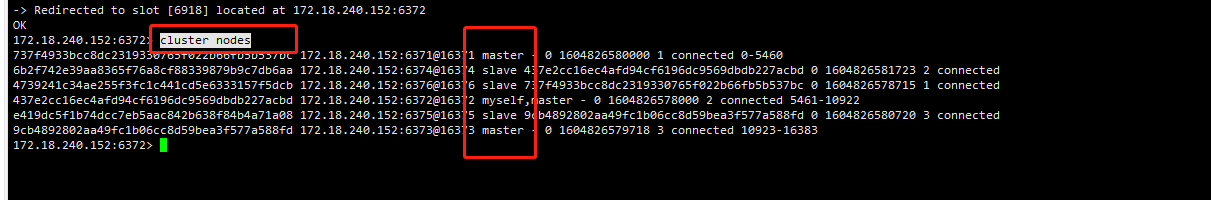

3. 查看集群状态

cluster nodes

4. 查看slots分片

cluster slots

5. 查看集群信息

cluster info

6. 测试读写分离

试试看,发现读不到,原来在redis cluster中,如果你要在slave读取数据,那么需要带先执行 readonly 指令,然后 get key

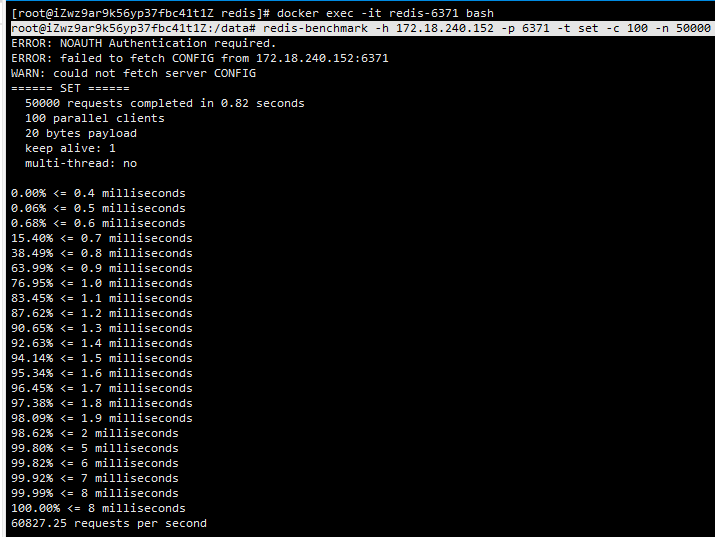

7. 简单压测

| 选项 | 描述 |

|---|---|

| -t | 指定命令 |

| -c | 客户端连接数 |

| -n | 总请求数 |

| -d | set、get的value大小(单位byte) |

测试如下

➜ docker docker exec -it redis7001 bash

root@cbc6e76a3ed2:/data# redis-benchmark -h 192.168.124.5 -p 7001 -t set -c 100 -n 50000 -d 20

====== SET ======

50000 requests completed in 10.65 seconds

100 parallel clients

20 bytes payload

keep alive: 1

0.00% <= 2 milliseconds

0.01% <= 3 milliseconds

...

100.00% <= 48 milliseconds

100.00% <= 49 milliseconds

4692.63 requests per second

docker exec -it redis-6371 bash

root@iZwz9ar9k56yp37fbc41t1Z:/data# redis-benchmark -h 172.18.240.152 -p 6371 -t set -c 100 -n 50000 -d 20

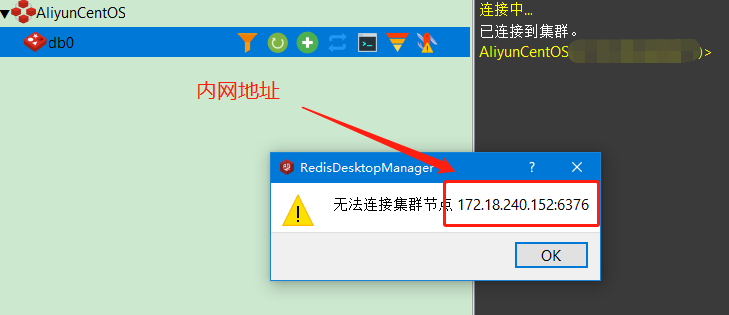

8.外网访问

这里没啥实际意义,在工作业务上大家可以根据QPS和主机配置进行压测,计算规划出节点数量。

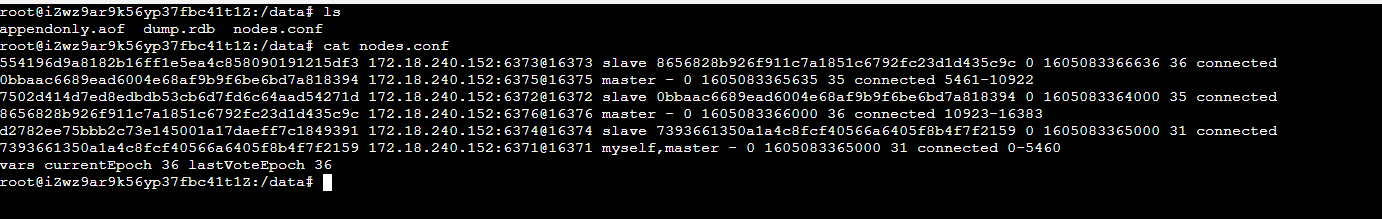

现在通过公网访问会出现unknown cluster ip:7000的报错信息,这是因为在nodes.conf文件中某些节点的IP是内网IP。解决方法为如下:

- 停止每个节点的进程。

- 编辑每个节点的nodes.conf文件,将其中的内网IP换成公网IP。

- 重新启动每个节点。

注意:设置公网访问Redis集群属于危险行为,一般生产环境进制使用公网redis集群

8.配置Redis-cluster-proxy

以下信息来自于官方的说明:

redis-cluster-proxy是Redis集群的代理。Redis能够在基于自动故障转移和分片的集群模式下运行。

这种特殊模式(指Redis集群模式)需要使用特殊的客户端来理解集群协议:通过代理,集群被抽象了出来,可以实现像单实例一样实现redis集群的访问。

Redis集群代理是多线程的,默认情况下,它目前使用多路复用通信模型,这样每个线程都有自己的集群连接,所有属于线程本身的客户端都可以共享该连接。

无论如何,在某些特殊情况下(多事务或阻塞命令),多路复用被禁用,客户端将拥有自己的集群连接。

通过这种方式,只发送简单命令(比如get和set)的客户端将不需要一组到Redis集群的私有连接。

注:依赖 gcc 4.9 以上版本,所以需要升级gcc版本,前面已经写过了。

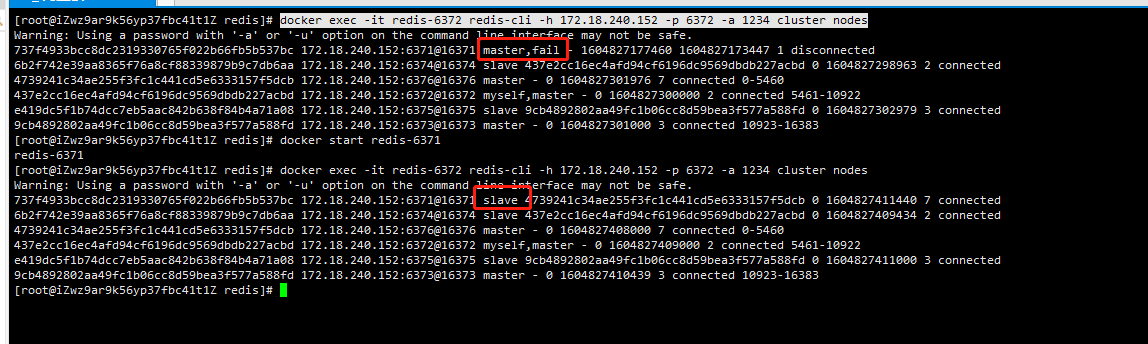

容灾演练

现在我们杀掉主节点redis7001,看从节点redis7005是否会接替它的位置。

docker stop redis7001

docker stop redis-6371

docker exec -it redis-6372 redis-cli -h 172.18.240.152 -p 6372 -a 123456 cluster nodes

docker start redis-6371

docker exec -it redis-6372 redis-cli -h 172.18.240.152 -p 6372 -a 123456 cluster nodes

SpringBoot配置Redis集群

在SpringBoot2.x版本中,redis默认的连接池已经更换为Lettuce,而不再是jedis。

1. 在pom.xml中引入相关依赖

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

</dependency>

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-pool2</artifactId>

</dependency>

2. application.yml

spring:

redis:

timeout: 6000

password: 123456

cluster:

max-redirects: 3 # 获取失败 最大重定向次数

nodes:

- 192.168.124.5:7001

- 192.168.124.5:7002

- 192.168.124.5:7003

- 192.168.124.5:7004

- 192.168.124.5:7005

- 192.168.124.5:7006

lettuce:

pool:

max-active: 1000 #连接池最大连接数(使用负值表示没有限制)

max-idle: 10 # 连接池中的最大空闲连接

min-idle: 5 # 连接池中的最小空闲连接

max-wait: -1 # 连接池最大阻塞等待时间(使用负值表示没有限制)

cache:

jcache:

config: classpath:ehcache.xml

3. redis配置

@Configuration

@AutoConfigureAfter(RedisAutoConfiguration.class)

public class RedisConfig {

@Bean

public RedisTemplate<String, Object> redisCacheTemplate(LettuceConnectionFactory redisConnectionFactory) {

RedisTemplate<String, Object> template = new RedisTemplate<>();

template.setKeySerializer(new StringRedisSerializer());

template.setValueSerializer(new GenericJackson2JsonRedisSerializer());

template.setConnectionFactory(redisConnectionFactory);

return template;

}

}

4. 基本测试

@SpringBootTest

public class RedisTest {

@Autowired

private RedisTemplate<String, String> redisTemplate;

@Test

public void test() {

redisTemplate.opsForValue().set("name", "admin");

String name = redisTemplate.opsForValue().get("name");

System.out.println(name); //输出admin

}

}

总结

通过以上演示,基本上可以在本地环境下用我们的Redis Cluster集群了。最后再上一张本地映射文件的最终样子,帮助大家了解Redis持久化及集群相关的东西。感兴趣的小伙伴可以自行测试并查看其中的内容。

https://www.cnblogs.com/zhangrui153169/p/12835681.html

https://redis.io/topics/cluster-tutorial

https://www.cnblogs.com/passzhang/p/13233485.html

https://www.jmsite.cn/blog-851.html