一、简介

Zookeeper是Apache Hadoop的子项目,是一个树型的目录的分布式服务框架,支持变更推送。主要是用来解决分布式应用中经常遇到的一些数据管理问题,如:统一命名服务、状态同步服务、集群管理、分布式应用配置项的管理等。

简单来说 zookeeper=文件系统+监听通知机制,适合作为Dubbo服务的注册中心。

二、安装

下载地址: http://archive.apache.org/dist/zookeeper/

windows下安装步骤:windows环境下安装zookeeper教程详解(单机版)

Linux下安装步骤:

第一步:安装配置jdk(略)

第二步:进入文件目录,下载zookeeper。

$ wget http://archive.apache.org/dist/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

或把zookeeper的压缩包(zookeeper-3.4.6.tar.gz) 上传到 linux系统。

第三步:解压缩压缩包

$ tar -zxvf zookeeper-3.4.6.tar.gz

第四步:进入zookeeper-3.4.6目录,创建data目录

$ mkdir data

第五步:进入conf目录,把zoo_sample.cfg改名为zoo.cfg

$ cd conf$ mv zoo_sample.cfg zoo.cfg

第六步:打开z00.cfg文件,修改data属性: dataDir=/root/zookeeper-3.4.6/data

三、架构

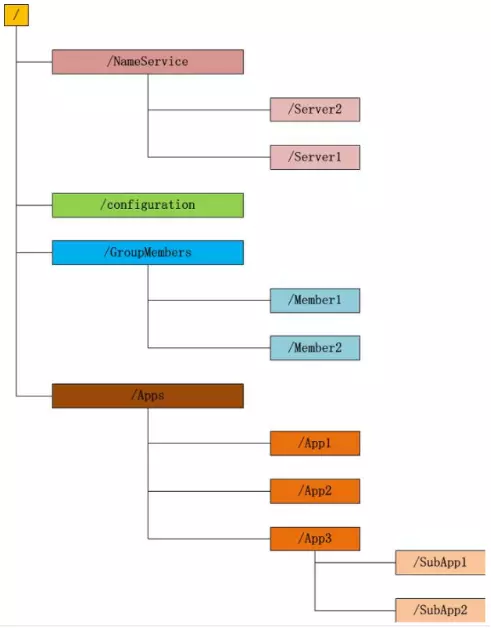

1、Zookeeper维护一个类似文件系统的数据结构

每个子目录项如 NameService 都被称作为 znode(目录节点),和文件系统一样,我们能够自由的增加、删除znode,在一个znode下增加、删除子znode,唯一的不同在于znode是可以存储数据的。

有四种类型的znode:

- PERSISTENT-持久化目录节点

客户端与zookeeper断开连接后,该节点依旧存在

- PERSISTENT_SEQUENTIAL-持久化顺序编号目录节点

客户端与zookeeper断开连接后,该节点依旧存在,只是Zookeeper给该节点名称进行顺序编号

- EPHEMERAL-临时目录节点

客户端与zookeeper断开连接后,该节点被删除

- EPHEMERAL_SEQUENTIAL-临时顺序编号目录节点

客户端与zookeeper断开连接后,该节点被删除,只是Zookeeper给该节点名称进行顺序编号

2、 监听通知机制

客户端注册监听它关心的目录节点,当目录节点发生变化(数据改变、被删除、子目录节点增加删除)时,zookeeper会通知客户端。

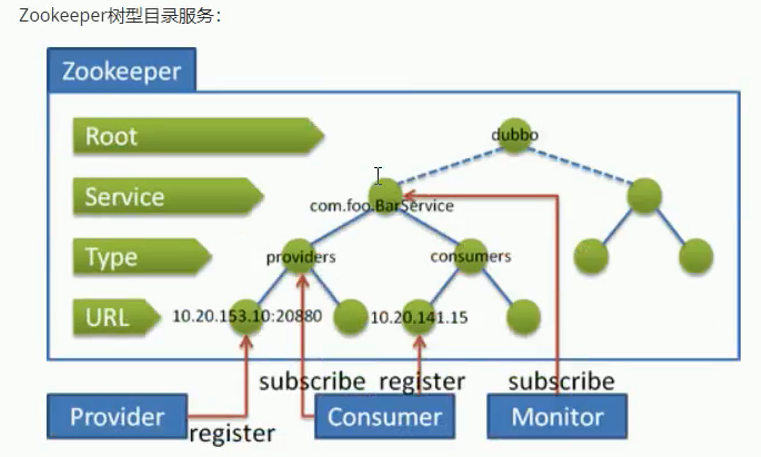

四、注册中心

- 服务提供者(Provider)启动时:向/dubbo/com.foo.BarService/providers目录下写入自己的URL地址。

- 服务消费者(Consumer)启动时:订阅/dubbo/com.foo.BarService/providers目录下的提供者URL地

址,并向/dubbo/com.foo.BarService/consumers目录下写入自己的URL地址。

- 监控中心(Monitor)启动时:订阅/dubbo/com.foo.BarService目录下的所有提供者和消费者URL地址。

- 当提供者出现断电等异常停机时,注册中心能自动删除提供者信息。

- 当注册中心重启时,能自动恢复注册数据,以及订阅请求。

- 当会话过期时,能自动恢复注册数据,以及订阅请求。

五、使用

进入Zookeeper的bin目录。

启动服务命令:

停止服务命令:$ ./zkServer.sh start

查看服务状态:$ ./zkServer.sh stop

$ ./zkServer.sh status

六、搭建集群

一台机器上启动三个zookeeper实例组成集群:

1、 配置JAVA环境

2、下载并解压Zookeeper

$ cd /usr/local$ wget http://archive.apache.org/dist/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz$ tar -zxvf zookeeper-3.4.6.tar.gz$cd zookeeper-3.4.6

3、进入conf目录,重命名 zoo_sample.cfg文件

$ cp conf/zoo_sample.cfg conf/zoo-1.cfg

4、修改配置文件zoo-1.cfg

$ vim conf/zoo-1.cfgdataDir=/tmp/zookeeper-1clientPort=2181server.1=127.0.0.1:2888:3888server.2=127.0.0.1:2889:3889server.3=127.0.0.1:2890:3890

配置说明

- tickTime:这个时间是作为 Zookeeper 服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个 tickTime 时间就会发送一个心跳。

- initLimit:这个配置项是用来配置 Zookeeper 接受客户端(这里所说的客户端不是用户连接 Zookeeper 服务器的客户端,而是 Zookeeper 服务器集群中连接到 Leader 的 Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过 10个心跳的时间(也就是 tickTime)长度后 Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是 10*2000=20 秒

- syncLimit:这个配置项标识 Leader 与 Follower 之间发送消息,请求和应答时间长度,最长不能超过多少个 tickTime 的时间长度,总的时间长度就是 5*2000=10秒

- dataDir:顾名思义就是 Zookeeper 保存数据的目录,默认情况下,Zookeeper 将写数据的日志文件也保存在这个目录里。

- clientPort:这个端口就是客户端连接 Zookeeper 服务器的端口,Zookeeper 会监听这个端口,接受客户端的访问请求。

- server.A=B:C:D:其中 A 是一个数字,表示这个是第几号服务器;B 是这个服务器的 ip 地址;C 表示的是这个服务器与集群中的 Leader 服务器交换信息的端口;D 表示的是万一集群中的 Leader 服务器挂了,需要一个端口来重新进行选举,选出一个新的 Leader,而这个端口就是用来执行选举时服务器相互通信的端口。如果是伪集群的配置方式,由于 B 都是一样,所以不同的 Zookeeper 实例通信端口号不能一样,所以要给它们分配不同的端口号。

4、从zoo-1.cfg复制两个配置文件zoo-2.cfg和zoo-3.cfg,只需修改dataDir和clientPort不同即可

$ cp conf/zoo-1.cfg conf/zoo-2.cfg$ cp conf/zoo-1.cfg conf/zoo-3.cfg$ vim conf/zoo-2.cfgdataDir=/tmp/zookeeper-2clientPort=2182$ vim conf/zoo-2.cfgdataDir=/tmp/zookeeper-3clientPort=2183

5、标识Server ID

创建三个文件夹/tmp/zookeeper-1,/tmp/zookeeper-2,/tmp/zookeeper-3。在每个目录中创建文件myid 文件,写入当前实例的server id,即1、2、3

$ mkdir /tmp/zookeeper-1$ cd /tmp/zookeeper-1$ vim myid1$ mkdir /tmp/zookeeper-2$ cd /tmp/zookeeper-2$ vim myid2$ mkdir /tmp/zookeeper-3$ cd /tmp/zookeeper-3$ vim myid3

6、启动三个zookeeper实例

$ ./zkServer.sh start conf/zoo-1.cfg$ ./zkServer.sh start conf/zoo-2.cfg$ ./zkServer.sh start conf/zoo-3.cfg

7、检测集群状态,也可以直接用命令zkCli.sh -server IP:PORT连接zookeeper服务端检测![[Dubbo] Zookeeper - 图4](/uploads/projects/2book@java/50943df7fc4af3594a0f84504010e1bd.jpeg)

8、如果启动失败,报错 address already in use ,说明端口被占用了。

$ sudo netstat -atunlp | grep 2181# 如果提示 -bash: netstat: command not found 则执行命令安装:yum install net-tools# tcp6 0 0:::2181 :::* LISTEN 1541/java# 显示如上信息就是java这个程序占用了端口,而1541就是进程的PID# 杀进程:$ sudo kill -9 1541

再次启动即可。